AI تیزی سے آگے بڑھ رہا ہے: نئے ملٹی موڈل ماڈلز اور بہتر ریئل ٹائم APIs طاقتور AI کو آٹومیشن پلیٹ فارمز میں سرایت کرنا آسان بنا رہے ہیں، جبکہ حفاظت اور مشاہدے کے بارے میں متوازی بحثیں نئی شکل دے رہی ہیں کہ ٹیمیں کس طرح پروڈکشن سسٹم چلاتی ہیں۔ مقامی آٹومیشن بنانے والے لوگوں کے لیے، ایک عملی نمونہ ابھر رہا ہے: ایک متحد ماڈل گیٹ وے استعمال کریں (جیسے CometAPI) بہت سے ماڈلز تک رسائی حاصل کرنے کے لیے، اور ان ماڈل کالز کو خود میزبان آٹومیشن رنر میں سلائی کریں (جیسے n8n) تاکہ آپ ڈیٹا، تاخیر اور اخراجات کو کنٹرول میں رکھیں۔ یہ گائیڈ آپ کو قدم بہ قدم دکھاتا ہے کہ کیسے شروع کیا جائے۔ CometAPI + n8n (مقامی)، کیا دیکھنا ہے، اور جب چیزیں ایک طرف جاتی ہیں تو کس طرح ٹربل شوٹ کرنا ہے۔

n8n کیا ہے اور یہ AI آٹومیشن کے لیے کیوں اہمیت رکھتا ہے؟

n8n ایک اوپن سورس ورک فلو آٹومیشن ٹول ہے جس میں بصری ایڈیٹر اور نوڈس (کنیکٹرز) کا ایک بڑا ماحولیاتی نظام ہے۔ یہ آپ کو ٹرگرز، ٹرانسفارمز، اور بیرونی API کالز کو دوبارہ قابل عمل ورک فلوز (ویب ہکس، شیڈول جابز، فائل پروسیسنگ، چیٹ بوٹس، وغیرہ) میں تبدیل کرنے کے لیے ڈیزائن کیا گیا ہے۔ سیلف ہوسٹنگ n8n مقامی طور پر آپ کو ڈیٹا ریزیڈنسی اور عمل درآمد پر مکمل کنٹرول فراہم کرتا ہے، جو کہ خاص طور پر قابل قدر ہے جب تھرڈ پارٹی AI ماڈلز کو کال کرتے ہیں جو حساس ان پٹس کو ہینڈل کرتے ہیں۔

N8n عملی طور پر کیسے کام کرتا ہے؟

- ٹرگرز (ویب ہُک، کرون) اور ایکشن نوڈس (HTTP درخواست، ڈیٹا بیس نوڈس، ای میل) کے ساتھ بصری کینوس۔

- کمیونٹی نوڈس صلاحیت کو بڑھاتے ہیں — آپ کمیونٹی پیکجز انسٹال کر سکتے ہیں اور ان کے ساتھ مقامی نوڈس کی طرح برتاؤ کر سکتے ہیں۔

سیلف ہوسٹنگ n8n آپ کو دیتا ہے:

- مکمل ڈیٹا کنٹرول - ورک فلو اور رن ڈیٹا آپ کے زیر انتظام انفراسٹرکچر پر رہتا ہے۔

- حسب ضرورت - کلاؤڈ خصوصیات کا انتظار کیے بغیر نجی نوڈس یا مقامی انضمام شامل کریں۔

- لاگت کی پیشن گوئی - بھاری اندرونی آٹومیشن کے لیے کوئی فی ٹاسک کلاؤڈ بلنگ سرپرائز نہیں۔

- حفاظت اور تعمیل - داخلی پالیسی اور ریگولیٹری ضروریات کو پورا کرنا آسان ہے۔

CometAPI کیا ہے اور اسے اپنے ماڈل گیٹ وے کے طور پر کیوں استعمال کریں؟

CometAPI ایک متحد API گیٹ وے ہے جو ایک واحد، OpenAI سے مطابقت رکھنے والے انٹرفیس اور بلنگ ماڈل کے پیچھے سینکڑوں تھرڈ پارٹی AI ماڈلز (ٹیکسٹ، ایمبیڈنگز، امیج جنریشن، وغیرہ) کو بے نقاب کرتا ہے۔ اس کا مطلب ہے کہ ہر LLM یا امیج انجن کے لیے bespoke integrations کو شامل کرنے کے بجائے، آپ ایک API کو کال کریں اور درخواست میں مطلوبہ ماڈل منتخب کریں۔ یہ تجربہ، لاگت پر کنٹرول، اور آپریشنل انضمام کو آسان بناتا ہے۔

فوائد:

- ماڈل کا انتخاب: ایک ہی کوڈ پاتھ کے ساتھ بہت سے وینڈرز/ماڈلز آزمائیں۔

- ٹوکن پولنگ / مفت کوٹہ: بہت سے متحد گیٹ ویز تجربے کے لیے کریڈٹ/ٹیر پیش کرتے ہیں۔

- آسان انفراسٹرکچر: ایک توثیقی نظام اور انتظام کرنے کے لیے ایک بنیادی URL۔

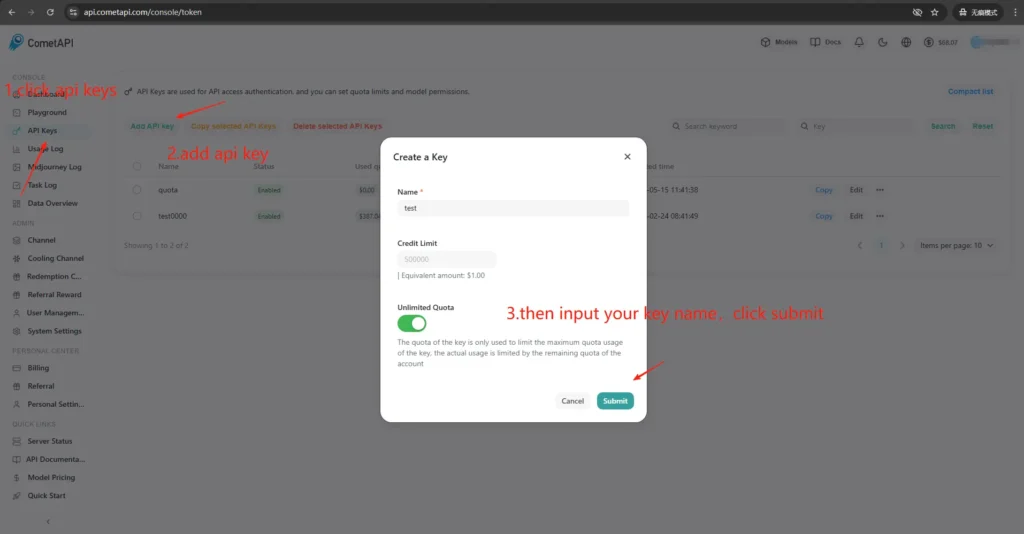

میں CometAPI تک رسائی اور چابیاں کیسے حاصل کروں؟

- سائن اپ کریں CometAPI سائٹ (یا وینڈر ڈیش بورڈ) پر۔ زیادہ تر گیٹ ویز میں ٹیسٹ کرنے کے لیے مفت درجے ہوتے ہیں۔

- ایک API کلید حاصل کریں۔ آپ کے CometAPI ڈیش بورڈ سے — ایک طویل خفیہ تار۔ نوٹ کریں کہ دستاویزات آپ کو اسے کہاں رکھنے کے لیے کہتے ہیں (CometAPI بیئرر کی اجازت کے خلاف استعمال کرتا ہے۔

https://api.cometapi.com/v1). - API دستاویزات پڑھیں اختتامی نقطہ کے لیے جسے آپ استعمال کرنے کا ارادہ رکھتے ہیں (چیٹ کی تکمیل، تصاویر، ایمبیڈنگز)۔ CometAPI دستاویزات کے اختتامی نکات جیسے

/v1/chat/completionsاور/v1/images/generations.

n8n اور CometAPI کے درمیان بانڈنگ (انضمام) کیوں ضروری ہے؟

یہاں "بانڈنگ" کا مطلب ہے آپ کے آٹومیشن رنر (n8n) اور آپ کے ماڈل گیٹ وے کے درمیان ایک قابل اعتماد، محفوظ انضمام کا راستہ۔ مناسب بندھن اہمیت رکھتا ہے کیونکہ:

- یہ محفوظ رکھتا ہے۔ سیاق و سباق تمام کالز (گفتگو کی سرگزشت، ایمبیڈنگز)۔

- یہ مرکزی بناتا ہے۔ اسناد اور محفوظ گردش کے لیے راز ایک جگہ پر۔

- یہ متوقع اختتامی پوائنٹس اور معیاری درخواست فارمیٹس کا استعمال کرکے تاخیر اور خرابی کی سطح کو کم کرتا ہے۔

- یہ قابل بناتا ہے مشاہدہ اور خرابیوں کا سراغ لگانا — یہ جاننا کہ کون سا ماڈل، پرامپٹ، اور ردعمل نتیجہ کا باعث بنا۔

مختصراً: اچھی بانڈنگ آپریشنل رسک کو کم کرتی ہے اور تکرار کو تیز کرتی ہے۔

میں مقامی طور پر n8n کیسے تعینات کروں (فوری عملی رہنما)؟

آپ n8n کو مقامی طور پر بھی چلا سکتے ہیں۔ npm یا Docker کے ساتھ؛ ڈوکر کمپوز زیادہ تر خود میزبان منظرناموں کے لئے تجویز کردہ نقطہ نظر ہے (یہ تولیدی ہے اور انحصار کو الگ کرتا ہے)۔ ذیل میں ایک کم سے کم ڈوکر کمپوز مثال اور ضروری نوٹ ہیں۔

میں Docker کے ساتھ n8n کی خود میزبانی کیسے کروں؟

ڈوکر (اور ڈوکر کمپوز) پیداوار میں n8n چلانے کا سب سے مضبوط، دہرایا جانے والا طریقہ ہے۔ یہ ایپ کو الگ تھلگ کرتا ہے، اپ گریڈ کو آسان بناتا ہے، اور ریورس پراکسی اور آرکیسٹریٹرز (Docker Swarm، Kubernetes) کے ساتھ اچھی طرح جوڑتا ہے۔ n8n کے آفیشل دستاویزات میں ایک Docker Compose حوالہ شامل ہے جس کی پیروی میں یہاں کروں گا اور اسے اپناؤں گا۔

پیداوار کے لیے آپ عام طور پر ایک اسٹیک چلائیں گے جس پر مشتمل ہے:

- n8n سروس (سرکاری تصویر:

docker.n8n.io/n8nio/n8norn8nio/n8nٹیگ پر منحصر ہے)۔ - PostgreSQL (یا دوسرا تعاون یافتہ DB)۔

- Redis (اگر آپ قطار موڈ استعمال کرنے کا ارادہ رکھتے ہیں)۔

- TLS، میزبان روٹنگ، اور شرح کی حد کے قوانین کے لیے ایک ریورس پراکسی (Traefik، Caddy، یا nginx)۔

یہ فن تعمیر صاف طور پر خدشات کو الگ کرتا ہے (DB استقامت، قطار لگانا، ویب پراکسی) اور اسکیلنگ اور بیک اپ کو سیدھا بناتا ہے۔ سرکاری n8n دستاویزات ڈوکر کمپوز پیٹرن اور ماحولیاتی متغیر حوالہ جات فراہم کرتے ہیں۔

یہ مرحلہ وار گائیڈ ہے:

- ایک فولڈر بنائیں اور ایک

docker-compose.ymlکیننیکل n8n سروس کے ساتھ۔ ذیل میں ایک عملی ڈوکر کمپوز مثال ہے جو عام پیداوار کی ضروریات کا احاطہ کرتی ہے: بیرونی پوسٹگریس، ریڈیس (قطار/عمل درآمد کے موڈ کے لیے)، مستقل حجم، اور ایک Nginx ریورس پراکسی ہینڈلنگ TLS:

```yaml

version: "3.8"

services:

n8n:

image: n8nio/n8n:latest

restart: unless-stopped

environment:

- DB_TYPE=postgresdb

- DB_POSTGRESDB_HOST=postgres

- DB_POSTGRESDB_PORT=5432

- DB_POSTGRESDB_DATABASE=n8n

- DB_POSTGRESDB_USER=n8n

- DB_POSTGRESDB_PASSWORD=supersecretpassword

- N8N_BASIC_AUTH_ACTIVE=true

- N8N_BASIC_AUTH_USER=admin

- N8N_BASIC_AUTH_PASSWORD=anothersecret

- WEBHOOK_TUNNEL_URL=https://n8n.example.com

- EXECUTIONS_MODE=queue

- QUEUE_BULL_REDIS_HOST=redis

ports:

- "5678:5678"

volumes:

- n8n_data:/home/node/.n8n

depends_on:

- postgres

- redis

postgres:

image: postgres:15

environment:

POSTGRES_DB: n8n

POSTGRES_USER: n8n

POSTGRES_PASSWORD: supersecretpassword

volumes:

- pgdata:/var/lib/postgresql/data

redis:

image: redis:7

volumes:

- redisdata:/data

volumes:

n8n_data:

pgdata:

redisdata:

2. شروع کریں:

docker compose up -d

3. دورہ `http://localhost:5678` اور اپنا ایڈمن صارف بنائیں۔ پروڈکشن کے لیے آپ پوسٹگریس، ایس ایس ایل، اور مناسب ماحول کے متغیرات چاہیں گے - آفیشل ڈوکر کمپوز دستاویزات دیکھیں۔

**نوٹس اور سختی:**

- Do **نوٹ** میں سادہ متن میں راز ذخیرہ کریں `docker-compose.yml`; پروڈکشن میں ماحول کی فائلیں، ڈاکر سیکریٹ، یا بیرونی خفیہ مینیجرز کا استعمال کریں۔

- بدل `WEBHOOK_URL` اپنے حقیقی عوامی یو آر ایل کے ساتھ اور روٹ کے لیے ریورس پراکسی کو ترتیب دیں۔ `n8n.example.com` n8n کنٹینر پر۔

- استعمال `EXECUTIONS_MODE=queue` مضبوط پس منظر کی پروسیسنگ کے لئے؛ اس کے لیے قطار میں موجود کارکنوں اور ریڈیز کی ضرورت ہے۔

## میں npm / Node.js کے ساتھ n8n کی خود میزبانی کیسے کروں؟

npm (یا pnpm) کے ذریعے انسٹال کرنا n8n براہ راست میزبان پر چلتا ہے۔ یہ ہلکا ہے (کوئی کنٹینر پرت نہیں) اور یہ واحد صارف، کم پیچیدگی والے انسٹال یا ڈویلپر مشینوں کے لیے مددگار ثابت ہو سکتا ہے۔ تاہم، یہ انحصار کے انتظام، تنہائی، اور سروس کی نگرانی کے لیے منتظم پر زیادہ ذمہ داری ڈالتا ہے۔ سرکاری n8n دستاویزات میں npm انسٹالیشن گائیڈ اور انتباہات شامل ہیں۔

### مطلوبہ OS پیکجز اور نوڈ ورژن:

- ایک مستحکم LTS Node.js استعمال کریں (Node 18 یا Node 20+، n8n ریلیز کی ضروریات سے مماثل ہوں)۔

- انسٹال `build-essential`, `git`، اور ایک پروسیس مینیجر (سسٹم ڈی کی سفارش کی جاتی ہے)۔

- پیداوار کے لیے، اب بھی PostgreSQL اور Redis کو بیرونی خدمات کے طور پر استعمال کریں (وہی استدلال جو Docker کی طرح ہے)۔

### میں n8n کو npm (مرحلہ بہ قدم) کے ذریعے کیسے انسٹال اور چلا سکتا ہوں؟

1. Node.js انسٹال کریں (تجویز کردہ: nvm)

Install nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

Reload your shell (adjust to your shell startup file if needed)

source ~/.bashrc # or ~/.zshrc

Install and use the latest LTS (usually 18 or 20)

nvm install --lts

nvm use --lts

Verify

node -v

npm -v

اگر آپ کو بعد میں "n8n: کمانڈ نہیں ملا" نظر آتا ہے، تو ٹرمینل کو دوبارہ شروع کریں یا یقینی بنائیں کہ nvm کے زیر انتظام npm گلوبل بن پاتھ آپ کے PATH پر ہے۔

---

2. انسٹال کریں اور شروع کریں n8n (مقامی)

npm install -g n8n

n8n -v # verify version

3. پیش منظر میں شروع کریں:

n8n start

ڈیفالٹ URL: <http://localhost:5678/> اگر پورٹ استعمال میں ہے:

export N8N_PORT=5679

n8n start

اختیاری: اسے پس منظر میں چلاتے رہیں (اب بھی مقامی):

npm install -g pm2

pm2 start "n8n" --name n8n

pm2 save

pm2 status

4. پہلی رسائی اور سائن ان:

- اپنے براؤزر میں http://localhost:5678/ کھولیں۔

- پہلی بار چلانے پر، اونر اکاؤنٹ (ای میل + پاس ورڈ) بنانے کے لیے وزرڈ کی پیروی کریں اور سائن ان کریں۔

## میں N8n میں CometAPI کمیونٹی نوڈ کو کیسے انسٹال یا کنفیگر کروں؟

جب آپ خود میزبانی کرتے ہیں تو n8n تصدیق شدہ کمیونٹی نوڈس (GUI انسٹال) اور npm سے دستی انسٹالیشن دونوں کو سپورٹ کرتا ہے۔ CometAPI کو n8n میں ضم کرنے کے دو طریقے ہیں:

### آپشن A - CometAPI کمیونٹی نوڈ استعمال کریں (اگر نوڈس پینل میں دستیاب ہو)

1. n8n میں نوڈس پینل کھولیں (دبائیں۔ `+` or `Tab`).

2. CometAPI ایک تصدیق شدہ کمیونٹی نوڈ ہے، یہ "کمیونٹی سے مزید" کے تحت ظاہر ہوتا ہے۔ کلک کریں اور انسٹال کریں۔

3. تنصیب کے بعد، اگر کہا جائے تو n8n کو دوبارہ شروع کریں۔ ایک نیا بنائیں **اسناد** ترتیبات → اسناد میں (اگر نوڈ فراہم کرتا ہے تو CometAPI اسناد کی قسم کا انتخاب کریں) اور اپنا CometAPI ٹوکن پیسٹ کریں۔

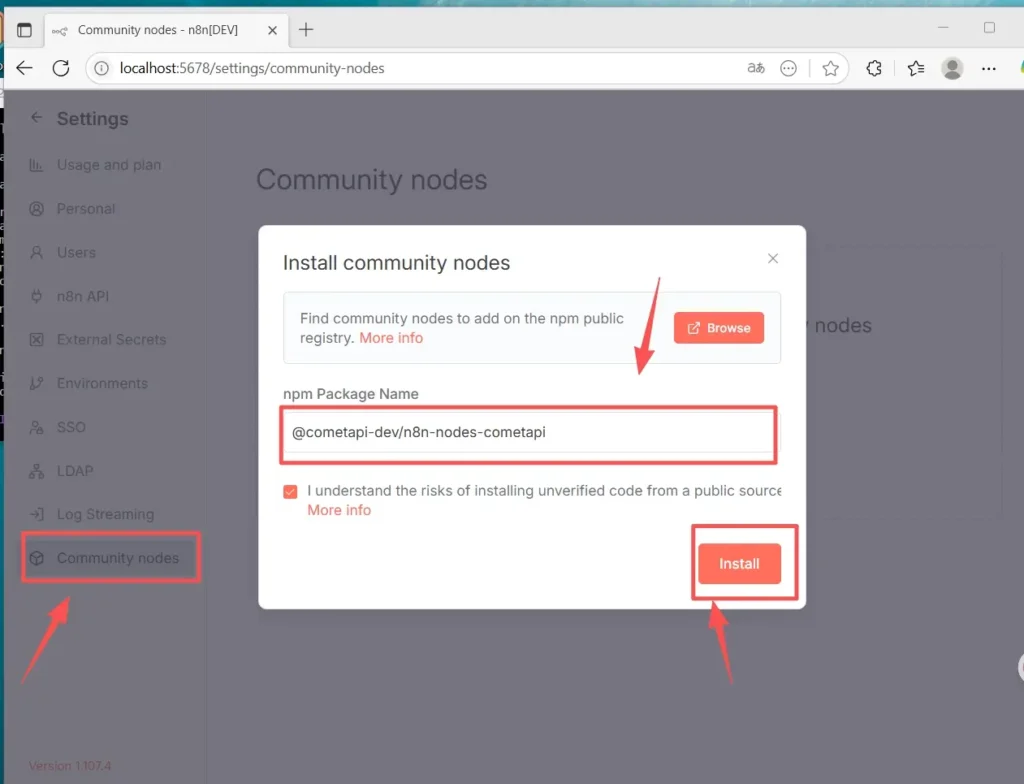

### آپشن B - دستی تنصیب (جب GUI انسٹال دستیاب نہیں ہے)

1. اپنے n8n میزبان/کنٹینر میں SSH۔

2. عالمی n8n میں پیکیج انسٹال کریں۔ `node_modules` یا آپ کا حسب ضرورت فولڈر:

- ترتیبات پر جائیں (نیچے بائیں) > کمیونٹی نوڈس پر کلک کریں "

- کمیونٹی نوڈ انسٹال کریں"

- "npm پیکیج کا نام" میں، درج کریں: `@cometapi-dev/n8n-nodes-cometapi`خطرے کی تصدیق کے باکس کو چیک کریں " پر کلک کریں

- انسٹال کریں"انسٹالیشن کے بعد، آپ نوڈ پینل میں "CometAPI" تلاش کر سکتے ہیں۔

3. n8n دوبارہ شروع کریں۔ اگر آپ کی مثال قطار کے موڈ میں چلتی ہے، تو آپ کو دستاویزات میں بیان کردہ مینوئل انسٹال روٹ پر عمل کرنا چاہیے۔

### کیسے چیک کریں کہ نوڈ انسٹال ہے۔

- دوبارہ شروع کرنے کے بعد، نوڈس پینل کھولیں اور "CometAPI" یا "Comet" تلاش کریں۔ نوڈ کو کمیونٹی پیکج کے طور پر نشان زد کیا جائے گا۔

- اگر آپ نوڈ نہیں دیکھ سکتے ہیں: تصدیق کریں کہ آپ کا مثال کے مالک کا اکاؤنٹ استعمال کیا گیا ہے (صرف مثال کے مالکان انسٹال کر سکتے ہیں)، یا یہ کہ نوڈ پیکیج کنٹینر/امیج لاگز میں غلطیوں کے بغیر انسٹال ہوا ہے۔

## ورک فلو کیسے بنائیں اور API کو کنفیگر کریں۔

### 1. ایک نیا ورک فلو بنائیں

- اپنے n8n مثال (خود میزبانی) میں لاگ ان کریں۔

- کلک کریں **"ورک فلو شامل کریں"** ایک تازہ آٹومیشن کینوس شروع کرنے کے لیے۔

### 2. نوڈ شامل کریں۔

- ایک ٹرگر نوڈ شامل کریں: "دستی محرک" یا "جب 'ورک فلو پر عمل کریں' پر کلک کریں" تلاش کریں۔

- کینوس کے دائیں جانب "+" پر کلک کریں اور نوڈ شامل کرنے کے لیے "CometAPI" تلاش کریں۔

- آپ بائیں نوڈ کی فہرست سے "CometAPI" بھی تلاش کر سکتے ہیں اور اسے کینوس پر گھسیٹ سکتے ہیں۔

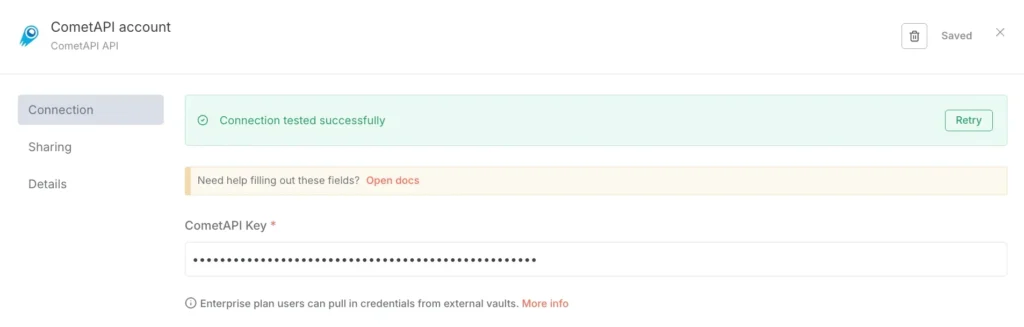

### 3. اسناد کو ترتیب دیں (صرف پہلی بار):

- CometAPI نوڈ میں، "جوڑنے کے لیے اسناد" کے تحت، "نیا تخلیق کریں" کو منتخب کریں۔

- CometAPI کنسول میں جو ٹوکن آپ نے بنایا ہے اسے "CometAPI کلید" میں چسپاں کریں۔

- محفوظ کریں۔ بیس یو آر ایل ڈیفالٹ https://www.cometapi.com/console/ پر ہے اور عام طور پر کسی تبدیلی کی ضرورت نہیں ہے۔

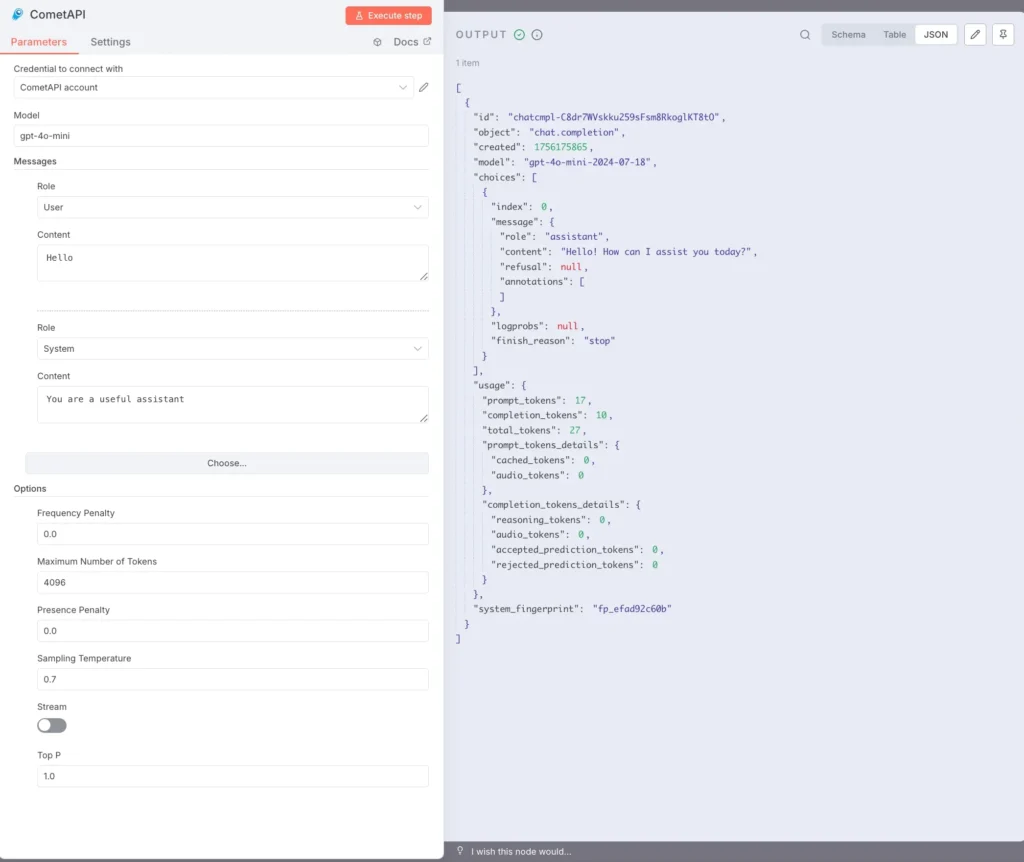

### 4. ماڈل اور پیغامات کو ترتیب دیں:

ماڈل: ایک معاون ماڈل درج کریں، جیسے، `gpt-4o` or `gpt-4o-mini`.

پیغامات: آپ کو کردار اور سیاق و سباق کو بھرنے کی ضرورت ہے، اور آپ کردار کے لیے صارف یا نظام کا انتخاب کر سکتے ہیں۔

اختیاری پیرامیٹرز (ضرورت کے مطابق) ہیں: ٹوکن کی زیادہ سے زیادہ تعداد (مثلاً، 4096)؛ نمونے لینے کا درجہ حرارت (مثال کے طور پر، 0.7)؛ PenaltyStream (سٹریمنگ کو فعال/غیر فعال کریں)۔ مخصوص پیرامیٹر دستاویزات اور وضاحتوں کے لیے، براہ کرم ملاحظہ کریں۔ [CometAPI دستاویزات](https://api.cometapi.com/doc).

### 5. ٹیکسٹ پر عمل درآمد:

CometAPI نوڈ کو منتخب کریں اور "Execute step" پر کلک کریں، یا نیچے "Execute workflow" پر کلک کریں۔

دائیں جانب OUTPUT پینل کو JSON جواب دکھانا چاہیے (بشمول انتخاب، استعمال وغیرہ)۔

اب آپ نے n8n(تجویز) کو مقامی طور پر لینکس پر npm کے ذریعے انسٹال کیا ہے، CometAPI کمیونٹی نوڈ کو انسٹال اور کنفیگر کیا ہے، اور وہ ورک فلو چلا سکتے ہیں جو کہ جوابات حاصل کرنے کے لیے gpt-4o جیسے ماڈلز کو کال کرتے ہیں۔

## عام مسائل کیا ہیں اور میں ان کو کیسے حل کروں؟

### 1) "401 غیر مجاز" یا "غلط API کلید"

- اپنے CometAPI ڈیش بورڈ میں درست ٹوکن سٹرنگ کی تصدیق کریں (وہاں اسی طرح کے ٹوکنز بھی ہو سکتے ہیں)۔ کاپی → n8n اسناد میں پیسٹ کریں اور اگر ضروری ہو تو نوڈ کو دوبارہ شروع کریں۔

- یقینی بنائیں کہ اجازت نامہ ہیڈر فارمیٹ ہے۔ `Bearer sk-xxxxx`.

### 2) کمیونٹی نوڈ انسٹال نہیں ہوگا / "قطار موڈ"

- اگر آپ کا n8n چلتا ہے۔ **قطار موڈ**، GUI انسٹال کو غیر فعال کیا جا سکتا ہے۔ npm کے ذریعے کمیونٹی نوڈس کو انسٹال کرنے کے لیے دستی انسٹالیشن ڈاک کی پیروی کریں یا اپنی مرضی کی تصویر بنائیں جس میں نوڈ شامل ہو۔ تنصیب کے بعد n8n دوبارہ شروع کریں۔

### 3) نوڈ انسٹال کرنے کے بعد پیلیٹ میں نہیں ملا

- n8n دوبارہ شروع کریں۔

- یقینی بنائیں کہ آپ نے پیکج کو صحیح تناظر میں انسٹال کیا ہے (کنٹینر کی تصویر کے اندر یا میں `.n8n/custom` راستہ اگر اس پیٹرن کا استعمال کرتے ہوئے)۔

- ماڈیول ریزولوشن کی غلطیوں کے لیے کنٹینر لاگز کو چیک کریں۔

### 4) شرح کی حد یا کوٹہ کے مسائل

- استعمال اور کوٹہ کے لیے CometAPI ڈیش بورڈ چیک کریں۔

- جب آپ کو حد کی وارننگز یا HTTP 429s کا پتہ چل جائے تو سستے ماڈلز پر ایکسپونیشنل بیک آف اور فال بیک لاگو کریں۔

## اگر کمیونٹی نوڈ دستیاب نہیں ہے یا آپ مزید لچک چاہتے ہیں تو کیا متبادل ہیں؟

ہاں - آپ ہمیشہ استعمال کر سکتے ہیں۔ **HTTP درخواست** نوڈ براہ راست (مکمل کنٹرول) یا ایک [بنیادی URL کے ساتھ OpenAI نوڈ](https://apidoc.cometapi.com/n8n-965890m0) ری ڈائریکشن (عملی شارٹ کٹ)۔ خام HTTP استعمال کرنے سے نئے CometAPI اینڈ پوائنٹس کو اپنانا بھی سیدھا ہو جاتا ہے جیسا کہ وہ ریلیز ہوتے ہیں (مثال کے طور پر، تصویر/ویڈیو اینڈ پوائنٹس)۔ براہ کرم ملاحظہ کریں۔ [رہنمائی](https://apidoc.cometapi.com/n8n-965890m0).

**یہ بھی دیکھتے ہیں** [CometAPI کے ساتھ n8n کا استعمال کیسے کریں۔](https://www.cometapi.com/ur/how-to-use-n8n-with-cometapi/?utm_source=chatgpt.com)

## نتیجہ:

CometAPI آپ کو ماڈل کا انتخاب اور آپریشنل سادگی فراہم کرتا ہے۔ n8n آپ کو بصری آرکیسٹریشن اور توسیع پذیری فراہم کرتا ہے۔ فوری چیٹ/مکمل انٹیگریشن، اور کمیونٹی نوڈس کے لیے اوپن اے آئی کی اسناد کا استعمال کریں جہاں وہ موجود ہیں اور قابل بھروسہ ہیں۔ لاگت، تاخیر، اور سیکورٹی کے لیے ہر ورک فلو کو تیار کریں۔ اہم فیصلوں کے لیے انسانی فال بیک کو ترجیح دیں؛ اور اپنے ماڈل کے انتخاب کو متحرک رکھیں تاکہ آپ AI وینڈر لینڈ سکیپ میں تیزی سے حرکت کرنے والی تبدیلیوں کو اپنا سکیں۔ n8n اور CometAPI کا امتزاج طاقتور ہے، لیکن تمام طاقتور ٹولز کی طرح، اس کو بھی نگہبانوں کی ضرورت ہے — مشاہدہ کریں، جانچیں اور اعادہ کریں۔