DeepSeek đã phát hành một thử nghiệm mô hình được gọi là DeepSeek-V3.2-Exp on Tháng Chín 29, 2025, giới thiệu một cơ chế chú ý thưa thớt mới (DeepSeek Sparse Attention, hay DSA) nhắm đến chi phí suy luận thấp hơn nhiều cho các khối lượng công việc ngữ cảnh dài — và đồng thời công ty cũng giảm giá API xuống khoảng một nửa. Hướng dẫn này giải thích mô hình này là gì, các điểm nổi bật về kiến trúc/tính năng, cách truy cập và sử dụng API (có ví dụ mã), so sánh với các mô hình DeepSeek trước đây, và cách phân tích cú pháp và xử lý phản hồi của nó trong môi trường sản xuất.

DeepSeek-V3.2-Exp là gì?

DeepSeek-V3.2-Exp là phiên bản thử nghiệm trong lộ trình V3 của DeepSeek. Bản phát hành — được công bố vào cuối tháng 9 năm 2025 — được định vị là một bước "trung gian" xác thực các tối ưu hóa kiến trúc cho độ dài ngữ cảnh mở rộng thay vì là một bước nhảy vọt lớn về độ chính xác thô. Đổi mới tiêu đề của nó là DeepSeek Sparse Attention (DSA), một mô hình chú ý chọn lọc các phần của đầu vào dài để giảm chi phí tính toán và bộ nhớ trong khi vẫn hướng tới mục tiêu duy trì chất lượng đầu ra tương đương với V3.1-Terminus.

Tại sao nó quan trọng trong thực tế:

- Chi phí cho các tác vụ ngữ cảnh dài: DSA nhắm đến chi phí chú ý theo bậc hai, giảm thiểu việc tính toán cho các dữ liệu đầu vào rất dài (ví dụ như truy xuất nhiều tài liệu, bản ghi dài, thế giới trò chơi lớn). Chi phí sử dụng API thấp hơn đáng kể đối với các trường hợp sử dụng ngữ cảnh dài thông thường.

- Khả năng tương thích và khả năng truy cập: API DeepSeek sử dụng định dạng yêu cầu tương thích với OpenAI, do đó nhiều quy trình làm việc của OpenAI SDK hiện có có thể được điều chỉnh nhanh chóng.

Những tính năng chính và kiến trúc của DeepSeek V3.2-Exp là gì?

DeepSeek Sparse Attention (DSA) là gì và nó hoạt động như thế nào?

DSA là một sự chú ý thưa thớt hạt mịn kế hoạch được thiết kế để chú ý một cách có chọn lọc đến các mã thông báo thay vì tính toán sự chú ý dày đặc trên toàn bộ bối cảnh. Tóm lại:

- Mô hình này tự động lựa chọn các tập hợp con mã thông báo để xử lý ở mỗi lớp hoặc khối, giảm FLOP cho các dữ liệu đầu vào có độ dài lớn.

- Quá trình lựa chọn được thiết kế để bảo toàn bối cảnh “quan trọng” cho các tác vụ lý luận, tận dụng sự kết hợp giữa các chính sách lựa chọn đã học và phương pháp định tuyến.

DSA là cải tiến cốt lõi trong V3.2-Exp, nhằm mục đích duy trì chất lượng đầu ra gần với các mô hình chú ý dày đặc đồng thời cắt giảm chi phí suy luận, đặc biệt là khi độ dài ngữ cảnh tăng lên. Ghi chú phát hành và trang mô hình nhấn mạnh rằng cấu hình huấn luyện được căn chỉnh với V3.1-Terminus, do đó sự khác biệt về số liệu chuẩn phản ánh cơ chế chú ý thưa thớt chứ không phải là một thay đổi toàn diện trong huấn luyện.

Những kiến trúc/tính năng nào khác đi kèm với V3.2-Exp?

- Chế độ kết hợp (suy nghĩ và không suy nghĩ): DeepSeek tiết lộ hai ID mô hình:

deepseek-chat(không suy nghĩ / trả lời nhanh hơn) vàdeepseek-reasoner(chế độ suy nghĩ có thể hiển thị Chuỗi suy nghĩ hoặc nội dung lý luận trung gian). Các chế độ này cho phép nhà phát triển lựa chọn tốc độ so với tính minh bạch của lý luận rõ ràng. - Cửa sổ ngữ cảnh rất lớn: Họ V3.x hỗ trợ ngữ cảnh rất lớn (dòng V3 cung cấp cho DeepSeek 128K tùy chọn ngữ cảnh trong các bản cập nhật hiện tại), khiến nó phù hợp với quy trình làm việc nhiều tài liệu, nhật ký dài và các tác nhân có nhiều kiến thức.

- Đầu ra JSON và gọi hàm nghiêm ngặt (Bản beta): API hỗ trợ một

response_formatđối tượng có thể ép xuất JSON (và một phiên bản beta gọi hàm nghiêm ngặt). Điều này hữu ích khi bạn cần các đầu ra có thể phân tích cú pháp bằng máy để tích hợp công cụ. - Mã thông báo phát trực tuyến và lý luận: API hỗ trợ các phản hồi phát trực tuyến và — đối với các mô hình lý luận — các mã thông báo nội dung lý luận riêng biệt (thường được hiển thị theo

reasoning_content), cho phép bạn hiển thị hoặc kiểm tra các bước trung gian của mô hình.

Làm thế nào để truy cập và sử dụng API DeepSeek-V3.2-Exp thông qua CometAPI?

DeepSeek cố tình giữ nguyên định dạng API theo phong cách OpenAI — để các SDK OpenAI hiện có hoặc công cụ tương thích có thể được nhắm mục tiêu lại với một URL cơ sở khác. Tôi khuyên bạn nên sử dụng CometAPI để truy cập DeepSeek-V3.2-Exp vì nó có giá thành thấp và là một cổng tổng hợp đa phương thức. DeepSeek hiển thị các tên mô hình ánh xạ đến hành vi V3.2-Exp. Ví dụ:

DeepSeek-V3.2-Exp-thinking — chế độ lý luận/suy nghĩ được ánh xạ tới V3.2-Exp.

DeepSeek-V3.2-Exp-thinking — chế độ trò chuyện/phi lý luận được ánh xạ tới V3.2-Exp.

Làm thế nào để xác thực và URL cơ sở là gì?

- Nhận khóa API từ bảng điều khiển dành cho nhà phát triển CometAPI (áp dụng trên trang web của họ).

- URL cơ sở: (

https://api.cometapi.comorhttps://api.cometapi.com/v1đối với các đường dẫn tương thích với OpenAI). Khả năng tương thích với OpenAI có nghĩa là nhiều SDK OpenAI có thể được trỏ lại tới DeepSeek với những thay đổi nhỏ.

Tôi nên sử dụng ID mô hình nào?

DeepSeek-V3.2-Exp-thinking— chế độ tư duy, hiển thị nội dung chuỗi suy nghĩ/lý luận. Cả hai đều đã được nâng cấp lên V3.2-Exp trong ghi chú phát hành mới nhất.DeepSeek-V3.2-Exp-nothinking— không cần suy nghĩ, phản hồi nhanh hơn, sử dụng tính năng trò chuyện/hoàn thành thông thường.

Ví dụ: yêu cầu curl đơn giản (hoàn thành trò chuyện)

curl -s https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer $cometapi_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize the attached meeting transcript in 3 bullet points."}

],

"max_tokens": 512,

"stream": false

}'

Ví dụ: Python (mẫu máy khách tương thích với OpenAI)

Mẫu này hoạt động sau khi trỏ máy khách OpenAI đến URL cơ sở CometAPI (hoặc sử dụng SDK của CometAPI). Ví dụ dưới đây tuân theo phong cách tài liệu của DeepSeek:

import os

import requests

API_KEY = os.environ

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Extract action items from the following notes..."}

],

"max_tokens": 800

}

r = requests.post(url, headers=headers, json=payload)

r.raise_for_status()

print(r.json())

Không cần SDK đặc biệt — nhưng nếu bạn đã sử dụng SDK của OpenAI, bạn thường có thể cấu hình lại base_url và api_key và giữ nguyên kiểu gọi.

Sử dụng nâng cao: cho phép suy luận hoặc reasoning_content

Nếu bạn cần chuỗi suy nghĩ nội bộ của mô hình (để kiểm tra, chắt lọc hoặc trích xuất các bước trung gian), hãy chuyển sang DeepSeek-V3.2-Exp-thinking. Các reasoning_content trường (và luồng hoặc mã thông báo liên quan) có sẵn trong phản hồi cho chế độ lý luận; tài liệu API cung cấp reasoning_content làm trường phản hồi để kiểm tra CoT được tạo trước khi có câu trả lời cuối cùng. Lưu ý: việc hiển thị các mã thông báo này có thể ảnh hưởng đến việc thanh toán vì chúng là một phần của kết quả mô hình.

Phát trực tuyến và cập nhật một phần

- Sử dụng

"stream": truetrong các yêu cầu nhận delta mã thông báo qua SSE (sự kiện do máy chủ gửi). stream_optionsvàinclude_usagecho phép bạn điều chỉnh cách thức và thời điểm siêu dữ liệu sử dụng xuất hiện trong luồng (hữu ích cho giao diện người dùng gia tăng).

DeepSeek-V3.2-Exp so sánh với các mô hình DeepSeek trước đây như thế nào?

V3.2-Exp so với V3.1-Terminus

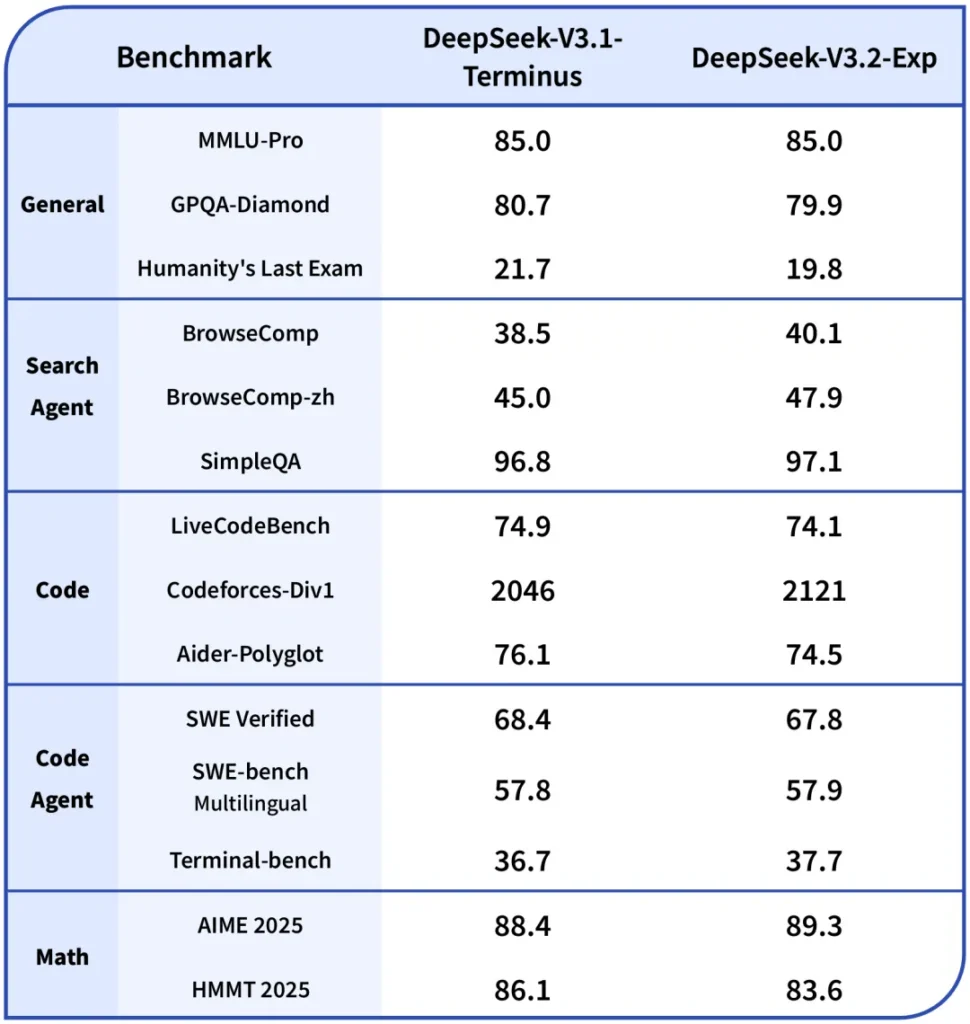

- Sự khác biệt chính: Phiên bản V3.2-Exp giới thiệu cơ chế chú ý thưa thớt để giảm thiểu tính toán cho các ngữ cảnh dài trong khi vẫn giữ nguyên phần còn lại của công thức huấn luyện theo V3.1. Điều này cho phép DeepSeek so sánh hiệu quả một cách rõ ràng và chính xác hơn. ()

- tiêu chuẩn: Ghi chú công khai cho thấy V3.2-Exp hoạt động gần như ngang bằng với V3.1 trong nhiều tác vụ lập luận/lập trình trong khi lại rẻ hơn đáng kể trong các ngữ cảnh dài; lưu ý rằng các tác vụ cụ thể vẫn có thể có những hồi quy nhỏ tùy thuộc vào cách tương tác giữa sự chú ý thưa thớt và các tương tác mã thông báo cần thiết.

V3.2-Exp so với R1 / Các bản phát hành cũ hơn

- Các dòng R1 và V3 theo đuổi các mục tiêu thiết kế khác nhau (R1 trước đây tập trung vào các đánh đổi kiến trúc khác nhau và năng lực đa phương thức ở một số nhánh). V3.2-Exp là một cải tiến trong dòng V3, tập trung vào ngữ cảnh dài và thông lượng. Nếu khối lượng công việc của bạn nặng về các tiêu chuẩn độ chính xác thô một vòng, sự khác biệt có thể không đáng kể; nếu bạn đang vận hành trên các quy trình xử lý đa tài liệu, chi phí của V3.2-Exp có thể hấp dẫn hơn.

Nơi để truy cập Claude Sonnet 4.5

CometAPI là một nền tảng API hợp nhất tổng hợp hơn 500 mô hình AI từ các nhà cung cấp hàng đầu—chẳng hạn như dòng GPT của OpenAI, Gemini của Google, Claude của Anthropic, Midjourney, Suno, v.v.—thành một giao diện duy nhất thân thiện với nhà phát triển. Bằng cách cung cấp xác thực nhất quán, định dạng yêu cầu và xử lý phản hồi, CometAPI đơn giản hóa đáng kể việc tích hợp các khả năng AI vào ứng dụng của bạn. Cho dù bạn đang xây dựng chatbot, trình tạo hình ảnh, nhà soạn nhạc hay đường ống phân tích dựa trên dữ liệu, CometAPI cho phép bạn lặp lại nhanh hơn, kiểm soát chi phí và không phụ thuộc vào nhà cung cấp—tất cả trong khi khai thác những đột phá mới nhất trên toàn bộ hệ sinh thái AI.

Các nhà phát triển có thể truy cập DeepSeek V3.2 Exp thông qua CometAPI, phiên bản mẫu mới nhất luôn được cập nhật trên trang web chính thức. Để bắt đầu, hãy khám phá các khả năng của mô hình trong Sân chơi và tham khảo ý kiến Hướng dẫn API để biết hướng dẫn chi tiết. Trước khi truy cập, vui lòng đảm bảo bạn đã đăng nhập vào CometAPI và lấy được khóa API. Sao chổiAPI cung cấp mức giá thấp hơn nhiều so với giá chính thức để giúp bạn tích hợp.

Sẵn sàng chưa?→ Đăng ký CometAPI ngay hôm nay !

Kết luận

DeepSeek-V3.2-Exp là một bản phát hành thử nghiệm thực tế, hướng đến việc làm cho công việc ngữ cảnh dài trở nên rẻ hơn và khả thi hơn, đồng thời vẫn duy trì chất lượng đầu ra của V3. Đối với các nhóm xử lý tài liệu dài, bản ghi chép hoặc lập luận đa tài liệu, đây là một phiên bản đáng để thử nghiệm: API sử dụng giao diện kiểu OpenAI giúp việc tích hợp trở nên đơn giản, đồng thời làm nổi bật cả cơ chế DSA và các mức giảm giá đáng kể, giúp thay đổi phép tính kinh tế của việc xây dựng quy mô lớn. Như với bất kỳ mô hình thử nghiệm nào, việc đánh giá toàn diện, đo lường và triển khai theo từng giai đoạn là điều cần thiết.