Dòng sản phẩm GLM-4.5, do Zhipu AI (Z.ai) phát triển, đại diện cho một bước tiến đáng kể trong các mô hình ngôn ngữ lớn (LLM) nguồn mở. Được thiết kế để hợp nhất các khả năng lập luận, mã hóa và tác tử, GLM-4.5 mang lại hiệu suất mạnh mẽ trên nhiều ứng dụng khác nhau. Cho dù bạn là nhà phát triển, nhà nghiên cứu hay người đam mê, hướng dẫn này cung cấp thông tin chi tiết về cách truy cập và sử dụng hiệu quả dòng sản phẩm GLM-4.5.

Dòng GLM-4.5 là gì và tại sao nó lại quan trọng?

GLM-4.5 là một mô hình lập luận lai kết hợp hai chế độ riêng biệt: "chế độ suy nghĩ" cho lập luận phức tạp và sử dụng công cụ, và "chế độ không suy nghĩ" cho phản hồi tức thì. Cách tiếp cận chế độ kép này cho phép mô hình xử lý hiệu quả một loạt các tác vụ. Bộ sản phẩm bao gồm hai biến thể chính:

- GLM-4.5:Với tổng cộng 355 tỷ tham số với 32 tỷ tham số đang hoạt động, mô hình này được thiết kế để triển khai trên quy mô lớn trong các tác vụ suy luận, tạo và đa tác nhân.

- GLM-4.5-Không khí: Phiên bản nhẹ với tổng cộng 106 tỷ tham số và 12 tỷ tham số hoạt động, được tối ưu hóa cho suy luận trên thiết bị và đám mây quy mô nhỏ hơn mà không ảnh hưởng đến các khả năng cốt lõi.

Cả hai mô hình đều hỗ trợ các chế độ lý luận kết hợp, cung cấp chế độ "suy nghĩ" và "không suy nghĩ" để cân bằng giữa các nhiệm vụ lý luận phức tạp và phản hồi nhanh. Chúng là mã nguồn mở và được phát hành theo giấy phép MIT, giúp chúng có thể sử dụng cho mục đích thương mại và phát triển thứ cấp.

Nguyên tắc kiến trúc và thiết kế

Về cơ bản, GLM-4.5 tận dụng MoE để định tuyến động các token thông qua các mạng con chuyên gia chuyên biệt, cho phép hiệu suất tham số và khả năng mở rộng vượt trội (). Phương pháp này đồng nghĩa với việc cần ít tham số hơn để kích hoạt mỗi lần truyền tiếp, giúp giảm chi phí vận hành trong khi vẫn duy trì hiệu suất tiên tiến cho các tác vụ suy luận và mã hóa ().

Khả năng chính

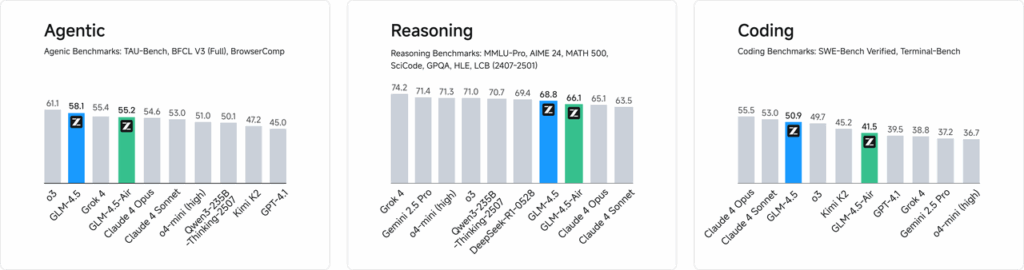

- Lý luận và mã hóa lai:GLM-4.5 chứng minh hiệu suất của SOTA trên cả tiêu chuẩn hiểu ngôn ngữ tự nhiên và các bài kiểm tra tạo mã, thường sánh ngang với các mô hình độc quyền về độ chính xác và tính trôi chảy.

- Tích hợp Agentic: Giao diện gọi công cụ tích hợp cho phép GLM-4.5 sắp xếp các quy trình làm việc nhiều bước—chẳng hạn như truy vấn cơ sở dữ liệu, sắp xếp API và tạo giao diện tương tác—trong một phiên duy nhất.

- Các hiện vật đa phương thức:Từ các ứng dụng nhỏ HTML/CSS đến các mô phỏng dựa trên Python và SVG tương tác, GLM-4.5 có thể tạo ra các sản phẩm có đầy đủ chức năng, nâng cao sự tương tác của người dùng và năng suất của nhà phát triển.

Tại sao GLM-4.5 lại là sản phẩm đột phá?

GLM-4.5 được ca ngợi không chỉ vì hiệu suất tuyệt vời mà còn vì đã định nghĩa lại giá trị đề xuất của LLM nguồn mở trong bối cảnh doanh nghiệp và nghiên cứu.

Điểm chuẩn hiệu suất

Trong các đánh giá độc lập trên 52 tác vụ lập trình—bao gồm phát triển web, phân tích dữ liệu và tự động hóa—GLM-4.5 luôn vượt trội hơn các mô hình mã nguồn mở hàng đầu khác về độ tin cậy khi gọi công cụ và khả năng hoàn thành tác vụ tổng thể. Trong các bài kiểm tra so sánh với Claude Code, Kimi-K2 và Qwen3-Coder, GLM-4.5 đạt điểm số cao nhất trong các bài kiểm tra chuẩn như bảng xếp hạng “SWE-bench Verified”.

Hiệu quả chi phí

Ngoài độ chính xác, thiết kế MoE của GLM-4.5 còn giúp giảm đáng kể chi phí suy luận. Giá công khai cho các lệnh gọi API bắt đầu từ mức thấp nhất là 0.8 Nhân dân tệ cho mỗi triệu token đầu vào và 2 Nhân dân tệ cho mỗi triệu token đầu ra—chỉ bằng khoảng một phần ba chi phí của các dịch vụ độc quyền tương đương. Cùng với tốc độ tạo đỉnh điểm 100 token/giây, mô hình này hỗ trợ triển khai thông lượng cao, độ trễ thấp mà không tốn kém quá nhiều chi phí.

Làm thế nào bạn có thể truy cập GLM-4.5?

1. Truy cập trực tiếp qua Nền tảng Z.ai

Phương pháp trực tiếp nhất để tương tác với GLM-4.5 là thông qua nền tảng Z.ai. Bằng cách truy cập chat.z.aiNgười dùng có thể chọn mẫu GLM-4.5 và bắt đầu tương tác thông qua giao diện thân thiện với người dùng. Nền tảng này cho phép thử nghiệm và tạo mẫu ngay lập tức mà không cần tích hợp phức tạp. Người dùng có thể chọn mẫu GLM-4.5 hoặc GLM-4.5-Air ở góc trên bên trái và bắt đầu trò chuyện ngay lập tức. Giao diện này thân thiện với người dùng và không yêu cầu thiết lập, lý tưởng cho các tương tác và trình diễn nhanh chóng.

2. Quyền truy cập API dành cho nhà phát triển

Đối với các nhà phát triển muốn tích hợp GLM-4.5 vào ứng dụng, nền tảng API Z.ai cung cấp hỗ trợ toàn diện. API này cung cấp giao diện tương thích OpenAI cho cả mô hình GLM-4.5 và GLM-4.5-Air, giúp tích hợp liền mạch vào các quy trình làm việc hiện có. Tài liệu chi tiết và hướng dẫn tích hợp có sẵn tại Tài liệu API Z.ai .

3. Triển khai nguồn mở

Đối với những ai quan tâm đến việc triển khai cục bộ, các mô hình GLM-4.5 có sẵn trên các nền tảng như Hugging Face và ModelScope. Các mô hình này được phát hành theo giấy phép nguồn mở MIT, cho phép sử dụng thương mại và phát triển thứ cấp. Chúng có thể được tích hợp với các nền tảng suy luận chính thống như vLLM và SGLang.

4. Tích hợp với CometAPI

Sao chổiAPI cung cấp quyền truy cập hợp lý vào các mô hình GLM-4.5 thông qua nền tảng API thống nhất của họ tại Dasborad. Tích hợp này đơn giản hóa việc xác thực, giới hạn tốc độ và xử lý lỗi, khiến nó trở thành lựa chọn tuyệt vời cho các nhà phát triển đang tìm kiếm một thiết lập đơn giản. Ngoài ra, định dạng API chuẩn hóa của CometAPI cho phép dễ dàng chuyển đổi mô hình và thử nghiệm A/B giữa GLM-4.5 và các mô hình khả dụng khác.

Các nhà phát triển có thể truy cập vào GLM-4.5 Series bằng cách nào?

Có nhiều kênh để tải và triển khai GLM-4.5, từ tải xuống mô hình trực tiếp đến API được quản lý.

Qua Hugging Face và ModelScope

Cả Hugging Face và ModelScope đều lưu trữ toàn bộ series GLM-4.5 dưới không gian tên zai-org. Sau khi đồng ý với giấy phép MIT, các nhà phát triển có thể:

- Sao chép kho lưu trữ:

git clone https://huggingface.co/zai-org/GLM-4.5

- Cài đặt phụ thuộc:

pip install transformers accelerate

- Tải mô hình:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

Thông qua CometAPI

Sao chổiAPI cung cấp API không có máy chủ cho GLM‑4.5 và API không khí GLM-4.5 với mức giá trả theo mã thông báo, có thể truy cập thông qua, bằng cách cấu hình các điểm cuối tương thích với OpenAI, bạn có thể gọi GLM-4.5 thông qua trình khách Python của OpenAI với các điều chỉnh tối thiểu đối với cơ sở mã hiện có. CometAPI không chỉ cung cấp GLM4.5 và GLM-4.5-air mà còn cung cấp tất cả các mô hình chính thức:

| tên mẫu | giới thiệu | Giá |

glm-4.5 | Mô hình lý luận mạnh mẽ nhất của chúng tôi, với 355 tỷ tham số | Mã thông báo đầu vào $0.48 Mã thông báo đầu ra $1.92 |

glm-4.5-air | Hiệu suất mạnh mẽ, nhẹ và tiết kiệm chi phí | Mã thông báo đầu vào $0.16 Mã thông báo đầu ra $1.07 |

glm-4.5-x | Hiệu suất cao, lý luận mạnh mẽ, phản ứng cực nhanh | Mã thông báo đầu vào $1.60 Mã thông báo đầu ra $6.40 |

glm-4.5-airx | Nhẹ, Hiệu suất mạnh mẽ, Phản hồi cực nhanh | Mã thông báo đầu vào $0.02 Mã thông báo đầu ra $0.06 |

glm-4.5-flash | Hiệu suất mạnh mẽ, tuyệt vời cho việc lập trình suy luận và tác nhân | Mã thông báo đầu vào $3.20 Mã thông báo đầu ra $12.80 |

Tích hợp Python và REST API

Đối với các triển khai riêng, các tổ chức có thể lưu trữ GLM-4.5 trên các cụm GPU chuyên dụng bằng Docker hoặc Kubernetes. Một thiết lập RESTful điển hình bao gồm:

Khởi chạy Máy chủ suy luận:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Gửi yêu cầu:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

Những phương pháp tốt nhất để tích hợp GLM-4.5 vào ứng dụng là gì?

Để tối đa hóa ROI và đảm bảo hiệu suất mạnh mẽ, các nhóm nên cân nhắc những điều sau:

Tối ưu hóa API và giới hạn tốc độ

- Yêu cầu hàng loạt: Nhóm các lời nhắc tương tự để giảm chi phí và tận dụng thông lượng GPU.

- Lưu trữ các truy vấn phổ biến: Lưu trữ các lần hoàn thành thường xuyên tại địa phương để tránh các lệnh suy luận trùng lặp.

- Lấy mẫu thích ứng: Điều chỉnh động

temperaturevàtop_pdựa trên độ phức tạp của truy vấn để cân bằng giữa tính sáng tạo và tính quyết định.

Bảo mật và Tuân thủ

- Vệ sinh dữ liệu: Xử lý sơ bộ dữ liệu đầu vào để loại bỏ thông tin nhạy cảm trước khi gửi đến mô hình.

- Kiểm soát truy cập: Triển khai khóa API, danh sách IP cho phép và điều chỉnh tốc độ để ngăn chặn việc sử dụng sai mục đích và lạm dụng.

- Ghi nhật ký kiểm tra: Ghi lại lời nhắc, nội dung hoàn thành và siêu dữ liệu để tuân thủ các yêu cầu của công ty và quy định, đặc biệt là trong bối cảnh tài chính hoặc chăm sóc sức khỏe.

Bắt đầu

CometAPI là một nền tảng API hợp nhất tổng hợp hơn 500 mô hình AI từ các nhà cung cấp hàng đầu—chẳng hạn như dòng GPT của OpenAI, Gemini của Google, Claude của Anthropic, Midjourney, Suno, v.v.—thành một giao diện duy nhất thân thiện với nhà phát triển. Bằng cách cung cấp xác thực nhất quán, định dạng yêu cầu và xử lý phản hồi, CometAPI đơn giản hóa đáng kể việc tích hợp các khả năng AI vào ứng dụng của bạn. Cho dù bạn đang xây dựng chatbot, trình tạo hình ảnh, nhà soạn nhạc hay đường ống phân tích dựa trên dữ liệu, CometAPI cho phép bạn lặp lại nhanh hơn, kiểm soát chi phí và không phụ thuộc vào nhà cung cấp—tất cả trong khi khai thác những đột phá mới nhất trên toàn bộ hệ sinh thái AI.

Đối với các nhà phát triển đang tìm cách tích hợp GLM-4.5 vào ứng dụng của mình, nền tảng CometAPI cung cấp một giải pháp mạnh mẽ. API này cung cấp các giao diện tương thích với OpenAI, cho phép tích hợp liền mạch vào các quy trình làm việc hiện có. Tài liệu hướng dẫn sử dụng và tài liệu chi tiết có sẵn trên Trang API Comet.

Các nhà phát triển có thể truy cập GLM‑4.5 và API không khí GLM-4.5 thông qua Sao chổiAPI, các phiên bản mẫu mới nhất được liệt kê là tính đến ngày xuất bản bài viết. Để bắt đầu, hãy khám phá các khả năng của mẫu trong Sân chơi và tham khảo ý kiến Hướng dẫn API để biết hướng dẫn chi tiết. Trước khi truy cập, vui lòng đảm bảo bạn đã đăng nhập vào CometAPI và lấy được khóa API. Sao chổiAPI cung cấp mức giá thấp hơn nhiều so với giá chính thức để giúp bạn tích hợp.

Kết luận

GLM-4.5 là một bước tiến đáng kể trong lĩnh vực mô hình ngôn ngữ lớn, cung cấp một giải pháp linh hoạt cho nhiều ứng dụng. Kiến trúc lập luận lai, khả năng tác tử và bản chất mã nguồn mở của nó khiến nó trở thành một lựa chọn hấp dẫn cho các nhà phát triển và tổ chức đang tìm cách tận dụng các công nghệ AI tiên tiến. Bằng cách khám phá các phương pháp truy cập khác nhau được nêu trong hướng dẫn này, người dùng có thể tích hợp GLM-4.5 vào dự án của mình một cách hiệu quả và đóng góp vào sự phát triển liên tục của nó.