OpenAI gần đây đã công bố một số bản cập nhật, bao gồm việc phát hành mô hình GPT-5-Codex-Mini, cải tiến giới hạn tốc độ cho hệ thống phân cấp nhiều người dùng và tối ưu hóa hiệu quả xử lý mô hình.

OpenAI's GPT-5-Codex-Mini là một biến thể mới được công bố, tập trung vào nhà phát triển của GPT-5-Codex: một mô hình nhỏ hơn, được tối ưu hóa về chi phí và thông lượng, được thiết kế để cung cấp hầu hết các hỗ trợ mã hóa của GPT-5-Codex nhưng với chi phí thấp hơn nhiều và khối lượng sử dụng cao hơn. Biến thể "Mini" được định vị là một lựa chọn thực tế cho các phiên mã hóa dài, tự động hóa nền và quy trình làm việc của nhà phát triển với tần suất cao, trong đó khả năng xử lý đỉnh cao không quan trọng bằng việc nhận được nhiều token/yêu cầu hơn cho cùng một gói.

GPT-5-Codex-Mini là gì và tính năng của nó là gì?

GPT-5-Codex-Mini là một biến thể nhỏ gọn, tiết kiệm chi phí của dòng sản phẩm GPT-5-Codex của OpenAI, được đóng gói riêng cho các bề mặt sản phẩm Codex (tích hợp CLI và IDE). Nó được định vị là một mô hình "nhỏ hơn, tiết kiệm chi phí hơn", đánh đổi một lượng nhỏ khả năng hoạt động đỉnh để lấy mức tiêu thụ tài nguyên thấp hơn đáng kể và hạn ngạch sử dụng cao hơn cho các quy trình làm việc tương tác của nhà phát triển. Mô hình mini này được thiết kế để cho phép các nhà phát triển chạy nhiều lượt mã hóa hơn (OpenAI mô tả sơ lược Sử dụng nhiều hơn 4 lần đối với cùng một mức đăng ký ChatGPT) trong khi vẫn giữ độ trễ và chi phí ở mức thấp cho các tác vụ kỹ thuật phổ biến, được xác định rõ ràng.

Về khả năng, GPT-5-Codex-Mini kế thừa các tính năng cốt lõi của dòng sản phẩm Codex: hiểu biết sâu sắc về cơ sở mã nguồn và thực thi các tác vụ nhiều bước theo cách "đại lý". Dựa trên các tính năng của Codex CLI, các nhà phát triển có thể gửi các lệnh ngôn ngữ tự nhiên, đoạn mã, ảnh chụp màn hình hoặc sơ đồ thiết kế giao diện cho Codex trên một thiết bị đầu cuối tương tác. Mô hình sẽ cung cấp một kế hoạch trước, sau đó tự động duyệt tệp, chỉnh sửa mã, chạy lệnh và kiểm tra sau khi được người dùng chấp thuận.

Từ góc độ mô hình, các sản phẩm Codex cho phép đính kèm hình ảnh (chẳng hạn như ảnh chụp màn hình giao diện người dùng, bản nháp thiết kế hoặc ảnh chụp màn hình thông báo lỗi) vào phiên làm việc trong terminal hoặc IDE. Mô hình có thể hiểu cả nội dung văn bản và hình ảnh, nhưng đầu ra vẫn chủ yếu là mã văn bản và giải thích. Do đó, GPT-5-Codex-Mini có thể được coi là một mô hình mã proxy chủ yếu là "nhập văn bản + hình ảnh, xuất văn bản" và không đảm nhiệm các tác vụ như tạo hình ảnh, tạo âm thanh hoặc tạo video.

GPT-5-Codex-Mini so với GPT-5-Codex như thế nào?

Có gì mới trong Codex?

Ngoài GPT-5-Codex-Mini đã được triển khai, OpenAI đã đồng loạt tăng giới hạn tốc độ Codex lên 50% cho các cấp độ người dùng ChatGPT Plus, Business và Edu, qua đó tăng đáng kể giới hạn yêu cầu khả dụng. Đồng thời, người dùng ChatGPT Pro sẽ được hưởng quyền xử lý ưu tiên để cải thiện tốc độ phản hồi và trải nghiệm thực thi tác vụ.

Hơn nữa, OpenAI đã thực hiện một bản nâng cấp nhỏ cho mô hình GPT-5-Codex, tối ưu hóa hiệu suất của nó trong các tình huống cộng tác. Mô hình cập nhật cho thấy sự cải thiện về một số điểm phần trăm trên các chỉ số đánh giá chính, tăng khoảng 3% hiệu quả sử dụng mã thông báo và khả năng xử lý các trường hợp ngoại lệ mạnh mẽ hơn, do đó giảm nhu cầu hướng dẫn người dùng.

| cấp độ người dùng | Bộ luật GPT-5 | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Biz/Edu | tăng âm lượng tin nhắn lên 1.5 lần. | tăng âm lượng tin nhắn lên 6 lần. |

GPT-5-Codex-Mini so với GPT-5-Codex: sự khác biệt về điểm chuẩn

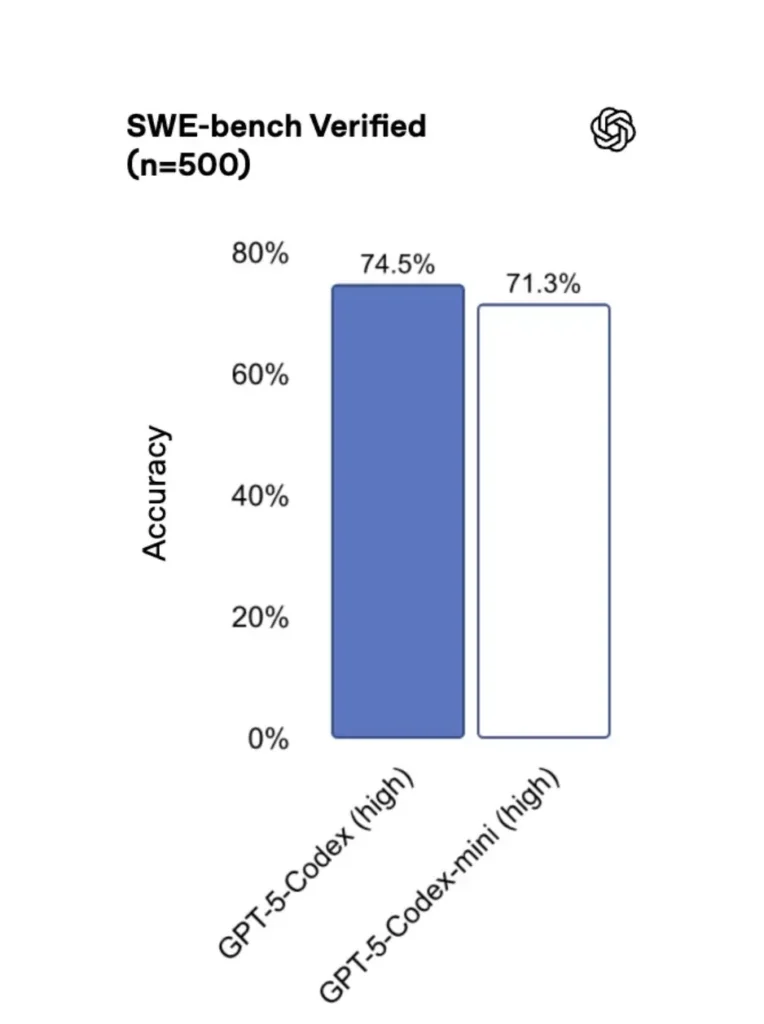

So với phiên bản gốc, hiệu năng của GPT-5-Codex-Mini giảm nhẹ, nhưng các nhà phát triển được hưởng mức tín dụng sử dụng cao gấp khoảng bốn lần. Trong bài kiểm tra SWE-bench Verified, GPT-5 High đạt 72.8%, GPT-5-Codex đạt 74.5% và GPT-5-Codex-Mini đạt 71.3%.

Codex (và phiên bản mini của nó) sử dụng ít mã thông báo hơn đáng kể cho các tương tác nhẹ—các tài liệu của OpenAI tuyên bố giảm theo thứ tự hàng chục phần trăm điểm cho các lời nhắc đơn giản (ví dụ: một số liệu được trích dẫn là ≈93.7% ít mã thông báo hơn về các tương tác nhẹ đối với họ Codex so với GPT-5 trong một số trường hợp).

GPT-5-Codex-Mini so với GPT-5-Codex: sự khác biệt về tính năng

- Kích thước và chi phí: Mini rõ ràng nhỏ hơn và tiết kiệm chi phí hơn; OpenAI định hình nó như cho phép sử dụng nhiều hơn khoảng 4 lần với cùng một ràng buộc đăng ký. Đây là một tối ưu hóa hạn ngạch/hiệu quả cho các tác vụ thường ngày của nhà phát triển.

- Phong bì năng lực: GPT-5-Codex vẫn là lựa chọn có năng lực cao hơn cho các tác vụ tác nhân dài và phức tạp (cải tiến lớn, đánh giá mã chuyên sâu, chu kỳ kiểm thử kéo dài). Mini được tinh chỉnh để nhanh hơn và ít tốn tài nguyên hơn cho các tương tác ngắn thường xuyên.

- Độ trễ và giới hạn tốc độ: Mini thường có độ trễ thấp hơn và cho phép giới hạn tốc độ cao hơn cho mỗi gói — phù hợp với các quy trình làm việc tương tác dày đặc.

- Bề mặt mặc định: Mini có sẵn dưới dạng mô hình có thể lựa chọn trong Codex CLI và IDE Extension; GPT-5-Codex là mặc định cho các tác vụ đám mây và luồng đánh giá mã sâu trong Codex.

Khi nào nên sử dụng Mini so với Full Codex

- Sử dụng Thống dành cho: dàn giáo, tạo mã lặp đi lặp lại, cải tiến nhỏ, hoàn thiện tương tác trong quá trình chỉnh sửa và khi làm việc theo hạn ngạch hoặc ràng buộc về chi phí.

- Sử dụng Bộ luật GPT-5 dành cho: đánh giá mã toàn diện, nhiệm vụ tự động kéo dài nhiều giờ, tái cấu trúc phức tạp và nhiệm vụ yêu cầu lập luận mạnh mẽ nhất của mô hình và thực thi theo hướng kiểm thử.

Tôi có thể truy cập GPT-5-Codex-Mini (CLI, IDE, API) bằng cách nào?

Codex CLI (đầu cuối trước)

OpenAI được giới thiệu gpt-5-codex-mini như một tùy chọn mô hình bên trong Codex CLI. Các mẫu sử dụng điển hình tuân theo quy trình làm việc của Codex CLI: bắt đầu một phiên tương tác, chỉ định mô hình, đính kèm tệp hoặc ảnh chụp màn hình, chạy "tác vụ Codex Cloud", v.v. CLI cũng hỗ trợ nhanh /model chuyển đổi giữa đầy đủ gpt-5-codex và gpt-5-codex-mini. Khi chạy lần đầu, bạn sẽ cần xác thực bằng tài khoản ChatGPT/Pro/Enterprise (hoặc cung cấp khóa API). CLI cung cấp nhiều lệnh khác nhau cho phép Codex quét cơ sở mã, chạy thử nghiệm, mở REPL hoặc áp dụng các khuyến nghị vá lỗi.

Ví dụ (phiên tương tác Codex CLI):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Luồng đó phản ánh các mặc định mới của Codex CLI, trong đó công cụ sẽ đề xuất Mini gần với giới hạn sử dụng.

Phần mở rộng VS Code / IDE

Có — tiện ích mở rộng Codex IDE (VS Code) đã bao gồm gpt-5-codex-mini (tùy chọn). Cài đặt tiện ích mở rộng Codex trong Visual Studio Code để nhận tính năng hoàn thiện mã nội tuyến, đề xuất tái cấu trúc và các bản sửa lỗi nhanh do AI hỗ trợ. Tiện ích mở rộng này cũng cung cấp các thao tác nhanh (tạo mã, giải thích mã đã chọn, tái cấu trúc) và có thể chạy các tác vụ Codex Cloud từ trình soạn thảo, các bước của VS Code:

- Cài đặt tiện ích mở rộng OpenAI Codex / ChatGPT cho VS Code.

- Đăng nhập bằng tài khoản ChatGPT của bạn (Plus/Pro/Business).

- Mở bảng lệnh:

Cmd/Ctrl+Shift+P → Codex: Set Model→ chọngpt-5-codex-mini. - Sử dụng lệnh nội tuyến (chọn mã → nhấp chuột phải → “Giải thích bằng Codex” hoặc nhấn phím nóng đã cấu hình).

Ví dụ: Lệnh nội tuyến VS Code (các bước giả)

- Chọn một chức năng trong

user_service.py. - Ấn Bản

Cmd/Ctrl+Shift+P → Codex: Explain Selectionhoặc sử dụng nút chuột phải → “Giải thích bằng Codex”. - Tiện ích mở rộng mở ra một bảng điều khiển bên cạnh với lời giải thích của Mini, các bài kiểm tra được đề xuất và nút "Tạo PR" chỉ bằng một cú nhấp chuột sử dụng tác vụ Codex Cloud để đưa nhánh vào để xem xét.

Còn API thì sao — tôi có thể gọi nó từ ứng dụng của mình không?

Thông báo của OpenAI cho biết Hỗ trợ API sẽ sớm ra mắt đối với GPT-5-Codex-Mini; tại thời điểm viết bài, mô hình hiện đã có sẵn trong chuỗi công cụ Codex (CLI/IDE). Điều này có nghĩa là các máy khách API sản xuất nên chuẩn bị cho tên mô hình. gpt-5-codex-mini trong API Yêu cầu/Phản hồi sau khi được xuất bản. Trong thời gian chờ đợi, bạn có thể tạo nguyên mẫu với các luồng Codex CLI và IDE.

Khi quyền truy cập API được bật, lệnh gọi thông thường (kiểu Phản hồi) có thể trông như sau:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Những phương pháp tốt nhất để thiết kế nhanh với Codex Mini là gì?

Dưới đây là các phương pháp và mô hình thực tế tốt nhất đã được thử nghiệm thực tế để tận dụng tối đa giá trị của Codex Mini trong quy trình kỹ thuật sản xuất.

1) Chiến lược lựa chọn mô hình — kết hợp và kết hợp

Sử dụng Mini cho các tác vụ tần suất cao, độ phức tạp thấp (định dạng, tái cấu trúc nhỏ, kiểm tra tự động) và chuyển sang Codex đầy đủ cho thiết kế phức tạp, gỡ lỗi sâu hoặc chuyển đổi trên toàn bộ kho lưu trữ. Tự động chuyển đổi: Codex CLI đã đề xuất Mini ở mức sử dụng 90% và bạn có thể viết mã lệnh /model chuyển đổi công cụ của bạn để chọn mô hình dựa trên độ phức tạp của nhiệm vụ.

2) Mẫu kỹ thuật nhanh chóng

Tạo các mẫu nhắc nhở nhỏ, mang tính xác định cho các tác vụ lặp lại: tạo thử nghiệm, bản nháp nhật ký thay đổi, tạo thông báo cam kết và mô tả PR. Lưu trữ chúng dưới dạng các đoạn mã có thể tái sử dụng trong kho lưu trữ của bạn hoặc dưới dạng cài đặt trước nhắc nhở Codex.

Mẫu nhắc nhở ví dụ cho các bài kiểm tra đơn vị:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Tự động hóa lưới an toàn — phê duyệt & cổng CI

Không bao giờ cho phép mô hình trực tiếp đẩy mã mà không có sự chấp thuận của con người. Sử dụng các chế độ phê duyệt của Codex và các tác vụ Codex Cloud để tạo các diff và yêu cầu sự chấp thuận của con người trong CI. Codex CLI hỗ trợ "chế độ phê duyệt" nên các chỉnh sửa phải được phê duyệt trước khi áp dụng.

4) Lưu trữ và loại bỏ các lệnh gọi mô hình trùng lặp

Đối với các lời nhắc lặp lại (ví dụ: giải thích một hàm), hãy lưu trữ đệm phản hồi được mã hóa bằng dấu nhắc + băm tệp. Điều này giúp giảm các cuộc gọi trùng lặp và duy trì tính dự đoán được của hồ sơ chi phí.

5) Sử dụng luồng + sự khác biệt gia tăng

Nếu có thể, hãy yêu cầu đầu ra phát trực tuyến và các thay đổi gia tăng thay vì viết lại toàn bộ tệp. Điều này giúp giảm thiểu việc sử dụng mã thông báo và giúp người đánh giá thấy được những thay đổi mục tiêu.

6) Kiểm tra đơn vị - dòng máy phát điện đầu tiên

Tạo các bài kiểm tra và chạy chúng cục bộ trong một môi trường tạm thời. Nếu các bài kiểm tra không thành công, hãy lặp lại với mô hình cung cấp các bản sửa lỗi cho các bài kiểm tra không thành công. Đóng khung mỗi lần lặp lại như một lời nhắc riêng biệt, bao gồm cả kết quả kiểm tra.

Ví dụ về đoạn mã tự động hóa Codex CLI (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Kết luận

GPT-5-Codex-Mini là một bước tiến thực tế: nó thừa nhận rằng quy trình làm việc của nhà phát triển thường bị chi phối bởi nhiều tương tác ngắn, trong đó độ trễ, chi phí và luồng dữ liệu không bị gián đoạn là những yếu tố quan trọng. Bằng cách cung cấp một tầng nhỏ dành riêng cho việc sử dụng IDE và CLI, OpenAI mang đến cho các nhóm khả năng mở rộng quy mô hỗ trợ lập trình hàng ngày mà không cần phải ngay lập tức áp dụng mô hình có chi phí cao nhất cho mọi tương tác.

Các nhà phát triển có thể truy cập API GPT-5-Codex ,API GPT-5 Pro Thông qua CometAPI, các mô hình mới nhất của cometAPI được liệt kê tính đến ngày bài viết được xuất bản. Trước khi truy cập, vui lòng đảm bảo bạn đã đăng nhập vào CometAPI và lấy được khóa API.Sao chổiAPI cung cấp mức giá thấp hơn nhiều so với giá chính thức để giúp bạn tích hợp.

Sẵn sàng chưa?→ Đăng ký CometAPI ngay hôm nay !

Nếu bạn muốn biết thêm mẹo, hướng dẫn và tin tức về AI, hãy theo dõi chúng tôi trên VK, X và Discord!