Trong giai đoạn 2025–2026, bối cảnh công cụ AI tiếp tục được củng cố: các API cổng (như CometAPI) được mở rộng để cung cấp quyền truy cập theo kiểu OpenAI vào hàng trăm mô hình, trong khi các ứng dụng LLM dành cho người dùng cuối (như AnythingLLM) tiếp tục cải thiện nhà cung cấp "OpenAI Chung" của họ để cho phép các ứng dụng máy tính để bàn và cục bộ gọi bất kỳ điểm cuối nào tương thích với OpenAI. Điều này giúp việc định tuyến lưu lượng AnythingLLM qua CometAPI trở nên dễ dàng và tận hưởng các lợi ích của việc lựa chọn mô hình, định tuyến chi phí và thanh toán thống nhất — trong khi vẫn sử dụng giao diện người dùng cục bộ và các tính năng RAG/agent của AnythingLLM.

AnythingLLM là gì và tại sao bạn muốn kết nối nó với CometAPI?

AnythingLLM là gì?

AnythingLLM là một ứng dụng AI mã nguồn mở, tất cả trong một, đồng thời là máy khách cục bộ/đám mây để xây dựng trợ lý trò chuyện, quy trình làm việc tăng cường truy xuất (RAG) và các tác nhân điều khiển LLM. Ứng dụng cung cấp giao diện người dùng mượt mà, API dành cho nhà phát triển, các tính năng không gian làm việc/tác nhân và hỗ trợ LLM cục bộ và đám mây — được thiết kế để riêng tư theo mặc định và có thể mở rộng thông qua các plugin. AnythingLLM cung cấp OpenAI chung nhà cung cấp cho phép nó giao tiếp với các API LLM tương thích với OpenAI.

CometAPI là gì?

CometAPI là một nền tảng tổng hợp API thương mại giúp phơi bày Hơn 500 mô hình AI thông qua một giao diện REST kiểu OpenAI và thanh toán thống nhất. Trên thực tế, nó cho phép bạn gọi các mô hình từ nhiều nhà cung cấp (OpenAI, Anthropic, các biến thể Google/Gemini, mô hình hình ảnh/âm thanh, v.v.) thông qua cùng một giao diện. https://api.cometapi.com/v1 điểm cuối và một khóa API duy nhất (định dạng sk-xxxxx). CometAPI hỗ trợ các điểm cuối theo phong cách OpenAI tiêu chuẩn như /v1/chat/completions, /v1/embeddingsv.v., giúp dễ dàng điều chỉnh các công cụ đã hỗ trợ API tương thích với OpenAI.

Tại sao nên tích hợp AnythingLLM với CometAPI?

Ba lý do thực tế:

- Lựa chọn mô hình và tính linh hoạt của nhà cung cấp: AnythingLLM có thể sử dụng "bất kỳ LLM nào tương thích với OpenAI" thông qua trình bao bọc OpenAI chung của nó. Việc trỏ trình bao bọc đó đến CometAPI cho phép truy cập ngay lập tức vào hàng trăm mô hình mà không cần thay đổi giao diện người dùng hoặc luồng của AnythingLLM.

- Tối ưu hóa chi phí/hoạt động: Sử dụng CometAPI cho phép bạn chuyển đổi mô hình (hoặc chuyển xuống mô hình rẻ hơn) một cách tập trung để kiểm soát chi phí và duy trì thanh toán thống nhất thay vì phải xử lý nhiều khóa nhà cung cấp.

- Thử nghiệm nhanh hơn: Bạn có thể A/B các mô hình khác nhau (ví dụ:

gpt-4o,gpt-4.5, các biến thể Claude hoặc các mô hình đa phương thức nguồn mở) thông qua cùng một giao diện người dùng AnythingLLM — hữu ích cho các tác nhân, phản hồi RAG, tóm tắt và các tác vụ đa phương thức.

Môi trường và điều kiện bạn phải chuẩn bị trước khi tích hợp

Yêu cầu hệ thống và phần mềm (cấp cao)

- Máy tính để bàn hoặc máy chủ chạy AnythingLLM (Windows, macOS, Linux) — cài đặt trên máy tính để bàn hoặc phiên bản tự lưu trữ. Xác nhận bạn đang sử dụng bản dựng gần đây có hiển thị Sở thích LLM / Nhà cung cấp AI cài đặt.

- Tài khoản CometAPI và khóa API (

sk-xxxxxbí mật kiểu). Bạn sẽ sử dụng bí mật này trong trình cung cấp OpenAI chung của AnythingLLM. - Kết nối mạng từ máy của bạn đến

https://api.cometapi.com(không có tường lửa chặn HTTPS đi). - Tùy chọn nhưng được khuyến nghị: môi trường Python hoặc Node hiện đại để thử nghiệm (Python 3.10 trở lên hoặc Node 18 trở lên), curl và trình khách HTTP (Postman / HTTPie) để kiểm tra tính hợp lệ của CometAPI trước khi kết nối vào AnythingLLM.

Các điều kiện cụ thể của AnythingLLM

OpenAI chung Nhà cung cấp LLM là tuyến đường được khuyến nghị cho các điểm cuối mô phỏng giao diện API của OpenAI. Tài liệu của AnythingLLM lưu ý rằng nhà cung cấp này tập trung vào nhà phát triển và bạn nên hiểu rõ các đầu vào mình cung cấp. Nếu bạn sử dụng phát trực tuyến hoặc điểm cuối của bạn không hỗ trợ phát trực tuyến, AnythingLLM có cài đặt để tắt phát trực tuyến cho OpenAI chung.

Danh sách kiểm tra an ninh và vận hành

- Xử lý khóa CometAPI giống như bất kỳ bí mật nào khác — không lưu nó vào kho lưu trữ; lưu trữ nó trong chuỗi khóa hệ điều hành hoặc biến môi trường nếu có thể.

- Nếu bạn dự định sử dụng tài liệu nhạy cảm trong RAG, hãy đảm bảo rằng các cam kết về quyền riêng tư điểm cuối đáp ứng nhu cầu tuân thủ của bạn (kiểm tra tài liệu/điều khoản của CometAPI).

- Quyết định số lượng token tối đa và giới hạn cửa sổ ngữ cảnh để ngăn chặn các hóa đơn vượt quá giới hạn.

Làm thế nào để cấu hình AnythingLLM để sử dụng CometAPI (từng bước)?

Dưới đây là trình tự các bước cụ thể — tiếp theo là các biến môi trường mẫu và đoạn mã để kiểm tra kết nối trước khi bạn lưu cài đặt trong giao diện người dùng AnythingLLM.

Bước 1 — Nhận khóa CometAPI của bạn

- Đăng ký hoặc đăng nhập tại CometAPI.

- Điều hướng đến “Khóa API” và tạo một khóa — bạn sẽ nhận được một chuỗi trông giống như

sk-xxxxx. Giữ bí mật nhé.

Bước 2 — Xác minh CometAPI hoạt động bằng yêu cầu nhanh

Sử dụng curl hoặc Python để gọi điểm cuối hoàn tất trò chuyện đơn giản để xác nhận kết nối.

Ví dụ về lọn tóc xoăn

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Nếu điều này trả về 200 và phản hồi JSON với choices mảng, khóa và mạng của bạn đang hoạt động. (Tài liệu của CometAPI hiển thị bề mặt và điểm cuối theo kiểu OpenAI).

Ví dụ Python (yêu cầu)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

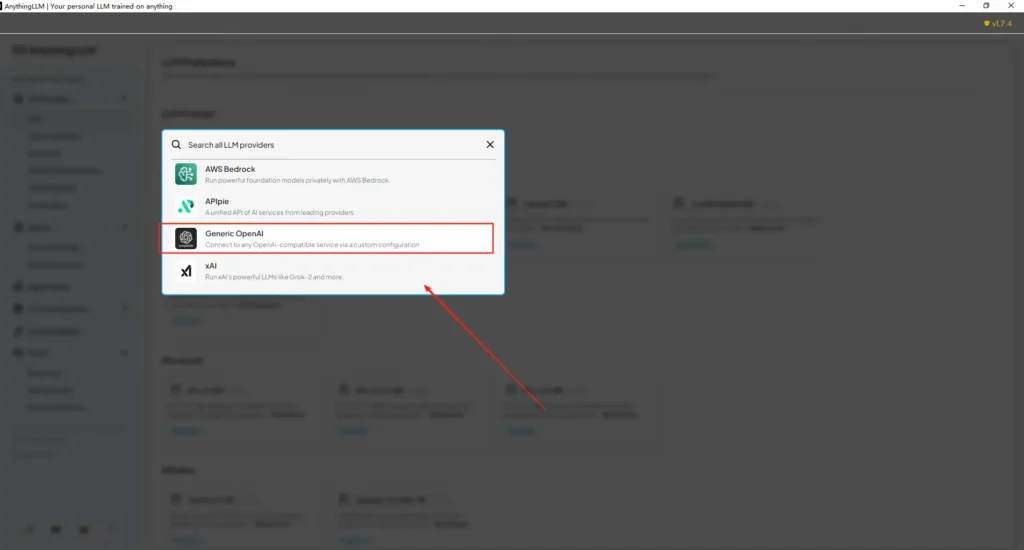

Bước 3 — Cấu hình AnythingLLM (UI)

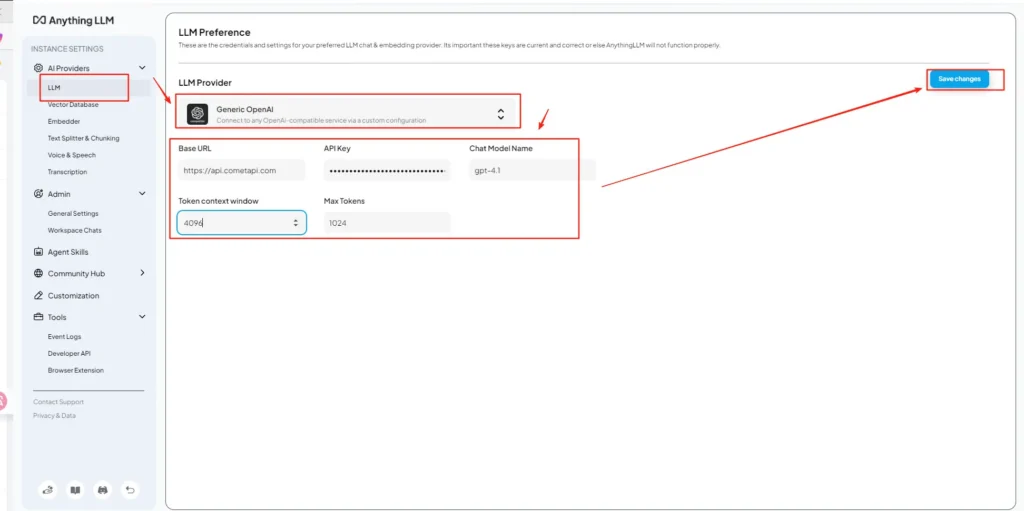

Mở AnythingLLM → Cài đặt → Nhà cung cấp AI → Sở thích LLM (hoặc đường dẫn tương tự trong phiên bản của bạn). Sử dụng OpenAI chung nhà cung cấp và điền vào các trường như sau:

Cấu hình API (ví dụ)

• Vào menu cài đặt AnythingLLM, tìm mục Tùy chọn LLM trong Nhà cung cấp AI.

• Chọn Generic OpenAI làm nhà cung cấp mô hình, nhậphttps://api.cometapi.com/v1trong trường URL.

• Dánsk-xxxxxtừ CometAPI trong hộp nhập khóa API. Điền vào cửa sổ ngữ cảnh Token và Max Tokens theo mô hình thực tế. Bạn cũng có thể tùy chỉnh tên mô hình trên trang này, chẳng hạn như thêmgpt-4omô hình.

Điều này phù hợp với hướng dẫn “OpenAI chung” của AnythingLLM (trình bao bọc dành cho nhà phát triển) và phương pháp URL cơ sở tương thích với OpenAI của CometAPI.

Bước 4 — Đặt tên mô hình và giới hạn mã thông báo

Trên cùng màn hình cài đặt, hãy thêm hoặc tùy chỉnh tên mô hình chính xác như CometAPI xuất bản chúng (ví dụ: gpt-4o, minimax-m2, kimi-k2-thinking) để giao diện người dùng AnythingLLM có thể hiển thị các mô hình đó cho người dùng. CometAPI xuất bản chuỗi mô hình cho từng nhà cung cấp.

Bước 5 — Kiểm tra trong AnythingLLM

Bắt đầu một cuộc trò chuyện mới hoặc sử dụng không gian làm việc hiện có, chọn nhà cung cấp OpenAI Chung (nếu bạn có nhiều nhà cung cấp), chọn một trong các tên mô hình CometAPI bạn đã thêm và chạy một lời nhắc đơn giản. Nếu bạn nhận được các kết quả hoàn thành mạch lạc, bạn đã được tích hợp.

AnythingLLM sử dụng những cài đặt đó như thế nào trong nội bộ

Trình bao bọc OpenAI chung của AnythingLLM xây dựng các yêu cầu theo kiểu OpenAI (/v1/chat/completions, /v1/embeddings), vì vậy, sau khi bạn trỏ URL cơ sở và cung cấp khóa CometAPI, AnythingLLM sẽ định tuyến các cuộc trò chuyện, cuộc gọi của tác nhân và các yêu cầu nhúng thông qua CometAPI một cách minh bạch. Nếu bạn sử dụng tác nhân AnythingLLM ( @agent flows), chúng sẽ kế thừa cùng một nhà cung cấp.

Những phương pháp tốt nhất và những cạm bẫy có thể xảy ra là gì?

Các phương pháp hay nhất

- Sử dụng cài đặt ngữ cảnh phù hợp với mô hình: Hãy khớp Cửa sổ ngữ cảnh mã thông báo và Mã thông báo tối đa của AnythingLLM với mô hình bạn chọn trên CometAPI. Việc không khớp sẽ dẫn đến việc cắt bớt hoặc gọi không thành công ngoài ý muốn.

- Bảo mật khóa API của bạn: Lưu trữ khóa CometAPI trong các biến môi trường và/hoặc Kubernetes/trình quản lý bí mật; đừng bao giờ nhập chúng vào git. AnythingLLM sẽ lưu trữ khóa trong cài đặt cục bộ của nó nếu bạn nhập chúng vào UI — hãy coi bộ nhớ máy chủ là nhạy cảm.

- Bắt đầu với các mô hình rẻ hơn/nhỏ hơn cho luồng thử nghiệm: Sử dụng CometAPI để thử nghiệm các mô hình chi phí thấp hơn cho phát triển, giữ lại các mô hình cao cấp cho sản xuất. CometAPI quảng cáo rõ ràng về chuyển đổi chi phí và thanh toán thống nhất.

- Theo dõi mức sử dụng và đặt cảnh báo: CometAPI cung cấp bảng thông tin sử dụng — thiết lập ngân sách/cảnh báo để tránh hóa đơn bất ngờ.

- Kiểm tra các tác nhân và công cụ một cách riêng biệt: Các tác nhân AnythingLLM có thể kích hoạt các hành động; hãy thử chúng bằng lời nhắc an toàn và trên các phiên bản dàn dựng trước.

Những cạm bẫy phổ biến

- Giao diện người dùng so với

.envxung đột: Khi tự lưu trữ, cài đặt UI có thể ghi đè.envthay đổi (và ngược lại). Kiểm tra các/app/server/.envnếu mọi thứ trở lại bình thường sau khi khởi động lại. Báo cáo sự cố cộng đồngLLM_PROVIDERđặt lại. - Tên mô hình không khớp: Việc sử dụng tên model không có sẵn trên CometAPI sẽ gây ra lỗi 400/404 từ cổng. Luôn kiểm tra các model khả dụng trong danh sách model CometAPI.

- Giới hạn mã thông báo và phát trực tuyến: Nếu bạn cần phản hồi phát trực tuyến, hãy kiểm tra xem mô hình CometAPI có hỗ trợ phát trực tuyến hay không (và phiên bản UI của AnythingLLM có hỗ trợ tính năng này không). Một số nhà cung cấp có ngữ nghĩa phát trực tuyến khác nhau.

Sự tích hợp này mở ra những trường hợp sử dụng thực tế nào?

Thế hệ tăng cường truy xuất (RAG)

Sử dụng trình tải tài liệu + cơ sở dữ liệu vector của AnythingLLM với CometAPI LLM để tạo câu trả lời theo ngữ cảnh. Bạn có thể thử nghiệm với mô hình nhúng giá rẻ + mô hình trò chuyện đắt tiền, hoặc giữ mọi thứ trên CometAPI để thanh toán thống nhất. Luồng RAG của AnythingLLM là một tính năng tích hợp chính.

Tự động hóa tác nhân

AnythingLLM hỗ trợ @agent quy trình công việc (duyệt trang, gọi công cụ, chạy tự động hóa). Việc gọi LLM của tác nhân định tuyến thông qua CometAPI cho phép bạn lựa chọn các mô hình cho các bước điều khiển/diễn giải mà không cần sửa đổi mã tác nhân.

Kiểm tra A/B đa mô hình và tối ưu hóa chi phí

Chuyển đổi mô hình theo không gian làm việc hoặc tính năng (ví dụ: gpt-4o để có câu trả lời sản xuất, gpt-4o-mini dành cho dev). CometAPI giúp việc hoán đổi mô hình trở nên đơn giản và tập trung chi phí.

Đường ống đa phương thức

CometAPI cung cấp hình ảnh, âm thanh và các mô hình chuyên biệt. Hỗ trợ đa phương thức của AnythingLLM (thông qua các nhà cung cấp) cùng với các mô hình của CometAPI cho phép tạo chú thích hình ảnh, tóm tắt đa phương thức hoặc chuyển đổi âm thanh thông qua cùng một giao diện.

Kết luận

CometAPI tiếp tục định vị mình là một cổng đa mô hình (hơn 500 mô hình, API theo phong cách OpenAI) — điều này khiến nó trở thành đối tác tự nhiên cho các ứng dụng như AnythingLLM vốn đã hỗ trợ nhà cung cấp OpenAI chung. Tương tự, nhà cung cấp chung của AnythingLLM và các tùy chọn cấu hình gần đây giúp việc kết nối với các cổng này trở nên dễ dàng. Sự hội tụ này giúp đơn giản hóa quá trình thử nghiệm và chuyển đổi sang sản xuất vào cuối năm 2025.

Cách bắt đầu với Comet API

CometAPI là một nền tảng API hợp nhất tổng hợp hơn 500 mô hình AI từ các nhà cung cấp hàng đầu—chẳng hạn như dòng GPT của OpenAI, Gemini của Google, Claude của Anthropic, Midjourney, Suno, v.v.—thành một giao diện duy nhất thân thiện với nhà phát triển. Bằng cách cung cấp xác thực nhất quán, định dạng yêu cầu và xử lý phản hồi, CometAPI đơn giản hóa đáng kể việc tích hợp các khả năng AI vào ứng dụng của bạn. Cho dù bạn đang xây dựng chatbot, trình tạo hình ảnh, nhà soạn nhạc hay đường ống phân tích dựa trên dữ liệu, CometAPI cho phép bạn lặp lại nhanh hơn, kiểm soát chi phí và không phụ thuộc vào nhà cung cấp—tất cả trong khi khai thác những đột phá mới nhất trên toàn bộ hệ sinh thái AI.

Để bắt đầu, hãy khám phá khả năng của mô hìnhSao chổiAPI trong Sân chơi và tham khảo hướng dẫn API để biết hướng dẫn chi tiết. Trước khi truy cập, vui lòng đảm bảo bạn đã đăng nhập vào CometAPI và lấy được khóa API. VớietAPI cung cấp mức giá thấp hơn nhiều so với giá chính thức để giúp bạn tích hợp.

Sẵn sàng chưa?→ Đăng ký CometAPI ngay hôm nay !

Nếu bạn muốn biết thêm mẹo, hướng dẫn và tin tức về AI, hãy theo dõi chúng tôi trên VK, X và Discord!