DeepSeek-V3.1 là mô hình suy luận lai mới nhất của DeepSeek, hỗ trợ cả chế độ trò chuyện nhanh "không suy nghĩ" và chế độ "suy nghĩ/lý luận" thận trọng hơn, cung cấp ngữ cảnh dài (lên đến 128K), đầu ra có cấu trúc và gọi hàm, và có thể được truy cập trực tiếp thông qua API tương thích OpenAI của DeepSeek, thông qua điểm cuối tương thích Anthropic hoặc thông qua CometAPI. Dưới đây, tôi sẽ hướng dẫn bạn về mô hình, các điểm nổi bật về điểm chuẩn và chi phí, các tính năng nâng cao (gọi hàm, đầu ra JSON, chế độ suy luận), sau đó cung cấp các mẫu mã cụ thể từ đầu đến cuối: các lệnh gọi REST DeepSeek trực tiếp (curl / Node / Python), cách sử dụng máy khách Anthropic và gọi qua CometAPI.

DeepSeek-V3.1 là gì và có gì mới trong bản phát hành này?

DeepSeek-V3.1 là phiên bản phát hành mới nhất trong họ DeepSeek V3: một dòng mô hình ngôn ngữ lớn, dung lượng cao, kết hợp nhiều chuyên gia, được cung cấp thiết kế suy luận lai với hai “chế độ” hoạt động — một chế độ nhanh trò chuyện không suy nghĩ chế độ và một suy nghĩ / lý luận Chế độ này có thể tiết lộ dấu vết kiểu chuỗi suy nghĩ cho các tác vụ suy luận khó hơn và việc sử dụng tác nhân/công cụ. Phiên bản này nhấn mạnh độ trễ "suy nghĩ" nhanh hơn, khả năng của công cụ/tác nhân được cải thiện và xử lý ngữ cảnh lâu hơn cho các quy trình làm việc quy mô tài liệu.

Những điểm chính cần lưu ý:

- Hai chế độ hoạt động:

deepseek-chatvề thông lượng và chi phí,deepseek-reasoner(một mô hình lý luận) khi bạn muốn có dấu vết chuỗi suy nghĩ hoặc độ trung thực của lý luận cao hơn. - Nâng cấp xử lý tác nhân/công cụ và cải tiến trình phân tích cú pháp/bối cảnh cho các tài liệu dài.

- Độ dài ngữ cảnh: lên đến ~128K mã thông báo (cho phép tài liệu dài, cơ sở mã, nhật ký).

Điểm chuẩn đột phá

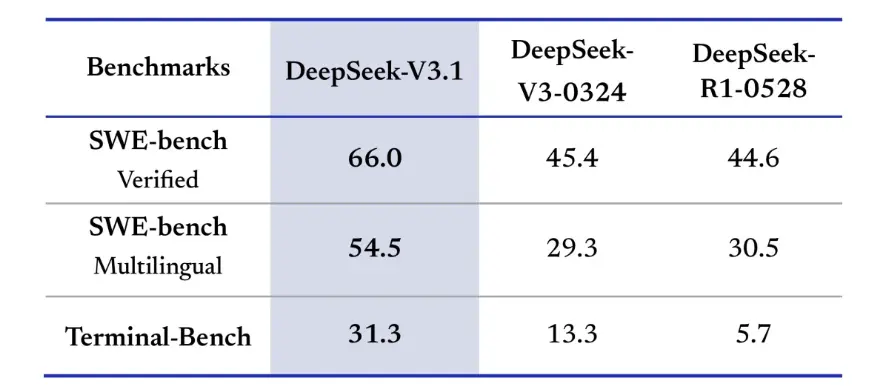

DeepSeek-V3.1 đã chứng minh những cải tiến đáng kể trong các thử thách mã hóa thực tế. Trong đánh giá SWE-bench Verified, đánh giá tần suất mô hình sửa các sự cố GitHub để đảm bảo các bài kiểm tra đơn vị vượt qua, V3.1 đạt tỷ lệ thành công 66%, so với 45% của cả V3-0324 và R1. Trong phiên bản đa ngôn ngữ, V3.1 đã giải quyết được 54.5% sự cố, gần gấp đôi tỷ lệ thành công khoảng 30% của các phiên bản khác. Trong đánh giá Terminal-Bench, kiểm tra xem mô hình có thể hoàn thành thành công các tác vụ trong môi trường Linux trực tiếp hay không, DeepSeek-V3.1 đã thành công trong 31% tác vụ, so với 13% và 6% của các phiên bản khác. Những cải tiến này chứng minh rằng DeepSeek-V3.1 đáng tin cậy hơn trong việc thực thi mã và hoạt động trong môi trường công cụ thực tế.

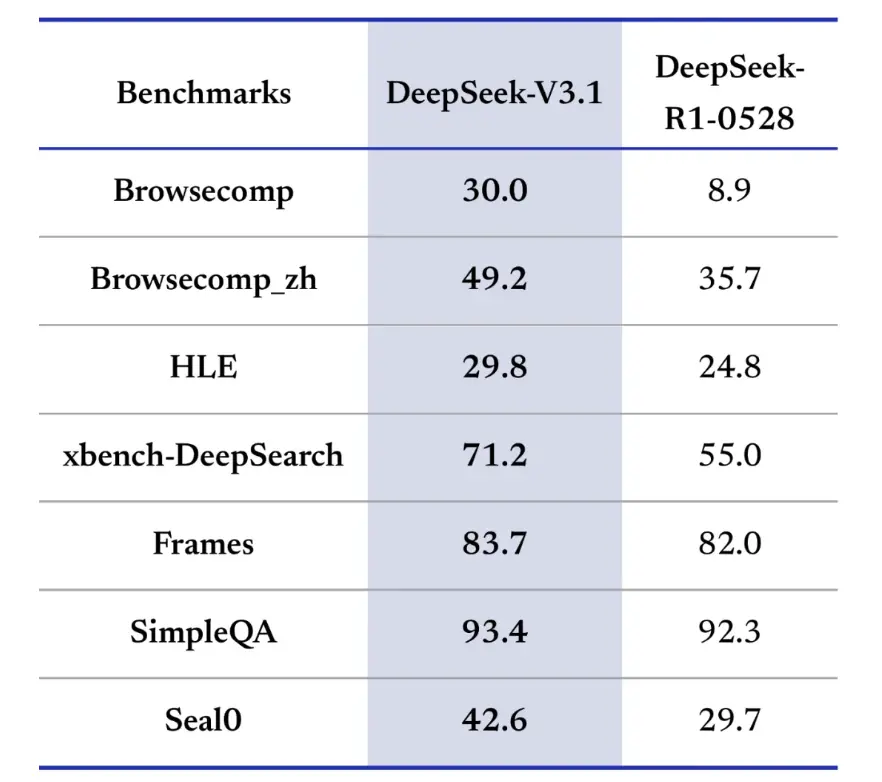

Tiêu chuẩn truy xuất thông tin cũng ưu tiên DeepSeek-V3.1 trong việc duyệt, tìm kiếm và trả lời câu hỏi. Trong đánh giá BrowseComp, yêu cầu điều hướng và trích xuất câu trả lời từ một trang web, V3.1 đã trả lời đúng 30% câu hỏi, so với 9% của R1. Trong phiên bản tiếng Trung, DeepSeek-V3.1 đạt độ chính xác 49%, so với 36% của R1. Trong Kỳ thi ngôn ngữ khó (HLE), V3.1 vượt trội hơn R1 một chút, đạt độ chính xác lần lượt là 30% và 25%. Trong các tác vụ tìm kiếm sâu như xbench-DeepSearch, yêu cầu tổng hợp thông tin từ nhiều nguồn, V3.1 đạt 71% so với 1% của R55. DeepSeek-V3.1 cũng thể hiện sự dẫn trước nhỏ nhưng nhất quán trong các tiêu chuẩn như (lập luận có cấu trúc), SimpleQA (trả lời câu hỏi thực tế) và Seal0 (trả lời câu hỏi theo lĩnh vực cụ thể). Nhìn chung, V3.1 vượt trội hơn R1 đáng kể trong việc truy xuất thông tin và trả lời câu hỏi nhẹ.

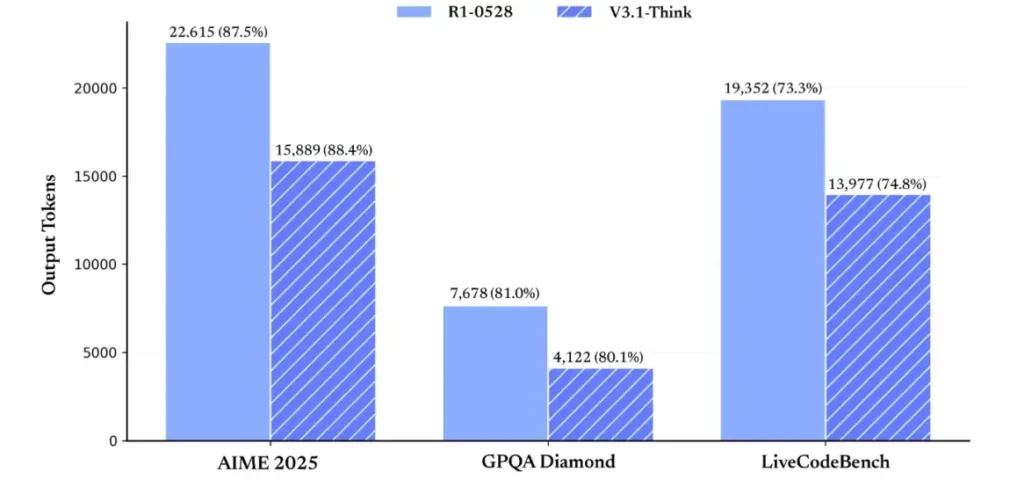

Về hiệu quả suy luận, kết quả sử dụng mã thông báo đã chứng minh tính hiệu quả của nó. Trong bài kiểm tra AIME 2025 (một bài kiểm tra toán khó), V3.1-Think đạt độ chính xác tương đương hoặc nhỉnh hơn R1 một chút (88.4% so với 87.5%), nhưng sử dụng ít mã thông báo hơn khoảng 30%. Trong bài kiểm tra GPQA Diamond (một bài kiểm tra sau đại học đa lĩnh vực), hai mô hình gần như ngang bằng nhau (80.1% so với 81.0%), nhưng V3.1 sử dụng gần một nửa số mã thông báo so với R1. Trong bài kiểm tra chuẩn LiveCodeBench, bài kiểm tra đánh giá suy luận mã, V3.1 không chỉ chính xác hơn (74.8% so với 73.3%) mà còn súc tích hơn. Điều này chứng tỏ V3.1-Think có khả năng đưa ra suy luận chi tiết mà không cần dài dòng.

Nhìn chung, V3.1 thể hiện một bước nhảy vọt đáng kể so với V3-0324. So với R1, V3.1 đạt độ chính xác cao hơn ở hầu hết mọi điểm chuẩn và hiệu quả hơn trong các tác vụ suy luận phức tạp. Điểm chuẩn duy nhất mà R1 đạt được là GPQA, nhưng chi phí gần gấp đôi.

Làm thế nào để lấy khóa API và thiết lập tài khoản phát triển?

Bước 1: Đăng ký và tạo tài khoản

- Truy cập cổng thông tin dành cho nhà phát triển của DeepSeek (tài liệu/bảng điều khiển DeepSeek). Tạo tài khoản bằng email hoặc nhà cung cấp dịch vụ SSO của bạn.

- Hoàn tất mọi bước kiểm tra danh tính hoặc thiết lập thanh toán theo yêu cầu của cổng thông tin.

Bước 2: Tạo khóa API

- Trong bảng điều khiển, hãy đi tới phím API → Tạo khóa. Đặt tên cho khóa của bạn (ví dụ:

dev-local-01). - Sao chép khóa và lưu trữ trong trình quản lý bí mật an toàn (xem các biện pháp thực hành sản xuất tốt nhất bên dưới).

Mẹo: Một số cổng và bộ định tuyến của bên thứ ba (ví dụ: CometAPI) cho phép bạn sử dụng một khóa cổng duy nhất để truy cập các mô hình DeepSeek thông qua chúng — điều này hữu ích cho việc dự phòng nhiều nhà cung cấp (xem API DeepSeek V3.1 phần).

Làm thế nào để thiết lập môi trường phát triển của tôi (Linux/macOS/Windows)?

Đây là thiết lập đơn giản, có thể tái tạo cho Python và Node.js, hoạt động với DeepSeek (điểm cuối tương thích với OpenAI), CometAPI và Anthropic.

Điều kiện tiên quyết

- Python 3.10+ (khuyến nghị), pip, virtualenv.

- Node.js 18+ và npm/yarn.

- curl (để kiểm tra nhanh).

Môi trường Python (từng bước một)

- Tạo thư mục dự án:

mkdir deepseek-demo && cd deepseek-demo

python -m venv .venv

source .venv/bin/activate # macOS / Linux

# .venv\Scripts\activate # Windows PowerShell

- Cài đặt các gói tối thiểu:

pip install --upgrade pip

pip install requests

# Optional: install an OpenAI-compatible client if you prefer one:

pip install openai

- Lưu khóa API của bạn vào biến môi trường (không bao giờ cam kết):

export DEEPSEEK_KEY="sk_live_xxx"

export CometAPI_KEY="or_xxx"

export ANTHROPIC_KEY="anthropic_xxx"

(Sử dụng Windows PowerShell $env:DEEPSEEK_KEY = "…")

Môi trường nút (từng bước)

- Khởi tạo:

mkdir deepseek-node && cd deepseek-node

npm init -y

npm install node-fetch dotenv

- Tạo ra một

.envtập tin:

DEEPSEEK_KEY=sk_live_xxx

CometAPI_KEY=or_xxx

ANTHROPIC_KEY=anthropic_xxx

Làm thế nào để gọi DeepSeek-V3.1 trực tiếp — ví dụ mã từng bước?

API của DeepSeek tương thích với OpenAI. Dưới đây là sao chép dán ví dụ: curl, Python (yêu cầu và phong cách SDK openai) và Node.

Bước 1: Ví dụ về lọn tóc xoăn đơn giản

curl https://api.deepseek.com/v1/chat/completions \

-H "Authorization: Bearer $DEEPSEEK_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-chat-v3.1",

"messages": [

{"role":"system","content":"You are a concise engineering assistant."},

{"role":"user","content":"Give a 5-step secure deployment checklist for a Django app."}

],

"max_tokens": 400,

"temperature": 0.0,

"reasoning_enabled": true

}'

Ghi chú: reasoning_enabled Chuyển đổi chế độ Think (cờ nhà cung cấp). Tên cờ chính xác có thể khác nhau tùy theo nhà cung cấp — hãy kiểm tra tài liệu mô hình.

Bước 2: Python (yêu cầu) với phép đo từ xa đơn giản

import os, requests, time, json

API_KEY = os.environ

URL = "https://api.deepseek.com/v1/chat/completions"

payload = {

"model": "deepseek-chat-v3.1",

"messages": [

{"role": "system", "content": "You are a helpful coding assistant."},

{"role": "user", "content": "Refactor this Flask function to be testable: ..."}

],

"max_tokens": 600,

"temperature": 0.1,

"reasoning_enabled": True

}

start = time.time()

r = requests.post(URL, headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}, json=payload, timeout=60)

elapsed = time.time() - start

print("Status:", r.status_code, "Elapsed:", elapsed)

data = r.json()

print(json.dumps(data, indent=2))

CometAPI: Truy cập hoàn toàn miễn phí vào DeepSeek V3.1

Đối với các nhà phát triển muốn truy cập ngay mà không cần đăng ký, CometAPI cung cấp một giải pháp thay thế hấp dẫn cho DeepSeek V3.1 (Tên model: deepseek-v3-1-250821; deepseek-v3.1). Dịch vụ cổng này tổng hợp nhiều mô hình AI thông qua một API thống nhất, cung cấp quyền truy cập vào DeepSeek và mang lại các lợi ích khác, bao gồm tự động chuyển đổi dự phòng, phân tích sử dụng và đơn giản hóa việc thanh toán giữa các nhà cung cấp.

Đầu tiên, hãy tạo một tài khoản CometAPI tại https://www.cometapi.com/—toàn bộ quá trình chỉ mất hai phút và chỉ cần xác minh địa chỉ email. Sau khi đăng nhập, hãy tạo khóa mới trong mục "Khóa API". https://www.cometapi.com/ cung cấp tín dụng miễn phí cho tài khoản mới và giảm giá 20% so với giá API chính thức.

Việc triển khai kỹ thuật chỉ yêu cầu thay đổi mã tối thiểu. Chỉ cần thay đổi điểm cuối API của bạn từ URL DeepSeek trực tiếp sang cổng CometAPI.

Lưu ý: API hỗ trợ phát trực tuyến (

stream: true),max_tokens, nhiệt độ, trình tự dừng và các tính năng gọi hàm tương tự như các API tương thích với OpenAI khác.

Làm thế nào tôi có thể gọi DeepSeek bằng Anthropic SDK?

DeepSeek cung cấp điểm cuối tương thích với Anthropic để bạn có thể sử dụng lại Anthropc SDK hoặc công cụ Claude Code bằng cách trỏ SDK tới https://api.deepseek.com/anthropic và đặt tên mô hình thành deepseek-chat (Hoặc deepseek-reasoner nơi được hỗ trợ).

Gọi mô hình DeepSeek thông qua Anthropic API

Cài đặt Anthropic SDK: pip install anthropic. Cấu hình môi trường của bạn:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

Tạo tin nhắn:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are a helpful assistant.",

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "Hi, how are you?"

}

]

}

]

)

print(message.content)

Sử dụng DeepSeek trong Claude Code

Cài đặt: npm install -g @anthropic-ai/claude-code. Cấu hình môi trường của bạn:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_AUTH_TOKEN=${YOUR_API_KEY}

export ANTHROPIC_MODEL=deepseek-chat

export ANTHROPIC_SMALL_FAST_MODEL=deepseek-chat

Vào Thư mục dự án và thực thi Mã Claude:

cd my-project

claude

Sử dụng DeepSeek trong Claude Code thông qua CometAPI

CometAPI hỗ trợ Claude Code. Sau khi cài đặt, khi cấu hình môi trường, chỉ cần thay thế URL cơ sở bằng https://www.cometapi.com/console/ và khóa bằng Khóa CometAPI để sử dụng mô hình DeepSeek của CometAPI trong Claude Code.

# Navigate to your project folder cd your-project-folder

# Set environment variables (replace sk-... with your actual token)

export ANTHROPIC_AUTH_TOKEN=sk-...

export ANTHROPIC_BASE_URL=https://www.cometapi.com/console/

# Start Claude Code

claude

Ghi chú:

- DeepSeek ánh xạ các tên mô hình Anthropic không được hỗ trợ tới

deepseek-chat. - Lớp tương thích Anthropic hỗ trợ

system,messages,temperature, phát trực tuyến, dừng chuỗi và mảng suy nghĩ.

Những biện pháp thực hành sản xuất cụ thể nào là tốt nhất (bảo mật, chi phí, độ tin cậy)?

Dưới đây là các mô hình sản xuất được đề xuất áp dụng cho DeepSeek hoặc bất kỳ ứng dụng LLM khối lượng lớn nào.

Bí mật và danh tính

- Lưu trữ khóa API trong trình quản lý bí mật (không sử dụng

.env(trong quá trình sản xuất). Xoay vòng khóa thường xuyên và tạo khóa cho từng dịch vụ với ít đặc quyền nhất. - Sử dụng các dự án/tài khoản riêng biệt cho giai đoạn phát triển/dựng thử/sản xuất.

Giới hạn tốc độ và thử lại

- Thực hiện hậu quả theo cấp số nhân trên HTTP 429/5xx có độ trễ. Giới hạn số lần thử lại (ví dụ: 3 lần).

- Sử dụng khóa idempotency cho các yêu cầu có thể được lặp lại.

Ví dụ Python — thử lại với backoff

import time, random, requests

def post_with_retries(url, headers, payload, attempts=3):

for i in range(attempts):

r = requests.post(url, json=payload, headers=headers, timeout=60)

if r.status_code == 200:

return r.json()

if r.status_code in (429, 502, 503, 504):

backoff = (2 ** i) + random.random()

time.sleep(backoff)

continue

r.raise_for_status()

raise RuntimeError("Retries exhausted")

Quản lý chi phí

- Giới Hạn

max_tokensvà tránh vô tình yêu cầu những kết quả đầu ra lớn. - Phản hồi mô hình bộ nhớ đệm khi cần thiết (đặc biệt là đối với các yêu cầu lặp lại). DeepSeek phân biệt rõ ràng giữa truy cập bộ nhớ đệm thành công và không thành công về mặt giá cả — lưu trữ bộ nhớ đệm giúp tiết kiệm chi phí.

- Sử dụng

deepseek-chatcho những câu trả lời nhỏ thường lệ; dự trữdeepseek-reasonerđối với những trường hợp thực sự cần CoT (chi phí cao hơn).

Khả năng quan sát và ghi nhật ký

- Chỉ ghi lại siêu dữ liệu về các yêu cầu ở dạng văn bản thuần túy (hàm băm nhắc nhở, số lượng mã thông báo, độ trễ). Tránh ghi lại toàn bộ dữ liệu người dùng hoặc nội dung nhạy cảm. Lưu trữ ID yêu cầu/phản hồi để hỗ trợ và đối chiếu hóa đơn.

- Theo dõi việc sử dụng mã thông báo theo yêu cầu và đưa ra ngân sách/cảnh báo về chi phí.

Kiểm soát an toàn và ảo giác

- Sử dụng đầu ra công cụ và trình xác thực xác định cho bất kỳ vấn đề quan trọng nào về an toàn (tài chính, pháp lý, y tế).

- Đối với các đầu ra có cấu trúc, hãy sử dụng

response_format+Sơ đồ JSON và xác thực đầu ra trước khi thực hiện các hành động không thể đảo ngược.

Các mẫu triển khai

- Chạy các lệnh gọi mô hình từ một quy trình làm việc chuyên dụng để kiểm soát tính đồng thời và xếp hàng.

- Chuyển giao các công việc nặng cho các tác nhân không đồng bộ (Celery, tác vụ Fargate, tác vụ Cloud Run) và phản hồi cho người dùng bằng chỉ báo tiến trình.

- Đối với nhu cầu về độ trễ/thông lượng cực cao, hãy cân nhắc SLA của nhà cung cấp và liệu có nên tự lưu trữ hay sử dụng trình tăng tốc của nhà cung cấp.

Ghi chú kết thúc

DeepSeek-V3.1 là một mô hình lai thực dụng, được thiết kế cho cả trò chuyện nhanh và các tác vụ phức tạp. API tương thích với OpenAI giúp việc di chuyển trở nên dễ dàng cho nhiều dự án, trong khi các lớp tương thích Anthropic và CometAPI giúp nó linh hoạt với các hệ sinh thái hiện có. Các điểm chuẩn và báo cáo cộng đồng cho thấy sự đánh đổi giữa chi phí/hiệu suất đầy hứa hẹn — nhưng như với bất kỳ mô hình mới nào, hãy kiểm tra nó trên khối lượng công việc thực tế của bạn (nhắc nhở, gọi hàm, kiểm tra an toàn, độ trễ) trước khi triển khai sản xuất hoàn chỉnh.

Trên CometAPI, bạn có thể chạy nó một cách an toàn và tương tác với nó thông qua API tương thích với OpenAI hoặc thân thiện với người dùng sân chơi, không có giới hạn về tỷ lệ.

👉 Triển khai DeepSeek-V3.1 trên CometAPI ngay!

Tại sao nên sử dụng CometAPI?

- Ghép kênh nhà cung cấp: chuyển đổi nhà cung cấp mà không cần viết lại mã.

- Thanh toán/số liệu thống nhất: nếu bạn định tuyến nhiều mô hình thông qua CometAPI, bạn sẽ nhận được một bề mặt tích hợp duy nhất.

- Siêu dữ liệu mô hình: xem độ dài ngữ cảnh và các tham số hoạt động trên mỗi biến thể mô hình.