Google công bố Gemini 3 Flash vào ngày 17–18 tháng 12 năm 2025 như một thành viên có độ trễ thấp, hiệu quả về chi phí trong gia đình Gemini 3. Sản phẩm mang năng lực suy luận cấp độ Pro vào khuôn khổ lớp Flash, hỗ trợ đa phương thức mở rộng (văn bản, hình ảnh, âm thanh, video), giới thiệu các điều khiển thinking_level và độ phân giải media, và có mặt qua Google AI Studio, Gemini API (REST / SDKs), Vertex AI, Gemini CLI, và là mô hình mặc định trong Google Search / ứng dụng Gemini.

Gemini 3 Flash là gì và vì sao quan trọng

Gemini 3 Flash là một phần của dòng mô hình 3-series của Google. Nó được thiết kế để đẩy biên Pareto giữa chất lượng - chi phí - độ trễ: mang lại phần lớn năng lực suy luận của Gemini 3 Pro trong khi nhanh hơn đáng kể và rẻ hơn để vận hành. Sự kết hợp đó khiến nó phù hợp với các kịch bản tương tác tần suất cao (chatbot, trợ lý IDE, luồng agentic thời gian thực), tạo nội dung hàng loạt nơi độ trễ quan trọng, và các ứng dụng cần suy luận đa phương thức (hình ảnh + văn bản + âm thanh) với chi phí thấp.

Các điểm chính ở mức cao:

- Mô hình được tối ưu rõ ràng cho tốc độ + chi phí thấp trong khi vẫn giữ vững khả năng suy luận và độ trung thực đa phương thức (Nhanh gấp ba lần Gemini 2.5 Pro cũ; Giữ các năng lực suy luận hàng đầu của Gemini 3.).

- Được định vị là “điểm cân bằng tối ưu” cho vòng lặp agentic và các quy trình phát triển lặp (ví dụ: hỗ trợ viết mã, agent nhiều lượt).

- Linh hoạt: Mô hình có thể “điều chỉnh thời gian suy nghĩ” theo độ phức tạp của vấn đề—trả lời câu hỏi đơn giản ngay lập tức và cân nhắc nhiều bước hơn cho các tác vụ phức tạp.

Hiệu năng kỹ thuật và kết quả benchmark

Gemini 3 Flash đạt bước đột phá ba mặt về tốc độ, trí tuệ và chi phí:

1) Vòng lặp agentic và hiểu đa phương thức

Gemini 3 Flash thừa hưởng các cải tiến kiến trúc và huấn luyện từ gia đình Gemini 3 rộng hơn, tạo ra năng lực đa phương thức mạnh (đầu vào văn bản, hình ảnh, video, âm thanh) và suy luận cải thiện so với các mẫu Flash trước đó. Google định vị Flash có thể xử lý các tác vụ như phân tích tài liệu (OCR + suy luận), tóm tắt video, Hỏi & Đáp hình ảnh-kèm-văn bản, và các tác vụ mã hóa đa phương thức. Khả năng đa phương thức này, kết hợp với độ trễ thấp, là một trong những điểm bán kỹ thuật nổi bật của mô hình.

Google công bố tuyên bố benchmark nội bộ cho thấy hiệu năng mã hóa agentic mạnh (SWE-bench Verified ~78% cho các luồng mã hóa agentic) và Flash tiến gần suy luận cấp Pro trên nhiều tác vụ trong khi vẫn đủ nhanh cho vòng lặp agentic và các quy trình gần thời gian thực.

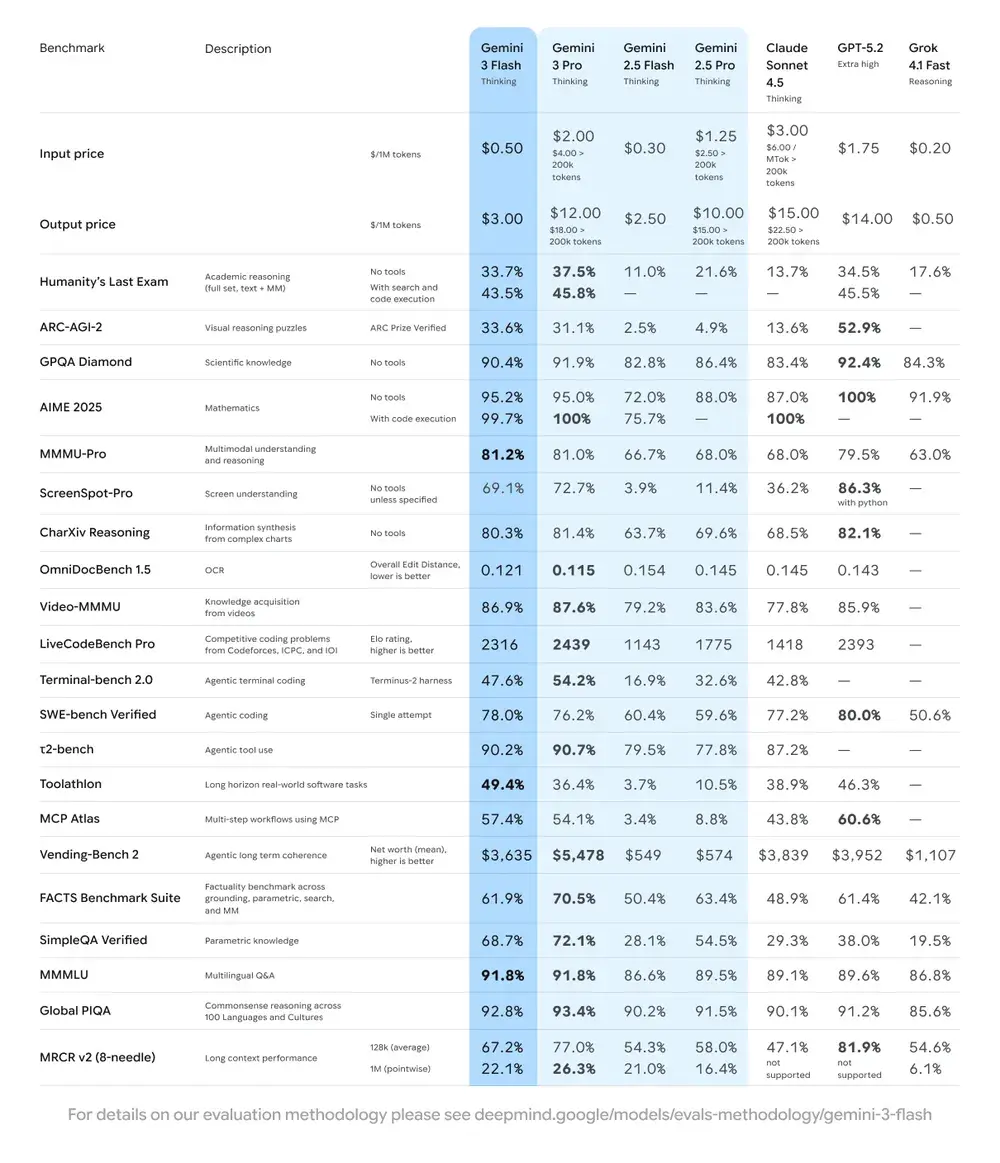

| Benchmark | Điểm Gemini 3 Flash | Mô hình so sánh | Cải thiện |

|---|---|---|---|

| GPQA Diamond (Suy luận trình độ Tiến sĩ) | 90.4% | Vượt Gemini 2.5 Pro | Đáng kể |

| Humanity’s Last Exam (Bài kiểm tra kiến thức) | 33.7% (không công cụ) | Gần với Gemini 3 Pro | Suy luận nâng cao |

| MMMU Pro (Hiểu đa phương thức) | 81.2% | Tương đương Gemini 3 Pro | — |

| SWE-bench Verified (Benchmark năng lực mã hóa) | 78% | Cao hơn Gemini 3 Pro và dòng 2.5 | Xuất sắc |

2) Chi phí và hiệu suất

Triết lý phát triển của Gemini 3 Flash là “Biên Pareto”: tức là tìm điểm cân bằng tối ưu giữa tốc độ, chất lượng và chi phí. Gemini 3 Flash được tối ưu rõ ràng cho tỷ lệ giá-hiệu năng. Google liệt kê giá của Flash thấp hơn đáng kể so với Pro cho các tác vụ tương đương, và định vị nó để xử lý khối lượng lớn yêu cầu với chi phí vận hành thấp hơn. Với nhiều khối lượng công việc, biến thể Flash được dự định là mặc định tiết kiệm chi phí — ví dụ, giá preview Flash khoảng $0.50 cho mỗi 1M token đầu vào và $3.00 cho mỗi 1M token đầu ra cho tầng preview Flash. Trên thực tế, điều đó khiến nó khả thi cho các tác vụ tần suất cao nơi mức phí theo token của Pro sẽ là rào cản.

Chỉ số hiệu suất

- Tốc độ: Nhanh gấp 3 lần Gemini 2.5 Pro (dựa trên kiểm thử của Artificial Analysis).

- Hiệu quả token: Sử dụng trung bình ít hơn 30% token để hoàn thành cùng tác vụ. Nói cách khác, bạn nhận được kết quả nhanh hơn, tốt hơn với cùng số tiền.

- Gemini 3 Flash có "Dynamic Thinking Mode"—thích ứng độ sâu suy luận với độ phức tạp của tác vụ, “suy nghĩ nhiều hơn một chút” khi cần, và phản hồi nhanh cho tác vụ đơn giản.

Hệ quả thực tiễn: Chi phí theo token hoặc theo lần gọi thấp hơn nghĩa là bạn có thể chạy nhiều truy vấn hơn, ngữ cảnh dài hơn, hoặc tần suất lấy mẫu cao hơn với cùng ngân sách. Cải thiện hiệu suất cũng có thể giảm độ phức tạp hạ tầng (cần ít phiên nóng hơn) và cải thiện đảm bảo thời gian phản hồi.

3) Benchmark hiệu năng

Gemini 3 Flash đạt hiệu năng “đẳng cấp frontier” trên một số benchmark học thuật và ứng dụng trong khi cung cấp độ trễ và chi phí tốt hơn so với các mẫu Pro trước đó. Google đưa ra các con số như điểm cao trên các benchmark suy luận và kiến thức phức tạp (ví dụ, các biến thể GPQA) để minh họa năng lực của nó.

Tôi sử dụng API Gemini 3 Flash như thế nào?

Tôi nên dùng phương thức truy cập nào?

- Khuyến nghị (đơn giản + ổn định): Dùng mẫu tích hợp SDK mà Comet cung cấp — chỉ cần trỏ SDK GenAI hiện có tới base URL của Comet và cung cấp API key Comet của bạn. Cách này tránh phải tự xử lý phân tích yêu cầu/luồng phản hồi.

- Tùy chọn (HTTP thô / curl / stack tùy chỉnh): Bạn có thể POST trực tiếp tới các endpoint của CometAPI (Comet chấp nhận dạng OpenAI-style hoặc theo nhà cung cấp). Dùng

Authorization: Bearer <sk-...>(ví dụ của Comet dùng header Bearer) và chuỗi modelgemini-3-flashtrong body. Xác nhận chính xác đường dẫn và tham số truy vấn trong tài liệu API của Comet cho mô hình bạn muốn.

Tóm tắt nhanh — bạn sẽ làm gì

- Đăng ký trên CometAPI và tạo token API.

- Chọn phương thức truy cập (khuyến nghị: mẫu wrapper SDK như dưới; phương án dự phòng: HTTP/cURL thô).

- Gọi mô hình

gemini-3-flashqua base URL của CometAPI (Comet định tuyến yêu cầu của bạn tới backend Gemini của Google). - Xử lý streaming / gọi hàm / đầu vào đa phương thức theo yêu cầu của mô hình (chi tiết bên dưới).

from google import genaiimport os# Get your CometAPI key from https://api.cometapi.com/console/token, and paste it hereCOMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="Explain how AI works in a few words",)print(response.text)

Tham số yêu cầu cần cân nhắc

thinking_level— điều khiển độ sâu suy luận nội bộ:MINIMAL,LOW,MEDIUM,HIGH. DùngMINIMALcho độ trễ và chi phí thấp nhất khi bạn không cần suy luận nhiều bước sâu.media_resolution— cho đầu vào thị giác/video:low,medium,high,ultra_high. Độ phân giải thấp giảm tương đương token và độ trễ.streamGenerateContentvsgenerateContent— dùng streaming để cải thiện độ trễ cảm nhận khi bạn muốn nhận trả lời từng phần ngay khi có.- Function calling / JSON Mode — dùng đầu ra có cấu trúc khi bạn cần kết quả có thể máy phân tích.

Gửi đầu vào đa phương thức (gợi ý thực tiễn)

- Hình ảnh/PDF: ưu tiên URI Cloud Storage (gs://) cho media lớn; nhiều API chấp nhận base64 cho ảnh nhỏ. Chú ý cách tính token theo phương thức — PDF có thể được tính vào hạn mức hình ảnh/tài liệu tùy endpoint.

- Video/âm thanh: với clip ngắn bạn có thể truyền URI; với media dài dùng quy trình xử lý theo lô hoặc stream từng phần. Kiểm tra kích thước đầu vào tối đa và ràng buộc mã hóa trong tài liệu API.

- Gọi hàm / công cụ: dùng schema hàm có cấu trúc để nhận đầu ra JSON và bật gọi công cụ an toàn. Gemini 3 Flash hỗ trợ streaming khi gọi hàm để cải thiện UX.

Tôi có thể truy cập Gemini 3 Flash ở đâu?

Gemini 3 Flash có mặt trên các bề mặt cho người dùng và nhà phát triển của Google:

- Google Search và ứng dụng Gemini — Flash đã được triển khai làm mô hình mặc định cho AI Mode trong Search và tích hợp vào trải nghiệm ứng dụng Gemini cho người dùng cuối.

- Google AI Studio — nơi trực tiếp để nhà phát triển thử nghiệm và tạo API key cho việc thử.

- Gemini API (Generative Language / AI Developer API) — có sẵn dưới ID

gemini-3-flash-preview(ID mô hình dùng trong tài liệu/ghi chú phát hành) và qua các endpoint generateContent / streamGenerateContent tiêu chuẩn. - Vertex AI (Google Cloud) — truy cập cấp sản xuất qua các API mô hình Generative AI của Vertex AI với giá/ hạn mức phù hợp khối lượng công việc doanh nghiệp.

- Gemini CLI — cho phát triển dựa trên terminal và quy trình scripting.

Cổng bên thứ ba CometAPI

CometAPI đã bổ sung gemini-3-flash vào danh mục, và trang mô hình của họ giải thích cách gọi qua endpoint hợp nhất của CometAPI. API mô hình cung cấp mức giá bằng 20% giá chính thức.

Thực tiễn tốt nhất khi dùng Gemini 3 Flash là gì?

1) Chọn thinking_level theo tác vụ và tinh chỉnh

- Đặt

MINIMAL/LOWcho Hỏi & Đáp đơn giản và tác vụ tương tác tần suất cao. - Dùng

MEDIUM/HIGHcó chọn lọc cho các tác vụ cần chuỗi suy luận sâu hoặc lập kế hoạch nhiều bước. - Đo đạc chi phí vs chất lượng khi thay đổi

thinking_level. Tài liệu của Google cảnh báo rằngthinking_levelthay đổi dấu hiệu suy nghĩ nội bộ và độ trễ.

2) Sử dụng media_resolution để kiểm soát tính toán thị giác

Nếu bạn truyền hình ảnh hoặc video, chọn media_resolution thấp nhất chấp nhận được cho tác vụ; ví dụ, dùng low cho thumbnail và trích xuất hàng loạt, high cho phê bình thiết kế thị giác. Điều này giảm tương đương token cho hình ảnh và giảm độ trễ.

3) Ưu tiên đầu ra có cấu trúc cho tự động hóa

Dùng Chế độ JSON / gọi hàm khi ứng dụng của bạn cần đầu ra có thể máy phân tích (ví dụ, trích xuất thực thể, gọi công cụ). Điều này đơn giản hóa đáng kể xử lý hạ nguồn. Áp dụng schema JSON nghiêm ngặt nếu có thể và xác thực ở phía client.

4) Tận dụng streaming cho phản hồi dài

streamGenerateContent giảm độ trễ cảm nhận và cho phép UI hiển thị tiến độ dần. Với tác vụ đa phương thức dài, stream đầu ra từng phần để người dùng thấy tiến trình ngay lập tức.

5) Kiểm soát chi phí với bộ nhớ đệm và quản lý ngữ cảnh

- Dùng bộ nhớ đệm ngữ cảnh cho các tham chiếu lặp lại (giá và token khác nhau giữa các mô hình).

- Tránh gửi ngữ cảnh dài không cần thiết — ưu tiên prompt súc tích và dùng truy xuất + grounding cho kho tri thức lớn.

Kịch bản sử dụng điển hình cho Gemini 3 Flash

Tác nhân hội thoại khối lượng lớn

Flash phù hợp tự nhiên cho chatbot và trợ lý hỗ trợ khách hàng cần độ trễ thấp và chi phí thấp cho mỗi suy luận. Với hỗ trợ streaming và tốc độ token cao, Flash giảm thời gian chờ cảm nhận và chi phí vận hành.

Trợ lý đa phương thức và pipeline tài liệu

Vì Flash xử lý tốt hình ảnh, PDF và video ngắn, các ứng dụng phổ biến gồm trích xuất hóa đơn, Hỏi & Đáp đa phương thức trên sách hướng dẫn, hỗ trợ khách hàng với hình ảnh, và nạp PDF cho kho tri thức.

Phân tích video thời gian thực và kiểm duyệt

Tốc độ đầu ra báo cáo cao (≈218 t/s trong thử nghiệm tiền phát hành) cho phép phân tích và tóm tắt video ngắn gần thời gian thực, phát hiện điểm nổi bật, và pipeline kiểm duyệt nội dung trực tiếp khi kiến trúc phù hợp.

Công cụ nhà phát triển agentic và trợ lý viết mã

Điểm số SWE-bench và hiệu năng mã hóa được báo cáo khiến Flash là lựa chọn tốt cho trợ lý viết mã nhanh, trợ lý CLI, và các quy trình nhà phát triển khác ưu tiên độ trễ thấp.

Kết luận — bạn có nên áp dụng Gemini 3 Flash ngay bây giờ?

Gemini 3 Flash là một sản phẩm mang tính chiến lược cho các nhóm cần suy luận mạnh và trí tuệ đa phương thức nhưng không muốn độ trễ và chi phí của các mô hình Pro cao cấp. Mô hình đặc biệt phù hợp với trợ lý mã hóa agentic, agent đa phương thức tương tác, pipeline xử lý tài liệu, và bất kỳ hệ thống nào mà độ trễ thấp và quy mô là mối quan tâm chính. Các benchmark ban đầu (từ Google và phân tích độc lập) cho thấy Flash có chất lượng cạnh tranh đồng thời cung cấp lợi thế đáng kể về thông lượng và chi phí.

Bắt đầu bằng cách khám phá khả năng của Gemini 3 Flash trong Playground và tham khảo Hướng dẫn API để biết chỉ dẫn chi tiết. Trước khi truy cập, hãy đảm bảo bạn đã đăng nhập vào CometAPI và lấy API key. CometAPI cung cấp mức giá thấp hơn nhiều so với giá chính thức để giúp bạn tích hợp.

Sẵn sàng bắt đầu?→ Dùng thử miễn phí Gemini 3 Flash !