GPT-5.2 API là gì

GPT-5.2 API giống với GPT-5.2 Thinking trong ChatGPT. GPT-5.2 Thinking là phiên bản tầm trung của họ GPT-5.2 của OpenAI, được thiết kế cho công việc chuyên sâu: lập luận nhiều bước, tóm tắt tài liệu dài, tạo mã chất lượng cao và công việc tri thức chuyên nghiệp, nơi độ chính xác và cấu trúc dễ sử dụng quan trọng hơn thông lượng thuần. Trong API, biến thể này được cung cấp dưới dạng model gpt-5.2 (Responses API / Chat Completions), và nằm giữa biến thể Instant có độ trễ thấp và biến thể Pro chất lượng cao nhưng đắt hơn.

Tính năng chính

- Ngữ cảnh rất dài & tinh gọn: cửa sổ ngữ cảnh hiệu dụng 400K và các công cụ tinh gọn để quản lý mức độ liên quan trong các cuộc hội thoại và tài liệu dài.

- Cấu hình mức nỗ lực lập luận:

none | medium | high | xhigh(xhigh kích hoạt tính toán nội bộ tối đa cho lập luận khó).xhighđược cung cấp cho các biến thể Thinking/Pro. - Hỗ trợ công cụ và hàm mạnh hơn: gọi công cụ cấp một, ngữ pháp (CFG/Lark) để ràng buộc đầu ra có cấu trúc, và hành vi tác tử được cải thiện giúp đơn giản hóa tự động hóa nhiều bước phức tạp.

- Hiểu đa phương thức: khả năng hiểu hình ảnh + văn bản phong phú hơn và tích hợp vào các tác vụ nhiều bước.

- Cải thiện an toàn / xử lý nội dung nhạy cảm: can thiệp có mục tiêu để giảm phản hồi không mong muốn trong các lĩnh vực như tự gây hại và các bối cảnh nhạy cảm khác.

Khả năng kỹ thuật & thông số (góc nhìn nhà phát triển)

- Điểm cuối API & ID model:

gpt-5.2cho Thinking (Responses API),gpt-5.2-chat-latestcho luồng công việc chat/instant, vàgpt-5.2-procho tầng Pro; có sẵn qua Responses API và Chat Completions ở nơi được chỉ định. - Token lập luận & quản lý mức nỗ lực: API hỗ trợ tham số rõ ràng để phân bổ tính toán (mức nỗ lực lập luận) cho mỗi yêu cầu; mức nỗ lực cao hơn tăng độ trễ và chi phí nhưng cải thiện chất lượng đầu ra cho các tác vụ phức tạp.

- Công cụ đầu ra có cấu trúc: hỗ trợ ngữ pháp (Lark / CFG) để ràng buộc đầu ra của model theo DSL hoặc cú pháp chính xác (hữu ích cho SQL, JSON, tạo DSL).

- Gọi công cụ song song & điều phối tác tử: khả năng song song cải thiện và điều phối công cụ gọn gàng hơn giúp giảm nhu cầu về lời nhắc hệ thống phức tạp và giàn giáo đa tác tử.

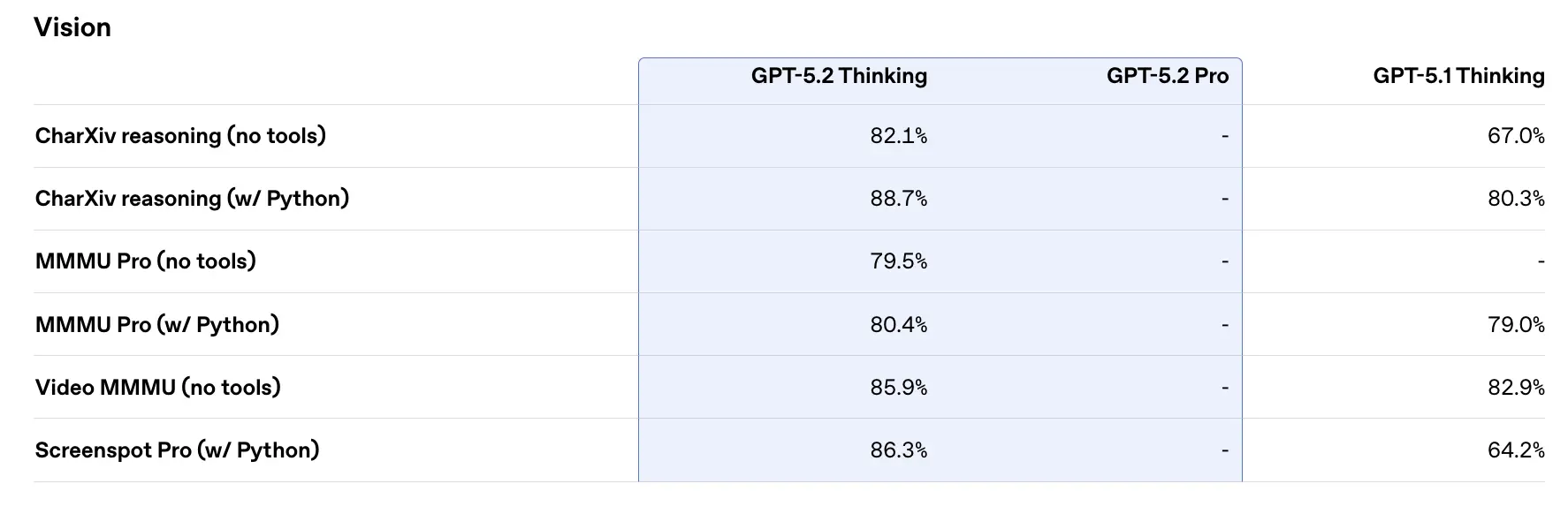

Hiệu năng benchmark & dữ liệu hỗ trợ

OpenAI đã công bố nhiều kết quả benchmark nội bộ và bên ngoài cho GPT-5.2. Một số điểm nổi bật (theo số liệu do OpenAI báo cáo):

- GDPval (44 nghề, công việc tri thức) — GPT-5.2 Thinking “vượt hoặc ngang bằng các chuyên gia hàng đầu trong ngành ở 70.9% phép so sánh”; OpenAI báo cáo rằng đầu ra được tạo ra với >11× tốc độ và <1% chi phí so với các chuyên gia trên các tác vụ GDPval của họ (ước tính tốc độ và chi phí dựa trên dữ liệu lịch sử). Những tác vụ này bao gồm mô hình bảng tính, bản thuyết trình và video ngắn.

- SWE-Bench Pro (coding) — GPT-5.2 Thinking đạt ≈55.6% trên SWE-Bench Pro và ~80% trên SWE-Bench Verified (chỉ Python) theo OpenAI, thiết lập một chuẩn mới cho đánh giá tạo mã/kỹ thuật trong các bài thử của họ. Theo ví dụ của OpenAI, điều này chuyển hóa thành gỡ lỗi đáng tin cậy hơn và sửa lỗi đầu-cuối trong thực tế.

- GPQA Diamond (hỏi đáp khoa học trình độ sau đại học) — GPT-5.2 Pro: 93.2%, GPT-5.2 Thinking: 92.4% trên GPQA Diamond (không dùng công cụ, lập luận tối đa).

- ARC-AGI series — Trên ARC-AGI-2 (benchmark lập luận linh hoạt khó hơn), GPT-5.2 Thinking đạt 52.9% và GPT-5.2 Pro 54.2% (OpenAI cho biết đây là các mốc đẳng cấp hàng đầu mới cho mô hình phong cách chuỗi suy nghĩ).

- Ngữ cảnh dài (OpenAI MRCRv2) — GPT-5.2 Thinking cho thấy độ chính xác gần 100% trên biến thể MRCR 4-needle đến 256k token và cải thiện đáng kể so với GPT-5.1 trong các thiết lập ngữ cảnh dài. (OpenAI đã công bố biểu đồ và bảng MRCRv2.)

So sánh với các đối thủ cùng thời

- so với Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro được quảng bá với ~1,048,576 (≈1M) token cửa sổ ngữ cảnh và đầu vào đa phương thức rộng (văn bản, hình ảnh, âm thanh, video, PDF) cùng tích hợp tác tử mạnh qua Vertex AI / AI Studio. Trên lý thuyết, cửa sổ ngữ cảnh lớn hơn của Gemini 3 là điểm khác biệt cho khối lượng công việc phiên đơn cực lớn; đánh đổi bao gồm bề mặt công cụ và mức độ phù hợp hệ sinh thái.

- so với Anthropic Claude Opus 4.5: Opus 4.5 nhấn mạnh luồng công việc mã hóa/tác tử cho doanh nghiệp và báo cáo kết quả SWE-bench mạnh cùng độ bền vững cho các phiên tác tử dài; Anthropic định vị Opus cho tự động hóa và tạo mã với cửa sổ ngữ cảnh 200k và tích hợp tác tử/Excel chuyên biệt. Opus 4.5 là đối thủ mạnh trong tự động hóa doanh nghiệp và tác vụ mã.

Kết luận thực tiễn: GPT-5.2 hướng tới một tập cải tiến cân bằng (ngữ cảnh 400k, đầu ra token lớn, lập luận/mã hóa được cải thiện). Gemini 3 nhắm tới ngữ cảnh phiên đơn lớn nhất (≈1M), trong khi Claude Opus tập trung vào kỹ thuật doanh nghiệp và độ bền tác tử. Hãy lựa chọn theo kích thước ngữ cảnh, nhu cầu đa phương thức, mức độ phù hợp tính năng/công cụ, và cân bằng chi phí/độ trễ.

Cách truy cập và sử dụng GPT-5.2 API

Bước 1: Đăng ký API Key

Đăng nhập vào cometapi.com. Nếu bạn chưa là người dùng của chúng tôi, vui lòng đăng ký trước. Đăng nhập vào CometAPI console. Lấy API key thông tin truy cập của giao diện. Nhấp “Add Token” tại mục API token trong trung tâm cá nhân, lấy khóa token: sk-xxxxx và gửi.

Bước 2: Gửi yêu cầu đến GPT-5.2 API

Chọn điểm cuối “gpt-5.2” để gửi yêu cầu API và thiết lập thân yêu cầu. Phương thức và thân yêu cầu được lấy từ tài liệu API trên trang web của chúng tôi. Trang web cũng cung cấp kiểm thử Apifox để thuận tiện cho bạn. Thay thế <YOUR_API_KEY> bằng CometAPI key thực tế từ tài khoản của bạn. Developers gọi các endpoint này qua Responses API / Chat.

Chèn câu hỏi hoặc yêu cầu của bạn vào trường content — đây là nội dung mà mô hình sẽ phản hồi. Xử lý phản hồi API để nhận câu trả lời được tạo ra.

Bước 3: Truy xuất và xác minh kết quả

Xử lý phản hồi API để nhận câu trả lời được tạo. Sau khi xử lý, API phản hồi với trạng thái tác vụ và dữ liệu đầu ra.

Xem thêm Gemini 3 Pro API xem trước