在 2025 年 7 月,Alibaba 发布了 Qwen3-Coder,这是其迄今为止最先进的开源 AI 模型,专为复杂的编码工作流与代理式编程任务而设计。本专业指南将一步步带你全面了解——从其核心能力与关键创新,到安装和使用随附的 Qwen Code CLI 工具以进行自动化、代理式编码。在此过程中,你还将学习最佳实践、故障排除技巧,以及如何优化提示与资源分配,以最大化 Qwen3-Coder 的效用。

什么是 Qwen3‑Coder,它为何重要?

Alibaba 的 Qwen3‑Coder 是一个 480 billion 参数的 Mixture‑of‑Experts(MoE)模型,具有 35 billion 活跃参数,面向大型上下文的编码任务——可原生处理 256 K tokens(通过外推方法可达 1 M)。它于 2025 年 7 月 23 日发布,代表了“代理式 AI 编码”的重大飞跃:模型不仅能生成代码,还能在无人干预的情况下自主规划、调试,并对复杂的编程挑战进行迭代。

Qwen3‑Coder 与前代相比有何不同?

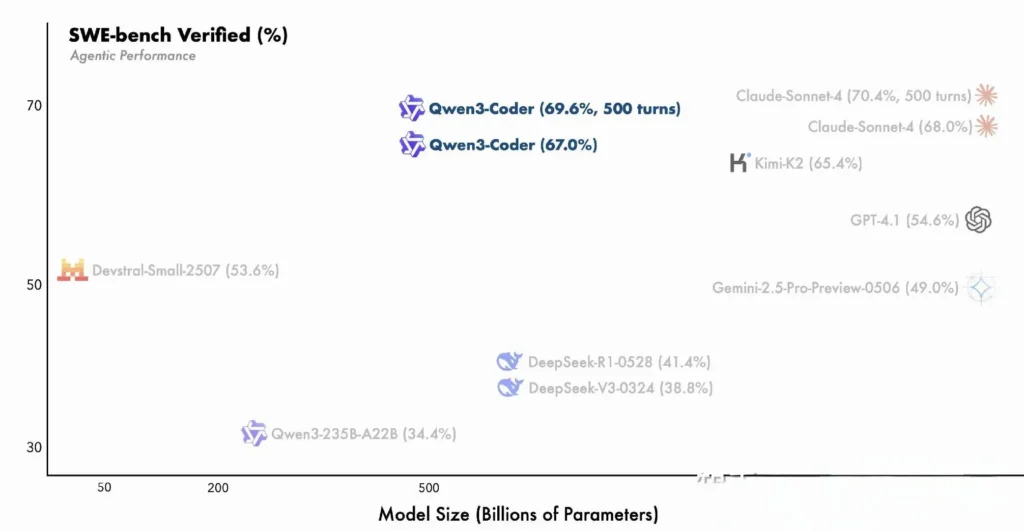

Qwen3‑Coder 构建于 Qwen3 系列的创新之上——将用于多步推理的“思考模式”和用于快速响应的“非思考模式”融合为统一框架,并可根据任务复杂度动态切换模式。与稠密、上下文更小的 Qwen2.5‑Coder 不同,Qwen3‑Coder 采用稀疏的 Mixture‑of‑Experts 架构,在 SWE‑Bench Verified 和 CodeForces ELO 等基准上实现最先进的性能,在关键编码指标上可与 Anthropic 的 Claude 和 OpenAI 的 GPT‑4 等模型相匹敌甚至更优。

Qwen3‑Coder 的关键特性:

- Massive Context Window:原生 256 K tokens,通过外推可达 1 M,使其能一次性处理整个代码库或长文档

- Agentic Capabilities:专用的“代理模式”,可自主规划、生成、测试与调试代码,减少人工工程开销

- High Throughput & Efficiency:Mixture‑of‑Experts 设计每次推理仅激活 35 billion 参数,在性能与计算成本之间取得平衡

- Open‑Source & Extensible:基于 Apache 2.0 发布,具有完整的 API 文档,社区驱动的增强在 GitHub 上可用

- Multi‑Language & Cross‑Domain:在 7.5 trillion tokens(70% code)上训练,覆盖数十种编程语言,从 Python、JavaScript 到 Go 和 Rust

开发者如何开始使用 Qwen3‑Coder?

在哪里下载和安装 Qwen3‑Coder?

你可以从以下渠道获取模型权重与 Docker 镜像:

- GitHub: https://github.com/QwenLM/Qwen3-Coder

- Hugging Face: https://huggingface.co/QwenLM/Qwen3-Coder-480B-A35B-Instruct

- ModelScope: 阿里巴巴官方仓库

只需克隆仓库并拉取预构建的 Docker 容器:

git clone https://github.com/QwenLM/Qwen3-Coder.git

cd Qwen3-Coder

docker pull qwenlm/qwen3-coder:latest

使用 Transformers 加载模型

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-Coder-480B-A35B-Instruct"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

上述代码初始化模型与分词器,并自动将层分布到可用的 GPU 上。

如何配置环境?

- Hardware Requirements:

- NVIDIA GPU,≥ 48 GB VRAM(推荐 A100 80 GB)

- 128–256 GB 系统内存

-

Dependencies:

pip install -r requirements.txt # PyTorch, CUDA, tokenizers, etc. -

API Keys(可选):

用于云端推理时,将你的ALIYUN_ACCESS_KEY和ALIYUN_SECRET_KEY设置为环境变量。

如何使用 Qwen Code 进行代理式编码?

以下是通过 Qwen Code CLI(命令为 qwen)快速上手使用 Qwen3‑Coder 的分步指南:

1. Prerequisites

- Node.js 20+(你可以通过官方安装程序或使用下方脚本安装)

- npm(随 Node.js 一同提供)

# (Linux/macOS)

curl -qL https://www.npmjs.com/install.sh | sh

2. 安装 Qwen Code CLI

npm install -g @qwen-code/qwen-code

Alternatively,从源码安装:

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code

npm install

npm install -g

3. 配置环境

Qwen Code 在底层使用 OpenAI‑compatible 的 API 接口。请设置以下环境变量:

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

OPENAI_MODEL 可设置为以下之一:

qwen3-coder-plus(别名指向 Qwen3‑Coder-480B-A35B-Instruct)- 或你已部署的其他 Qwen3‑Coder 变体

4. 基本用法

- 启动交互式编码 REPL:

qwen

这将进入由 Qwen3‑Coder 驱动的代理式编码会话。

- Shell 中的一次性提示,用于请求代码片段或完成函数:

qwen code complete \

--model qwen3-coder-plus \

--prompt "Write a Python function that reverses a linked list."

- 基于文件的代码补全,自动填充或重构现有文件:

qwen code file-complete \

--model qwen3-coder-plus \

--file ./src/utils.js

- 聊天式交互,在“chat”模式下使用 Qwen,适合多轮编码对话:

qwen chat \

--model qwen3-coder-plus \

--system "You are a helpful coding assistant." \

--user "Generate a REST API endpoint in Express.js for user authentication."

如何通过 CometAPI API 调用 Qwen3‑Coder?

CometAPI 是一个统一的 API 平台,将超过 500 个来自领先供应商的 AI 模型(如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等)聚合到一个对开发者友好的接口中。通过提供一致的认证、请求格式与响应处理,CometAPI 大幅简化了将 AI 能力集成到应用中的过程。无论你在构建聊天机器人、图像生成器、音乐创作工具还是数据驱动的分析管线,CometAPI 都能让你更快迭代、控制成本并保持供应商无关性,同时利用 AI 生态的最新突破。

如果你是 cometAPI 用户,可以登录 cometapi 获取 key 和 base url,参见 Qwen3-Coder API。开始时可在 Playground 探索模型能力,并参考 API guide 获取详细说明。

通过 CometAPI 调用 Qwen3‑Coder 时,使用与其他模型相同的 OpenAI‑compatible 端点——只需将客户端指向 CometAPI 的 base URL,使用你的 CometAPI key 作为 Bearer token,并指定 qwen3-coder-plus 或 qwen3-coder-480b-a35b-instruct 模型。

1. Prerequisites

- 在 https://cometapi.com 注册,并在仪表盘中添加/生成 API token

- 记录你的 API key(以

sk-…开头) - 熟悉 OpenAI Chat API 协议(roles + messages)

2. Base URL 与认证

Base URL:

arduinohttps://api.cometapi.com/v1

Endpoint:

bashPOST https://api.cometapi.com/v1/chat/completions

3. cURL / REST 示例

curl https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer sk-xxxxxxxxxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "qwen3-coder-plus",

"messages": [

{ "role": "system", "content": "You are a helpful coder." },

{ "role": "user", "content": "Generate a SQL query to find duplicate emails." }

],

"temperature": 0.7,

"max_tokens": 512

}'

- Response:返回的 JSON 中

choices.message.content包含生成的代码。

如何利用 Qwen3‑Coder 的代理式能力?

Qwen3‑Coder 的代理式特性支持动态工具调用与自主的多步工作流,使模型能在生成代码的过程中调用外部函数或 API。

工具调用与自定义工具

在你的代码库中定义自定义工具(如 linter、测试运行器或格式化器),并通过函数 schema 暴露给模型。例如:

tools = [

{"name":"run_tests","description":"Execute the test suite and return results","parameters":{}},

{"name":"format_code","description":"Apply black formatter to the code","parameters":{}}

]

response = client.chat.completions.create(

messages=,

functions=tools,

function_call="auto"

)

随后,Qwen3‑Coder 可在一次会话中自主生成、格式化并验证代码,从而降低人工集成开销()。

使用 Qwen Code CLI

qwen-code 命令行工具提供用于代理式编码的交互式 REPL:

qwen-code --model qwen3-coder-480b-a35b-instruct

> generate: "Create a REST API in Node.js with JWT authentication."

> tool: install_package(express)

> tool: create_file(app.js)

> tool: run_tests

该 CLI 可编排复杂工作流并提供透明日志,非常适合探索性原型开发或集成到 CI/CD 流水线。

Qwen3‑Coder 是否适合大型代码库?

得益于扩展的上下文窗口,Qwen3‑Coder 能摄取整个仓库——多达数十万行代码——并在生成补丁或重构前进行分析。这使其能够进行全局重构、跨模块分析与架构建议,而小上下文模型难以胜任。

最大化 Qwen3‑Coder 价值的最佳实践是什么?

要高效采用 Qwen3‑Coder,需要在配置与 CI/CD 集成上进行审慎规划。

如何调优采样与 beam 设置?

- Temperature:0.6–0.8 以平衡创造性;在确定性重构任务中降低至 0.2–0.4

- Top‑p:0.7–0.9,聚焦高概率延续,同时允许偶发新颖建议

- Top‑k:标准使用建议 20–50;当需要高度聚焦的输出时降至 5–10

- Repetition Penalty:1.05–1.1,抑制模型重复样板化模式

结合项目对结果可变性的容忍度调整这些参数,可显著提升生产效率。

有效使用 Qwen3‑Coder 的最佳实践是什么?

面向代码质量的提示工程

- Be Specific:在提示中明确语言、风格规范与期望复杂度

- Iterative Refinement:利用模型的代理式能力对生成代码进行迭代调试与优化

- Temperature Tuning:在生产场景中将生成温度调低(如

temperature=0.2)以获得更确定性的输出

管理资源使用

- Model Variants:原型阶段先用更小的 Qwen3‑Coder 变体,按需再扩容

- Dynamic Quantization:尝试 FP8 与 GGUF 量化检查点,在不显著性能下降的前提下降低 GPU 内存占用

- Asynchronous Generation:将耗时较长的代码生成任务卸载到后台工作者,以保持响应性

遵循上述指南,你将能在软件开发生命周期中最大化集成 Qwen3‑Coder 的投资回报率。

通过理解其架构,安装与配置模型和 Qwen Code CLI,并运用最佳实践,你将能够充分发挥 Qwen3‑Coder 的潜力——从简单代码片段到完全自主的编程代理。