Zhipu 的 GLM‑4.5 API 是部署于 Z.ai(全球)与 Zhipu AI Open(中国大陆)平台上的统一 RESTful 服务,提供对 355 billion 参数、混合专家的 GLM‑4.5 模型的访问——该模型具备复杂推理、编码与代理型任务能力,并支持可配置选项(如 temperature、max tokens、streaming)。

基本功能

GLM‑4.5 设计为一个统一的代理型模型,在单一架构内整合了推理、编码与自主决策能力。它原生支持两种运行模式——思考用于复杂推理与工具使用,以及非思考用于快速、按需响应——非常适合多样化的代理工作流。

技术细节

- 参数规模:旗舰 GLM‑4.5 拥有 355 billion 总参数,32 billion 活跃参数。

- 混合推理:GLM‑4.5 采用混合 FP8 量化策略,以优化推理效率,同时不显著牺牲准确性。

- 参数效率:从 355 B 中使用 32 B 活跃参数,在推理过程中尽量降低硬件负载。

- 层级优化:对组件进行裁剪并重新分配到更深层,在不显著增大模型规模的情况下提升逻辑推理能力。

训练流程

多阶段训练:

- 基础预训练,约 ~15 trillion tokens。

- 推理微调,在 >7 trillion 精选 tokens 上进行,以强化决策与代码合成能力。

基准表现

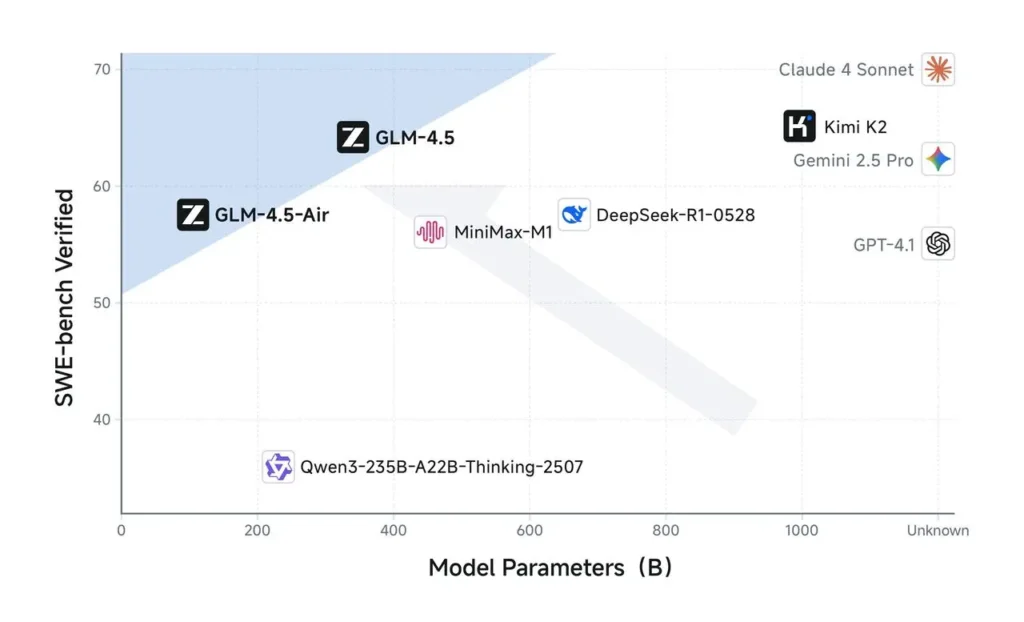

在涵盖代理型、推理与编码任务的12 项行业标准基准测试中,GLM‑4.5 取得总体得分 63.2,全球排名第三,位列 GPT‑4 与 Grok 4 等商业巨头之后。亮点包括:

| 基准 | GLM‑4.5 得分 | 顶级商业模型对比 |

|---|---|---|

| BrowseComp (web) | 26.4 % | Claude 4 Opus: 18.8 % |

| MATH 500 | 98.2 % | GPT‑4 Turbo |

| AIME24 | 91.0 % | Claude 4 Sonnet |

| GPQA | 79.1 % | Gemini 2.5 Pro |

在 12 项竞赛测试——涵盖编码、推理与代理型基准——中,GLM‑4.5 总体排名第三,并在 SWE‑bench 与 AIME24 等任务上与 Claude 4 Sonnet、Gemini 2.5 Pro 等领先商业模型持平或超越。

模型版本

GLM‑4.5 家族包含多个可通过 API 访问的专用变体:

- GLM‑4.5(355 B 总参数;32 B 活跃)

- GLM‑4.5‑Air(106 B 总参数;轻量、推理更快)

- GLM‑4.5‑X、GLM‑4.5‑AirX(超高速推理)

- GLM‑4.5‑Flash(免费,针对编码与推理优化)

如何通过 GLM‑4.5 API(CometAPI)

GLM‑4.5 系列 API 定价(CometAPI),较官方价优惠 20%:

| Model | introduce | Price |

glm-4.5 | 我们最强大的推理模型,拥有 355 billion 参数 | 输入 Tokens $0.48 输出 Tokens $1.92 |

glm-4.5-air | 高性价比 轻量级 强性能 | 输入 Tokens $0.16 输出 Tokens $1.07 |

glm-4.5-x | 高性能 强推理 超高速响应 | 输入 Tokens $1.60 输出 Tokens $6.40 |

glm-4.5-airx | 轻量级 强性能 超高速响应 | 输入 Tokens $0.02 输出 Tokens $0.06 |

glm-4.5-flash | 强性能 卓越适用于推理、编码与代理 | 输入 Tokens $3.20 输出 Tokens $12.80 |

必要步骤

- 登录 cometapi.com。若尚未成为我们的用户,请先注册

- 获取接口访问凭证 API key。在个人中心的 API token 处点击“Add Token”,获取 token key:sk-xxxxx 并提交。

- 获取本站的 URL:https://api.cometapi.com/

使用方法

- 选择 “

glm-4.5” 端点发送 API 请求并设置请求体。请求方法与请求体可从我们网站 API doc 获取。我们的网站也提供 Apifox 测试以供使用。 - 将 <YOUR_API_KEY> 替换为你账户中的实际 CometAPI key。

- 将你的问题或请求插入 content 字段——模型将对此进行响应。

- . 处理 API 响应以获取生成的答案。

CometAPI 提供完全兼容的 REST API——实现无缝迁移。关键细节参见 API 文档:

- Base URL: https://api.cometapi.com/v1/chat/completions

- Model Names: “

glm-4.5“ - Authentication:

Bearer YOUR_CometAPI_API_KEY头 - Content-Type:

application/json。

API 集成与示例

下面是一个 Python 代码片段,演示如何通过 CometAPI 的 API 调用 GLM‑4.5。请将 <API_KEY> 与 <PROMPT> 分别替换为实际值:

import requests

API_URL = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": "Bearer <API_KEY>",

"Content-Type": "application/json"

}

payload = {

"model": "glm-4.5",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "<PROMPT>"}

],

"max_tokens": 512,

"temperature": 0.7

}

response = requests.post(API_URL, json=payload, headers=headers)

print(response.json())

关键参数:

- model: 指定 GLM‑4.5 变体

- max_tokens: 控制输出长度

- temperature: 在创造性与确定性之间进行调节

另请参见 [GLM-4.5 Air API](https://www.cometapi.com/grok-4-api/)