由中国的 Zhipu AI(在许多开发者渠道对外品牌为 Z.AI / zai-org)于本周发布的 GLM-5,标志着大模型发布节奏进一步加速的又一步。新模型被定位为 Zhipu 的旗舰:规模更大,针对长时程的代理式任务进行调优,并通过工程选择在保留长上下文的同时降低推理成本。早期行业报道与开发者上手笔记显示,相较此前的 GLM 迭代,在编码、多步推理与代理编排方面有显著提升——在部分测试中甚至对标 Claude 4.5。

GLM-5 是什么,由谁构建?

GLM-5 是 GLM 系列的最新重大版本:由 Z.ai(GLM 系列背后的团队)开发与发布的大型开源基础模型。于 2026 年 2 月上旬宣布推出,GLM-5 被呈现为专门为“agentic”任务调优的下一代模型——即多步、长时程工作流,模型需要规划、调用工具、执行,并在长对话或自动化代理中保持上下文。此次发布不仅在模型设计上引人注目,也体现在训练方式与地点:Z.ai 使用了国内硬件与工具链的组合,以推动自给自足。

报告的架构与训练数据包括:

- **参数扩展:**GLM-5 规模扩展至约 744B 参数(部分技术说明中提到更小的“活跃”专家数量,如 40B active),而此前 GLM-4 家族规模约为 355B/32B active。

- **预训练数据:**训练语料规模据称从 GLM-4 代的 ~23 万亿 tokens 增加至 GLM-5 的 ~28.5 万亿 tokens。

- **稀疏注意力 / DeepSeek 稀疏注意力(DSA):**一种在推理时降低计算成本、同时保留长上下文的稀疏注意力方案。

- **设计重点:**工程选择聚焦于代理编排、长上下文推理与具备成本效益的推理。

起源与定位

GLM-5 延续了包括 GLM-4.5(于 2025 年中发布)以及若干迭代更新如 4.7 在内的产品线。Z.ai 将 GLM-5 的定位从“vibe coding”(快速单步代码输出)跃迁至“agentic engineering”:在长窗口中进行持续推理、多工具编排与系统综合。公开材料强调,GLM-5 被设计用于处理复杂系统工程任务——构建、协调并维护多步代理行为,而不仅仅是回答孤立问题。

GLM-5 有哪些新特性?

主要架构变化

- **大规模稀疏扩展(MoE):**GLM-5 采用更大规模的稀疏专家混合架构。来自开发者页面与独立综述的公开数据表明,该模型约 744B 总参数、每个 token ~40B 活跃参数——相较 GLM-4.5 的 ~355B / 32B active 是一次显著提升。稀疏扩展让模型在呈现极大的总容量的同时,保持可控的每 token 计算量。

- **DeepSeek 稀疏注意力(DSA):**为在不线性提升推理成本的前提下保留长上下文能力,GLM-5 集成了稀疏注意力机制(品牌为 DeepSeek),在超长上下文中保留关键的长程依赖,并削减注意力的计算开销。

将代理式工程作为基础设计目标

GLM-5 的一项核心特性是其明确面向代理式工程——意味着该模型不仅用于单轮聊天或摘要任务,而是作为多步代理的“大脑”,能够规划、发起工具调用、管理状态,并在长上下文中进行推理。Z.ai 将 GLM-5 定位为编排环路中的核心:拆解复杂问题、调用外部工具/API,并在多轮任务中进行长期跟踪。

为什么代理式设计重要

代理式工作流是现实世界自动化的核心:自动化研究助理、自主软件工程师、运营编排与仿真控制。为这些场景而构建的模型需要强规划能力、稳定的工具调用行为,以及在成千上万 tokens 的上下文中具备稳健性。

改进的编码、推理与“长时程”行为

GLM-5 强调改进代码生成与推理。Z.ai 声称模型在编写、重构与调试代码方面有针对性提升,并在长交互中的多步推理更为一致。独立的早期访问报告与合作伙伴评估发现,该模型在面向开发者的任务上明显强于先前 GLM 世代。

面向开发者的实用特性

- 更大的上下文窗口,用于容纳文档、代码库与会话状态。

- 面向安全的工具调用基元与结果处理。

- 更好的少样例与链式思维表现,用于拆解并执行复杂任务。

- **代理式特性与工具调用:**GLM-5 强调对代理的原生支持:函数/工具调用、有状态会话,以及对长对话与工具使用序列的更好管理。这使得更容易构建整合网页搜索、数据库或任务自动化的代理。

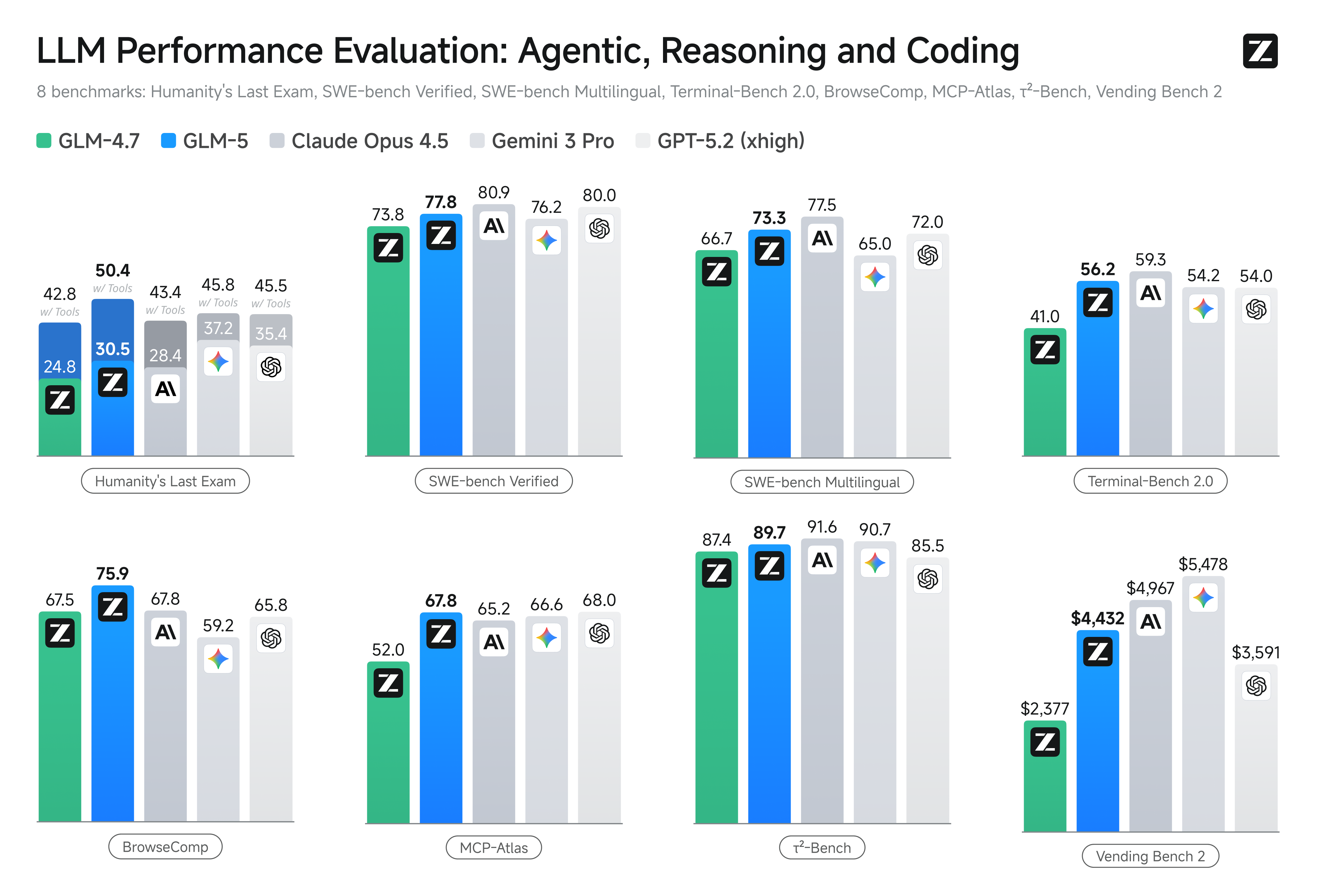

GLM-5 在基准测试中的表现如何?

具体基准亮点

- **编码基准:**在特定编码任务上,GLM-5 接近(某些情况下匹配)如 Anthropic 的 Claude Opus 4.5 等高度优化的专有模型的编码表现。这些结果因任务类型而异(单元测试、算法编码、API 使用),但与 GLM-4.5 相比,提升十分明显。

- **推理与代理测试:**在多步推理与代理评估套件(例如多轮规划、任务分解基准)上,GLM-5 在开源模型中取得同类最佳,并在部分针对性任务的指标上超越竞争的闭源模型。

我如何获取并试用 GLM-5?

GLM-5 是 Zhipu AI(Z.ai)的第五代大语言模型,采用 Mixture-of-Experts 架构(~745 B 总参数,~44 B 活跃),面向强推理、编码与代理式工作流。其于 约 2026 年 2 月 12 日正式发布。

目前主要有两种方式可以访问:

A) 官方 API 访问(Z.ai 或聚合平台)

Zhipu AI 本身提供其模型的 API,你可以通过这些 API 调用 GLM-5。

典型步骤:

- 注册 Z.ai/Open BigModel API 账户。

- 在控制台获取 API key。

- 使用 OpenAPI 风格或 REST API 端点,并设置模型名(例如

glm-5)。

(类似你调用 OpenAI 的 GPT 模型) - 设置提示词并发送 HTTP 请求。

👉 Z.ai 的定价页显示官方 GLM-5 token 价格如下:

- ~$1.0 / 百万输入 tokens

- ~$3.2 / 百万输出 tokens

B) 第三方 API 封装 ——CometAPI

CometAPI 或 WaveSpeed 等 API 会以统一接口封装多个 AI 模型(OpenAI、Claude、Z.ai 等)。

- 使用类似 CometAPI 的服务,你可以通过切换模型 ID 来调用 GLM 系列。

(CometAPI 目前支持 GLM-5/GLM-4.7。) - CometAPI 的 glm-5 定价为官方价格的 20%。

| 使用类型 | 价格 |

|---|---|

| 输入 tokens | ~$0.8 / 每 1M tokens |

| 输出 tokens | ~$2.56 / 每 1M tokens |

**这意味着:**你可以保留现有的 OpenAI 兼容客户端代码,只需更改 base URL/模型 ID。

C) 通过 Hugging Face / 权重自托管

在 Hugging Face 的模型列表中可见 非官方 的 GLM-5 权重仓库(例如名为 glm-5/glm-5-fp8 的版本)。

使用这些你可以:

- 下载模型权重。

- 使用 vLLM、SGLang、xLLM 或 Transformers 在本地或你的云 GPU 集群部署服务。

**优点:**最大化控制,无持续 API 成本。

**缺点:**计算需求巨大——很可能需要多块高端 GPU 和内存(数百 GB),对小型系统不切实际。

那么——GLM-5 值得吗,你是否应保留 GLM-4.7?

简短答案(管理摘要)

- **如果你的工作需要稳健的多步代理行为、生产级代码生成或系统级自动化:**应立即评估 GLM-5。其架构、规模与调优正是为这些目标而设。

- **如果你需要成本高效、高吞吐的微服务(短对话、分类、轻量提示):**GLM-4.7 可能仍是最经济的选择。GLM-4.7 在许多服务商的每 token 成本显著更低,同时能力集仍然强劲,并已在生产环境中充分验证。

较长答案(实用建议)

采用 分层模型策略:将 GLM-4.7 用于日常高频交互,保留 GLM-5 用于高价值工程问题与代理编排。在一个能覆盖长上下文、工具集成与代码正确性的产品切片上试点 GLM-5;同时衡量节省的工程时间与模型的增量成本。随着时间推移,你将判断 GLM-5 的能力提升是否值得更广泛迁移。

使用 CometAPI,你可以随时在 GLM-4.7 与 GLM-5 之间切换。

GLM-5 表现突出的真实场景

1. 复杂代理编排

GLM-5 在多步规划与工具调用上的设计重点,使其非常适合需要协调搜索、API 调用与程序执行的系统(例如:自动化研究助理、迭代式代码生成器,或需要查询数据库与外部 API 的多步客服代理)。

2. 长篇工程与代码库推理

当你需要模型在许多文件或大型代码库上进行分析、重构或综合时,GLM-5 的扩展上下文与稀疏注意力是直接优势——更少因上下文被截断导致的失败模式,并且在长跨度上更一致。

3. 知识密集型合成

生成复杂报告的分析师与产品团队——多章节研究简报、法律摘要或合规文件——可受益于模型在稳态多步推理上的提升,以及在厂商报告测试中降低幻觉率。

4. 面向工作流的代理式自动化

构建需要编排多套系统(例如规划 + 工单 + 部署流水线)的自动化的团队,可以将 GLM-5 作为中心的规划者与执行者,并配套工具调用框架与安全封装。

结论

GLM-5 是快速演进的前沿模型格局中的一次重要发布。其对代理式工程、改进编码与推理、以及开放权重可用性的强调,使其对构建长时程、工具增强型 AI 系统的团队颇具吸引力。在若干选定任务的真实收益与令人鼓舞的成本/性能权衡下——但在投入生产前,使用方应针对自己的具体任务开展受控基准评估。

开发者现在即可通过 GLM-5 与 CometAPI 进行访问。开始之前,请在 Playground 体验模型能力,并查阅 API 指南 获取详细说明。在访问前,请确保已登录 CometAPI 并获取 API key。CometAPI 提供远低于官方价格的方案,帮助你集成。

准备好了吗?→ 立即注册 glm-5 !