GPT-4o Realtime API: 一个低延迟的多模态流式端点,使开发者能够通过 WebRTC 或 WebSocket 发送与接收同步的文本、音频和视觉数据(model=gpt-4o-realtime-preview-<date>,stream=true),用于交互式实时应用。

基本信息与特性

OpenAI 的 GPT-4o Realtime(模型 ID:gpt-4o-realtime-preview-2025-06-03)是首个面向公众的基础模型,面向端到端语音到语音(S2S)交互并实现亚秒级延迟。该模型源自 “omni” GPT-4o 家族,Realtime 变体将语音识别、自然语言推理与神经文本转语音融合为单一网络,使开发者能够构建如人类般流畅对话的语音代理。模型通过专用的 Realtime API 对外提供,并与 Agents SDK(TypeScript 与 Python)中的全新 RealtimeAgent 抽象深度集成。

核心功能集 — 端到端 S2S • 中断处理 • 工具调用

• 原生语音到语音: 连续音频输入以流式方式摄取,内部进行分词、推理,并以合成语音返回。无需外部 STT/TTS 缓冲,消除多秒级流水线延迟。

• 毫秒级延迟: 通过架构裁剪、模型蒸馏与 GPU 优化的服务栈,实现典型云部署下约 300–500 ms 的首 Token 延迟,接近人类对话的轮流发言节奏。

• 稳健的指令遵循: 在会话脚本与函数调用轨迹上微调,相较 2024 年 5 月的 GPT-4o 基线,GPT-4o Realtime 的任务执行错误降低 >25%。

• 确定性的工具调用: 模型生成符合 OpenAI function-calling schema 的结构化 JSON,可确定性调用后端 API(预订系统、数据库、IoT)。内置错误感知重试与参数验证。

• 优雅的中断处理: 实时语音活动检测器与增量解码配合,使代理可在句中暂停发声,摄取用户打断,并无缝恢复或重规划回复。

• 可配置的语速: 新增 speed 参数(0.25–4× 实时),满足无障碍或高速应用的节奏需求。

技术架构 — 统一的多模态 Transformer

统一的编码器–解码器: GPT-4o Realtime 采用 omni 架构的单栈 Transformer,在同一潜空间内共置音频、文本与(未来的)视觉 Token。分层自适应计算将音频帧直通至后期注意力模块,每次前向传播可节省 20–40 ms。

分层音频分词: 原始 16 kHz PCM 被切分为对数梅尔谱片段 → 量化为粗粒度声学 Token → 压缩为语义 Token,在不牺牲韵律的前提下优化每秒令牌预算。

低比特推理内核: 部署权重采用 4-bit NF4 量化,通过 Triton / TensorRT-LLM 内核运行,与 fp16 相比吞吐翻倍,同时维持 <1 dB 的 MOS 质量损失。

流式注意力: 滑动窗口旋转嵌入与键值缓存使模型可在 O(L) 内存下关注最近 15 s 的音频,对电话通话长度的对话至关重要。

技术细节

- API 版本:

2025-06-03-preview - 传输协议:

- WebRTC:客户端音视频流的超低延迟(< 80 ms)

- WebSocket:服务端到服务端的流式传输,延迟低于 100 ms

- 数据编码:

- 音频使用 Opus 编码并封装于 RTP 包中

- 视频采用 H.264/H.265 帧封装

- 流式传输:支持

stream: true以在生成 Token 的同时交付增量部分响应 - 全新语音音色库:引入八种新声音——alloy、ash、ballad、coral、echo、sage、shimmer 和 verse——实现更富表现力、更拟人化的交互。

GPT-4o Realtime 的演进

- 2024 年 5 月:GPT-4o Omni 首次亮相,支持文本、音频与视觉的多模态。

- 2024 年 10 月:Realtime API 进入私测(

2024-10-01-preview),针对低延迟音频优化。 - 2024 年 12 月:推出

gpt-4o-realtime-preview-2024-12-17的全球可用性,新增提示缓存与更多声音。 - 2025 年 6 月 3 日:最新更新(

2025-06-03-preview)发布,优化声音音色库与性能。

基准表现

- MMLU:88.7,超越 GPT-4 在大规模多任务语言理解上的 86.5。

- 语音识别:在嘈杂环境中实现行业领先的词错误率,优于 Whisper 基线。

- 延迟测试:

- 端到端(语音输入 → 文本输出):通过 WebRTC 实现 50–80 ms

- 音频往返(语音输入 → 语音输出):< 100 ms

技术指标

- 吞吐:文本流维持15 tokens/sec;音频为 24 kbps Opus。

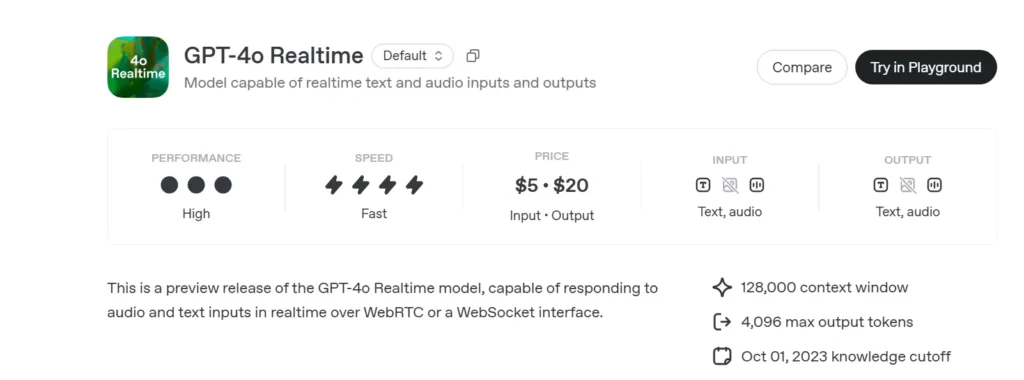

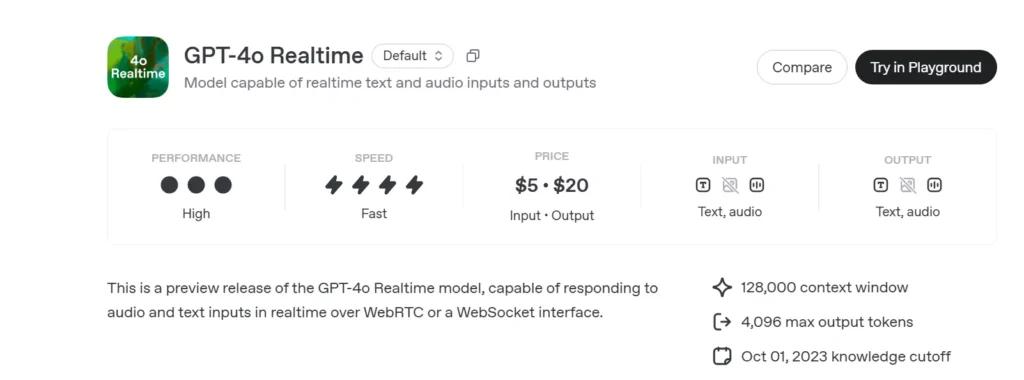

- 定价:

- 文本:每 1 M 输入令牌 $5;每 1 M 输出令牌 $20

- 音频:每 1 M 输入令牌 $100;每 1 M 输出令牌 $200。

- 可用性:在所有支持 Realtime API 的区域全球部署。

如何通过 CometAPI 调用 GPT-4o Realtime API

GPT-4o Realtime 在 CometAPI 的 API 定价:

- 输入令牌:$2 / M 令牌

- 输出令牌:$8 / M 令牌

必要步骤

- 登录 cometapi.com。若您尚未成为我们的用户,请先注册

- 获取接口访问凭证 API Key。在个人中心的 API Token 处点击“Add Token”,获取令牌密钥:sk-xxxxx 并提交。

- 获取本站的 URL:https://api.cometapi.com/

使用方法

- 选择 “

gpt-4o-realtime-preview-2025-06-03” 端点发送请求并设置请求体。请求方法与请求体可从我们的网站 API 文档获取。我们的网站也提供 Apifox 测试以便您使用。 - 将 <YOUR_API_KEY> 替换为您账户中的实际 CometAPI Key。

- 将您的问题或请求插入到 content 字段中——模型将对此作出响应。

- . 处理 API 响应以获取生成的答案。

有关在 Comet API 中访问模型的信息,请参见 API 文档。

有关模型价格的信息,请参见 https://api.cometapi.com/pricing。

示例代码与 API 集成

import openai

openai.api_key = "YOUR_API_KEY"

# Establish a Realtime WebRTC connection

connection = openai.Realtime.connect(

model="gpt-4o-realtime-preview-2025-06-03",

version="2025-06-03-preview",

transport="webrtc"

)

# Stream audio frames and receive incremental text

with open("user_audio.raw", "rb") as audio_stream:

for chunk in iter(lambda: audio_stream.read(2048), b""):

result = connection.send_audio(chunk)

print("Assistant:", result)

- 关键参数:

model:“gpt-4o-realtime-preview-2025-06-03”version:“2025-06-03-preview”transport:“webrtc”,实现最低延迟stream:true,用于增量更新

通过结合最先进的多模态推理、强大的新语音音色库与超低延迟流式能力,GPT-4o Realtime(2025-06-03)助力开发者构建真正互动、对话式的 AI 应用。

另见 o3-Pro API

安全与合规

OpenAI 为 GPT-4o Realtime 提供:

• 系统级护栏: 基于策略调整,拒绝不合规请求(极端主义、非法行为)。

• 实时内容过滤: 子 100 ms 分类器在输出前对用户输入与模型输出进行筛查。

• 人工审批路径: 在高风险工具调用(支付、法律建议)时触发,利用 Agents SDK 的新审批基元。