截至2025年12月15日,公开信息显示,Google 的 Gemini 3 Pro(预览版)与OpenAI 的 GPT-5.2均在推理、多模态与长上下文能力上开辟了新边界——但它们采用了不同的工程路径(Gemini → 稀疏 MoE + 超大上下文;GPT-5.2 → 稠密/“路由”设计、压缩与超高推理模式),因此在峰值基准成绩 vs. 工程可预测性、工具链与生态之间各有取舍。哪一个“更好”取决于你的主要需求:倾向于极限上下文的多模态代理型应用时选择 Gemini 3 Pro;追求稳定的企业级开发工具、可预测的成本与即刻的 API 可用性时选择 GPT-5.2。

什么是 GPT-5.2?其主要特性是什么?

GPT-5.2 是 OpenAI 于 2025 年 12 月 11 日发布的 GPT-5 系列产品(变体:Instant、Thinking、Pro)。它被定位为公司面向“专业知识工作”的最强能力模型——针对电子表格、演示文稿、长上下文推理、工具调用、代码生成与视觉任务做了优化。OpenAI 已将 GPT-5.2 提供给付费 ChatGPT 用户,并通过 OpenAI API(Responses API / Chat Completions)以诸如 gpt-5.2、gpt-5.2-chat-latest 和 gpt-5.2-pro 等模型名提供。

模型变体与适用场景

- gpt-5.2 / GPT-5.2 (Thinking) —— 最适合复杂、多步骤推理(Responses API 中默认使用的 “Thinking” 家族变体)。

- gpt-5.2-chat-latest / Instant —— 面向日常助理与聊天场景的低延迟选择。

- gpt-5.2-pro / Pro —— 面向最难问题的最高保真度/可靠性(额外计算,支持

reasoning_effort: "xhigh")。

关键技术特性(面向用户)

- 视觉与多模态改进 —— 更强的图像空间推理;与代码工具(Python 工具)配合时的视频理解提升,并支持类似代码解释器的片段执行工具。

- 可配置的推理强度(

reasoning_effort: none|minimal|low|medium|high|xhigh),用于在延迟/成本与深度之间权衡。xhigh为 GPT-5.2 新增(且在 Pro 上支持)。 - 增强的长上下文处理与压缩能力,可在数十万 token 范围内进行推理(OpenAI 报告在 MRCRv2/长上下文指标上表现强劲)。

- 高级工具调用与代理式工作流 —— 更强的多轮协调,在“单一巨型代理”式架构下更好地编排工具(OpenAI 强调在 Tau2-bench 工具任务上的表现)。

什么是 Gemini 3 Pro Preview?

Gemini 3 Pro Preview 是 Google 在 2025 年 11 月随更广泛的 Gemini 3 家族推出的最先进生成式 AI 模型。该模型强调多模态理解——能够理解并综合文本、图像、视频与音频——并提供超大的上下文窗口(约 1,000,000 个 token),可处理超长文档或代码库。

Google 将 Gemini 3 Pro 定位为在推理深度与细腻度方面的最先进模型,并将其作为多款开发者与企业工具的核心引擎,包括 Google AI Studio、Vertex AI 和类似 Google Antigravity 的代理式开发平台。

目前,Gemini 3 Pro 处于预览阶段——功能与访问权限仍在扩展中,但该模型已在逻辑、多模态理解与代理式工作流方面取得了很高的基准成绩。

关键技术与产品特性

- 上下文窗口:Gemini 3 Pro Preview 支持1,000,000 个 token 的输入上下文窗口(输出最多64k token),可在一次请求中摄取超大型文档、书籍或视频转录,具有显著的实际优势。

- API 特性:

thinking_level参数(low/high)用于在延迟与推理深度间权衡;media_resolution设置用于控制多模态保真度与 token 使用;支持搜索对齐、文件/URL 上下文、代码执行与函数调用。思维签名(Thought signatures)与上下文缓存有助于在多次调用的工作流中保持状态。 - Deep Think 模式/更高推理:“Deep Think” 选项提供额外的推理轮次,以提升在困难基准上的成绩。Google 将 Deep Think 作为应对复杂问题的独立高性能路径发布。

- **原生多模态支持:**文本、图像、音频与视频输入,并与搜索及产品集成紧密对齐(强调了 Video-MMMU 等多模态基准成绩)。

快速预览 —— GPT-5.2 与 Gemini 3 Pro

简明对比表(涵盖最重要的事实,来源已注明)。

| 方面 | GPT-5.2(OpenAI) | Gemini 3 Pro(Google / DeepMind) |

|---|---|---|

| 厂商 / 定位 | OpenAI —— 面向专业知识工作、编码与代理式工作流的 GPT-5.x 旗舰升级。 | Google DeepMind / Google AI —— Gemini 旗舰一代产品,聚焦超长上下文多模态推理与工具集成。 |

| 主要模型版本 | Instant、Thinking、Pro(并支持在它们之间自动切换)。Pro 提供更高的推理强度。 | Gemini 3 系列,包括 Gemini 3 Pro 与 Deep-Think 模式;侧重多模态/代理能力。 |

| 上下文窗口(输入 / 输出) | 约 400,000 token 总输入容量;最多 128,000 输出/推理 token(为超长文档与代码库而设计)。 | 最多约 1,000,000 token 输入/上下文窗口(1M),输出最多 64K token。 |

| 关键优势 / 关注点 | 长上下文推理、代理式工具调用、编码、结构化职场任务(表格、演示);安全/系统卡更新强调可靠性。 | 大规模多模态理解,推理 + 图像合成,超大上下文 + “Deep Think” 推理模式,在 Google 生态中的强工具/代理集成。 |

| 多模态与图像能力 | 改进的视觉与多模态对齐;针对工具使用与文档分析进行了调优。 | 高保真图像生成 + 增强推理的合成,多参考图像编辑与清晰的文本渲染。 |

| 时延 / 交互性 | 厂商强调相比先前 GPT-5.x 模型更快的推理与提示响应(更低时延);提供多个层级(Instant / Thinking / Pro)。 | Google 强调优化的“Flash”/服务性能,在许多流程中有可比的交互速度;Deep Think 模式以更高推理换取更高时延。 |

| 显著特性 / 差异点 | 推理强度级别(medium/high/xhigh)、改进的工具调用、高质量代码生成、为企业工作流提供高 token 效率。 | 1,000,000 token 上下文、原生强多模态摄取(视频/音频)、“Deep Think” 推理模式、与 Google 产品(Docs/Drive/NotebookLM)紧密集成。 |

| 典型最佳用例(简述) | 长文档分析、代理式工作流、复杂编码项目、企业自动化(表格/报告)。 | 超大型多模态项目、需要 1,000,000 token 上下文的长视野代理工作流、先进的图像 + 推理流水线。 |

GPT-5.2 与 Gemini 3 Pro 在架构上如何对比?

核心架构

- **基准 / 实务评测:**GPT-5.2 Thinking 在 GDPval(44 职业的知识工作评测)中取得 70.9% 的胜出/持平率,并在工程与数学基准上较此前 GPT-5 变体取得大幅提升。在编码(SWE-Bench Pro)与学科科学问答(GPQA Diamond)上也有显著进步。

- **工具与代理:**内置对工具调用、Python 执行与代理式工作流(文档搜索、文件分析、数据科学代理)的强力支持。相较人类专家,在部分 GDPval 任务上实现 11 倍速度/低于 1% 成本(潜在经济价值度量由此前约 38.8% 提升至 70.9%),并在电子表格建模方面显示出具体收益(例如较 GPT-5.1 在初级投行任务上提升 +9.3%)。

- **Gemini 3 Pro:**稀疏专家混合(Sparse Mixture-of-Experts, MoE)Transformer。模型对每个 token 仅激活少量专家,在保持次线性每 token 计算的同时实现极大的总体参数容量。Google 在模型卡中明确指出,稀疏 MoE 设计是性能提升的核心因素之一。该架构使得在不线性增加推理成本的情况下大幅提升模型容量成为可能。

- **GPT-5.2(OpenAI):**OpenAI 在 GPT-5 系列中继续采用基于 Transformer 的架构,并辅以“路由/压缩”策略(“路由器”在 Instant 与 Thinking 等模式间触发不同路径,公司文档强调用于长上下文的压缩与 token 管理)。GPT-5.2 更强调“先思考再作答”的训练与评估,以及面向长程任务的压缩能力,而非宣布采用大规模经典稀疏 MoE。

架构带来的影响

- **时延与成本权衡:**像 Gemini 3 Pro 这样的 MoE 模型,因每次仅运行部分专家,可在许多任务上以较低推理成本提供更高的每 token 峰值能力,但会增加服务与调度复杂度(专家冷启动均衡、IO 等)。GPT-5.2 的方式(稠密/路由 + 压缩)则更有利于可预测时延与开发者体验——尤其在与 OpenAI 既有工具(Responses、Realtime、Assistants、批处理 API)整合时。

- **长上下文的扩展:**Gemini 提供 1,000,000 输入 token 能力,可原生接收极长文档与多模态流。GPT-5.2 的约 400k 综合上下文(输入+输出)同样庞大,覆盖多数企业需求,但小于 Gemini 的 1M 规格。对于超大型语料或多小时视频转录,Gemini 的规格具有明显技术优势。

工具、代理与多模态底层管道

- **OpenAI:**深度集成工具调用、Python 执行、“Pro” 推理模式与付费代理生态(ChatGPT Agents / 企业工具集成)。强力关注以代码为中心的工作流与将电子表格/幻灯片作为一等输出。

- **Google / Gemini:**内置与 Google Search 的对齐(可选计费功能)、代码执行、URL 与文件上下文,并提供显式的媒体分辨率控制,以在视觉保真度与 token 消耗间权衡。API 提供

thinking_level等旋钮来调优成本/时延/质量。

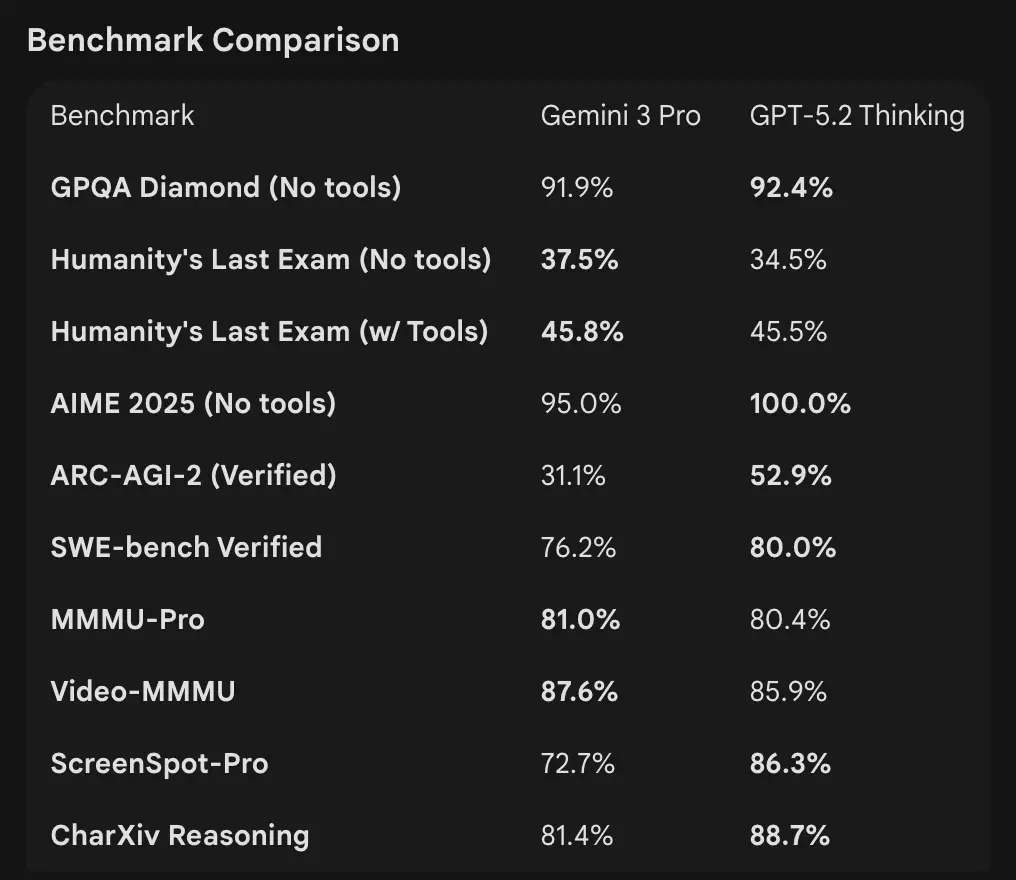

基准数据如何对比

上下文窗口与 token 处理

- **Gemini 3 Pro Preview:**1,000,000 输入 token / 64k 输出 token(Pro 预览模型卡)。知识截止:2025 年 1 月(Google)。

- **GPT-5.2:**OpenAI 展示了强大的长上下文性能(在 4k–256k 的 needle 任务上 MRCRv2 分数在许多设置中达到 >85–95% 区间),并使用压缩能力;OpenAI 的公开上下文示例显示即便在极大上下文下也能保持稳健表现,但官方按变体提供窗口规格(更强调压缩而非单一的 1M 数字)。API 使用的模型名包括

gpt-5.2、gpt-5.2-chat-latest、gpt-5.2-pro。

推理与代理基准

- **OpenAI(节选):**Tau2-bench Telecom 98.7%(GPT-5.2 Thinking),在多步工具使用与代理任务上有显著提升(OpenAI 强调将多代理系统折叠为“巨型代理”)。GPQA Diamond 与 ARC-AGI 相较 GPT-5.1 有台阶式提升。

- **Google(节选):**Gemini 3 Pro:LMArena 1501 Elo、MMMU-Pro 81%、Video-MMMU 87.6%,在 GPQA 与 Humanity’s Last Exam 上表现较高;Google 亦展示了代理案例中的长程规划能力。

工具与代理:

GPT-5.2:内置对工具调用、Python 执行与代理式工作流(文档搜索、文件分析、数据科学代理)的强力支持。相较人类专家,在部分 GDPval 任务上实现 11 倍速度 / 低于 1% 的成本(潜在经济价值度量 70.9%,此前约 38.8%),并在电子表格建模方面显示出具体提升(例如相较 GPT-5.1 的初级投行任务 +9.3%)。

**解读:**基准呈互补关系——OpenAI 强调真实世界知识工作基准(GDPval),显示 GPT-5.2 在电子表格、幻灯片与长代理序列等生产任务中表现出色。Google 强调原始推理排行榜与超大单次请求上下文窗口。孰轻孰重取决于你的负载:面向代理化、长文档的企业流水线偏好 GPT-5.2 在 GDPval 上的验证;需要摄取海量原始上下文(如整套视频语料/整本书一次性输入)则青睐 Gemini 的 1M 输入窗口。

多模态能力如何对比?

输入与输出

- Gemini 3 Pro Preview:支持文本、图像、视频、音频、PDF输入与文本输出;Google 提供细粒度的

media_resolution控制以及thinking_level参数,以调优多模态任务的成本与保真度。输出上限 64k token;输入最多 1M token。 - **GPT-5.2:**支持丰富的视觉与多模态工作流;OpenAI 强调改进的空间推理(图像组件边界与标签估计)、视频理解(Video MMMU 分数)以及工具增强的视觉(在视觉任务中启用 Python 工具可提升分数)。GPT-5.2 强调复杂的视觉 + 代码任务在启用工具支持(Python 代码执行)时收益显著。

实际差异

**颗粒度 vs. 广度:**Gemini 暴露一组多模态旋钮(media_resolution、thinking_level),旨在让开发者按媒体类型微调取舍。GPT-5.2 强调集成式工具使用(在环执行 Python),将视觉、代码与数据变换任务组合在一起。若你的用例偏重超大规模的视频 + 图像分析并需要极长上下文,Gemini 的 1M 上下文具有吸引力;若工作流需要在环执行代码(数据变换、电子表格生成),GPT-5.2 的代码工具与代理友好性可能更便捷。

API 访问、SDK 与定价如何?

OpenAI GPT-5.2(API 与定价)

- **API:**通过 Responses API / Chat Completions 提供

gpt-5.2、gpt-5.2-chat-latest、gpt-5.2-pro。具备成熟的 SDK(Python/JS)、Cookbook 指南与完备生态。 - 定价(公开):****$1.75 / 1M input tokens 与 $14 / 1M output tokens;缓存折扣(缓存输入可享 90% 折扣)可降低重复数据的有效成本。OpenAI 强调 token 效率(单位 token 价格更高,但达到质量阈值所需总成本更低)。

Gemini 3 Pro Preview(API 与定价)

- **API:**通过 Google GenAI SDK 与 Vertex AI/GenerativeLanguage 端点提供

gemini-3-pro-preview。新增参数(thinking_level、media_resolution)并与 Google 的对齐与工具集成。 - 定价(公开预览):预览层级(低于 200k tokens)约为$2 / 1M input tokens 与 $12 / 1M output tokens;使用 Search 对齐、Maps 或其他 Google 服务可能产生额外费用(Search 对齐计费自 2026 年 1 月 5 日开始)。

通过 CometAPI 同时使用 GPT-5.2 与 Gemini 3

CometAPI 是一个网关/聚合 API:以单一、OpenAI 风格的 REST API 端点,为你提供对数百个模型(LLM、图像/视频模型、嵌入模型等)的统一访问。无需集成多个厂商 SDK,CometAPI 允许你调用熟悉的 OpenAI 格式端点(chat/completions/embeddings/images),并在底层切换模型或厂商。

开发者可通过 CometAPI 同时使用两家公司的旗舰模型,而无需更换供应商,且 API 定价更实惠,通常有 20% 的折扣。

示例:快速 API 片段(可直接复制运行)

以下为最小可运行示例。它们参考了厂商发布的快速入门(OpenAI Responses API + Google GenAI 客户端)。将 $OPENAI_API_KEY / $GEMINI_API_KEY 替换为你的密钥。

GPT-5.2 — Python(OpenAI Responses API,深难题将 reasoning 设为 xhigh)

# Python (requires openai SDK that supports responses API)from openai import OpenAIclient = OpenAI(api_key="YOUR_OPENAI_API_KEY")resp = client.responses.create( model="gpt-5.2-pro", # gpt-5.2 or gpt-5.2-pro input="Summarize this 50k token company report and output a 10-slide presentation outline with speaker notes.", reasoning={"effort": "xhigh"}, # deeper reasoning max_output_tokens=4000)print(resp.output_text) # or inspect resp to get structured outputs / tokens

Notes: reasoning.effort 允许在成本与深度间权衡。日常聊天可用 gpt-5.2-chat-latest。OpenAI 文档展示了 responses.create 的示例。

GPT-5.2 — curl(简单示例)

curl https://api.openai.com/v1/responses \ -H "Authorization: Bearer $OPENAI_API_KEY" \ -H "Content-Type: application/json" \ -d '{ "model": "gpt-5.2", "input": "Write a Python function that converts a PDF with tables into a normalized CSV with typed columns.", "reasoning": {"effort":"high"} }'

(在 JSON 中查看 output_text 或结构化输出。)

Gemini 3 Pro Preview — Python(Google GenAI 客户端)

# Python (google genai client) — example from Google docsfrom google import genaiclient = genai.Client(api_key="YOUR_GEMINI_API_KEY")response = client.models.generate_content( model="gemini-3-pro-preview", contents="Find the race condition in this multi-threaded C++ snippet: <paste code here>", config={ "thinkingConfig": {"thinking_level": "high"} })print(response.text)

Notes: thinking_level 控制模型的内部推理;图像/视频可设置 media_resolution。REST 与 JS 示例见 Google 的 Gemini 开发者指南。

Gemini 3 Pro — curl(REST)

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \ -H "x-goog-api-key: $GEMINI_API_KEY" \ -H "Content-Type: application/json" \ -X POST \ -d '{ "contents": [{ "parts": [{"text": "Explain the race condition in this C++ code: ..."}] }], "generationConfig": {"thinkingConfig": {"thinkingLevel": "high"}} }'

Google 文档包含多模态示例(内联图像数据、media_resolution)。

哪个模型“更好”——实践指引

在以下情况下选择 GPT-5.2:

- 你需要与代码执行工具(OpenAI 的解释器/工具生态)紧密集成,用于程序化数据管道、电子表格生成或代理式代码工作流。OpenAI 强调了 Python 工具改进与巨型代理的使用。

- 你优先考虑厂商所宣称的token 效率,并希望获得明确、可预测的 OpenAI 按 token 定价,以及对缓存输入的大幅折扣(有助于批处理/生产工作流)。

- 你希望使用 OpenAI 生态(ChatGPT 产品集成、Azure / Microsoft 合作,以及围绕 Responses API 与 Codex 的工具链)。

在以下情况下选择 Gemini 3 Pro:

- 你需要极致多模态输入(视频 + 图像 + 音频 + PDF),并希望单一模型即可原生接收这些输入,且具备1,000,000 token 输入窗口。Google 明确将其用于长视频、大型文档 + 视频流水线与交互式 Search/AI Mode 等场景。

- 你在 Google Cloud / Vertex AI 上构建,并希望与 Google 的搜索对齐、Vertex 资源与 GenAI 客户端 API 深度集成。你将从 Google 的产品集成(Search AI Mode、AI Studio、Antigravity 代理工具)中受益。

结论:2026 年谁更“好”?

在 GPT-5.2 与 Gemini 3 Pro Preview 的对比中,答案取决于具体上下文:

- GPT-5.2 在专业知识工作、分析深度与结构化工作流方面领先。

- Gemini 3 Pro Preview 在多模态理解、生态集成与超大上下文任务方面表现卓越。

两者都不是普适意义上的“更好”——而是各自优势对应不同的真实需求。明智的采用者应将模型选择与具体用例、预算约束与生态契合度相匹配。

可以肯定的是,到了 2026 年,AI 前沿已显著推进,GPT-5.2 与 Gemini 3 Pro 均在企业及更广泛领域不断拓展智能系统的能力边界。

若你希望即刻尝试,可在 Playground 中体验 CometAPI 提供的 GPT-5.2 与 Gemini 3 Pro 的能力,并查阅 API 指南获取详细说明。访问前,请确保已登录 CometAPI 并获取 API Key。CometAPI 提供远低于官方的价格,帮助你完成集成。

准备好出发了吗?→ 免费试用 GPT-5.2 与 Gemini 3 Pro !

如果你想要