OpenAI 发布了gpt-oss-safeguard的研究预览版,这是一组开放权重的推理模型家族,旨在让开发者在推理时执行他们自己的安全策略。与交付固定分类器或黑箱化的审核引擎不同,新模型通过微调以便从开发者提供的策略进行推理,输出链式思维(CoT)解释其推理过程,并生成结构化的分类结果。作为研究预览发布,gpt-oss-safeguard 以一对推理模型——gpt-oss-safeguard-120b 与 gpt-oss-safeguard-20b——亮相,这些模型从 gpt-oss 家族微调而来,明确面向在推理过程中执行安全分类与策略执法任务。

什么是 gpt-oss-safeguard?

gpt-oss-safeguard 是一对开放权重、纯文本的推理模型,从 gpt-oss 家族进行后期训练,能够解读自然语言撰写的策略,并依据该策略对文本进行标注。其与众不同之处在于,策略在推理时提供(以策略为输入),而不是固化在静态分类器权重中。该模型主要用于安全分类任务——例如多策略审核、跨多监管体系的内容分类,或策略合规性检查。

意义何在

传统的审核系统通常依赖于(a)基于标注样本训练的固定规则集映射到分类器,或(b)启发式/正则表达式关键词检测。gpt-oss-safeguard 试图改变这一范式:无需在策略变更时重训分类器,你只需提供策略文本(例如你公司的可接受使用政策、平台服务条款或监管指南),模型就会推理给定内容是否违反该策略。这带来敏捷性(策略变更无需重训)与可解释性(模型输出其推理链)。

其核心理念是——“用推理替代记忆,用解释替代猜测”。

这代表了内容安全的新阶段,从“被动学习规则”走向“主动理解规则”。

gpt-oss-safeguard 能直接读取由开发者定义的安全策略,并在推理过程中遵循这些策略做出判断。

gpt-oss-safeguard 如何工作?

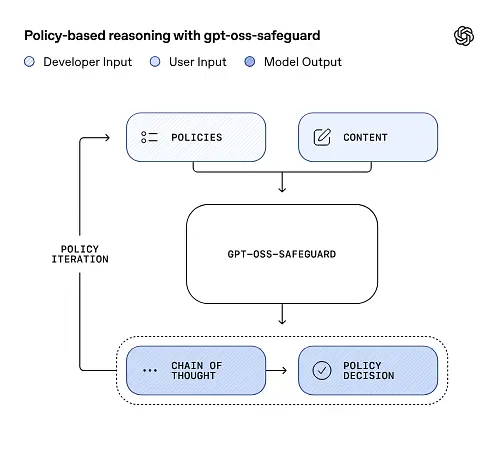

以策略为输入的推理

在推理时,你需要提供两样东西:策略文本与待标注的候选内容。模型将策略视为主要指令,然后逐步推理以确定内容是允许、禁止,还是需要额外的审核步骤。在推理过程中模型会:

- 生成包含结论(标签、类别、置信度)与人类可读推理轨迹的结构化输出,解释为何得出该结论。

- 读取策略与待分类的内容,

- 在内部以类似链式思维的步骤逐条推理策略条款,并

例如:

Policy: Content that encourages violence, hate speech, pornography, or fraud is not allowed.

Content: This text describes a fighting game.

它将回应:

Classification: Safe

Reasoning: The content only describes the game mechanics and does not encourage real violence.

链式思维(CoT)与结构化输出

gpt-oss-safeguard 可以在每次推理时输出完整的 CoT 轨迹。CoT 旨在可供审阅——合规团队可以阅读模型为何得出某个结论,工程师可利用该轨迹诊断策略歧义或模型失效模式。模型还支持结构化输出——例如包含判定、违规策略条款、严重程度分数与建议补救措施的 JSON——便于集成到审核流水线。

可调的“推理力度”级别

为平衡时延、成本与周详度,模型支持可配置的推理力度:低/中/高。更高的力度会加深链式思维深度,通常得到更稳健但更慢且成本更高的推理。开发者可据此分流工作负载——对常规内容用低力度,对边界案例或高风险内容用高力度。

模型结构与版本

家族与谱系

gpt-oss-safeguard 是在 OpenAI 早期gpt-oss开放模型基础上后训练的变体。当前 safeguard 家族包含两个已发布尺寸:

- gpt-oss-safeguard-120b —— 1200亿参数模型,面向高准确推理任务,在优化运行时可在单张 80GB GPU 上运行。

- gpt-oss-safeguard-20b —— 200亿参数模型,优化于低成本推理与边缘/本地环境(在部分配置下可运行于 16GB 显存设备)。

架构备注与运行时特性(可预期表现)

- 每个 token 的活跃参数:底层 gpt-oss 架构使用技术减少每个 token 被激活的参数数量(其母体 gpt-oss 采用了稠密与稀疏注意力/专家混合风格的设计)。

- 在实际运行中,120B 级别可适配单台大型加速卡,而 20B 级别则面向 16GB 显存环境在优化运行时中运行。

Safeguard 模型未使用额外的生物或网络安全数据进行训练,对 gpt-oss 发布所进行的最坏情况滥用场景分析大体适用于 safeguard 变体。该模型面向分类用途,而非为终端用户生成内容。

gpt-oss-safeguard 的目标

目标

- 策略灵活性:允许开发者用自然语言定义任意策略,模型无需自定义标签收集即可应用该策略。

- 可解释性:公开推理过程,便于审计决策并迭代策略。

- 可达性:提供开放权重替代方案,使组织能在本地运行安全推理并检查模型内部机理。

与经典分类器的比较

优点(相较传统分类器)

- 策略变更无需重训:当审核策略变更时,更新策略文档即可,而非收集标签并重训分类器。

- 更丰富的推理:CoT 输出可揭示策略间的微妙互动,并向人工审阅者提供有价值的叙述式说明。

- 可定制性:单一模型可在推理时同时应用多种不同策略。

缺点(相较传统分类器)

- 某些任务的性能上限:OpenAI 的评估指出,在数万条标注样本上训练的高质量分类器在特定分类任务上可能优于 gpt-oss-safeguard。当目标是纯分类准确率且你拥有标注数据时,针对该分布训练的专用分类器可能更好。

- 时延与成本:带 CoT 的推理计算密集、速度慢于轻量级分类器;在大规模下纯粹基于 safeguard 的流水线可能成本较高。

简而言之:当你优先考虑策略敏捷性与可审计性,或标注数据稀缺时,gpt-oss-safeguard 表现最佳——更适合作为混合流水线的互补组件,而不一定是面向规模优化的分类器的直接替代。

gpt-oss-safeguard 在 OpenAI 评估中的表现如何?

OpenAI 在一份 10 页技术报告中发布了基线结果,涵盖内部与外部评测。要点如下(经挑选的关键指标):

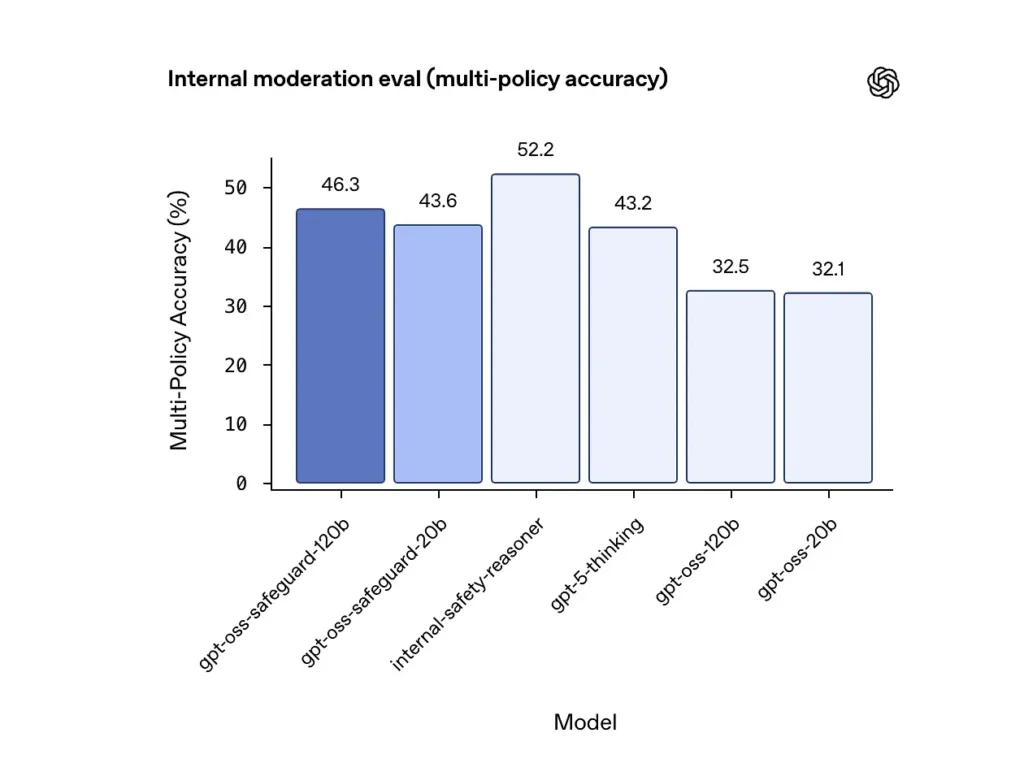

多策略准确率(内部评测)

OpenAI 通过同时给模型提供多份策略,并仅在预测与所有策略的金标准标签一致时计为正确来评估多策略准确率。结果:

- gpt-oss-safeguard-120b: 多策略准确率为 46.3%

- gpt-oss-safeguard-20b: 43.6%

- 作为对比:gpt-5-thinking: 43.2%;gpt-oss-120b: 32.5%;gpt-oss-20b: 32.1%。

OpenAI 内部的“safety-reasoner”集成在同测中得分 52.2%。这些数字显示 safeguard 模型在多策略任务上显著超越其 gpt-oss 基座模型,甚至超过了更大的 gpt-5-thinking 在该内部多策略指标上的表现。

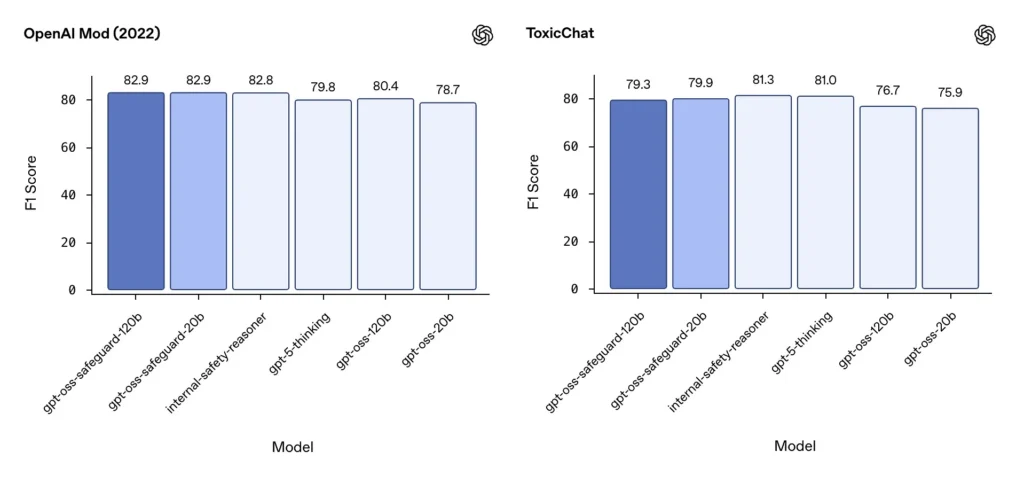

审核 F1(外部基准)

在 OpenAI 2022 审核数据集与公开的 ToxicChat 基准上,gpt-oss-safeguard 模型取得了稳定的 F1 分数:

- OpenAI Mod(2022)F1: gpt-oss-safeguard-120b = 82.9%,gpt-oss-safeguard-20b = 82.9%

- ToxicChat F1: gpt-oss-safeguard-120b = 79.3%,gpt-oss-safeguard-20b = 79.9%

这些分数使 gpt-oss-safeguard 在部分基准上接近或略低于 OpenAI 的专用内部系统,且总体领先于未微调的 gpt-oss 同类模型。

观察到的局限

OpenAI 指出两点实际局限:

- 当唯一目标是分类准确率时,在大规模、特定任务标注数据上训练的分类器依然可能优于 safeguard 模型。

- **计算与时延成本:**CoT 推理增加推理时间与计算消耗,若不配合分流分类器与异步流水线,将难以扩展至平台级流量。

多语言一致性

在类似 MMMLU 的多语言测试中,gpt-oss-safeguard 与其底层 gpt-oss 模型表现大体持平,表明经过微调的 safeguard 变体保留了广泛的推理能力。

团队如何获取与部署 gpt-oss-safeguard?

OpenAI 以 Apache 2.0 许可提供模型权重,并在 Hugging Face 提供下载链接。由于 gpt-oss-safeguard 是开放权重模型,本地与自托管部署(建议用于隐私与定制)

- 下载模型权重(来自 OpenAI / Hugging Face),并在你自有服务器或云主机上托管。Apache 2.0 许可允许修改与商业使用。

- **运行时:**使用支持大型 Transformer 模型的标准推理运行时(ONNX Runtime、Triton 或厂商优化运行时)。社区运行时如 Ollama 与 LM Studio 已在为 gpt-oss 系列添加支持。

- **硬件:**120B 通常需要高显存 GPU(如 80GB A100 / H100 或多卡分片),20B 可更低成本运行,并有针对 16GB 显存的优化选项。为峰值吞吐与多策略评估成本进行容量规划。

托管与第三方运行时

若自建硬件不现实,CometAPI 正在快速为 gpt-oss 模型提供支持。这类平台可能更易扩展,但会重新引入第三方数据暴露的权衡。在选择托管运行时前,请评估隐私、SLA 与访问控制。

使用 gpt-oss-safeguard 的高效审核策略

1) 采用混合流水线(分流 → 推理 → 裁决)

- 分流层:小型、快速的分类器(或规则)过滤掉简单案例。减少对昂贵的 safeguard 模型的负载。

- Safeguard 层:对含糊、高风险或多策略检查、策略细节重要的内容运行 gpt-oss-safeguard。

- 人工裁决:升级边界案例与申诉,存储 CoT 作为透明度证据。该混合设计平衡吞吐与精度。

2) 策略工程(而非提示词工程)

- 将策略当作软件工件:进行版本化、用数据集测试,并保持结构清晰、分层明确。

- 用正反示例撰写策略。在可能情况下,加入消歧指令(例如,“若用户意图明显为探索性和历史性,则标注为 X;若意图为操作性且实时,则标注为 Y”)。

3) 动态配置推理力度

- 对大批量处理用低力度,对被标记内容、申诉或法律/医疗/金融等高影响领域用高力度。

- 结合人工审阅反馈调参,找到成本/质量的平衡点。

4) 校验 CoT 并警惕幻觉式推理

CoT 很有价值,但可能出现幻觉:其轨迹是模型生成的理由,而非客观事实。请常规审计 CoT 输出;为虚构引用或不匹配推理配置检测器。OpenAI 将幻觉式推理记录为已观察挑战,并提出了缓解策略。

5) 从系统运行中构建数据集

记录模型决策与人工更正,积累标注数据集,以改进分流分类器或指导策略重写。随着时间推移,一个小而优质的标注数据集加上高效分类器,通常能减少常规内容对完整 CoT 推理的依赖。

6) 监控计算与成本;采用异步流程

对于面向消费者、低时延的应用,考虑采用异步安全检查与短期保守的用户体验(例如在复审前暂时隐藏内容),而不是同步执行高力度 CoT。OpenAI 指出 Safety Reasoner 在生产服务中内部使用异步流程以管理时延。

7) 考虑隐私与部署位置

由于权重开放,你可以完全在本地部署推理,以满足严格的数据治理或降低第三方 API 暴露——这对受监管行业尤为有价值。

结论:

gpt-oss-safeguard 是一个面向策略驱动安全推理的实用、透明且灵活的工具。当你需要与明确策略紧密挂钩、可审计的决策、策略频繁变更,或希望将安全检查放在本地时,它大放异彩。它并非能够自动替代专用大规模分类器的万能解——OpenAI 自身评估显示,在狭窄任务上,基于大量标注语料训练的专用分类器在纯准确率上可能更优。将 gpt-oss-safeguard 视为战略性组件:位于分层安全架构核心的可解释推理引擎(快速分流 → 可解释推理 → 人工监督)。

快速开始

CometAPI 是一个统一的 API 平台,将来自领先提供商的 500+ 款 AI 模型——如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等——聚合进单一、对开发者友好的接口。通过提供一致的认证、请求格式与响应处理,CometAPI 大幅简化了将 AI 能力集成到应用中的流程。无论你是在构建聊天机器人、图像生成器、音乐创作工具,还是数据驱动的分析流水线,CometAPI 都能让你更快迭代、控制成本、保持厂商无关性,同时紧跟 AI 生态的最新进展。

最新集成 gpt-oss-safeguard 即将登陆 CometAPI,敬请关注!在我们完成 gpt-oss-safeguard 模型上传前,开发者可以通过 CometAPI 访问 GPT-OSS-20B API 与 GPT-OSS-120B API,the latest model version 始终与官网保持同步更新。入门请先在 Playground 体验模型能力,并参考 API guide 获取详细说明。访问前请确保已登录 CometAPI 并获得 API Key。CometAPI 提供远低于官方的价格,帮助你完成集成。

准备好开始了吗?→ Sign up for CometAPI today!