当 xAI 在 2025 年 8 月下旬宣布 Grok Code Fast 1 时,AI 社区收到了一个明确信号:Grok 不再只是一个对话式助手——它正被武装用于开发者工作流。Grok Code Fast 1(简称:Code Fast 1)是一款专为编码任务和代理型编码工作流而调优的、低延迟低成本的推理模型——也就是模型能够规划、调用工具,并在 IDE 与流水线中充当自主编码助手的工作流。该模型已开始在合作伙伴集成中出现(尤其作为 GitHub Copilot 的可选预览)以及诸如 CometAPI 的多家云与第三方提供商目录中。

什么是 Grok Code Fast 1,为什么重要?

xAI 的 grok-code-fast-1 是一个刻意聚焦、低延迟的编码模型,旨在成为开发者工具与自动化工作流中的主动伙伴。它定位为务实的“结对程序员”,在速度、代理型工具使用(搜索、函数调用、代码编辑、测试)以及跨仓库的大上下文推理方面进行优化;作为 xAI Grok 家族中的专业变体,它优先考虑两点:交互速度与经济的 token 成本,以适配编码工作流。它并非要与最广泛的多模态通用模型竞争,而是瞄准日常开发循环:阅读代码、提出编辑建议、调用工具(linter/测试)、快速迭代。

为什么现在重要:

- 团队愈发期望在 IDE 与 CI 中获得即时反馈——每次助手迭代都要等待数秒会打断开发流。Grok Code Fast 1 明确旨在减少这种摩擦。

- 它支持函数调用、结构化输出与可见的推理轨迹,从而更好地自动化多步骤任务(搜索 → 编辑 → 测试 → 验证)。这使其天然适配代理型编码系统与编排式开发者助手。

为什么这里的“agentic(代理型)”很重要

代理型模型不只是“自动补全”。它们可以:

- 决定调用哪个外部工具(运行测试、检索包文档),

- 将任务拆解为子步骤并执行,

- 返回结构化 JSON 结果或以 git 风格的方式进行程序化更改。

Grok Code Fast 1 刻意公开其推理轨迹(便于开发者在流式过程中检查思路链路),并强调原生工具调用——这两项特性支持安全、可控的代理型编码。

Grok Code Fast 1 的性能与速度

Grok 如何衡量“快”?

模型品牌中的“Fast”指向多个维度:

- 推理延迟——在生成代码或推理轨迹时的 token 吞吐与响应时间。该模型针对低延迟进行了优化,适配交互式 IDE 循环(自动补全、代码建议、快速修复)而非仅限长批次作业。

- 成本效率——通过 token 定价与模型配置降低日常编码任务的使用成本;第三方市场相较于更大、更通用的模型列出更低费率。

- 开发者生产力——工作流中感知到的“速度”:从提示到可运行代码的速度,包括模型调用函数与返回结构化、可测试输出的能力。

真实世界的性能注记

| 操作 / 模型 | Grok Code Fast 1(观测值) |

|---|---|

| 简单行补全 | 瞬时 |

| 函数生成(5-10 行) | < 1 秒 |

| 复杂组件/文件生成(50+ 行) | 2-5 秒 |

| 重构大型函数 | 5-10 秒 |

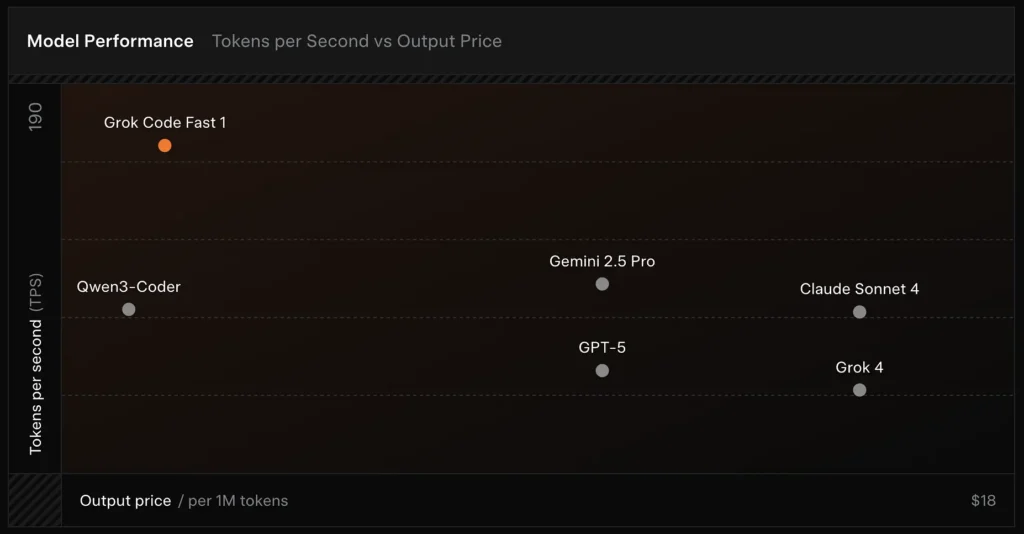

性能对比

- 速度:测试中达到每秒 190 个 token。

- 价格对比:GPT-5 输出成本约为每 100 万 token 18 美元,而 Grok Code Fast-1 仅为 1.50 美元。

- 准确率:在 SWE-Bench-Verified 基准上得分 70.8%。

支撑速度的设计选择

- 大上下文窗口(256k tokens):允许模型摄入大型代码库或长对话历史而不被截断,减少重复上传上下文的需求。

- 友好缓存的提示:模型与平台优化了在代理型步骤中很少变更的前缀 token 缓存,从而减少重复计算并提升多步骤工具交互的延迟表现。

- 原生工具调用协议:相较于临时的 XML 或脆弱的字符串“函数调用”,Grok 的 API 支持模型在推理过程内调用结构化的函数/工具定义(并可流式返回摘要或“思考轨迹”)。这最小化了解析工作,使模型能可靠组合多个工具。

Grok Code Fast 1 提供了哪些特性?

以下是让 Grok Code Fast 1 适合面向开发者集成的核心特性。

核心能力

- 代理型编码:内置支持调用工具(测试运行器、linter、包查询、git 操作)并组合多步骤工作流。

- 流式推理轨迹:在流式模式下,API 会暴露中间“推理内容”,便于开发者与系统观察模型的规划并进行干预。

- 结构化输出与函数调用:返回适合程序化消费的 JSON 或类型化结果(不仅是自由文本)。

- 超大上下文(256k tokens):适合单会话的跨文件任务。

- 快速推理:创新加速技术与提示缓存优化显著提升推理速度,响应速度极快,常常在用户读完提示之前就完成数十次工具调用。

- 代理型编程优化:常见开发工具:grep、终端操作与文件编辑。与 Cursor、GitHub Copilot、Cline 等主流 IDE 无缝集成。

- 编程语言覆盖:在 TypeScript、Python、Java、Rust、C++ 与 Go 等多种语言上具备出色能力。可处理完整开发任务,从零构建项目到排查复杂代码库与执行精细缺陷修复。

开发者体验

- 与 OpenAI 兼容的 SDK 接口:xAI 的 API 强调与常用 SDK 的兼容性并提供迁移指南,缩短开发者上手时间。

- CometAPI 与 BYOK 支持:像 CometAPI 这样的第三方提供商通过 REST 暴露 Grok Code Fast 1,适合偏好 OpenAI 兼容端点的团队。这有助于集成到期望 OpenAI 式 API 的工具链中。

与通用型 LLM 的不同

Grok Code Fast 1 以牺牲部分旗舰对话模型的广泛性,换取围绕代码、开发者工具与快速工具循环的更紧凑调优。实际效果包括:

- 更快的 token 生成与工具调用往返延迟。

- 更精炼、以行动为中心的输出(结构化响应、JSON/函数调用元数据)。

- 针对高频代码交互调优的成本模型(在许多网关列表中每 token 更便宜)

Grok Code Fast 1 的代理型能力如何——“agentic coding”在实践中意味着什么?

“代理型”意味着模型可以在与外部工具交互的情况下规划并执行多步骤任务。对 Grok Code Fast 1 来说,代理型能力表现为:

- 函数调用:Grok 可请求调用外部函数(如运行测试、获取文件、调用 linter),并将返回结果纳入后续决策。

- 可见的推理轨迹:输出可能包含可供检查的逐步推理,便于调试或引导代理行为。在自动化修改整个代码库时,这种透明度很有帮助。

- 持续的工具循环:Grok 旨在在简短、重复的 规划→执行→验证 循环中使用,而非期待单次的“长回复”。

受益于代理型行为的用例

- 自动化代码修复:定位失败测试、提出编辑、运行测试、迭代。

- 仓库分析:在成千上万文件中搜索使用模式、创建摘要或提出重构,并引用精确文件/行。

- PR 辅助生成:撰写 PR 描述、生成 diff 补丁并标注测试——全部在可运行于 CI 的编排流程中完成。

开发者如何访问与使用 Grok Code Fast 1 API?

xAI 通过公共 API 与合作伙伴集成对外提供 Grok 模型。常见的三种访问方式:

- 直接使用 xAI API——创建 xAI 账户,在控制台生成 API 密钥,并调用 REST 端点。xAI 文档给出 REST 基址为

https://api.x.ai,并指定标准的 Bearer 令牌认证。文档与指南提供了 curl 与 SDK 示例,并强调对许多工具层的 OpenAI 式请求兼容。 - IDE/服务伙伴(预览集成)——GitHub Copilot(可选公开预览)及其他伙伴(Cursor、Cline 等)作为首批合作推出,在 VS Code 与类似工具中启用 Grok Code Fast 1,有时通过“自带密钥(BYOK)”流程。若使用 Copilot 的 Pro 或企业版,请查找 Grok Code Fast 1 的可选项。

- 第三方网关(CometAPI、API 聚合器)——这些厂商在不同提供商间规范化 API 调用,并可能提供不同速率层(对原型或多提供商回退很有帮助)。CometAPI 等注册表会列出模型上下文、样例定价与示例调用。

以下是两个实用代码示例(Python 原生 SDK 流式与通过 CometAPI 的 REST),展示如何在真实应用中驱动 Grok Code Fast 1。

设计你的工具:在请求中注册函数/工具定义,以便模型可以调用;对流式场景,捕获

reasoning_content以监控模型的计划。

用例代码:Python(原生 xAI SDK,流式采样器)

示例基于 xAI 文档模式改写。将

XAI_API_KEY替换为你的真实密钥,并按你的环境调整工具定义。流式会显示 token 与推理轨迹。

# 保存为 grok_code_fast_example.py

import os

import asyncio

# 根据 xAI 文档的假设 xai_sdk

import xai_sdk

API_KEY = os.getenv("XAI_API_KEY") # 安全存储你的密钥

async def main():

client = xai_sdk.Client(api_key=API_KEY)

# 示例:请模型添加一个单元测试并修复失败代码

prompt = """

仓库结构:

/src/math_utils.py

/tests/test_math_utils.py

任务:运行测试,识别第一个失败的测试用例,并修改 src/math_utils.py

以修复该缺陷。展示最小代码 diff 并再次运行测试。

"""

# 启动一个流式采样;我们希望看到推理轨迹

async for chunk in client.sampler.sample(

model="grok-code-fast-1",

prompt=prompt,

max_len=1024,

stream=True,

return_reasoning=True, # 当可用时流式推理内容

):

# chunk 可能包含 token 与推理轨迹

if hasattr(chunk, "delta"):

if getattr(chunk.delta, "reasoning_content", None):

# 模型正在暴露其内部规划步骤

print("", chunk.delta.reasoning_content, flush=True)

if getattr(chunk.delta, "token_str", None):

print(chunk.delta.token_str, end="", flush=True)

if __name__ == "__main__":

asyncio.run(main())

注意

return_reasoning=True标志体现了文档关于流式推理轨迹的指引——捕获并展示它们,以便审计模型的计划。- 在真实的代理型设置中,你还会注册工具(如

run_tests、apply_patch)并授权模型调用。模型随后可以决定调用run_tests()并利用输出制定补丁。

用例代码:REST(CometAPI / 兼容 OpenAI)

若你的技术栈期望 OpenAI 式 REST 端点,CometAPI 以兼容模型字符串暴露

grok-code-fast-1。下面示例使用“openai”式客户端模式。

import os

import requests

CometAPI_KEY = os.getenv("CometAPI_API_KEY")

BASE = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {CometAPI_KEY}",

"Content-Type": "application/json",

}

payload = {

"model": "grok-code-fast-1",

"messages": [

{"role": "system", "content": "你是 Grok Code Fast 1,一个快速的编码助手。"},

{"role": "user", "content": "用 Python 编写一个函数,将两个已排序的列表合并为一个已排序的列表。"}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

注意

- CometAPI 在本地 gRPC 或 SDK 访问有困难的环境中充当桥梁;它支持同样的 256k 上下文并暴露

grok-code-fast-1。请检查提供商的可用性与速率限制。

实用集成模式与最佳实践是什么?

IDE 优先(结对编程)

将 Grok Code Fast 1 作为 IDE(如 VS Code)中的补全/助手模型嵌入。使用简短提示请求小而可测试的编辑。让助手保持紧凑循环:生成补丁 → 运行测试 → 用失败测试输出重新运行助手。

CI 自动化

使用 Grok Code Fast 1 分诊不稳定失败、建议修复或为新代码自动生成单元测试。由于其价格与架构都瞄准低延迟,相比更昂贵的通用模型,它更适合频繁的 CI 运行。

代理编排

将模型与健全的工具防线结合:始终在沙箱中执行建议补丁、运行完整测试套件,对非平凡的安全或设计更改要求人工审查。利用可见的推理轨迹审计行为并使其可复现。

提示工程技巧

- 为模型提供确切文件或小而聚焦的编辑上下文窗口。

- 偏好用于 diff 或 JSON 摘要的结构化输出模式——它们更易自动验证。

- 在运行多步骤流程时,记录模型的工具调用与结果,以便重放或调试代理行为。

具体用例:自动修复一个失败的 pytest 测试

下面是一个简化的 Python 工作流,展示如何将 Grok Code Fast 1 集成到测试-修复循环中。

# 伪代码:基于 grok-code-fast-1 的代理型测试修复循环

# 1) 收集失败测试输出

failing_test_output = run_pytest_and_capture("tests/test_math.py")

# 2) 请求 Grok 提出补丁与测试

prompt = f"""

Pyproject:仓库根目录

失败测试输出:

{failing_test_output}

请:

1) 简要解释根因。

2) 提供一个统一 diff 格式的补丁以修复问题。

3) 建议一个最小的新/更新单元测试来证明修复有效。

"""

resp = call_grok_model("grok-code-fast-1", prompt, show_reasoning=True)

# 3) 从响应中解析结构化补丁(务必校验!)

patch = extract_patch_from_response(resp)

if is_patch_safe(patch):

apply_patch(patch)

test_result = run_pytest_and_capture("tests/test_math.py")

report_back_to_grok(test_result)

else:

alert_human_review(resp)

该循环展示了代理型行为(提出 → 验证 → 运行 → 迭代)如何在保持开发者对变更应用控制的同时实现。

开始使用

CometAPI 是一个统一的 API 平台,将包括 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等在内的 500 多个领先 AI 模型聚合到一个对开发者友好的接口中。通过提供一致的认证、请求格式与响应处理,CometAPI 大幅简化了将 AI 能力集成到你的应用中。无论你是在构建聊天机器人、图像生成器、音乐合成器或数据驱动的分析管线,CometAPI 都能让你更快迭代、控制成本并保持供应商无关性,同时紧跟 AI 生态的最新突破。

开发者可通过 Grok Code Fast 1 API 访问 Grok Code Fast 1,且最新模型版本将始终与官网同步更新。开始之前,请在Playground探索模型能力,并查阅API 指南获取详细说明。访问前,请确保你已登录 CometAPI 并取得 API 密钥。CometAPI提供远低于官方价格的费率,帮助你完成集成。

准备好了吗?→ 立即注册 CometAPI!

结论

Grok Code Fast 1 并非为每项任务而生的单一“最佳”模型。它是一名专家型——针对代理型、工具丰富的编码工作流进行调优,在这些场景中,速度、大上下文窗口与低迭代成本至关重要。这种组合使其成为许多工程团队的实用日常驱动:足够快以胜任实时编辑器体验,足够便宜以支持迭代,并具备足够透明度以在适当边界下安全集成。