Anthropic 的 Claude Sonnet 4.5(通常简称为 Sonnet 4.5)作为 Anthropic 的 Claude 家族中以性能为重点的继任者发布。对于正在决定是否将 Claude Sonnet 4.5 用于聊天机器人、代码助手或长时间运行的自主代理的团队而言,成本是首要问题——重要的不仅是每个 token 的标价,还包括你如何部署模型、使用哪些节省功能,以及你拿它与哪些竞品模型比较。

什么是 Claude Sonnet 4.5,为什么要使用它?

Claude Sonnet 4.5 是 Anthropic 最新的 Sonnet 家族旗舰模型,针对长跨度的代理式(agentic)工作流、编程与复杂多步推理进行了优化。与先前的 Sonnet 版本相比,Anthropic 将 Claude Sonnet 4.5 定位为具备更大上下文窗口、在持续任务执行、代码编辑与领域推理方面改进的“前沿”模型。

主要技术和用户侧特性

- 强化的长上下文性能——旨在在多步过程中保持连贯工作(Anthropic 提及多小时连续工作的用例)。

- 改进的代码编辑与执行原语——支持检查点、在部分集成中进行代码执行,相较早期 Sonnet/Opus 模型具有更高的编辑准确性。

- 改进的推理、编码与代理性能——Anthropic 强调更长时间的连续自主运行,以及在多步骤工作流中更可靠的行为。

- 针对长上下文使用而设计(Sonnet 变体通常面向适用于代码库与多文档工作流的大上下文窗口),并在系统层面改进与安全护栏方面着重优化。

*更强的“计算机使用(computer use)”与编码性能

如果你的产品或团队需要以下一项或多项,Claude Sonnet 4.5 尤其具有吸引力:

- 长时间、有状态的代理运行(自主应用构建、多小时代码合成或自动化测试)。

- 高质量的代码编辑与重构——Anthropic 报告相较先前 Sonnet 版本在内部代码编辑错误率上有直接改进。

- 在金融、法律、医疗与 STEM 等领域的复杂推理与领域工作,在更长上下文与更少“提醒”下提升吞吐量、减少人工编排。

通过 Claude 应用使用 Claude 4.5 的定价如何?

面向消费者的订阅层级(网页/移动)有哪些?

Anthropic 的消费者层级仍如下(公开定价页面与后端文档):

- Free——适合休闲使用;消息/使用吞吐量受限。

- Pro——$20/月,按月计费(按年计费折后约 $17/月),面向日常重度用户与高级效率特性。Pro 提高会话/使用上限(高峰时段约为 Free 的 ~5×)。

- Max 计划——Anthropic 宣布更高使用量的 “Max” 层级($100/月约为 ~5× Pro 使用量,$200/月约为 ~20× Pro 使用量),面向需要持续大用量、但尚未采购企业方案的专业用户。该计划明确面向会用尽 Pro 会话上限的人群。

订阅能使用多少小时/消息?

Pro 用户可期望在高峰窗口获得类似于每五小时 ~45 条消息的额度,或每周 ~40–80 小时的 Sonnet 使用时长(视工作负载而定);Max 层级大幅扩容(Max 5× 与 20× 提供相应倍数的提升)。以上为大致范围——实际消耗取决于提示长度、附件大小、模型选择(Sonnet vs Opus vs Haiku)以及 Claude Code 等功能。

Claude Sonnet 4.5 的 API 定价详情是什么?

API 如何计费?

Anthropic 按 token 计费,区分输入 token(你发送的内容)与输出 token(模型返回的内容)。对于 Claude Sonnet 4.5,Anthropic 发布的基准费率为:

- 输入(标准 API):每 1,000,000 个输入 token 收费 $3.00。

- 输出(标准 API):每 1,000,000 个输出 token 收费 $15.00。

有哪些折扣或替代模式?

- Batch API(异步批量处理)在 Anthropic 文档中约有 ~50% 折扣——通常表示为 Sonnet 模型的批处理模式:输入 $1.50 / 百万(1M),输出 $7.50 / 百万(1M)。适合代码库分析、批量摘要等大规模离线工作负载。

- 提示缓存(prompt caching)在重复调用相同提示时可带来非常可观的节省。对于重复的助手提示或代理计划中重复出现的起始提示,使用缓存能降低成本。

- 第三方渠道:CometAPI 对官方 API 提供 20% 折扣,并提供专门适配的 cursor API 版本:输入(prompt)token 为每 1,000,000(1M)$2.4;输出(generation)token 为每 1,000,000(1M)$12。

注意:“提示缓存”和“批处理”是减少相同提示重复计算、并在多次调用间摊薄工作量的实现模式——实际节省幅度完全取决于你应用的工作负载模式。

订阅与 API 选项的成本如何比较?

这完全取决于使用画像:

- 对于交互式的人类效率场景(写作、研究、偶发代码协作),Pro 或 Max 订阅通常在成本/体验上更佳,因为它们将容量、应用特性与更高会话上限捆绑为可预测的月费。Anthropic 的 Pro 面向写作者与小团队;Max 面向需要显著更多月度时长与提示次数的专业用户。

- 对于程序化、高容量或按次事务(per-transaction)调用(如 Webhook、产品特性每天调用模型成千上万次),API 按量计费通常是正确选择:成本随 token 线性增长,并可通过批处理定价与缓存降低计费 token。

实用经验法则

如果你按 $3/$15 每百万 token 估算得到的月度 API 账单将明显高于满足你所需 Pro/Max 档位的订阅费用(在将预期小时/消息换算为 token 后),那就购买订阅或企业方案。反之,如果你的产品需要细粒度的程序化调用,API 是唯一可行的选择。

Claude Sonnet 4.5——按应用场景估算成本

以下为 Claude Sonnet 4.5 在典型应用场景(文本生成、代码、RAG、代理、长文档摘要等)下的实用、可操作的月度成本估算。每个场景给出假设(每次调用的 token 数与每月调用次数)、使用 Anthropic 公布费率的“基准”成本(输入 $3 / 百万;输出 $15 / 百万),以及两种常见优化视角:批处理折扣(50%)与提示缓存示例(70% 命中率与 90% 命中率)。这些折扣/收益与 Anthropic 文档一致(批处理≈50%,提示缓存可达 ~90% 节省)。

计算规则与假设是什么?

- 1,000,000 个 token 为计费单位。

- 月度成本 =(total_input_tokens / 1,000,000)× 输入费率 +(total_output_tokens / 1,000,000)× 输出费率。

- 报告三种成本视图:基准、批处理(费率 50% 折扣)、缓存(两个代表性的缓存命中率:70% 与 90% 的调用由缓存提供)。

- 以上为估算模型——实际账单将随缓存命中质量、精确提示大小、响应长度以及任何谈判折扣或合作/云平台加成而变化。

以下为 9 个场景。每个场景列出:每月调用次数、平均输入 token(提示/上下文)与平均输出 token(模型回复),随后是每月总量与成本。

Token 与词数粗略换算参考:1,000 个 token ≈ 750–900 个英文单词(取决于语言与格式)。

1) 短篇内容(博客大纲、社交帖子)

假设:1,000 次调用/月;每次 200 个输入 token;1,200 个输出 token。

总计:200,000 个输入 token;1,200,000 个输出 token。

| 成本视图 | 月度成本 |

|---|---|

| 基准(无折扣) | $18.60 |

| 批处理(费率 50%) | $9.30 |

| 70% 缓存命中(仅 30% 计费) | $5.58 |

| 90% 缓存命中(仅 10% 计费) | $1.86 |

适用场景:为小型创作者与代理批量生成短内容。对模板化提示(如固定大纲模板)使用缓存,效果显著。

2) 长文文章生成(多页输出)

假设:200 次调用/月;每次 500 个输入 token;5,000 个输出 token。

总计:100,000 个输入 token;1,000,000 个输出 token。

| 成本视图 | 月度成本 |

|---|---|

| 基准 | $15.30 |

| 批处理 | $7.65 |

| 缓存 70% | $4.59 |

| 缓存 90% | $1.53 |

适用场景:媒体/团队生产长文章;对计划性的批量生成使用批处理、对重复模板使用缓存。由于该场景以输出 token 为主导,即便如此,在中低量级文章产出下成本仍较温和;在高通量(每月数百—上千篇长文)下,批处理 + 谨慎截断可显著降本。

3) 客服聊天机器人(中等规模部署)

假设:30,000 个会话/月;每次 600 个输入 token;800 个输出 token。

总计:18,000,000 个输入 token;24,000,000 个输出 token。

| 成本视图 | 月度成本 |

|---|---|

| 基准 | $387.00 |

| 批处理 | $193.50 |

| 缓存 70% | $116.10 |

| 缓存 90% | $38.70 |

适用场景:中型应用的对话式支持——结合 RAG/知识检索与缓存常见答复可大幅降低成本。对聊天机器人而言,输出 token 往往是成本驱动因素。降低冗长(聚焦回答)并使用流式/提前停止可助力降本。缓存仅在提示重复时有效。

4) 代码助手(IDE 集成、编辑与修复)

假设:10,000 次调用/月;每次 1,200 个输入 token;800 个输出 token。

总计:12,000,000 个输入 token;8,000,000 个输出 token。

| 成本视图 | 月度成本 |

|---|---|

| 基准 | $258.00 |

| 批处理 | $129.00 |

| 缓存 70% | $77.40 |

| 缓存 90% | $25.80 |

适用场景:IDE 内逐次编辑协助。将 lint/格式化任务路由至更轻量的模型,仅在高价值代码编辑时升级到 Claude Sonnet 4.5。复用系统提示与模板并结合缓存以降低输入成本。

5) 文档摘要——长文档(法律/金融)

假设:200 次调用/月;每次 150,000 个输入 token(含大文档/分块);5,000 个输出 token。

总计:30,000,000 个输入 token;1,000,000 个输出 token。

| 成本视图 | 月度成本 |

|---|---|

| 基准(每次输入 ≤200k → 标准费率) | $615.00 |

| 批处理 | $307.50 |

| 缓存 70% | $184.50 |

| 缓存 90% | $61.50 |

重要提示:该示例将单次输入控制在 ≤200k,因此适用标准费率。若单次输入超过 200k token,则适用长上下文定价(见下个场景)。

6) 超长文档审阅(单次请求 >200k token → 长上下文费率)

假设:20 次调用/月;每次 600,000 个输入 token;20,000 个输出 token。

总计:12,000,000 个输入 token;400,000 个输出 token。

由于单次输入 > 200k,适用 Anthropic 的长上下文溢价费率(示例:输入 $6 / 百万,输出 $22.50 / 百万)。

| 成本视图(长上下文费率) | 月度成本 |

|---|---|

| 长上下文基准 | $81.00 |

| (若不计长上下文溢价,仅作对照) | $42.00 |

适用场景:对极大型证据集或书籍进行单次调用分析。尽可能使用分块 + 检索(RAG)以避免单次长上下文溢价。

7) RAG / 企业级问答(超高 QPS)

假设:1,000,000 次调用/月;每次 400 个输入 token;200 个输出 token。

总计:400,000,000 个输入 token;200,000,000 个输出 token。

| 成本视图 | 月度成本 |

|---|---|

| 基准 | $3,300.00 |

| 批处理 | $1,650.00 |

| 缓存 70% | $990.00 |

| 缓存 90% | $330.00 |

适用场景:高流量文档问答。RAG + 预过滤 + 本地缓存能显著减少必须调用 Claude Sonnet 4.5 的请求次数。

8) 代理式自动化(持续代理,多轮对话)

假设:50,000 个代理会话/月;每次 2,000 个输入 token;4,000 个输出 token。

总计:100,000,000 个输入 token;200,000,000 个输出 token。

| 成本视图 | 月度成本 |

|---|---|

| 基准 | $3,300.00 |

| 批处理 | $1,650.00 |

| 缓存 70% | $990.00 |

| 缓存 90% | $330.00 |

适用场景:后台运行的多步骤代理。架构至关重要:压缩状态、总结历史,并缓存重复的子提示以控制成本。

9) 批量翻译(大批量作业)

假设:500 个批处理作业/月;每次 50,000 个输入 token;50,000 个输出 token。

总计:25,000,000 个输入 token;25,000,000 个输出 token。

| 成本视图 | 月度成本 |

|---|---|

| 基准 | $450.00 |

| 批处理 | $225.00 |

| 缓存 70% | $135.00 |

| 缓存 90% | $45.00 |

适用场景:定时批量处理——批处理 API 是此类场景的最大杠杆。

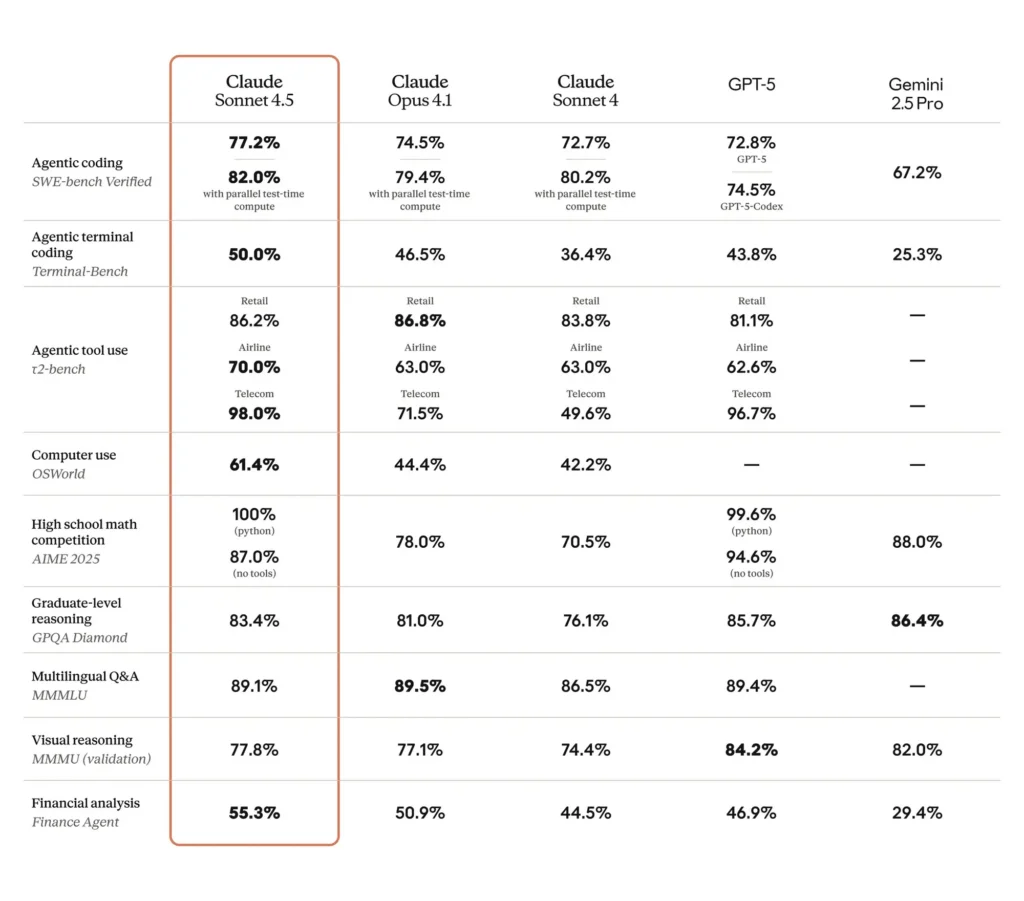

Claude Sonnet 4.5 的价格与其他主流模型相比如何?

Token 价格对比(简化视图)

- Claude Sonnet 4.5:输入 $3 / 百万,输出 $15 / 百万(标准 API)。

- OpenAI GPT-4o(案例报道):约输入 $2.50 / 百万,输出 $10 / 百万。

- OpenAI GPT-5(其旗舰的公开定价示例):约输入 $1.25 / 百万,输出 $10 / 百万(GPT-5 发布时 OpenAI 公布的 API 定价)。

解读:Sonnet 的输出成本明显高于部分 OpenAI 旗舰的输出价格,但 Sonnet 旨在以更高的代理效率进行对冲(因其可容纳更长上下文并在内部完成更多步骤,从而减少来回调用次数),同时 Anthropic 的缓存/批处理选项在重复提示下可显著降低有效成本。

能力/成本同样重要

如果 Claude Sonnet 4.5 能以更少的 API 调用完成多小时的代理任务,或生成更简洁、正确、无需后处理的输出,那么“真实成本”(工程时间 + API 费用)可能更低,尽管其每 token 输出费率更高。基准对比应按工作流计价,而非仅以 token 为单位。

哪些成本优化策略最适合 Claude Sonnet 4.5?

1) 强力利用提示缓存

Anthropic 宣称对重复提示可节省高达 90%。如果你的应用经常发送相同的系统提示或重复的指令脚手架,缓存能显著减少 token 处理。为 API 实现提示缓存层,以避免重新发送未变化的提示。()

2) 尽可能进行批处理

对数据处理或多项推理,将多条任务合并到一次 API 调用中。Anthropic 与其他厂商报告批处理模式可带来可观节省——具体节省取决于厂商对批处理计算的计费方式。()

3) 主动减少输出 token 数量

- 使用更严格的最大 token 设置,并在可接受时要求模型简明扼要。

- 对于 UI 流,优先发送部分响应或摘要,而非冗长全量输出。由于 Sonnet 的输出价格占比更高,压缩生成 token 将产生更大的节省效应。

4) 模型选择与路由

- 将低价值或抽取类任务路由至更便宜的模型(或更小的 Claude 变体),仅在关键代码/代理任务中使用 Sonnet 4.5。

- 对后台任务评估小型“mini”变体或旧版本 Claude。

5) 缓存生成结果以应对重复查询

若用户频繁请求相同答案(如产品描述、政策片段),缓存模型输出,用缓存结果替代再次生成。

6) 使用嵌入 + 检索以减少提示大小

将长文档存入向量数据库,仅检索最相关片段纳入提示——这可减少输入 token,并保持上下文精炼。

如何更低成本调用 Claude Sonnet API?

CometAPI 是一个统一的 API 平台,将 OpenAI GPT 系列、Google Gemini、Anthropic Claude、Midjourney、Suno 等 500+ 家头部提供商的模型聚合到单一、对开发者友好的接口中。通过提供一致的认证、请求格式与响应处理,CometAPI 大幅简化了在应用中集成 AI 能力的过程。无论你在构建聊天机器人、图像生成、音乐创作,还是数据驱动的分析管道,CometAPI 都能帮助你更快迭代、控制成本、保持供应商无关,同时获取 AI 前沿成果。

开发者可以通过 CometAPI 访问 Claude Sonnet 4.5 API,最新模型版本 会与官网保持同步更新。开始之前,可在 Playground 探索模型能力,并查阅 API 指南 获取详细说明。访问前请确保已登录 CometAPI 并获取 API Key。CometAPI 提供远低于官方的价格,助力你的集成落地。

准备好开始了吗?→ 立即注册 CometAPI!

结论

Claude Sonnet 4.5 是面向长时、代理式与编码任务的高能力模型。Anthropic 公布的 Sonnet 4.5 API 标价约为每百万输入 token $3、每百万输出 token $15;在合适的工作负载下,批处理与提示缓存机制往往可将有效成本削减一半或更多。订阅层级(Pro、Max)与企业方案为交互式或超重人类工作负载提供了替代的容量购买方式。在规划采用时,请按工作流测量 token 用量,在最难的流程上进行试点,并通过提示缓存、批处理与模型选择来优化性价比。