由 Zhipu AI(Z.ai)开发的 GLM-4.5 系列,是开源大语言模型(LLMs)领域的一次重要进步。GLM-4.5 旨在统一推理、编码与代理能力,在多种应用场景中都具备稳健表现。无论你是开发者、研究者,还是爱好者,本指南将详细介绍如何高效访问与使用 GLM-4.5 系列。

什么是 GLM-4.5 系列,它为何具有重要意义?

GLM-4.5 是一种混合推理模型,结合了两种模式:“思考模式”用于复杂推理与工具使用,“非思考模式”用于即时响应。该双模式方法使模型能够高效处理广泛任务。该系列包含两大变体:

- GLM-4.5:总参数量 3550 亿、活跃参数 320 亿,面向推理、生成与多代理任务的大规模部署。

- GLM-4.5-Air:总参数量 1060 亿、活跃参数 120 亿的轻量版,在不牺牲核心能力的前提下,优化用于端侧与小规模云端推理。

两款模型均支持混合推理模式,提供“思考”和“非思考”两种模式,以平衡复杂推理任务与快速响应;它们是开源的,并以 MIT 许可发布,可用于商业与二次开发。

架构与设计原则

GLM-4.5 的核心采用 MoE,将 Token 动态路由至专门的专家子网络,实现更优的参数效率与可扩展性()。这种方法意味着每次前向传播需要激活的参数更少,在保持推理与编码任务 SOTA 性能的同时,显著降低运营成本()。

关键能力

- 混合推理与编码:GLM-4.5 在自然语言理解基准和代码生成测试中均展现 SOTA 水平,准确性与流畅度常常可媲美专有模型。

- 代理集成:内置的工具调用接口支持在单次会话中编排多步工作流——如数据库查询、API 编排与交互式前端生成。

- 多模态产物:从 HTML/CSS 迷你应用到基于 Python 的仿真与交互式 SVG,GLM-4.5 可输出完整可运行的产物,提升用户参与度与开发者生产力。

为什么 GLM-4.5 是改变游戏规则者?

GLM-4.5 不仅因其原始性能而备受赞誉,也因其重新定义了开源 LLM 在企业与研究场景中的价值主张。

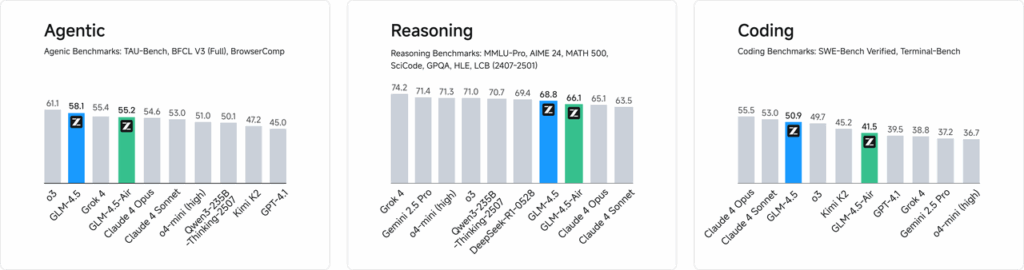

性能基准

在针对 52 项编程任务(涵盖 Web 开发、数据分析与自动化)的独立评估中,GLM-4.5 在工具调用的可靠性与整体任务完成度方面持续优于其他领先开源模型。在与 Claude Code、Kimi-K2 与 Qwen3-Coder 的对比测试中,GLM-4.5 在“SWE-bench Verified”排行榜等基准上取得同类最佳成绩。

成本效率

除了准确性之外,GLM-4.5 的 MoE 设计显著降低推理成本。公开 API 价格低至每百万输入 Token RMB 0.8、每百万输出 Token RMB 2——约为同类专有产品的三分之一。叠加峰值生成速度 100 Tokens/秒,模型支持高吞吐、低延迟的部署,而不会带来高昂费用。

如何访问 GLM-4.5?

1. 通过 Z.ai 平台直接访问

与 GLM-4.5 交互的最直接方式是使用 Z.ai 平台。访问 chat.z.ai,用户可选择 GLM-4.5 模型并通过友好的界面开始互动。该平台允许在无需复杂集成的情况下立即测试与原型验证。用户可以从左上角选择 GLM-4.5 或 GLM-4.5-Air 模型并立即开始聊天。该界面易用、无需设置,非常适合快速交互与演示。

2. 面向开发者的 API 访问

如需将 GLM-4.5 集成到应用程序,Z.ai API 平台提供全面支持。该 API 为 GLM-4.5 与 GLM-4.5-Air 提供兼容 OpenAI 的接口,便于无缝融入现有工作流。详细文档与集成指南请参阅 Z.ai API Documentation。

3. 开源部署

如需本地部署,可在 Hugging Face 与 ModelScope 等平台获取 GLM-4.5 模型。这些模型以 MIT 开源许可发布,允许商业使用与二次开发。它们可与 vLLM、SGLang 等主流推理框架集成。

4. 与 CometAPI 集成

CometAPI 通过其统一 API 平台在 仪表板 提供对 GLM-4.5 模型的简化访问。该集成简化了认证、速率限制与错误处理,是追求零负担设置的开发者的优选。此外,CometAPI 标准化的 API 格式便于在 GLM-4.5 与其他可用模型之间轻松切换与进行 A/B 测试。

开发者如何访问 GLM-4.5 系列?

获取与部署 GLM-4.5 的渠道多样,涵盖直接模型下载与托管 API。

通过 Hugging Face 与 ModelScope

Hugging Face 与 ModelScope 均以 zai-org 命名空间托管完整的 GLM-4.5 系列。开发者在同意 MIT 许可后即可:

- 克隆仓库:

git clone https://huggingface.co/zai-org/GLM-4.5

- 安装依赖:

pip install transformers accelerate

- 加载模型:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

通过 CometAPI

CometAPI 提供面向 GLM‑4.5 与 GLM-4.5 Air API 的无服务器 API,按 Token 计费。通过配置兼容 OpenAI 的端点,你可以在几乎不改动现有代码库的情况下,使用 OpenAI 的 Python 客户端调用 GLM-4.5。CometAPI 不仅提供 GLM4.5 与 GLM-4.5-air,还提供全部官方模型:

| 模型名称 | 介绍 | 价格 |

glm-4.5 | 我们最强大的推理模型,拥有 3550 亿参数 | 输入 Tokens $0.48 输出 Tokens $1.92 |

glm-4.5-air | 高性价比、轻量且性能强劲 | 输入 Tokens $0.16 输出 Tokens $1.07 |

glm-4.5-x | 高性能、强推理、超快响应 | 输入 Tokens $1.60 输出 Tokens $6.40 |

glm-4.5-airx | 轻量、强性能、超快响应 | 输入 Tokens $0.02 输出 Tokens $0.06 |

glm-4.5-flash | 强劲性能,适合推理、编码与代理场景 | 输入 Tokens $3.20 输出 Tokens $12.80 |

Python 与 REST API 集成

对于定制化部署,组织可使用 Docker 或 Kubernetes 在专用 GPU 集群上托管 GLM-4.5。典型的 RESTful 设置包括:

启动推理服务:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

发送请求:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "翻译为法语:Hello。", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

将 GLM-4.5 集成到应用的最佳实践是什么?

为最大化投资回报并确保稳健性能,团队应考虑以下事项:

API 优化与速率限制

- 批量请求:将相似提示分组,以减少开销并利用 GPU 吞吐。

- 缓存常见查询:在本地存储高频结果,避免重复推理调用。

- 自适应采样:根据查询复杂度动态调整

temperature与top_p,平衡创造性与确定性。

安全与合规

- 数据净化:在发送到模型前预处理输入,剔除敏感信息。

- 访问控制:实施 API Key、IP 白名单与请求节流,防止滥用与误用。

- 审计日志:记录提示、补全与元数据,以满足企业与监管要求,尤其是金融或医疗场景。

入门指南

CometAPI 是一个统一的 API 平台,将来自头部提供商的 500 多个 AI 模型(包括 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等)聚合到一个对开发者友好的接口中。通过提供一致的认证、请求格式与响应处理,CometAPI 大幅简化了将 AI 能力集成到你的应用中的过程。无论你在构建聊天机器人、图像生成器、音乐创作工具,还是数据驱动的分析管道,CometAPI 都能帮助你更快迭代、控制成本并保持供应商中立,同时畅享 AI 生态的最新突破。

对于希望将 GLM-4.5 集成到应用的开发者,CometAPI 平台提供了稳健的解决方案。该 API 提供兼容 OpenAI 的接口,便于无缝融入现有工作流。详细文档与使用指南可在 Comet API 页面 查阅。

开发者可通过 CometAPI 访问 GLM‑4.5 与 GLM-4.5 Air API,文中的最新模型版本以文章发布时为准。开始之前,请在 Playground 探索模型能力,并参考 API 指南 获取详细说明。访问前请确保已登录 CometAPI 并获取 API Key。CometAPI 提供远低于官方价格的方案,助你高效集成。

结论

GLM-4.5 是大语言模型领域的一次重大进展,为广泛应用提供了通用而强大的解决方案。其混合推理架构、代理能力与开源特性,使其成为希望利用先进 AI 技术的开发者与组织的理想选择。通过探索本指南中概述的多种访问方式,用户可将 GLM-4.5 有效集成到项目中,并为其持续发展做出贡献。