OpenAI 最近宣布了多项更新,包括发布 GPT-5-Codex-Mini 模型、改进多用户层级的速率限制,以及优化模型处理效率。

OpenAI 的 GPT-5-Codex-Mini 是新近宣布、面向开发者的 GPT-5-Codex 变体:更小、更注重成本与吞吐优化,旨在以更低成本和更高可用量提供 GPT-5-Codex 的大部分编码辅助能力。“Mini” 变体定位为针对长时间编码会话、后台自动化以及高频开发者工作流的务实选择,在这些场景中,相比原始峰值能力,能在同一套餐下获得更多 tokens/请求更为重要。

什么是 GPT-5-Codex-Mini 及其功能?

GPT-5-Codex-Mini 是 OpenAI 的 GPT-5-Codex 家族中一款紧凑、具成本效率的变体,专门打包用于 Codex 的产品界面(CLI 与 IDE 集成)。其定位为“更小、更加经济高效”的模型,以少量峰值能力为代价,换取显著更低的资源消耗和更高的交互式开发工作流可用配额。该 mini 模型旨在让开发者在保持常见、明确工程任务的低延迟与低成本的同时,运行更多编码轮次(OpenAI 描述为同级 ChatGPT 订阅层约可获得“约 4× 的使用量”)。

在能力方面,GPT-5-Codex-Mini 继承了 Codex 产品线的核心特性:对代码库的深度理解,以及以“agent”方式执行多步骤任务。基于 Codex CLI 功能,开发者可以在交互式终端向 Codex 提交自然语言命令、代码片段、截图或界面设计图。模型会先给出计划,然后在获得用户批准后自动浏览文件、编辑代码、运行命令并进行测试。

从模态角度看,Codex 产品允许在终端或 IDE 会话中附加图像(例如 UI 截图、设计稿或错误信息截图)。模型可理解文本与图像内容,但输出主要仍为文本代码与说明。因此,GPT-5-Codex-Mini 可视为主要“文本 + 图像输入、文本输出”的代码代理模型,不承担图像生成、音频生成或视频生成等任务。

GPT-5-Codex-Mini 与 GPT-5-Codex 有何比较?

Codex 有哪些新变化?

除了发布 GPT-5-Codex-Mini 外,OpenAI 已统一将 Codex 的速率限制为 ChatGPT Plus、Business 和 Edu 用户等级提升 50%,显著增加可用请求上限。同时,ChatGPT Pro 用户将获得优先处理权限,以提升响应速度和任务执行体验。

此外,OpenAI 对 GPT-5-Codex 模型进行了小幅升级,优化了其在协作场景下的表现。更新后的模型在关键评估指标上提升了几个百分点,token 使用效率约提高 3%,并在处理边缘案例方面更为稳健,从而减少用户引导的需求。

| 用户等级 | GPT-5-Codex | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Biz/Edu | 消息量分别提升至 1.5 倍。 | 消息量分别提升至 6 倍。 |

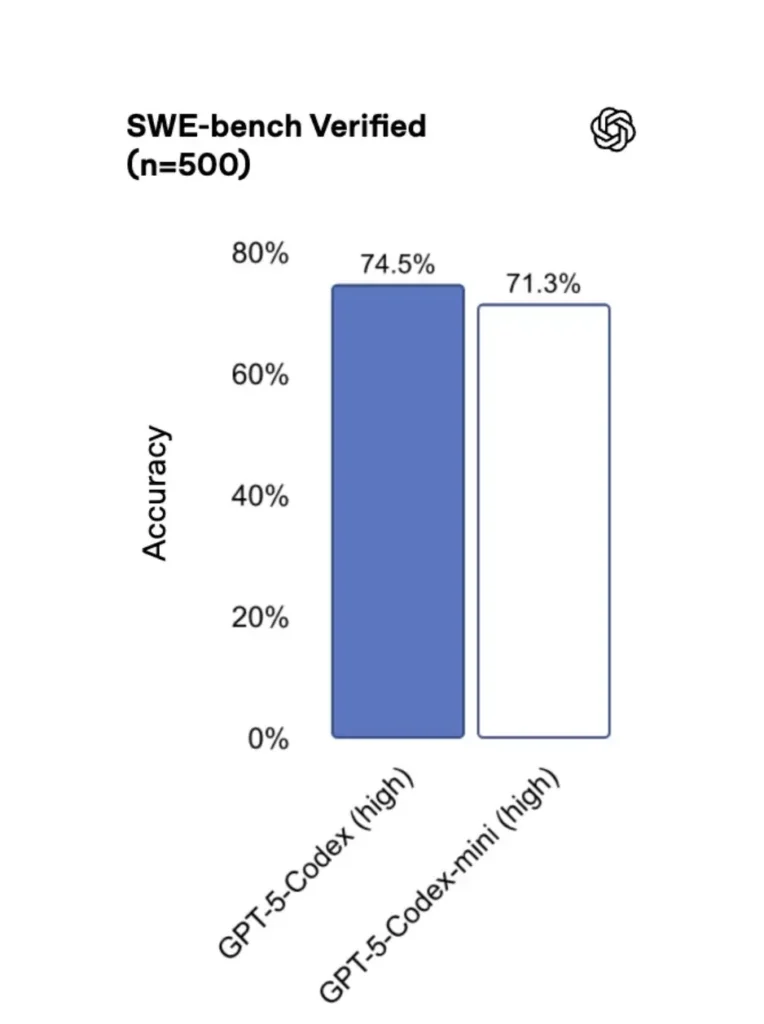

GPT-5-Codex-Mini vs GPT-5-Codex:基准测试差异

与原始版本相比,GPT-5-Codex-Mini 的性能略有下降,但开发者可获得约四倍的使用额度。在 SWE-bench Verified 测试中,GPT-5 High 得分 72.8%,GPT-5-Codex 得分 74.5%,而 GPT-5-Codex-Mini 得分 71.3%。

Codex(及其 mini 变体)在轻量交互中使用的 token 显著更少——OpenAI 的资料称,对于简单提示,其降低幅度可达几十个百分点(例如在某些场景下,Codex 系列相较 GPT-5 的轻量交互可实现 ≈93.7% 的 token 减少)。

GPT-5-Codex-Mini vs GPT-5-Codex:功能差异

- 规模与成本:Mini 明确更小且更具成本效率;OpenAI 表述为在同一订阅约束下可获得约 4× 的使用量。这是针对常规开发任务的配额/效率优化。

- 能力范围:GPT-5-Codex 仍是处理长时、复杂的 agent 化任务(大型重构、深入代码评审、长流程测试)的更高能力选项;Mini 则针对高频短交互调优,更灵敏、资源占用更低。

- 时延与速率限制:Mini 通常提供更低时延,并在各套餐下允许更高的速率限制——适合密集、交互式工作流。

- 默认界面:Mini 可在 Codex CLI 与 IDE 扩展中作为可选模型;GPT-5-Codex 则是 Codex 中云任务与深度代码评审流程的默认选择。

何时使用 Mini 与完整版 Codex

- 适合使用 Mini 的场景:脚手架搭建、重复性代码生成、小型重构、编辑时的交互式补全,以及存在配额或成本约束的工作。

- 适合使用 GPT-5-Codex 的场景:全面代码评审、跨数小时的自主任务、复杂重构,以及需要模型最强推理与测试驱动执行的任务。

如何访问 GPT-5-Codex-Mini(CLI、IDE、API)?

Codex CLI(以终端为先)

OpenAI 在 Codex CLI 中加入了 gpt-5-codex-mini 作为模型选项。典型使用模式遵循 Codex CLI 的工作流:启动交互会话、指定模型、附加文件或截图、运行 “Codex Cloud tasks” 等。CLI 也支持在完整版 gpt-5-codex 与 gpt-5-codex-mini 之间快速进行 /model 切换。首次运行时,需使用你的 ChatGPT/Pro/Enterprise 账户进行认证(或提供 API key)。CLI 提供多种命令,支持 Codex 扫描代码库、运行测试、打开 REPL 或应用补丁建议。

示例(Codex CLI 交互会话):

# 安装 Codex CLI(npm)

npm i -g @openai/codex

# 或在 macOS 上使用 Homebrew

brew install --cask codex

# 在仓库中启动

cd myproject

# 打开 Codex 交互会话

codex

# 在会话中可以切换模型:

# (在 Codex TUI 中输入)

> /model gpt-5-codex-mini

# 让 Codex 生成单元测试

> 为 discounts.py 中的函数 `calculate_discount` 编写 pytest 测试

该流程与新的 Codex CLI 默认一致:当接近使用上限时,工具会建议使用 Mini。

VS Code / IDE 扩展

是的——Codex IDE 扩展(VS Code)已包含 gpt-5-codex-mini 选项。在 Visual Studio Code 中安装 Codex 扩展,可获得行内代码补全、重构建议与 AI 驱动的快速修复。扩展还提供快速操作(生成代码、解释所选代码、重构),并可在编辑器中运行 Codex Cloud 任务。VS Code 步骤:

- 安装 OpenAI Codex / ChatGPT 的 VS Code 扩展。

- 使用你的 ChatGPT 账户(Plus/Pro/Business)登录。

- 打开命令面板:

Cmd/Ctrl+Shift+P → Codex: Set Model→ 选择gpt-5-codex-mini。 - 使用行内命令(选择代码 → 右键 → “Explain with Codex” 或按已配置的快捷键)。

示例:VS Code 行内命令(伪步骤)

- 在

user_service.py中选择一个函数。 - 按

Cmd/Ctrl+Shift+P → Codex: Explain Selection或使用右键 → “Explain with Codex”。 - 扩展将在侧边栏展示 Mini 的解释、建议测试,并提供一键“创建 PR”按钮,使用 Codex Cloud 任务推送分支以供评审。

那 API 呢——可以从我的应用调用吗?

OpenAI 的公告显示 API 支持即将推出 GPT-5-Codex-Mini;截至撰写时,该模型首先在 Codex 工具链(CLI/IDE)中可用。这意味着生产环境的 API 客户端应为该模型名 gpt-5-codex-mini 做好准备,一旦上线即可在 Requests/Responses API 中使用。同时,你可通过 Codex CLI 与 IDE 流程进行原型验证。

当启用 API 访问时,典型调用(Responses 风格)可能如下:

# 说明性示例——最终参数名请以 OpenAI 文档为准

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="编写一个用于验证电子邮件地址的 Python 函数,并包含单元测试。",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

使用 Codex Mini 进行快速工程的最佳实践是什么?

以下是可在生产工程工作流中最大化 Codex Mini 价值的具体、经实战检验的最佳实践与模式。

1) 模型选择策略——混用与切换

将 Mini 用于高频、低复杂度任务(格式化、小型重构、自动化测试),并在复杂设计、深度调试或大规模仓库变更时回退到完整版 Codex。实现自动切换:Codex CLI 在使用量达 90% 时会建议使用 Mini,你也可在工具中脚本化 /model 切换,根据任务复杂度选型。

2) 提示工程模板

为可重复任务(测试生成、变更日志草稿、提交信息生成、PR 描述)编写小而确定性的提示模板。将这些模板存为仓库中的可复用片段或 Codex 提示预设。

单元测试的提示模板示例:

# Template: generate_pytests

System: 你是一名严谨的 Python 开发者。请产出 pytest 测试。

User: 基于下方函数,生成覆盖典型边界情况的参数化 pytest 测试函数。

--- file: discounts.py

<insert function>

---

仅返回包含必要 imports 与 fixtures 的有效 Python 测试代码。

3) 自动化安全网——审批与 CI 闸门

切勿允许模型在无人审批的情况下直接推送代码。使用 Codex 的审批模式与 Codex Cloud 任务生成差异,并在 CI 中要求人工签核。Codex CLI 支持“审批模式”,编辑必须经批准才会应用。

4) 缓存与去重模型调用

对于重复性提示(例如解释一个函数),根据提示 + 文件哈希进行响应缓存。这样可减少冗余调用,并使成本轮廓更可控。

5) 使用流式输出与增量差异

尽可能请求流式输出与增量 diff,而非整文件重写。这能降低 token 使用,并帮助评审者聚焦于针对性改动。

6) 测试先行的生成流程

先生成测试并在本地的临时环境中运行。如果测试失败,携带失败信息与模型迭代。将每次迭代组织为离散的提示,并包含测试输出。

示例 Codex CLI 自动化片段(bash):

# 生成测试

codex --model gpt-5-codex-mini request "为 discounts.py 生成 pytest 测试" > generated_tests.py

# 在本地运行测试

pytest generated_tests.py -q || {

echo "测试失败。正在打开 Codex 进行调试..."

codex --model gpt-5-codex-mini request "测试失败。以下是 pytest 输出:$(tail -n 50 pytest_output.txt)。请为 discounts.py 提出修复方案。"

}

结论

GPT-5-Codex-Mini 是一次务实的产品举措:它承认开发者工作流往往由大量短交互主导,此时时延、成本与不中断的流畅度更为关键。通过提供面向 IDE 与 CLI 的 mini 级别,OpenAI 让团队能够扩展日常编码辅助,而不必在每次交互中都调用成本最高的模型。

开发者可通过 CometAPI 访问 GPT-5-Codex API 、GPT-5 Pro API,其所列模型为文章发布当日的最新版本。在访问前,请确保你已登录 CometAPI 并获取 API key。CometAPI 提供远低于官方价格的方案,帮助你完成集成。

准备好了吗?→ 立即注册 CometAPI !