在 2025–2026 年间,AI 工具版图持续整合:网关式 API(如 CometAPI)扩展为提供 OpenAI 风格的数百模型访问;而终端 LLM 应用(如 AnythingLLM)也不断完善其 “Generic OpenAI” 提供方,使桌面与本地优先应用可以调用任意 OpenAI 兼容端点。如今,将 AnythingLLM 的流量路由到 CometAPI 十分直接,从而获得模型选择、成本路由与统一计费的优势——同时仍可使用 AnythingLLM 的本地 UI 与 RAG/Agent 能力。

什么是 AnythingLLM,以及为什么要将它连接到 CometAPI?

什么是 AnythingLLM?

AnythingLLM 是一个开源、全功能的 AI 应用与本地/云端客户端,用于构建聊天助手、检索增强生成(RAG)工作流和由 LLM 驱动的智能体。它提供流畅的 UI、开发者 API、工作区/智能体特性,并支持本地与云端 LLM——默认以隐私为中心,并可通过插件扩展。AnythingLLM 暴露了一个名为 Generic OpenAI 的提供方,使其能够与兼容 OpenAI 的 LLM API 通讯。

什么是 CometAPI?

CometAPI 是一个商业化的 API 聚合平台,通过一个 OpenAI 风格的 REST 接口与统一计费,提供对 500+ AI 模型 的访问。实际使用中,它允许你通过同一 https://api.cometapi.com/v1 端点和一把 API Key(格式为 sk-xxxxx)调用多家厂商的模型(OpenAI、Anthropic、Google/Gemini 变体、图像/音频模型等)。CometAPI 支持标准的 OpenAI 风格端点,如 /v1/chat/completions、/v1/embeddings 等,使已支持 OpenAI 兼容 API 的工具容易适配。

为什么要将 AnythingLLM 与 CometAPI 集成?

三大实践理由:

- 模型选择与厂商灵活性:AnythingLLM 可通过其 Generic OpenAI 包装器使用“任意 OpenAI 兼容”的 LLM。将其指向 CometAPI,便可在不更改 AnythingLLM UI 或流程的前提下,立即获取数百种模型访问。

- 成本/运营优化:通过 CometAPI 可在中心化位置切换模型(或下调至更便宜的模型)以控制成本,并使用统一计费,而无需管理多家提供方的密钥。

- 更快的实验:你可以在同一 AnythingLLM UI 内对不同模型做 A/B(如

gpt-4o、gpt-4.5、Claude 变体或开源多模态模型)——适用于智能体、RAG 回答、摘要与多模态任务。

集成前需要准备的环境与条件

系统与软件要求(总体)

- 运行 AnythingLLM 的桌面或服务器(Windows、macOS、Linux)——桌面安装或自托管实例。确认你的版本提供 LLM Preferences / AI Providers 设置。

- CometAPI 账户与 API Key(

sk-xxxxx风格的密钥)。你将在 AnythingLLM 的 Generic OpenAI 提供方中使用该密钥。 - 你的机器可连通

https://api.cometapi.com(防火墙不阻断出站 HTTPS)。 - 可选但推荐:用于测试的现代 Python 或 Node 环境(Python 3.10+ 或 Node 18+)、curl,以及一个 HTTP 客户端(Postman / HTTPie),在接入 AnythingLLM 前先对 CometAPI 做连通性检查。

AnythingLLM 特定条件

对于模仿 OpenAI API 表面的端点,推荐使用 Generic OpenAI LLM 提供方。AnythingLLM 文档提示此提供方面向开发者,你应理解自己传入的参数。如果你使用流式响应而目标端点不支持流式,AnythingLLM 在 Generic OpenAI 中提供关闭流式的设置。

安全与运维核对清单

- 像对待其他机密一样对待 CometAPI Key——不要将其提交到代码仓;尽可能保存在操作系统钥匙串或环境变量中。

- 如在 RAG 中使用敏感文档,确保端点的隐私保障满足你的合规需求(查看 CometAPI 文档/条款)。

- 预先设定最大 tokens 与上下文窗口限制,避免账单失控。

如何配置 AnythingLLM 使用 CometAPI(分步)?

下面是具体步骤——紧随其后的是环境变量示例与用于在保存 AnythingLLM UI 设置前进行连接性测试的代码片段。

第 1 步 — 获取你的 CometAPI Key

- 在 CometAPI 注册或登录。

- 前往 “API Keys” 并生成密钥——你会得到形如

sk-xxxxx的字符串。务必妥善保管。

第 2 步 — 用一个快速请求验证 CometAPI 是否可用

使用 curl 或 Python 调用一个简单的 chat completion 端点,以确认连通性。

Curl 示例

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

如果返回 200 且 JSON 响应中包含 choices 数组,说明你的密钥与网络均正常。(CometAPI 文档展示了 OpenAI 风格的接口与端点。)

Python 示例(requests)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

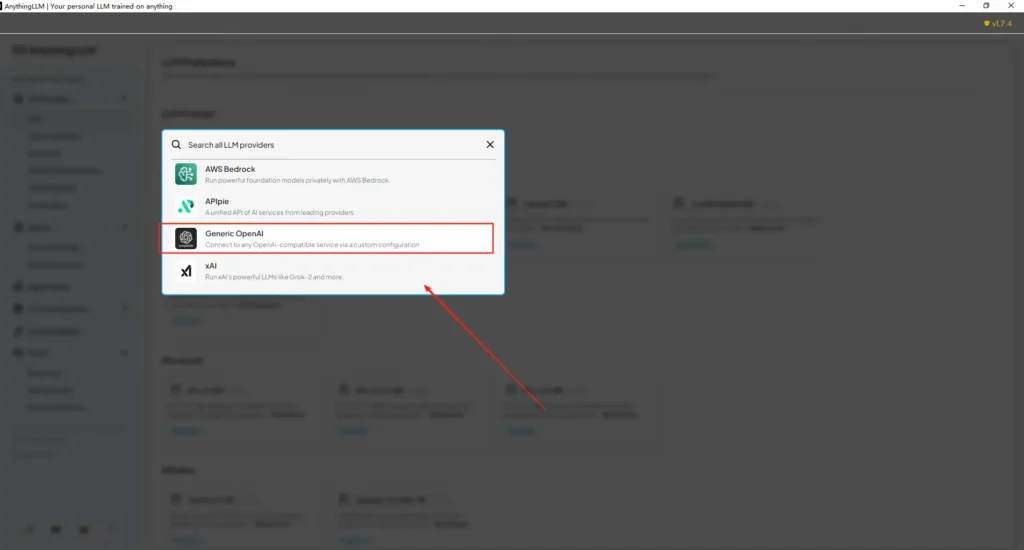

第 3 步 — 配置 AnythingLLM(UI)

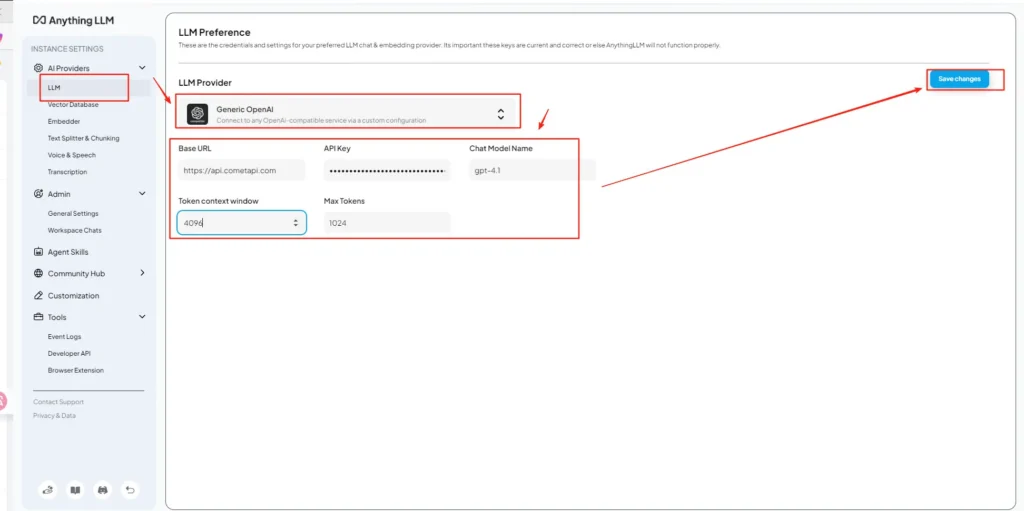

打开 AnythingLLM → Settings → AI Providers → LLM Preferences(或你版本中的类似路径)。选择 Generic OpenAI 提供方,并按如下填写字段:

API 配置(示例)

• 进入 AnythingLLM 设置菜单,在 AI Providers 下找到 LLM Preferences。

• 选择 Generic OpenAI 作为模型提供方,在 URL 字段输入https://api.cometapi.com/v1。

• 将 CometAPI 的sk-xxxxx粘贴到 API Key 输入框。根据实际模型填写 Token context window 与 Max Tokens。你也可以在此页面自定义模型名称,例如添加gpt-4o模型。

这与 AnythingLLM 的 “Generic OpenAI” 指南(开发者包装器)及 CometAPI 的 OpenAI 兼容基础 URL 思路一致。

第 4 步 — 设定模型名称与 token 限制

在同一设置页面,按 CometAPI 公布的名称精确添加或自定义模型名(例如 gpt-4o、minimax-m2、kimi-k2-thinking),以便 AnythingLLM 的 UI 能向用户展示这些模型。CometAPI 会为各厂商发布模型字符串。

第 5 步 — 在 AnythingLLM 中测试

新建一个聊天或使用现有工作区,选择 Generic OpenAI 提供方(若你配置了多个提供方),选择你添加的某个 CometAPI 模型名,并运行一个简单提示词。如果得到连贯的完成结果,就表示集成成功。

AnythingLLM 如何在内部使用这些设置

AnythingLLM 的 Generic OpenAI 包装器会构造 OpenAI 风格请求(/v1/chat/completions、/v1/embeddings),因此一旦你指向基础 URL 并提供 CometAPI Key,AnythingLLM 就会将聊天、智能体调用与嵌入请求透明地路由到 CometAPI。如果你使用 AnythingLLM 智能体(@agent 流程),它们也会继承同一提供方。

最佳实践与可能的陷阱

最佳实践

- 使用匹配模型的上下文设置:将 AnythingLLM 的 Token Context Window 与 Max Tokens 与在 CometAPI 上选择的模型相匹配。不匹配会导致意外截断或调用失败。

- 保护你的 API Key:将 CometAPI Key 存储在环境变量和/或 Kubernetes/密钥管理器中;切勿提交到 git。若在 UI 中输入,AnythingLLM 会将密钥保存在本地设置中——将宿主存储视作敏感资源。

- 以更便宜/更小的模型起步:开发阶段用更低成本的模型进行试验,生产再使用高阶模型。CometAPI 明确支持成本切换与统一计费。

- 监控用量并设置告警:CometAPI 提供用量看板——设置预算/告警以避免账单意外。

- 独立测试智能体与工具:AnythingLLM 智能体可能触发动作;先在安全的提示词与预发布环境中测试。

常见陷阱

- UI 与

.env冲突:自托管时,UI 设置可能覆盖.env(反之亦然)。若重启后设置被回滚,请检查生成的/app/server/.env。社区反馈中有LLM_PROVIDER重置问题。 - 模型名不匹配:使用 CometAPI 中不可用的模型名会导致网关返回 400/404。务必在 CometAPI 模型列表中确认可用模型。

- Token 限制与流式:如需流式响应,确认 CometAPI 的该模型支持流式(且你的 AnythingLLM UI 版本也支持)。不同提供方在流式语义上可能存在差异。

该集成能解锁哪些真实场景?

检索增强生成(RAG)

将 AnythingLLM 的文档加载器 + 向量数据库与 CometAPI 的 LLM 结合,生成具备上下文的回答。你可以在嵌入用便宜模型 + 对话用昂贵模型之间做实验,或将所有调用都放在 CometAPI 上以统一计费。RAG 流程是 AnythingLLM 的核心内建能力之一。

智能体自动化

AnythingLLM 支持 @agent 工作流(浏览网页、调用工具、运行自动化)。通过 CometAPI 路由智能体的 LLM 调用,让你在控制/解释环节拥有模型选择权,无需修改智能体代码。

多模型 A/B 测试与成本优化

按工作区或功能切换模型(如生产回答用 gpt-4o,开发用 gpt-4o-mini)。CometAPI 让模型切换变得轻而易举,并实现成本集中化。

多模态流程

CometAPI 提供图像、音频与专用模型。AnythingLLM 对多模态(通过提供方)与 CometAPI 的模型结合,可通过同一接口实现图像描述、多模态摘要或音频转写等流程。

结论

CometAPI 持续定位为多模型网关(500+ 模型、OpenAI 风格 API),这使其与已支持 Generic OpenAI 提供方的应用(如 AnythingLLM)天然契合。同样,AnythingLLM 的 Generic 提供方与近期的配置选项也让连接此类网关变得直观。在 2025 年末,这种收敛简化了从实验到生产的迁移。

如何开始使用 Comet API

CometAPI 是一个统一 API 平台,将来自领先提供商的 500 多个 AI 模型——例如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等——聚合到一个对开发者友好的接口中。通过提供一致的认证、请求格式与响应处理,CometAPI 大幅简化了将 AI 能力集成到你的应用中的过程。无论你在构建聊天机器人、图像生成器、音乐生成器,还是数据驱动的分析流水线,CometAPI 都能让你更快迭代、控制成本并保持供应商无关性,同时紧跟 AI 生态的最新突破。

开始之前,请在 CometAPI 的 Playground 中探索模型能力,并查阅 API 指南获取详细说明。访问前,请确保你已登录 CometAPI 并获得 API Key。CometAPI 提供远低于官方价格的方案,帮助你完成集成。

准备好出发了吗?→ Sign up for CometAPI today