DeepSeek 发布了 DeepSeek V3.2 以及高算力变体 DeepSeek-V3.2-Speciale,引入了新的稀疏注意力引擎(DSA)、改进的代理/工具行为,以及能够呈现内部推理的“思考”(链式推理)模式。两款模型均可通过 DeepSeek 的 API(兼容 OpenAI 的端点)访问,模型工件与技术报告也已公开发布。

什么是 DeepSeek V3.2?

DeepSeek V3.2 是 DeepSeek V3 系列中的生产级继任者——这一大型、长上下文的生成式模型系列专为以推理为先的工作流与代理使用而设计。V3.2 将此前的实验性改进(V3.2-Exp)整合到主流模型线上,并通过 DeepSeek 的应用、Web UI 和 API 对外提供。它同时支持快速的对话式输出,以及专用的“思考”(链式推理)模式,适用于数学、调试、规划等多步推理任务。

为什么 V3.2 重要(快速背景)

DeepSeek V3.2 在三个实用方面尤为突出:

- 长上下文:最多支持 128k token 的上下文窗口,适用于长文档、法律合同或多文档研究。

- 以推理为先的设计:模型将链式推理(“thinking”)融入工作流与工具使用——面向需要中间推理步骤的代理型应用的转变。

- 成本与效率:引入 DSA(稀疏注意力)在长序列上降低计算,显著降低大上下文推理的推理成本。

什么是 DeepSeek-V3.2-Speciale,它与基础版 v3.2 有何不同?

“Speciale” 变体的特别之处是什么?

DeepSeek V3.2-Speciale 是 v3.2 家族中的高算力、高推理变体。相比平衡型的 v3.2,Speciale 专门针对多步推理、数学与代理型任务进行调优(及后训练);在训练中使用了额外的人类反馈强化学习(RLHF)与扩展的内部链式推理。该临时端点与 Speciale 的 API 访问被宣布为有时间限制(参考 Speciale 路径的端点到期日为 2025 年 12 月 15 日)。

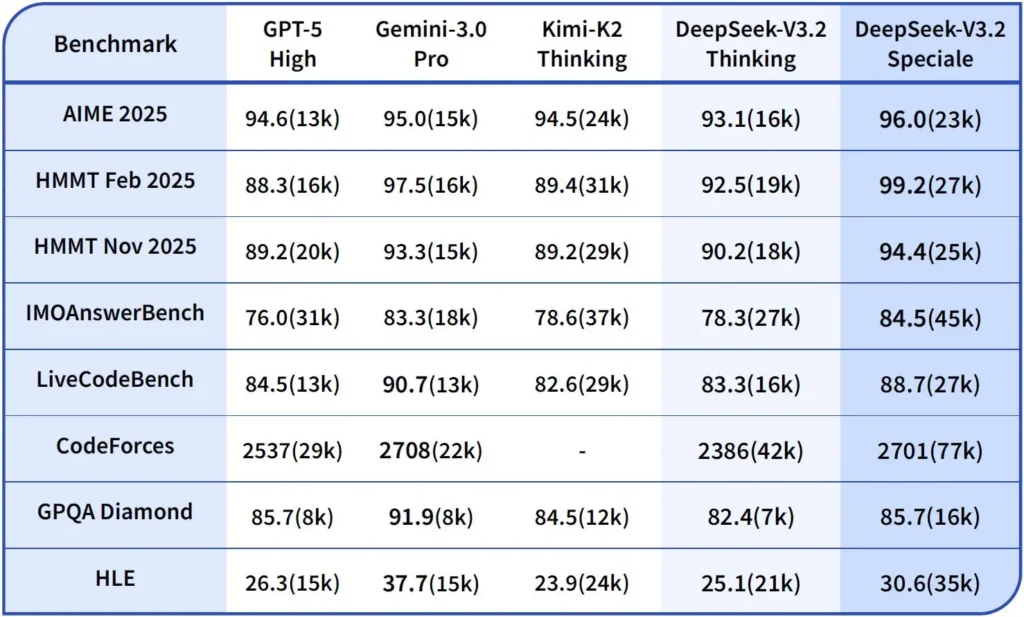

性能与基准

DeepSeek-V3.2-Speciale 是 V3.2 的高算力、推理优化变体。Speciale 版本集成了此前的数学模型 DeepSeek-Math-V2,定位于在需要最深入的链式推理、多步问题求解、竞争性推理(如数学奥赛风格)以及复杂代理编排时使用的模型。

它能够自主证明数学定理并验证逻辑推理;在多项世界级竞赛中取得了显著成绩:

- IMO(International Mathematical Olympiad,国际数学奥林匹克竞赛)金牌

- CMO(Chinese Mathematical Olympiad,中华数学奥林匹克竞赛)金牌

- ICPC(International Computer Programming Contest,国际计算机程序设计竞赛)人类赛季军(第二名)

- IOI(International Olympiad in Informatics,国际信息学奥林匹克竞赛)人类赛第十名

DeepSeek v3.2 的推理模式是什么?

DeepSeek 提供显式的“思考/推理模式”,使模型在最终答案之前输出一段离散的链式推理(CoT)。API 会提供这段 CoT,客户端应用可以对其进行检查、展示或提炼。

机制——API 提供了什么

reasoning_content字段:当启用思考模式时,响应结构会在最终content同级包含reasoning_content字段(即 CoT)。这便于客户端以编程方式访问内部步骤。- 思考期间的工具调用:V3.2 声称支持在思考轨迹中进行工具调用;模型可以交错推理步骤与工具调用,从而提升复杂任务的表现。

DeepSeek v3.2 API 如何实现推理

版本 3.2 引入了标准化的推理链 API 机制,以在多轮对话中保持一致的推理逻辑:

- 每次推理请求都包含模型中的

reasoning_content字段; - 若用户希望模型继续推理,必须在下一轮传回该字段;

- 当新问题开始时,需清空旧的

reasoning_content以避免逻辑污染; - 在推理模式下,模型可多次执行“推理 → 工具调用 → 再推理”的循环。

如何访问并使用 DeepSeek v3.2 API

简述: CometAPI 是一个 OpenAI 风格的网关,通过 https://api.cometapi.com/v1 暴露众多模型(包括 DeepSeek 系列),你可以通过在请求中更改 model 字符串来切换模型。先在 CometAPI 注册并获取你的 API 密钥。

为什么选择 CometAPI 而不是直接使用 DeepSeek?

- CometAPI 集中管理计费、限流与模型选择(如果你计划在不改代码的情况下切换提供商,这会很方便)。

- 直接的 DeepSeek 端点(例如

https://api.deepseek.com/v1)仍然存在,并且有时会提供特定于提供商的功能;选择 CometAPI 以获得便利,或选择直接供应商端点以使用供应商原生控制。在依赖前请确认哪些功能(例如 Speciale、实验性端点)可通过 CometAPI 使用。

步骤 A — 创建 CometAPI 帐号并获取 API 密钥

- 前往 CometAPI(注册/控制台)生成 API 密钥(仪表盘通常显示为

sk-...)。请妥善保管。CometAPI

步骤 B — 确认可用的确切模型名称

- 查询模型列表以确认 CometAPI 暴露的确切模型字符串(模型名可能包含变体后缀)。在硬编码名称前先使用 models 端点:

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

查找 DeepSeek 条目(例如 deepseek-v3.2 或 deepseek-v3.2-exp),并记下确切的 id。CometAPI 提供一个 /v1/models 的列表。

步骤 C — 发起基础聊天调用(curl)

将 <COMET_KEY> 和 deepseek-v3.2 替换为你确认的模型 id:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

这与 OpenAI 风格的调用模式相同——CometAPI 会转发到所选提供商。

兼容性与注意事项

- 支持在 Claude Code 环境中启用 Think Mode;

- 在命令行(CLI)中,只需输入模型名 deepseek-reasoner;

- 但目前可能不兼容 Cline、RooCode 等非标准工具;

- 建议普通任务使用非思考模式,复杂逻辑推理使用思考模式。

实践采用模式:一些示例架构

1 — 面向开发者工作流的辅助代理

- 模式:在复杂代码生成与测试创建时调用 Speciale(思考模式);内联助手使用快速聊天模式。

- 安全:对生成代码使用 CI 流水线检查与沙箱化测试执行。

- 部署:API 或在 vLLM + 多 GPU 集群上自托管以支持大上下文。

2 — 面向法务/金融团队的文档分析

- 模式:使用 V3.2 的 DSA 长上下文优化处理长合同,并产出结构化摘要与行动清单。

- 安全:下游决策需由人类律师签署;在发送到托管端点前进行 PII 脱敏。

- 部署:API 或内网推理服务,配合审计与日志。

3 — 自主数据管道编排器

- 模式:思考模式用于规划多步 ETL 任务,调用工具查询数据库并执行验证测试。

- 安全:在任何不可逆操作之前(例如破坏性数据库写入)实施动作确认与可验证检查。

上述每种模式在 V3.2 系列模型上都可行,但你必须将模型与验证工具及保守的治理相配套。

如何优化 v3.2 的成本与性能?

有策略地使用双模式

- 微交互用快速模式:在短检索、格式转换或直接 API 调用且重视时延的场景中使用非思考工具模式。

- 规划与验证用思考模式:将复杂任务、多动作代理或安全敏感决策路由到思考模式。捕获中间步骤,并在执行关键动作前进行(自动或人工)验证。

我该选择哪个模型变体?

- deepseek-v3.2 —— 面向通用代理任务的平衡型生产模型。

- deepseek-v3.2-Speciale —— 专门的重推理变体;可能初期仅通过 API 提供,在你需要最佳推理/基准表现且接受潜在更高成本时使用。

实用的成本控制与技巧

- 提示工程:保持系统指令简洁,避免发送冗余上下文。显式系统指令:使用声明模式意图的系统提示,例如:“You are in THINKING mode — list your plan before calling tools.” 对工具模式,加入约束如:“When interacting with the calculator API, only output JSON with the following fields.”

- 分片 + 检索增强:使用外部检索器,仅发送与每个用户问题最相关的片段。

- 温度与采样:工具交互时降低温度以提高确定性;在探索或创意任务中提高温度。

基准测试与度量

- 在验证前将输出视为不可信:即便推理输出也可能不正确。在执行不可逆操作前加入确定性检查(单元测试、类型检查)。

- 在样本工作负载上进行 A/B 测试(时延、token 使用量、正确性)后再决定变体。v3.2 在推理基准上报告了大幅提升,但真实应用行为取决于提示设计与输入分布。

常见问题

问:从模型获取 CoT 的推荐方式是什么?

答:使用 deepseek-reasoner 模型,或在请求中设置 thinking/thinking.type = enabled。响应会包含 reasoning_content(CoT)以及最终的 content。

问:模型在思考模式下能调用外部工具吗?

答:是的——V3.2 引入了在思考与非思考模式下使用工具的能力;模型可在内部推理过程中发出结构化的工具调用。使用 strict 模式与清晰的 JSON 架构可避免格式错误的调用。

问:启用思考模式会增加成本吗?

答:会——思考模式会输出中间 CoT token,增加 token 使用量,从而提高成本。仅在必要时启用思考模式。

问:应该使用哪个端点与基础 URL?

答:CometAPI 提供兼容 OpenAI 的端点。默认基础 URL 为 https://api.cometapi.com,主要聊天端点为 /v1/chat/completions(或根据你选择的基础 URL 使用 /chat/completions)。

问:使用工具调用需要特殊工具吗?

答:不需要——API 支持在 JSON 中声明结构化函数。你需要提供 tools 参数、工具模式(schema),并在你的应用中处理 JSON 函数生命周期:接收函数调用 JSON、执行函数,然后将结果返回给模型以继续或结束。思考模式增加了一项要求:需要在返回工具结果时一并传回 reasoning_content。

结论

DeepSeek V3.2 与 DeepSeek-V3.2-Speciale 明确推动了面向“开放、以推理为中心”的大模型,显式提供链式推理并支持代理型工具工作流。它们提供了强大的新原语(DSA、思考模式、工具使用训练),在构建可验证的代理方面带来简化——前提是你要考虑 token 成本、谨慎的状态管理与运营控制。

开发者可通过 CometAPI 访问 Deepseek v3.2 API,最新模型版本 会与官网同步更新。开始前可在 Playground 探索模型能力,并查阅 API guide 获取详细说明。访问前,请确保已登录 CometAPI 并获取 API 密钥。CometAPI 提供远低于官方的价格,帮助你完成集成。

准备好了吗?→ Free trial of deepseek v3.2 !