Google 于 2025 年 12 月 17–18 日发布了 Gemini 3 Flash,作为 Gemini 3 系列中低时延、具成本效率的成员。它在 Flash 级体量中带来 Pro 级推理,支持广泛的多模态输入(文本、图像、音频、视频),引入 thinking_level 和媒体分辨率控制,可通过 Google AI Studio、Gemini API(REST / SDKs)、Vertex AI、Gemini CLI,以及 Google Search / Gemini app 中的默认模型进行使用。

什么是 Gemini 3 Flash,以及它为何重要

Gemini 3 Flash 属于 Google 的 3 系列模型。其设计目标是在质量、成本与时延的帕累托前沿上推进:在显著更快、更便宜的同时,提供大量接近于Gemini 3 Pro的推理能力。这使其非常适合高频交互场景(聊天机器人、IDE 助手、实时智能体流程)、对时延敏感的大批量内容生成,以及需要以低开销进行多模态推理(图像 + 文本 + 音频)的应用。

关键要点:

- 明确优化于速度与低成本,同时保留强大的推理与多模态保真度(比旧版 Gemini 2.5 Pro 快三倍;保留 Gemini 3 的顶级推理能力)。

- 被定位为智能体循环与迭代式开发者工作流的“甜蜜点”(例如,代码辅助、多轮智能体)。

- 灵活性:可根据问题复杂度“调整思考时间”——对简单问题即时作答,对复杂任务会适当增加推理步骤。

技术性能与基准结果

Gemini 3 Flash 在速度、智能与成本上实现三重突破:

1) 智能体循环与多模态理解

Gemini 3 Flash 继承了 Gemini 3 家族的架构与训练改进,在多模态能力(文本、图像、视频、音频输入)与推理方面较早期的 Flash 模型显著提升。Google 将 Flash 定位为可处理文档分析(OCR + 推理)、视频摘要、图文问答、多模态编码任务等。该多模态能力与低时延的结合,是其技术卖点之一。

Google 发布的内部基准显示其在智能体编码方面表现强劲(针对智能体编码工作流的 SWE-bench Verified 约 78%),并在许多任务上接近 Pro 级推理,同时足够快以支持智能体循环与近实时工作流。

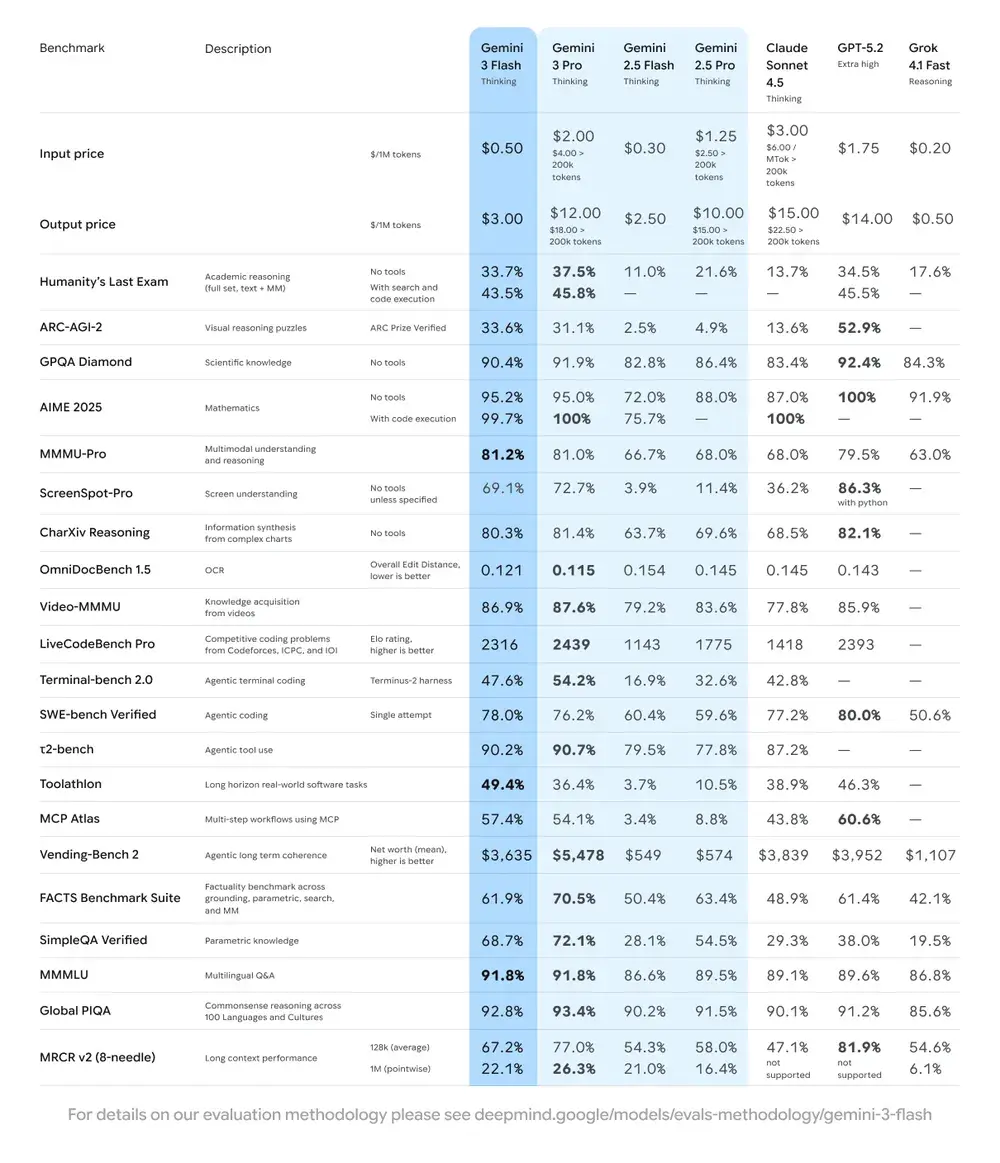

| Benchmark | Gemini 3 Flash Score | Comparison Model | Improvement |

|---|---|---|---|

| GPQA Diamond(博士级推理) | 90.4% | 优于 Gemini 2.5 Pro | 显著 |

| Humanity’s Last Exam(通用知识测试) | 33.7%(无工具) | 接近 Gemini 3 Pro | 高级推理 |

| MMMU Pro(多模态理解) | 81.2% | 与 Gemini 3 Pro 相当 | — |

| SWE-bench Verified(编码能力基准) | 78% | 高于 Gemini 3 Pro 与 2.5 系列 | 优秀 |

2) 成本与效率

Gemini 3 Flash 的研发理念是“帕累托前沿”:在速度、质量与成本之间寻求最优平衡。Gemini 3 Flash 明确为价格性能优化。Google 标注了相较于 Pro 更低的定价,并将其定位于以更低运维成本处理大规模请求。在许多工作负载上,Flash 旨在成为具成本效率的默认选项——例如,Flash 预览版的定价大约为每 1M 输入 tokens $0.50、每 1M 输出 tokens $3.00。实践中,这使其适用于高频任务,否则 Pro 更高的按 token 收费可能会令人望而却步。

效率指标

- 速度:比 Gemini 2.5 Pro 快 3 倍(基于 Artificial Analysis 测试)。

- Token 效率:完成相同任务平均少用 30% 的 tokens。换言之,用同样的钱得到更快、更好的结果。

- Gemini 3 Flash 具备“动态思考模式”——可根据任务复杂度调整推理深度:简单任务快速响应,复杂任务“多想一步”。

实际意义:更低的每 token 或每次调用成本意味着在同样预算下你可以运行更多查询、更长上下文或更高采样率。效率提升还可降低基础设施复杂度(需要的热实例更少),并改善响应时延保障。

3) 性能基准

Gemini 3 Flash 在多个学术与应用基准上实现“前沿级”表现,同时相较早期 Pro 模型提供更好的时延与成本。Google 展示了在复杂推理与知识基准(如 GPQA 变体)上的高分,以说明其能力。

我如何使用 Gemini 3 Flash API?

我应选择哪种接入方式?

- 推荐(简单且稳健):使用 Comet 展示的 SDK 集成模式——只需将现有 GenAI SDK 指向 Comet 的 base URL,并提供你的 Comet API key。这样可避免自己处理请求/流的解析。

- 备选(原始 HTTP / curl / 自定义栈):你可以直接向 CometAPI 端点发送 POST(Comet 接受 OpenAI 风格或厂商特定格式)。使用

Authorization: Bearer <sk-...>(Comet 示例使用 Bearer 头),并在请求体中指定模型字符串gemini-3-flash。请在 Comet 的 API 文档中确认目标模型的确切路径与查询参数。

快速概览 — 你需要做什么

- 在 CometAPI 注册并创建一个 API token。

- 选择一种接入方式(推荐:下面展示的 SDK 封装模式;备选:原始 HTTP/cURL)。

- 通过 CometAPI 的 base URL 调用

gemini-3-flash模型(Comet 会将你的请求路由至 Google 的 Gemini 后端)。 - 按模型要求处理流式传输 / 函数调用 / 多模态输入(详见下文)。

下面是一个简洁示例(基于 CometAPI 的样例模式)展示如何通过 CometAPI 调用 gemini-3-flash;将 <YOUR_COMETAPI_KEY> 替换为你的实际密钥。模型 ID 与端点与 CometAPI 文档一致。

from google import genaiimport os# 从 https://api.cometapi.com/console/token 获取你的 CometAPI 密钥,并在此粘贴COMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="用几句话解释 AI 的工作原理",)print(response.text)

需要关注的关键请求参数

thinking_level—— 控制内部推理深度:MINIMAL、LOW、MEDIUM、HIGH。当不需要深度多步推理时使用MINIMAL以获得最低时延与成本。media_resolution—— 用于视觉/视频输入:low、medium、high、ultra_high。较低分辨率会降低等效 token 与时延。streamGenerateContentvsgenerateContent—— 当希望接收局部结果以改善主观时延时,使用流式模式。- 函数调用 / JSON 模式 —— 当需要机器可解析输出时使用结构化响应。

发送多模态输入(实用提示)

- 图像/PDF:大型媒体优先使用云存储 URI(gs://);许多 API 对小图支持 base64。留意模态的 token 计费规则——PDF 可能按图像/文档配额计费,取决于端点。

- 视频/音频:短片段可直接传 URI;长媒体使用批处理工作流或分片流式传输。请查看 API 文档中的最大输入大小与编码限制。

- 函数调用/工具:使用结构化函数模式获取 JSON 输出,并启用安全的工具调用。Gemini 3 Flash 支持流式函数调用以改善体验。

在哪里可以访问 Gemini 3 Flash?

Gemini 3 Flash 覆盖 Google 的消费者与开发者入口:

- Google Search 与 Gemini app —— Flash 已作为 Search 中 AI 模式的默认模型,并整合至面向终端用户的 Gemini app 体验。

- Google AI Studio —— 开发者用于试验与生成测试用 API key 的首选之地。

- Gemini API(Generative Language / AI Developer API)—— 以

gemini-3-flash-preview提供(文档/发行说明中的模型 ID),并通过标准的 generateContent / streamGenerateContent 端点使用。 - Vertex AI(Google Cloud)—— 通过 Vertex AI 的生成式 AI 模型 API 提供生产级接入与适配企业工作负载的定价/配额。

- Gemini CLI —— 用于基于终端的开发与脚本工作流。

第三方网关 CometAPI

CometAPI 已将 gemini-3-flash 纳入其目录,模型页面说明了如何通过 CometAPI 的统一端点进行调用。所提供的模型 API 定价为官方价格的 20%。

使用 Gemini 3 Flash 的最佳实践是什么?

1) 按任务选择并调优 thinking_level

- 对简单问答与高频交互任务使用

MINIMAL/LOW。 - 对需要更深链式推理或多步规划的任务,选择性使用

MEDIUM/HIGH。 - 当更改

thinking_level时对成本与质量进行基准测试。Google 的文档提示,thinking_level会改变内部思考特征与时延。

2) 使用 media_resolution 控制视觉计算

如果传入图像或视频,请选择满足任务需求的最低可接受 media_resolution;例如,缩略图与批量抽取用 low,视觉设计评审用 high。这会降低图像的等效 token 并减少时延。

3) 自动化场景优先结构化输出

当你的应用需要机器可解析的输出(如实体抽取、工具调用)时,使用 JSON 模式/函数调用。这能显著简化下游处理。尽可能强制严格的 JSON 模式并在客户端进行校验。

4) 对长响应充分使用流式输出

streamGenerateContent 可降低主观时延,并允许 UI 渐进式渲染。对于长多模态任务,流式传输部分输出,让用户立即看到进度。

5) 通过缓存与上下文管理控制成本

- 对重复引用的上下文使用上下文缓存(不同模型的定价与 token 规则不同)。

- 避免在不需要时发送冗长上下文——更倾向简洁提示,并使用检索 + 贴源来处理大型知识库。

典型使用场景

海量会话型智能体

Flash 天然适合需要低时延与低推理成本的聊天机器人与客户支持助手。借助流式支持与高 tokens/sec,Flash 能降低用户的等待感与运维成本。

多模态助手与文档处理管线

由于 Flash 能良好处理图像、PDF 与短视频,常见应用包括发票信息抽取、手册的多模态问答、带图客户支持,以及 PDF 摄取用于知识库等。

实时视频分析与内容审核

据报道的高输出速度(≈218 t/s,预发布测试)可在恰当架构下支持短视频的近实时分析与摘要、亮点检测与直播内容审核管线。

智能体开发工具与代码辅助

SWE-bench 成绩与编码性能表现,使 Flash 成为快速代码助手、CLI 助手,以及其他优先考虑低时延的开发者工作流的优选。

结论 — 现在是否应该采用 Gemini 3 Flash?

对于需要在不牺牲时延与成本的前提下获得强推理与多模态智能的团队,Gemini 3 Flash 是一项战略性选择。该模型尤其适合智能体代码助手、交互式多模态智能体、文档处理管线,以及任何以低时延与规模为主要诉求的系统。早期基准(包括 Google 与独立分析)显示,Flash 在质量上具备竞争力,同时带来可观的吞吐与成本优势。

开始之前,可在 Gemini 3 Flash 的 Playground 中探索其能力,并查阅 API guide 获取详细说明。访问前请确保已登录 CometAPI 并获取 API key。CometAPI 以远低于官方的价格帮助你集成。

Ready to Go?→ Gemini 3 Flash 免费试用 !