由 AI 驱动的自动化最近激增,随之而来的是对更具动态性和上下文感知的工作流的需求。n8n 作为一款开源工作流自动化工具,已成为在无需大量编码专长的情况下编排复杂流程的强大平台。与此同时,Model Context Protocol(MCP)对 AI 代理与外部服务的交互方式进行了标准化,使其能够以一致的方式发现工具并执行操作。通过将 n8n 与 MCP 服务器集成,组织可以解锁全新的灵活性:既允许 AI 代理将 n8n 工作流作为工具调用,反过来 n8n 也能在其工作流中直接消费兼容 MCP 的服务。这种双向能力将 n8n 定位为 AI 驱动任务的生产者和消费者,简化端到端自动化,减少定制集成代码的需求。

什么是 n8n?

n8n 是一个工作流自动化平台,其特点是基于节点的、fair-code 许可模式,允许用户构建基于事件或计划触发的动作(节点)序列。它开箱即支持广泛的集成,从 HTTP 请求与数据库到消息平台与云服务。与受限的“黑盒”自动化工具不同,n8n 让开发者可以完全掌控其工作流,包括自托管以及通过社区节点或自定义代码扩展功能。

什么是 MCP?

Model Context Protocol(MCP)是一项新兴标准,定义了 AI 模型与代理如何发现、访问并编排外部工具与数据源。它提供统一的 API 表面与元数据架构,实现 AI 代理(如大型语言模型,LLM)与具备可操作能力的服务之间的无缝互操作。MCP 服务器发布工具定义与提示模板,而 MCP 客户端(通常嵌入在 AI 代理中)可以基于上下文提示请求并执行这些工具。

哪些最新更新使这种集成变得必要?

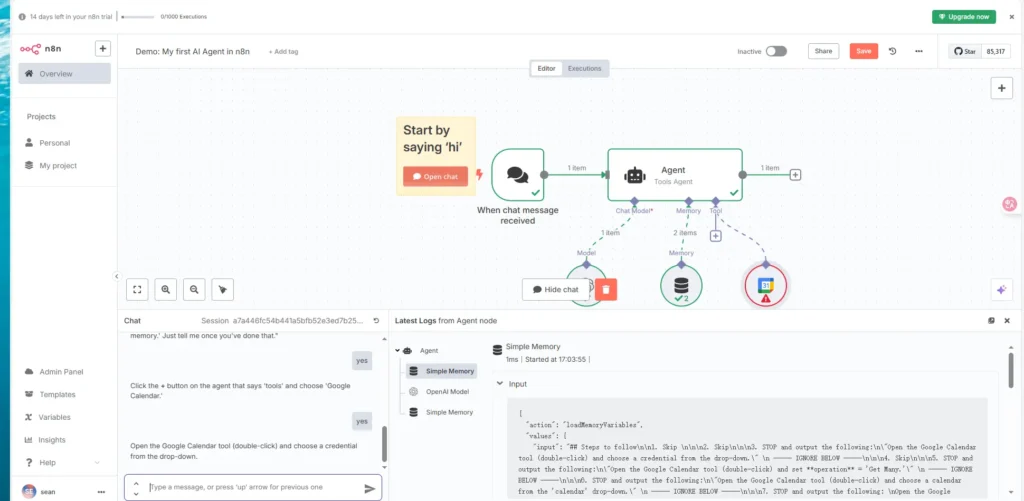

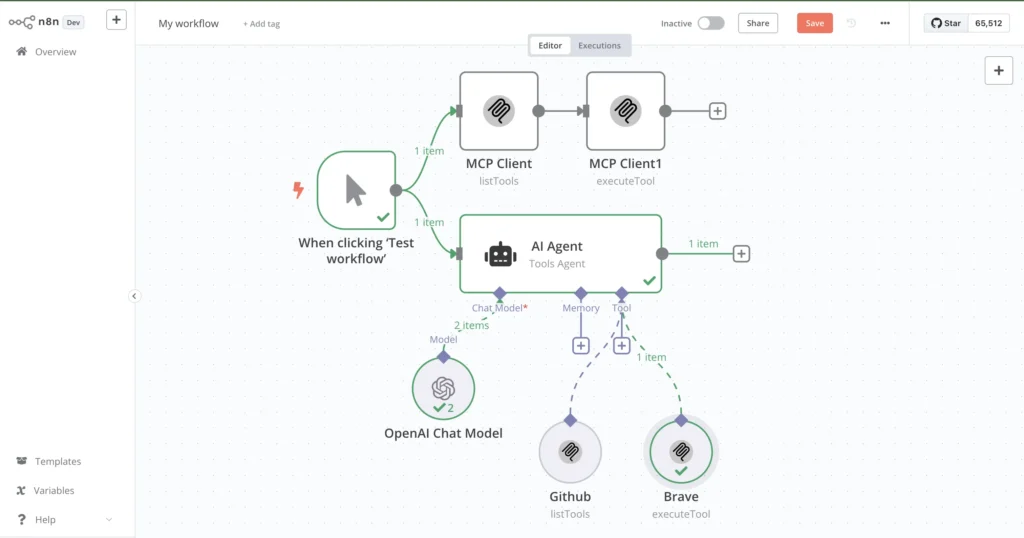

在 2025 年 2 月至 4 月期间,n8n 团队正式推出了两个关键节点:MCP Client Tool 和 MCP Server Trigger。MCP Client Tool 节点允许 n8n 工作流像调用原生节点一样调用外部 MCP 服务器,仅用一个接口即可打开 AI 驱动的功能。相反,MCP Server Trigger 节点将 n8n 工作流变为一个 MCP 服务器,使外部 AI 代理可以直接调用工作流动作。这些进展使 n8n 站在 AI 工作流自动化的前沿,降低复杂度,并支持快速构建智能自动化流水线。

如何安装与配置面向 MCP 服务器的 n8n?

在深入 MCP 集成之前,你需要一个可用的 n8n 实例。你可以在本地自托管 n8n,或通过一键安装器、Docker 容器或托管服务将其部署到云平台。

先决条件

- Node.js:推荐使用 18.17.0、20.x 或 22.x;n8n 目前不支持 Node.js 23.x。

- Git 与 npm/yarn:用于安装 n8n 与社区节点。

- Docker(可选):便于容器化部署。

- 托管环境:本地机器、VPS,或如 Zeabur 等可为 MCP 流量暴露 HTTP 端点的云服务。

安装步骤

安装 Node 版本管理器(NVM)

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

source ~/.nvm/nvm.sh

nvm install 18.17.0

nvm use 18.17.0

这可确保与你的 n8n 支持的 Node.js 版本兼容。

全局安装 n8n

npm install -g n8n

安装完成后,运行 n8n 启动 Web 界面,地址为 http://localhost:5678。

创建你的账户

首次启动时,n8n 会提示创建账户。输入邮箱与密码即可——免费社区版无需信用卡。

安装 MCP 社区节点(客户端可选)

在 n8n 的“Community Nodes”设置中搜索并安装 n8n-nodes-mcp。如果你的 n8n 版本缺少内置节点,该插件可提供增强的 MCP 客户端能力。

如何在 n8n 中设置 MCP Server Trigger 节点?

将 n8n 变成 MCP 服务器可使外部 AI 代理将工作流视作可调用的工具。按以下步骤操作:

添加 MCP Server Trigger 节点

- 新建工作流

在 n8n 编辑器中,点击“New Workflow”。 - 添加节点

在节点面板中搜索 MCP Server Trigger 并拖入工作区。 - 设置激活

配置完成后,将工作流切换为“Active”。MCP Server Trigger 节点会生成一个唯一端点,通常为/mcp/<randomId>。

配置触发器

- MCP URL Path:接受默认值或指定自定义路径(例如

/mcp/ai-tools)。 - Authentication:初次测试可选择“None”,但在生产环境中应配置 API Key、OAuth 或 JWT 验证来保护端点。

- Input Schema:定义预期的 JSON 载荷键(例如

tool、params)。n8n 将解析传入的 JSON,并自动将字段映射到后续节点。

配置完成后,对该端点(例如 http://your-domain.com/mcp/abc123)发起任何 HTTP POST 请求,均会触发工作流,使 AI 代理能够调用你所暴露的工具。

如何在 n8n 中配置 MCP Client Tool?

Server Trigger 将 n8n 暴露为工具提供方,而 MCP Client Tool 节点则让 n8n 在工作流中消费外部 MCP 服务。

安装社区节点

如果之前未安装 n8n-nodes-mcp,现在按以下步骤安装:

- 打开 Settings → Community Nodes

- 安装新节点:搜索

n8n-nodes-mcp并点击“Install” - 重启 n8n 以加载新节点

设置 MCP Client Tool

- 添加 MCP Client Tool 节点

在你的工作流中搜索 MCP Client Tool 并添加。 - 配置连接

- Server URL:输入 MCP 服务器的端点(例如你自己的 n8n MCP Trigger URL 或第三方服务)。

- Tool Name:指定服务器发布的工具标识符(例如

sendEmail、fetchData)。 - Parameters:将输入字段从上游节点或工作流变量进行映射。

- 处理响应

MCP Client Tool 节点返回结构化的 JSON 输出,你可以将其传递给后续节点,如“Set”或“HTTP Response”,用于格式化或进一步处理。

如何测试与验证你在 n8n 中的 MCP 服务器?

验证对于确保 MCP 端点与客户端集成在各种场景下可靠运行至关重要。

发送测试请求

使用 curl 或 Postman 发送示例载荷:

curl -X POST http://localhost:5678/mcp/abc123 \

-H 'Content-Type: application/json' \

-d '{"tool": "exampleTool", "params": {"message": "Hello, world!"}}'

请求成功表明 n8n 已解析该请求、执行了工作流,并返回预期结果。

调试常见问题

- 无效 JSON:确保载荷格式正确;n8n 会以 400 错误拒绝格式错误的输入。

- 身份验证失败:若使用 API Key 或 OAuth,请核验请求头与令牌配置是否正确。

- 工作流错误:使用 n8n 执行日志检查节点执行数据与错误信息。

- 网络连通性:确认 n8n 实例可从客户端环境访问,注意防火墙规则与 DNS 设置。

n8n 与 MCP 服务器的示例用例有哪些?

将 n8n 与 MCP 集成可在各领域解锁多样的自动化场景——以下是几个示例。

自动化邮件工作流

假设你希望 AI 代理按需发送可自定义邮件:

- MCP Server Trigger:暴露名为

sendEmail的工具。 - Email 节点:将触发器连接至 n8n 的“Send Email”节点(SMTP、Gmail 等)。

- 参数映射:将 MCP 载荷中的

to、subject、body映射到邮件节点的字段。

AI 代理只需通过 MCP 调用 sendEmail 工具,而无需在代理中管理 SMTP 细节。

获取与转换 API 数据

让 AI 代理能够查询并处理第三方 API:

- MCP Server Trigger:工具名为

fetchData。 - HTTP Request 节点:配置调用外部 API(例如 https://api.cometapi.com/v1/chat/completions)。

- Set 节点:格式化与筛选 API 响应。

- 返回:向客户端发送结构化 JSON。

AI 代理可以请求特定数据集,而无需处理分页、认证或限流。

构建语音 AI 代理

语音助手可将 n8n 作为后端:

- MCP Server Trigger 暴露诸如

createTask或checkCalendar等工具。 - 语音引擎将口语命令转换为 MCP 请求(例如“创建一个明天下午 3 点的会议”)。

- n8n 工作流与 Google 日历、数据库或自定义函数交互,然后向代理返回确认信息。

这种方式将语音界面逻辑与后端集成解耦,简化维护与演进。

最佳实践与安全注意事项有哪些?

面向生产的 MCP 集成需要稳健的安全性、监控与可扩展性措施。

认证与访问控制

- API Key:为每个客户端签发带细粒度范围的密钥(例如仅允许 read 或 write 操作)。

- OAuth 2.0 / JWT:在企业环境中,与身份提供商(Okta、Auth0)集成。

- 限流:使用反向代理(NGINX、Traefik)或云端 API 网关对请求进行限速,防止滥用。

可扩展性与性能

- 水平扩展:在负载均衡器后部署多个 n8n 实例以分担 MCP 流量。

- Redis / 数据库队列:将繁重或长时任务卸载到后台队列,确保 MCP 响应迅速。

- 监控:实现日志(例如 Elastic Stack)与指标(Prometheus、Grafana),以追踪工作流执行时间与错误率。

n8n 与 MCP 集成的未来展望如何?

围绕 MCP 与 n8n 的生态正在快速演进,前景可期。

即将推出的功能

- 动态工具发现:代理或可实时查询 n8n 的可用工具与元数据,进一步提升工作流灵活性。

- 增强的安全节点:在 n8n 中引入内置加密、令牌轮换与审计日志节点。

- 低代码 MCP 客户端:进一步抽象以简化 MCP 消费,无需安装自定义节点。

社区与生态增长

- MCP 工作流市场:如 n8n.io/workflows 等平台已开始列出示例 MCP 服务器模板,促进共享与复用。

- 第三方服务:云服务商与 SaaS 平台正开始发布 MCP 端点,扩展 AI 驱动自动化的覆盖范围。

- 开放标准协作:MCP 规范在积极演进中,主要 AI 与自动化厂商正贡献力量以提升互操作性。

结论

将 n8n 与 MCP 服务器集成,可将静态工作流转变为动态的、由 AI 驱动的服务,并赋能 n8n 消费外部面向 AI 的工具。最近引入的 MCP Client Tool 与 MCP Server Trigger 节点代表了重要的飞跃,简化了智能自动化流水线的开发与运维。通过遵循安装、配置、安全与测试方面的最佳实践,组织可以充分释放这一集成的潜力,更快创新、降低工程开销,并在各种用例中交付具备上下文感知的自动化。