低代码可视化 AI 工具领域发展迅速。Flowise——一个用于构建 LLM 工作流的开源可视化构建器——持续增加社区集成并频繁发布更新;CometAPI 是多家统一 AI API平台之一,如今可通过单一端点暴露数百个模型;而像 BuildShip 这样的无代码后端构建器同样提供调用 CometAPI 的节点,使你能将相同的模型接入服务器端工作流。本指南先说明为何以及何时要组合使用这些组件,然后带你完成一个具体的 Flowise → CometAPI 集成,如何连接 Prompt → LLM Chain → CometAPI,推荐的最佳实践,以及示例用例。

什么是 FlowiseAI,它为何重要?

FlowiseAI 是一个用于构建 LLM 工作流、聊天助手和智能体管道的开源可视化平台。它提供由节点(集成)组成的拖拽画布,这些节点代表提示、链、LLM 连接器、检索器、记忆、工具和输出——让团队无需手动接线即可原型化并交付由 LLM 驱动的系统。Flowise 还提供 API、追踪、评估工具以及由社区维护的节点,因此既适用于快速原型,也适用于生产实验。

为什么这很重要:使用 Flowise 你可以在提示链和模型选择上获得可视化可观测性与快速迭代能力——并且通过添加第三方连接器(如 CometAPI),你可以在仅做最小改动的情况下切换或试验多种底层模型。

什么是 CometAPI,它提供什么?

CometAPI 是一个统一的 API 层,将对数百个 AI 模型(OpenAI、Anthropic/Claude、Google/Gemini、Replicate 模型、图像与音频提供商等)的访问聚合在单一且一致的请求格式与认证方案之下。也就是说,你可以选择或切换模型、比较成本/延迟,或在不同提供商间实现程序化回退,而无需重写应用代码。该平台定位为面向 LLM 与多模态模型的成本管理与供应商无关的访问层。

这在实践中带来的好处:针对多模型评估的更简化凭据管理,快速进行不同模型的 A/B 测试,以及(通常)通过在合适场景选择更便宜的模型变体来优化成本。

为何要将 FlowiseAI 与 CometAPI 集成?

将 Flowise 与 CometAPI 集成,可将 Flowise 的可视化构建便利性与 CometAPI 面向多模型后端的集中访问结合起来。好处包括:

- 通过 CometAPI 对多个模型端点进行统一凭据管理。

- 在可视化链中轻松进行模型 A/B 测试与提供商级路由(无需更改节点连线即可切换模型)。

- 更快的试验迭代:在 Flowise 流中交换模型、调整提示并比较输出。

- 适合那些需要可视化编排层、同时又希望在幕后使用多个模型提供商的团队,减少工程摩擦。

- 为何要将 FlowiseAI 与 CometAPI 集成?

- 将 Flowise 与 CometAPI 集成,可将 Flowise 的可视化构建便利性与 CometAPI 面向多模型后端的集中访问结合起来。好处包括:

- 通过 CometAPI 对多个模型端点进行统一凭据管理。

- 在可视化链中轻松进行模型 A/B 测试与提供商级路由(无需更改节点连线即可切换模型)。

- 更快的试验迭代:在 Flowise 流中交换模型、调整提示并比较输出。

- 适合那些需要可视化编排层、同时又希望在幕后使用多个模型提供商的团队,减少工程摩擦。

- 这些能力在保留 Flowise 提供的可视化溯源与可追踪性的同时,加速 RAG 搭建、智能体编排与模型组合工作流。

这些能力在保留 Flowise 提供的可视化溯源与可追踪性的同时,加速 RAG 搭建、智能体编排与模型组合工作流。

集成前需要哪些环境与前置条件?

清单(最低要求):

- 登录 FlowiseAI

- 一个 CometAPI 账号 + API Key(从 CometAPI Console 获取)。注意:CometAPI 使用基础路径(例如

https://api.cometapi.com/v1/)进行请求——你需要在 Flowise 节点设置中提供该值。

安全与运维准备:

- 将 API Key 存储在 Flowise Credentials 中——不要把密钥放在提示模板或节点代码里。

- 规划配额与速率限制:CometAPI 与底层模型供应商都可能施加限制——检查你的套餐,并在客户端实施限流或重试。

- 关注成本:切换模型会显著改变 Token 使用量与成本——请接入度量并设置保护性阈值。

如何将 CometAPI 与 FlowiseAI 集成?(查找并添加 CometAPI 节点——具体步骤是什么?)

按照以下实操步骤添加 ChatCometAPI 节点并配置凭据。

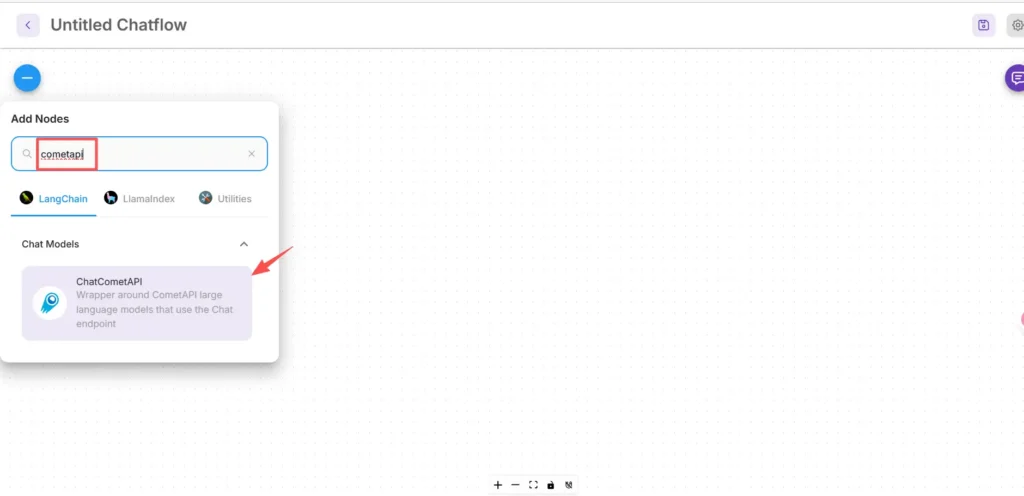

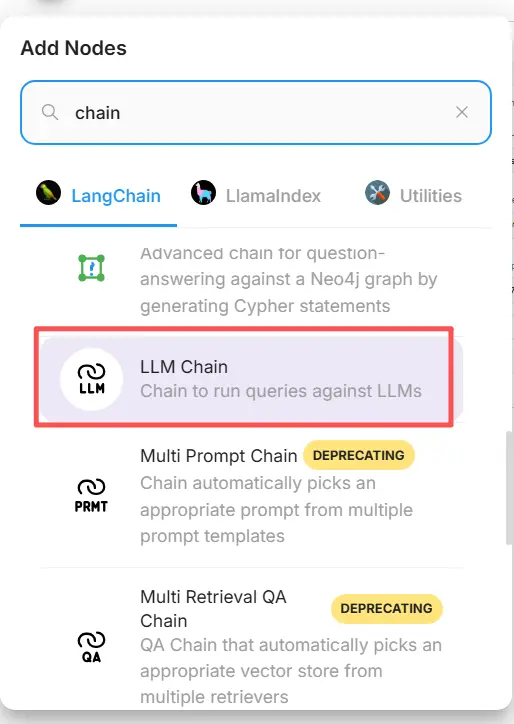

第 1 步——确认该节点可用

- 在 FlowiseAI 画布中,点击 Add new。

- 在搜索框中输入并搜索“cometapi”,找到 CometAPI 方块。有些社区节点位于 LangChain → Chat Models 下。

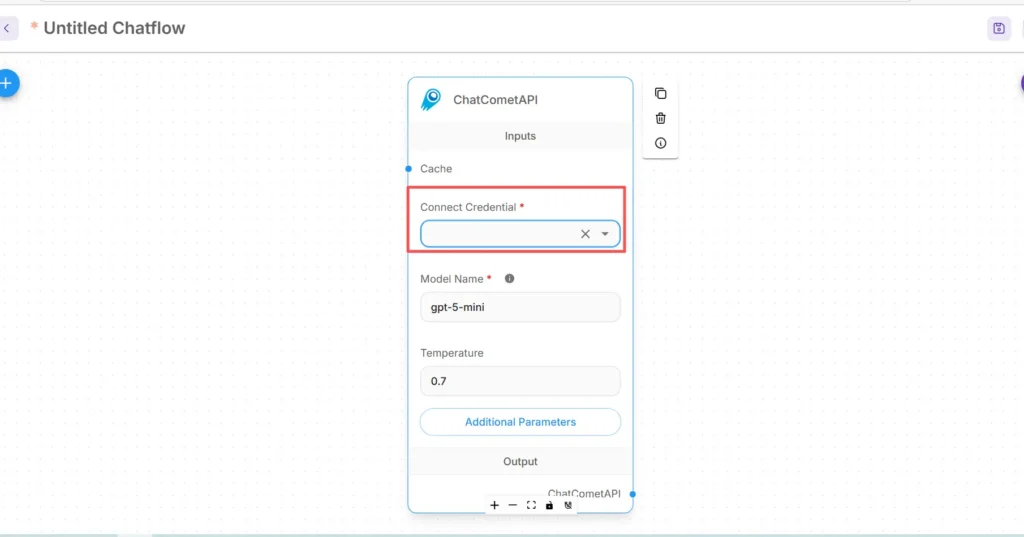

第 2 步——将 CometAPI 节点添加到你的流程中

- 将 ChatCometAPI 节点拖入工作区。该节点提供模型选择、temperature、max tokens 以及其他推理参数。

- 在 CometAPI 节点的上游放置一个 Start/Input 节点(或你的聊天机器人前置节点)。

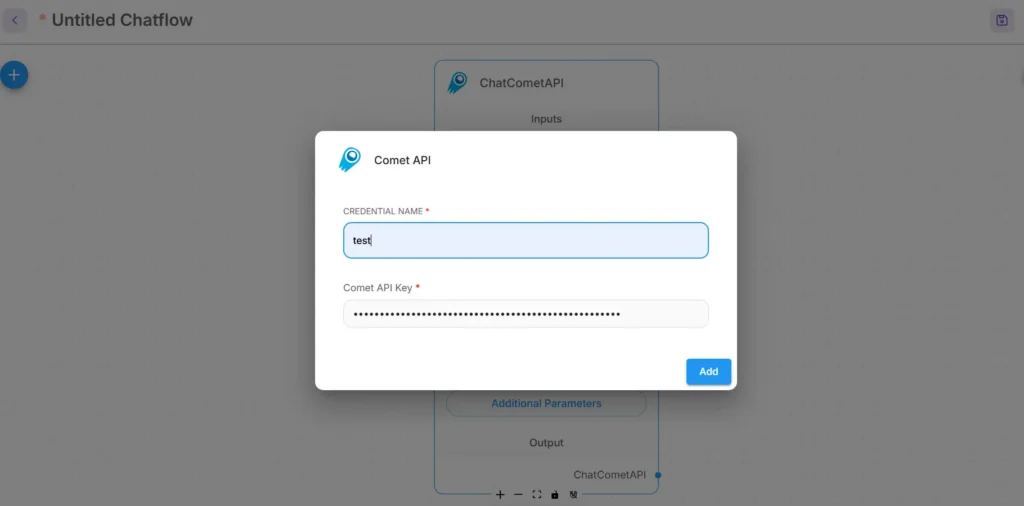

第 3 步——为 CometAPI 配置凭据

- 在 CometAPI 节点的 Connect Credential 下拉菜单中,选择 Create New 并找到 API Key / Credentials 字段。(在 Flowise 中,或打开 Credentials)

- 输入你的 CometAPI API key(最好通过 Flowise 的凭据管理器或作为环境变量提供)。在生产环境中,请使用机密管理。

- 选择默认的底层模型(或如果你希望在运行时切换模型,可保持其可由节点输入调整)。CometAPI 通常接受一个

model参数以指示使用哪个提供商/模型。

第 4 步——设置 Base Path 与其他参数

在 ChatCometAPI 节点设置中展开 Additional Parameters,并将 Base Path 设置为 https://api.cometapi.com/v1/(这能确保该节点指向 CometAPI 的 v1 网关)。可选地,调整默认模型名称或 CometAPI 支持的提供商参数。

故障排查提示:

- 如果调用失败,请检查 Flowise 与 CometAPI 端点之间的网络出口与任何防火墙/NAT 规则。

- 检查 CometAPI 返回的速率限制与错误响应;在 429/5xx 上实现指数退避。

如何在 Flowise 中添加 Prompt 节点并设置 LLM 链?

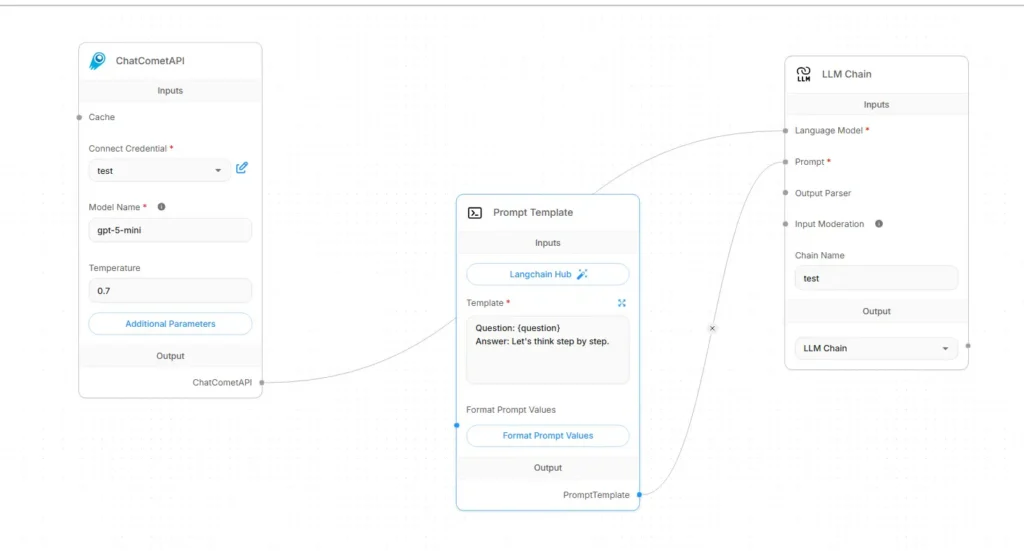

Flowise 的 LLM 流通常由 Input → Prompt Template → LLM Chain → Output 组成。下面给出以 CometAPI 作为语言模型的具体连线方法:

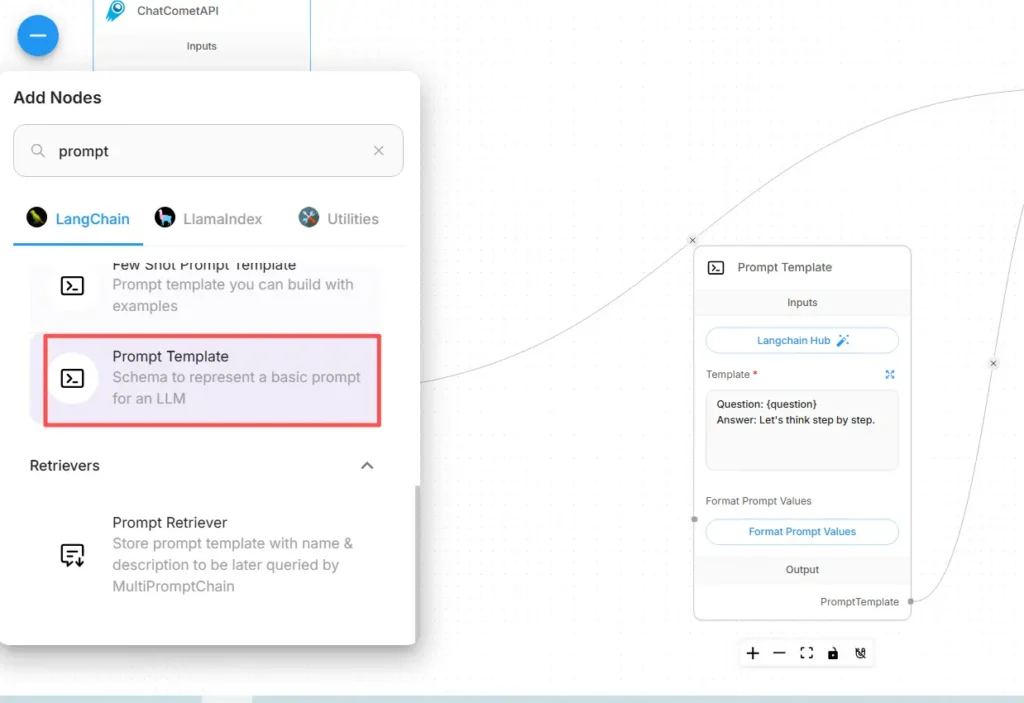

步骤 A——创建一个 Prompt Template 节点

- 向画布添加一个 Prompt Template 节点(或 “Prompt” 节点)。

- 在 Prompt 节点中,使用变量撰写你的模板,例如:

You are an expert SRE. Given the following user question: {{user_input}}

Produce a step-by-step diagnostic plan and concise summary.

- 暴露

user_input作为变量,由 Start/Input 节点传入。

步骤 B——添加一个 LLM Chain 节点(LLM 包装器)

添加一个表示 “提示 → 模型调用” 的 LLM Chain 或 LLM 节点。在 Flowise 中,LLM Chain 节点通常有两个主要输入:Language Model(模型/推理节点)与 Prompt(提示模板)。

步骤 C——连接节点(显式连线)

- 将 CometAPI 节点连接到 LLM Chain 的 Language Model 输入。

这会告诉该链用于生成的调用模型。(CometAPI 成为模型提供方。) - 将 Prompt Template 节点连接到 LLM Chain 的 Prompt 输入。

该链会将提示模板与变量值合并,并将得到的提示发送给 CometAPI。 - 将 Start/Input 节点连接到 Prompt Template 的

user_input变量。 - 将 LLM Chain 的输出连接到 Output 节点(用于 UI 响应或下游工具)。

从视觉上,流程应如下所示:

Start/Input → Prompt Template → LLM Chain (Language Model = CometAPI node) → Output

步骤 D——以试运行方式测试

- 在 Flowise 的测试控制台中运行该流程。检查发送给 CometAPI 的提示、返回的 Token、以及延迟。在 CometAPI 节点设置中调整 temperature、max tokens 或 top-p,以在创造性与确定性之间进行调优。

该集成可实现哪些实际用例?

以下是 Flowise + CometAPI 能带来实质收益的优秀用例:

1)多模型路由 / 最佳工具选择

根据子任务选择模型:用低成本模型做快速摘要,用高准确度模型做事实性支撑,用图像模型进行图像生成——这一切都可通过 CometAPI 参数实现,无需更改 Flowise 的连线。

2)模型 A/B 测试与评估

在 Flowise 中启动两条并行的 LLM Chain(A 与 B),将同一提示路由到不同的 CometAPI 模型选择,并将结果送入一个小型比较器节点对输出评分。使用指标决定采用哪个模型。

3)混合 RAG(Retriever + LLM)

使用 Flowise 的文档存储与向量检索器收集上下文,然后将合并的提示模板发送给 CometAPI 的模型。统一 API 使更换用于最终综合的 LLM 更加简单。

4)智能体工具链(API、数据库、代码)

在 Flowise 智能体中组合工具(HTTP GET/POST、数据库调用),使用 CometAPI 进行语言推理与动作选择,并将输出路由到连接器/工具。Flowise 为此支持请求工具与智能体模式。

入门

CometAPI 是一个统一 API 平台,将来自领先提供商的 500 多个 AI 模型——例如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等——聚合到一个对开发者友好的接口中。通过提供一致的认证、请求格式与响应处理,CometAPI 大幅简化了将 AI 能力集成到你的应用中的过程。无论你是在构建聊天机器人、图像生成器、音乐创作工具,还是数据驱动的分析流水线,CometAPI 都能让你更快迭代、控制成本并保持供应商无关性,同时能获取整个 AI 生态的最新突破。

开始之前,请在Playground中探索模型能力,并查阅 Flowise 的API 指南以获得详细说明。访问前,请确保已登录 CometAPI 并获取 API Key。CometAPI 提供远低于官方的价格,帮助你完成集成。

准备好了吗?→ 立即注册 CometAPI!

最终建议与总结

将 Flowise 与 CometAPI 集成,是把快速可视化编排(Flowise)与灵活访问多家模型提供商(CometAPI)结合起来的务实做法。这个模式——将提示存为模板、将模型节点解耦、并认真记录每次运行——可让团队快速迭代,并在无需重写流程的情况下切换提供商。请记得安全管理凭据,考虑延迟与成本,并对你的流程进行可观测性与治理的度量与仪表化。