Moonshot AI 作为中国 AI 版图中的新锐力量,已正式推出下一代大型语言模型 Kimi K2,基于前沿的专家混合(MoE)架构。此次发布在性能、可扩展性与效率方面实现了显著跃升,使 Moonshot AI 站在全球 AI 创新的前沿。

什么是 Kimi K2?

由 Moonshot AI(北京)于 2025 年 7 月 11 日宣布的 Kimi K2,是该公司最新且最大的开源 AI 模型——采用 Mixture‑of‑Experts(MoE)架构的超大规模模型,拥有 1 万亿参数与 32B 激活参数。公司将其定位为强调“智能体智能”的模型,专为工具调用、代码生成与自主任务执行而设计。它在代码生成、数学推理与基于知识的问答方面表现出色,并且——关键在于——对**“智能体”任务**进行了专门优化,这意味着它不仅能回答问题,还能自主完成多步骤工作流。

Moonshot 同步开源了两类软件:“Kimi‑K2‑Base”(面向研究者与开发者)与 “Kimi‑K2‑Instruct”(面向聊天与智能体应用)。API 也已上线,强调其多样性,可与传统专有模型竞争。

- Kimi‑K2‑Base:基础模型,用于研究与自定义微调。

- Kimi‑K2‑Instruct:指令微调版本,优化用于通用聊天与轻量级智能体应用。

关键能力

- 多步骤任务执行

- 代码生成与调试

- 数据分析与可视化

- 自动工具调用

- 强大的本地/私有化部署支持

Moonshot 的目标是提供一个完整的**“open‑agent”**AI 平台,使开发者与研究者能够构建可调用外部工具并主动执行复杂任务的系统。

Moonshot AI 为何推出 Kimi K2?

市场环境与竞争格局

在中国,随着 DeepSeek、Baidu、Alibaba、Tencent 等加剧竞争,Moonshot 在 2024 年曾一度在中长文本分析与搜索领域占有一席之地。然而,由于率先以低成本模型扩散的 DeepSeek 的影响,Kimi 应用的月活排名在 2025 年初从前三降至第七。

因此,为了重新获得关注,Moonshot 决定采取开源可在全球市场使用的模型策略。公司旨在在参考 Meta(LLaMA 等)所采用策略的同时,实现“性能与可达性”的兼顾。

为什么开源?

美国的主要 AI 公司(OpenAI、Google 等)倾向于以闭源方式运营其最新模型。与此同时,中国的主要参与者走上了开源路线,而 Moonshot 将延续这一趋势。开源的优势在于提升可靠性、扩展开发者生态以及强化国际品牌力。

Kimi K2 是如何设计的?

MoE 架构

“Kimi K2” 采用总参数量达 1 万亿的 MoE 结构。对每次输入,仅有 32B 子集被激活,并从 384 位专家中选择 8 位专家。这相较于总参数规模实现了极高的计算效率。

MuonClip 优化器

Moonshot 的自研技术 “MuonClip” 是一种新型优化方法,用于消除在万亿规模模型训练中存在的不稳定性问题。它避免了价值数百万美元的重训开销,同时兼顾训练稳定性与成本效率。

任务驱动的自监督

- Kimi‑K2 不仅训练于静态文本:它在模拟任务(报告撰写、代码修复、图表生成、网页创建)上进行练习。

- 它生成自身的训练样本,并使用次级评估模型为输出打分,迭代完善能力。

自主规划与工具使用

- 规划多步骤流程(例如:“按地区分析薪资 → 绘制结果 → 撰写解读”),并在每一步决定调用何种工具或 API,像紧凑型智能体一样行动。

友好的智能体部署

- 通过简单的 API 调用或本地推理即可开箱使用——无需复杂的中间件或编排管线。

全面技能集

- 代码:读/写/调试,跨文件重构,自动化测试

- 数学:代数、几何、概率、统计,接近 GPT‑4 水平

- 数据分析:表格推理、制图、交互式报告

- 网页生成:数据直出 HTML/JS/页面

- CLI 自动化:完整的终端命令支持与重试逻辑

Kimi K2 的性能如何?

基准表现

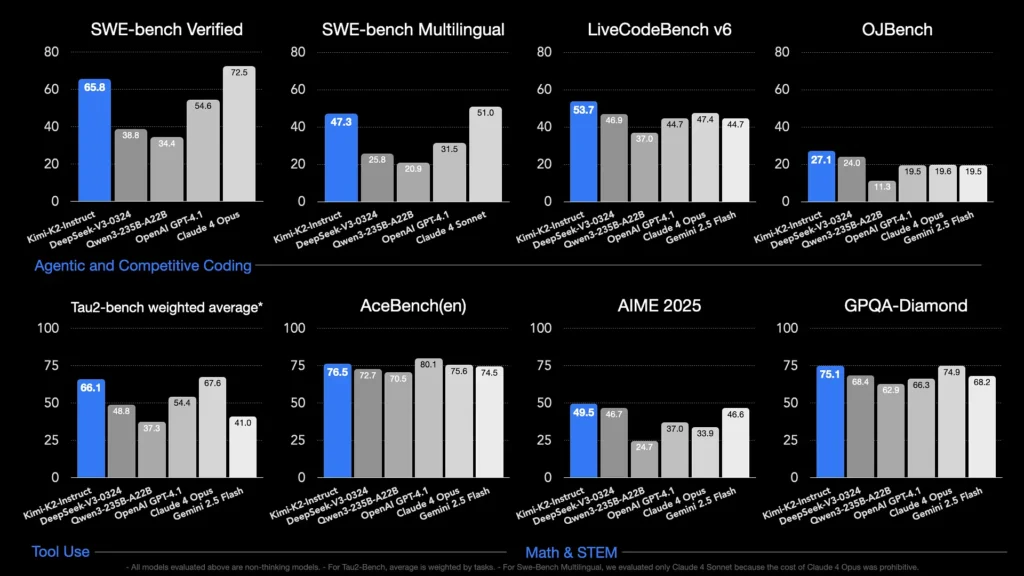

- 在多项代码基准上超越 GPT‑4.1 与 Claude Sonnet。

- 能读取、修改与调试多文件代码库;可自动移植项目(例如 Flask → Rust)或生成完整的 Web 应用。

此外,它在 MATH‑500(数学基准)中取得了 97.4% 的极高得分,并在“基于智能体”的工具使用基准中展示了优势。

性能与价格的平衡

Moonshot 在定价上参考了 OpenAI 与 Anthropic,API 使用费为每 1M 输入 Token 0.15 美元、每个输出 Token 2.50 美元。其以低成本高性能的策略吸引企业客户。

如何使用 Kimi K2?

用法

- 在自有环境中托管开源模型(Base/Instruct)。* 通过API使用兼容 OpenAI/Anthropic 的协议从应用调用。

模型检查点已发布于 Hugging Face 等站点。推荐 vLLM、SGLang、KTransformers 与 TensorRT‑LLM 作为推理引擎。

简单使用示例

聊天补全(Instruct 模型示例):

client.chat.completions.create(

model="kimi-k2-instruct",

messages=[{"role":"system","content":"You are Kimi..."},

{"role":"user","content":"Introduce yourself"}],

temperature=0.6,

max_tokens=256

)

工具调用也可行:

tools=

client.chat.completions.create(..., tools=tools, tool_choice="auto")

上述配置允许在对话中自主使用工具。

哪里可以获取 Kimi K2?

- 可从 GitHub 仓库获取模型与代码。

- 也可通过 API 在 Moonshot 平台上使用。

- 还提供对 Hugging Face 等外部基础设施的封装,便于构建先进的开发环境。

Kimi K2 的费用是多少?

API 价格:

- 每 1 M 输入 Token 0.15 美元(cache hit)

- 每 1 M 输入 Token 0.60 美元(cache miss)

- 每 1 M 输出 Token 2.50 美元

自托管免费,但需要服务器与 GPU 成本。通过选择推理引擎可优化成本。

竞争环境:相较 OpenAI 与 Anthropic,定价强调在性能与价格上的优势。

引入 Kimi K2 将带来哪些变化?

1. 成本效率型大规模 AI 的扩散

抑制巨大训练成本的 MuonClip 可能使普通用户与中小企业也能掌控 MoE 大规模模型。

2. 通过生态扩张提升质量

开源使全球研究者与开发者得以参与并推进应用与改进。目标是在共享数据集、分叉与社区的推动下实现累积式质量提升。

3. 应用向社会落地扩展

Kimi K2‑Instruct 的“智能体”功能为可用于聊天与搜索之外的自动化、报告生成、软件开发辅助等高实用性 AI 工具铺平道路。

入门指南

CometAPI 是一个统一的 API 平台,聚合了 500+ 来自领先提供商的 AI 模型——例如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等——并以单一、对开发者友好的接口提供。通过一致的认证、请求格式与响应处理,CometAPI 大幅简化将 AI 能力集成到应用中的过程。无论你在构建聊天机器人、图像生成器、音乐合成器,还是数据驱动的分析管线,CometAPI 都能让你更快迭代、控制成本、保持供应商中立,同时获取整个 AI 生态的最新突破。

开发者可通过 CometAPI 访问 Kimi K2 API(kimi-k2-0711-preview)。开始之前,可在 Playground 探索模型能力,并参考 API 指南 获取详细说明。访问前请确保已登录 CometAPI 并获得 API Key。CometAPI 提供远低于官方价格的方案,助你集成落地。

总结:Kimi K2 是否是 AI 新纪元的象征?

Moonshot AI 的 “Kimi K2” 将下一代 AI 的关键要素——开源、大规模 MoE、具成本效率的训练与智能体化——合而为一。尤其值得注意的是,它在代码生成、数学与工具集成任务中表现优异,同时能以低价格广泛分发。

这一策略不仅仅是技术披露,更有潜力促进研究者、开发者与企业之间的对话与协作,并成为开源 AI 的标准。它也可能为 Moonshot AI 以及中国企业整体在国际竞争中重新取得优势提供契机。