Qwen3-Max-Preview 是 Qwen3 系列中 Alibaba 最新的旗舰预览模型——一款拥有万亿级以上参数、采用 Mixture-of-Experts(MoE)风格的模型,具备超长 262k token 上下文窗口,以预览形式面向企业/云使用发布。其定位于 *深度推理、长文档理解、编码,以及智能代理型工作流。

基本信息与核心特性

- 名称 / 标签:

qwen3-max-preview(Instruct)。 - 规模: 超过 1 万亿参数(万亿参数旗舰)。这是本次发布的关键市场/统计里程碑。

- 上下文窗口: 262,144 tokens(支持超长输入和多文件转录)。

- 模式: 指令微调的“Instruct”变体,在 Qwen3 系列中支持 thinking(深思熟虑的链式思维)和 non-thinking 快速模式。

- 可用性: 通过 Qwen Chat、Alibaba Cloud Model Studio(兼容 OpenAI 或 DashScope 端点)以及 CometAPI 等路由提供商提供预览访问。

技术细节(架构与模式)

- 架构: Qwen3-Max 延续 Qwen3 的设计谱系,在更大规模变体中采用 稠密 + Mixture-of-Experts(MoE) 组件组合,并通过工程优化提升超大参数量下的推理效率。

- 思考模式 vs 非思考模式: Qwen3 系列引入了 思考模式(用于多步链式思维风格输出)与 非思考模式(更快、更简洁的回复);平台提供参数以切换这些行为。

- 上下文缓存 / 性能特性: Model Studio 列出了针对大请求的 context cache 支持,以减少重复输入成本并提升在重复上下文场景下的吞吐。

基准测试表现

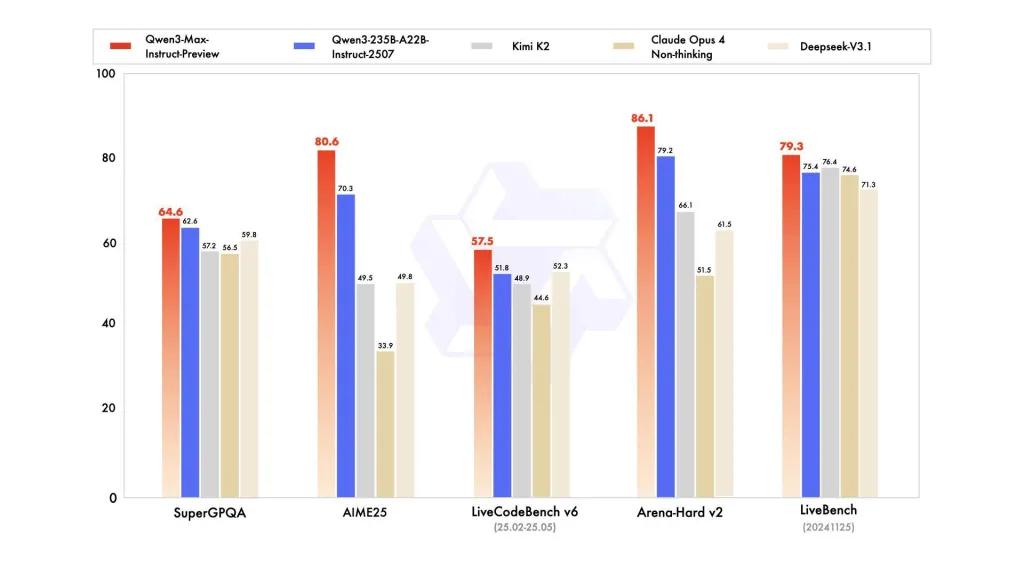

报告引用了 SuperGPQA、LiveCodeBench 的变体、AIME25 以及其他竞赛/基准套件,在这些评测中 Qwen3-Max 具有竞争力或处于领先。

限制与风险(实践与安全提示)

- 完整训练配方/权重的不透明性: 作为预览版本,其完整训练/数据/权重发布与可复现材料相较早期开放权重的 Qwen3 版本可能较为有限。尽管 Qwen3 家族中部分模型以开放权重发布,Qwen3-Max 以受控预览形式通过云交付。这会对独立研究者的可复现性形成一定限制。

- 幻觉与事实性: 厂商报告称幻觉有所降低,但在真实使用中仍会出现事实错误与过度自信的断言——属于大型语言模型的常见注意事项。高风险部署前需进行独立评估。

- 规模成本: 由于上下文窗口巨大且能力强,面对超长提示或生产级吞吐时 token 成本 可能很高。建议使用缓存、分块与预算控制。

- 监管与数据主权考虑: 企业用户在处理敏感信息前应核查 Alibaba Cloud 所在区域、数据驻留与合规影响。(Model Studio 文档包含特定区域端点与说明。)

适用场景

- 大规模文档理解/摘要: 法律文书、技术规范与多文件知识库(优势:262K token 窗口)。

- 长上下文代码推理与仓库级代码辅助: 多文件代码理解、大型 PR 审阅、仓库级重构建议。

- 复杂推理与链式思维任务: 数学竞赛、多步规划、需要“思考”轨迹以增强可追溯性的智能代理型工作流。

- 多语言、企业级问答与结构化数据抽取: 支持大规模多语言语料与结构化输出能力(JSON / 表格)。

如何通过 CometAPI 调用 Qqwen3-max-preview API

qwen3-max-preview API 在 CometAPI 中的定价,较官方价优惠 20%:

| 输入 Tokens | $0.24 |

| 输出 Tokens | $2.42 |

必要步骤

- 登录 cometapi.com。如果您还不是我们的用户,请先注册

- 获取接口访问凭证 API key。点击个人中心的 API token 处“Add Token”,获得令牌密钥:sk-xxxxx 并提交。

- 获取本站点的 url:https://api.cometapi.com/

使用方法

- 选择 “qwen3-max-preview” 端点发送 API 请求并设置请求体。请求方法与请求体可从我们网站 API 文档获取。我们的网站也提供 Apifox 测试,方便使用。

- 将 <YOUR_API_KEY> 替换为您账户中的实际 CometAPI 密钥。

- 将您的问题或请求插入 content 字段——模型将对其作出响应。

- . 处理 API 响应以获取生成的答案。

API 调用

CometAPI 提供完全兼容的 REST API——实现无缝迁移。关键细节参见 API doc:

- 核心参数:

prompt,max_tokens_to_sample,temperature,stop_sequences - 端点:

https://api.cometapi.com/v1/chat/completions - 模型参数: qwen3-max-preview

- 认证:

Bearer YOUR_CometAPI_API_KEY - Content-Type:

application/json。

将

CometAPI_API_KEY替换为您的密钥;注意 基础 URL。

Python (requests) — 兼容 OpenAI

import os, requests

API_KEY = os.getenv("CometAPI_API_KEY")

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": f"Bearer {API_KEY}", "Content-Type": "application/json"}

payload = {

"model": "qwen3-max-preview",

"messages": [

{"role":"system","content":"You are a concise assistant."},

{"role":"user","content":"Explain the pros and cons of using an MoE model for summarization."}

],

"max_tokens": 512,

"temperature": 0.1,

"enable_thinking": True

}

resp = requests.post(url, headers=headers, json=payload)

print(resp.status_code, resp.json())

提示: 在发送非常大的上下文时,请使用 max_input_tokens、max_output_tokens 以及 Model Studio 的 context cache 功能,以控制成本和吞吐量。

另见 Qwen3-Coder