Kimi K2 在开源大型语言模型领域实现了显著跃升,将最先进的专家混合架构与面向代理任务的专项训练相结合。下文将探讨其来源、设计、性能,以及获取与使用的实践要点。

什么是 Kimi K2?

Kimi K2 是由 Moonshot AI 开发的万亿参数专家混合(MoE)语言模型。它具有 320 亿“激活”参数——即每个 token 实际参与的参数——总专家参数规模达 1 万亿,在不线性增加推理成本的前提下提供海量能力。基于 Muon 优化器,Kimi K2 在超过 15.5 万亿个 token 上进行训练,在此前被认为不切实际的规模上实现了稳定性。该模型提供两个主要变体:

Kimi‑K2‑Instruct: 预调优用于对话与代理型应用,可即刻部署于对话系统与工具驱动的工作流。

Kimi‑K2‑Base: 适用于研究、定制微调与底层实验的基础模型。

其架构如何工作?

- 专家混合(MoE): 在每一层通过门控机制为每个 token 选择一小部分专家(384 个专家中选择 8 个)进行处理,在保持庞大知识库的同时显著降低推理计算量。

- 专用层: 在总计 61 层中引入单个稠密层,配备 64 个注意力头,隐藏维度为 MoE 效率进行定制。

- 上下文与词表: 支持最长 128 K 的上下文长度与 160 K 的词表规模,能够进行长文本理解与生成。

为什么 Kimi K2 很重要?

Kimi K2 将开源 AI 的边界进一步推进,其性能可与领先的闭源模型比肩,尤其在编程与推理基准上表现突出。

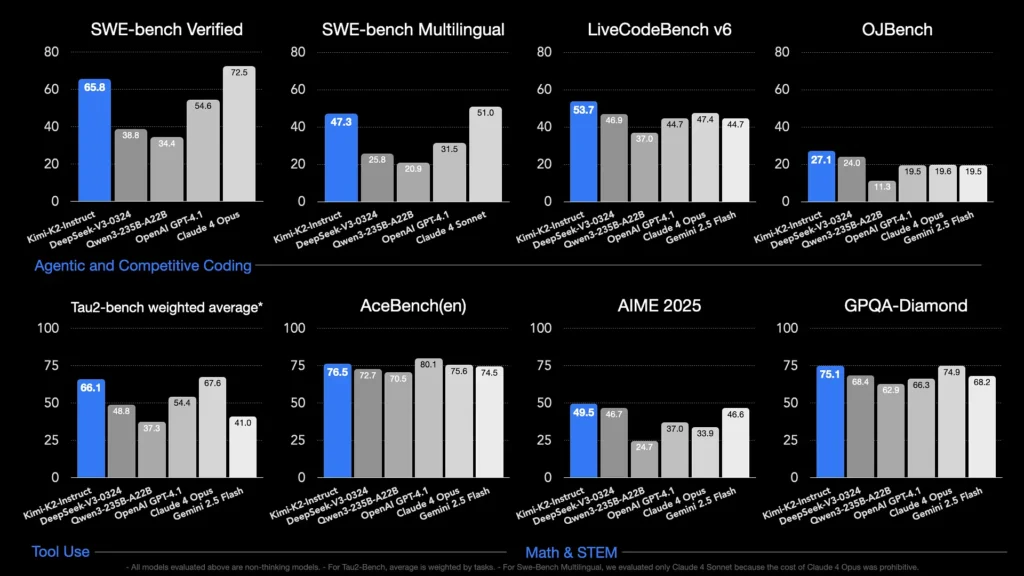

哪些基准展示了其能力?

- LiveCodeBench v6:pass@1 达到 53.7%,领跑开源模型,并可与 GPT‑4.1(44.7%)等闭源系统相抗衡。

- SWE‑bench Verified:得分 65.8%,优于 GPT‑4.1 的 54.6%,在公开对比测试中仅次于 Claude Sonnet 4。

- MultiPL‑E 与 OJBench:展现出强大的多语言编程能力(MultiPL‑E 上为 85.7%),并在真实世界的编程挑战中表现稳健。

- Math-500:达到 97.4%,超过 GPT‑4.1 的 92.4%,展现其在形式化数学推理上的实力。

它如何针对代理型任务进行优化?

除了纯文本生成之外,Kimi K2 还通过合成的工具使用场景——Model Context Protocol(MCP)数据——进行训练,以调用外部工具、推理多步流程并自主解决问题。这使其在诸如 Cline 等环境中格外得心应手,能够无缝编排代码执行、API 交互与工作流自动化。

我如何获取 Kimi K2?

访问方式涵盖官方平台、开源分发与第三方集成,满足研究、开发与企业需求。

Moonshot AI 官方平台

Moonshot AI 通过其平台提供托管推理,面向 Kimi‑K2‑Base 与 Kimi‑K2‑Instruct 两个变体提供低延迟 API 访问。定价基于算力消耗分级,企业方案包含优先支持与本地部署。用户可在 Moonshot AI 官网注册并获取 API 密钥以立即集成。

CometAPI

CometAPI 已将 K2 集成到其产品中。它将 K2 推理与托管 GPU 基础设施、SLA 保证及可扩展的定价层级打包提供,使组织能够在按需付费的 API 使用与带批量折扣的预留算力之间进行选择。

CometAPI 是一个统一的 API 平台,将来自领先供应商的 500 多个 AI 模型——如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等——聚合到一个对开发者友好的接口之中。通过提供一致的认证、请求格式与响应处理,CometAPI 大幅简化将 AI 能力集成到应用中的过程。

开发者可以通过 CometAPI 访问 Kimi K2 API(kimi-k2-0711-preview)。要开始,请在 Playground 探索模型能力,并查阅详细说明的 API 指南。在访问之前,请确保已登录 CometAPI 并获取 API 密钥。

第三方工具集成

- Cline: 一款广受欢迎的代码中心型 IDE,通过

cline:moonshotai/kimi-k2提供商原生支持 Kimi K2,使开发者在编辑器内一键使用聊天、代码生成与代理型工作流。 - Hugging Face Spaces: 社区托管的演示与极简界面,让用户可在浏览器中直接与 K2‑Instruct 模型交互。需要 Hugging Face 账号,性能可能随共享后端资源而变化。

我该如何使用 Kimi K2?

一旦选择了访问方式,您便可将 K2 用于多种任务——从聊天到代码执行,再到自主代理。

通过 API 或平台 SDK

- 认证: 从 Moonshot AI 或 CometAPI 获取您的 API 密钥。

- 初始化客户端: 使用官方 SDK(Python/JavaScript)或标准 HTTP 请求。

- 选择模型变体:

- Kimi‑K2‑Base 用于微调与研究。

- Kimi‑K2‑Instruct 用于即插即用的聊天与代理。

- CometAPI 的模型:

kimi-k2-0711-preview

- 发送提示词: 按聊天模板(system、user、assistant 角色)格式化输入,以利用优化的指令遵循行为。

使用 llama.cpp 本地运行

对于离线或自托管方案,可使用 Unsloth 量化的 GGUF 权重(1.8 位动态量化为 245 GB)。

- 下载权重: 从 Moonshot AI 的 GitHub 或 Hugging Face 仓库。

- 安装 llama.cpp: 确保拥有足够的磁盘(≥ 250 GB)以及合计 RAM+VRAM(≥ 250 GB),以获得约 5 tokens/s 的吞吐。

- 启动模型:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - 调整设置: 使用 Unsloth 指南中记录的推荐参数(

rope_freq_base、context_len)以获得稳定性能。

与开发工具的集成

- IDE 插件: 多个社区插件在 VS Code、Neovim 与 JetBrains 系列 IDE 中启用 K2。配置通常需要在设置中指定 API 端点与模型 ID。

- 自动化框架: 结合 LangChain 或 Haystack 等框架利用 K2 的代理核心,将提示词、API 调用与代码执行步骤串联为复杂自动化。

Kimi K2 的典型用例是什么?

规模、代理训练与开放获取的组合使 K2 在各个领域都具备高度通用性。

编码辅助

从样板代码生成与重构,到缺陷修复与性能剖析,K2 的 SOTA 编码基准转化为切实的生产率提升——在可读性与简洁性方面常常胜过替代方案。

知识与推理

凭借 128 K 上下文长度,K2 能处理长文档、多文档问答与链式思维推理。其 MoE 架构确保保留多样化知识而不发生灾难性遗忘。

代理型工作流

K2 擅长编排多步任务——获取数据、调用 API、更新代码库与汇总结果——非常适合用于客服、数据分析与 DevOps 等领域的自主助手。

Kimi K2 与其他开源模型如何比较?

尽管 DeepSeek 的 V3 与 Meta 近期的开源发布在 2025 年早期占据了头条,Kimi K2 通过以下方面实现差异化:

代理智能

Kimi K2 明确面向“代理型”工作流设计——通过工具调用、Shell 命令、网页自动化与 API 集成来自动化任务。其自博弈增强的训练数据集包含多样的工具调用示例,使其能够与真实世界系统无缝集成。

成本效率

与 Claude Sonnet 4 等模型相比,其每 token 推理成本约低 80–90%,Kimi K2 以非天价提供企业级性能,促使对价格敏感的开发者迅速采用。

许可与可得性

不同于某些受限许可约束的开源发布,Kimi K2 采用宽松许可,允许商业使用、衍生作品与本地部署,契合 Moonshot AI 的开源理念。

—

通过将前沿的 MoE 设计、严谨的代理训练与开源可用性融为一体,Kimi K2 赋能开发者与研究者构建智能、自主的应用,而无需承担高昂成本或受限于封闭生态。无论您是在编写代码、打造复杂的多步工作流,还是进行大规模推理实验,K2 都提供了多用途且高性能的基础。