在“scale-at-all-costs”哲学主导的版图中——诸如 Flux.2 和 Hunyuan-Image-3.0 等模型将参数规模推进到庞大的 30B 至 80B——一个新的竞争者出现,打破现状。Z-Image 由阿里巴巴的通义实验室开发,现已正式发布,以精巧的 60 亿参数架构在消费级硬件上运行,同时在输出质量上媲美行业巨头,颠覆了人们的预期。

Z-Image 于 2025 年末发布,其极速变体 Z-Image-Turbo 一同亮相,瞬间吸引了 AI 社区的关注,上线 24 小时内下载量超过 500,000 次。凭借仅 8 次推理步骤 即可生成照片级逼真图像,Z-Image 不是又一个模型,而是生成式 AI 的普惠力量,让那些在竞品面前“卡住”的笔记本也能进行高保真创作。

什么是 Z-Image?

Z-Image 是由 Tongyi-MAI / Alibaba Tongyi Lab 研究团队开发的全新开源图像生成基础模型。它是一款拥有 60 亿参数的生成模型,采用新型 Scalable Single-Stream Diffusion Transformer (S3-DiT) 架构,将文本 token、视觉语义 token 与 VAE token 连接为单一处理流。其设计目标非常明确:在显著降低推理成本、适配消费级硬件的同时,提供顶级的照片级写实与指令服从性。Z-Image 项目在 Apache-2.0 许可下发布代码、模型权重和在线演示。

Z-Image 提供多个变体。其中讨论最广的是 Z-Image-Turbo ——面向部署优化的蒸馏少步版本;此外还有未蒸馏的 Z-Image-Base(基础检查点,更适合微调)以及 Z-Image-Edit(针对图像编辑进行指令微调)。

“Turbo”的优势:8 步推理

旗舰变体 Z-Image-Turbo 采用一种名为 Decoupled-DMD(Distribution Matching Distillation) 的渐进式蒸馏技术。该方法将生成过程从标准的 30–50 步压缩到仅 8 步。

结果: 在企业级 GPU(H800)上实现亚秒级生成,在消费级显卡(RTX 4090)上几乎实时,且没有其他 turbo/lightning 模型常见的“塑料感”或“泛白感”。

Z-Image 的 4 项关键特性

Z-Image 配备了面向技术开发者与创意专业人士的丰富能力。

1. 无与伦比的写实度与美学

尽管仅有 60 亿参数,Z-Image 生成的图像清晰惊人。它擅长:

- 皮肤质感: 在人物主体上复刻毛孔、瑕疵与自然光照。

- 材料物理: 精确渲染玻璃、金属与织物纹理。

- 光照: 在电影感与体积光的处理上优于 SDXL。

2. 原生双语文本渲染

文本渲染一直是 AI 图像生成的痛点。Z-Image 原生支持 英语与中文。

- 它能够生成复杂的海报、徽标与标识牌,并在两种语言中保证拼写与书法的正确性——这一特性在许多以西方为中心的模型中并不常见。

3. Z-Image-Edit:基于指令的编辑

团队同时发布了 Z-Image-Edit。该变体针对图像到图像任务进行微调,允许用户用自然语言指令修改现有图像(例如:“让这个人微笑”、“将背景改为雪山”)。在这些变换中它能够很好地保持身份与光照的一致性。

4. 面向消费级硬件的可达性

- 显存效率: 在 6GB VRAM(量化)到 16GB VRAM(全精度)范围内舒适运行。

- 本地执行: 通过 ComfyUI 与

diffusers完全支持本地部署,无需依赖云端。

Z-Image 如何工作?

单流扩散 Transformer(S3-DiT)

Z-Image 摒弃经典的双流设计(分别使用文本与图像编码器/流),而是将文本 token、图像 VAE token 与视觉语义 token 拼接为单一 transformer 输入。该 单流 方法改善了参数利用率,并简化了在 transformer 骨干中的跨模态对齐。作者表示,这为 6B 模型带来了更优的效率/质量权衡。

Decoupled-DMD 与 DMDR(蒸馏 + 强化学习)

为在少步(8 步)生成中避免常见的质量损失,团队提出了 Decoupled-DMD 蒸馏方法。该技术将 CFG(classifier-free guidance)增强与分布匹配分离,使二者可独立优化。随后应用后训练的强化学习步骤(DMDR)进一步优化语义对齐与美学。二者结合,令 Z-Image-Turbo 在远少于典型扩散模型的 NFE 条件下仍保持高度写实。

训练吞吐与成本优化

Z-Image 采用生命周期优化方法进行训练:精心策划的数据管线、精简的课程策略与面向效率的实现选择。作者报告完整训练流程约耗费 314K H800 GPU 小时(≈ USD $630K) ——这是一个明确且可复现的工程指标,相较于超大规模(>20B)的替代方案更加经济。

Z-Image 模型的基准结果

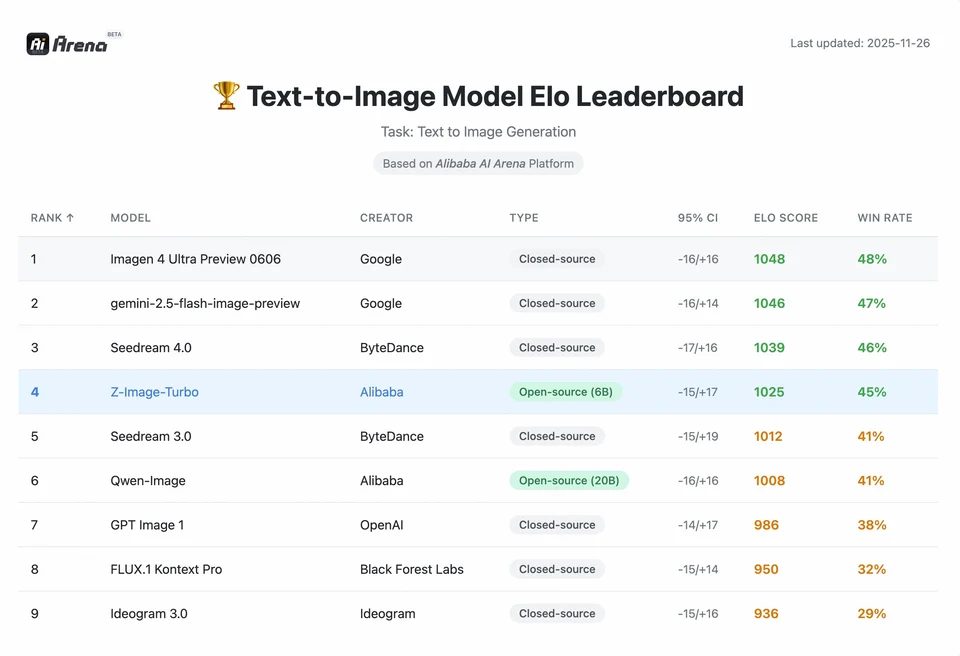

Z-Image-Turbo 在多项当代榜单上名列前茅,包括在 Artificial Analysis Text-to-Image 排行榜上的开源名次以及在 Alibaba AI Arena 人类偏好评测中的强势表现。

但真实世界的质量也取决于提示词设计、分辨率、放大管线与额外后处理。

要理解 Z-Image 的成就幅度,我们需要看数据。下面是 Z-Image 与主流开源/专有模型的对比分析。

基准对比摘要

| 特性 / 指标 | Z-Image-Turbo | Flux.2 (Dev/Pro) | SDXL Turbo | Hunyuan-Image |

|---|---|---|---|---|

| 架构 | S3-DiT(单流) | MM-DiT(双流) | U-Net | Diffusion Transformer |

| 参数量 | 6 Billion | 12B / 32B | 2.6B / 6.6B | ~30B+ |

| 推理步数 | 8 Steps | 25 - 50 Steps | 1 - 4 Steps | 30 - 50 Steps |

| 显存需求 | ~6GB - 12GB | 24GB+ | ~8GB | 24GB+ |

| 文本渲染 | 高(EN + CN) | 高(EN) | 中(EN) | 高(CN + EN) |

| 生成速度(4090) | ~1.5 - 3.0 Seconds | ~15 - 30 Seconds | ~0.5 Seconds | ~20 Seconds |

| 写实度评分 | 9.2/10 | 9.5/10 | 7.5/10 | 9.0/10 |

| 许可 | Apache 2.0 | 非商业(Dev) | OpenRAIL | Custom |

数据分析与性能洞察

- 速度 vs. 质量: 尽管 SDXL Turbo 更快(1 步),但在复杂提示词上质量显著下降。Z-Image-Turbo 在 8 步达成“甜蜜点”,匹配 Flux.2 的质量,同时 快 5 倍至 10 倍。

- 硬件普惠化: 虽然 Flux.2 功能强大,但在 24GB 显存(RTX 3090/4090)卡上表现才算理想,形成一定门槛。Z-Image 允许中端显卡(RTX 3060/4060)用户在本地生成专业级 1024x1024 图像。

开发者如何获取与使用 Z-Image?

典型路径有三种:

- 托管 / SaaS(Web UI 或 API): 使用如 z-image.ai 等服务或其他提供商部署的模型,通过 Web 界面或付费 API 进行图像生成。这是无需本地搭建即可快速试验的方式。

- Hugging Face + diffusers 管线: Hugging Face 的

diffusers库包含ZImagePipeline与ZImageImg2ImgPipeline,并提供典型的from_pretrained(...).to("cuda")工作流。这是希望简洁集成与复现实例的 Python 开发者的推荐路径。 - 从 GitHub 仓库进行本地原生推理: Tongyi-MAI 仓库提供原生推理脚本、优化选项(FlashAttention、编译、CPU offload),以及从源码安装

diffusers以获得最新集成的说明。此路径适用于希望完整掌控或进行自定义训练/微调的研究者与团队。

最小化 Python 示例是什么样的?

下面是一个使用 Hugging Face diffusers 的简洁 Python 代码段,演示用 Z-Image-Turbo 进行文生图。

# minimal_zimage_turbo.pyimport torchfrom diffusers import ZImagePipelinedef generate(prompt, output_path="zimage_output.png", height=1024, width=1024, steps=9, guidance_scale=0.0, seed=42): # Use bfloat16 where supported for efficiency on modern GPUs pipe = ZImagePipeline.from_pretrained("Tongyi-MAI/Z-Image-Turbo", torch_dtype=torch.bfloat16) pipe.to("cuda") generator = torch.Generator("cuda").manual_seed(seed) image = pipe( prompt=prompt, height=height, width=width, num_inference_steps=steps, guidance_scale=guidance_scale, generator=generator, ).images[0] image.save(output_path) print(f"Saved: {output_path}")if __name__ == "__main__": generate("A cinematic portrait of a robot painter, studio lighting, ultra detailed")

说明:guidance_scale 的默认值与推荐设置在 Turbo 模型上有所不同;文档建议根据目标行为将引导设为较低或为零。

如何在 Z-Image 上运行图像到图像(编辑)?

ZImageImg2ImgPipeline 支持图像编辑。示例:

from diffusers import ZImageImg2ImgPipelinefrom diffusers.utils import load_imageimport torchpipe = ZImageImg2ImgPipeline.from_pretrained("Tongyi-MAI/Z-Image-Turbo", torch_dtype=torch.bfloat16)pipe.to("cuda")init_image = load_image("sketch.jpg").resize((1024, 1024))prompt = "Turn this sketch into a fantasy river valley with vibrant colors"result = pipe(prompt, image=init_image, strength=0.6, num_inference_steps=9, guidance_scale=0.0, generator=torch.Generator("cuda").manual_seed(123))result.images[0].save("zimage_img2img.png")

这与官方用法模式一致,适用于创意编辑与内补(inpainting)任务。

如何编写提示词与设置引导?

- 结构要明确: 对于复杂场景,构建提示词时包含场景构图、主体、镜头/相机、光照、情绪与任何文本元素。Z-Image 从详细提示词中受益,且能很好处理位置/叙事线索。

- 仔细调优

guidance_scale: Turbo 模型常推荐较低的引导值;需要自行试验。对许多 Turbo 工作流而言,使用固定种子与步数,guidance_scale=0.0–1.0可获得稳定结果。 - 使用图像到图像进行可控编辑: 当需要保留构图而改变风格/色彩/对象时,从初始图像开始,并用

strength控制变化幅度。

最佳使用场景与实践

1. 快速原型与分镜

应用场景: 电影导演与游戏设计师需要即时可视化场景。

为什么选 Z-Image? 在不到 3 秒的生成速度下,创作者可在一次会话中迭代数百个概念,实时精炼光照与构图,而无需等待数分钟渲染。

2. 电商与广告

应用场景: 为商品生成产品背景或生活化场景图。

最佳实践: 使用 Z-Image-Edit。

上传一张原始产品照片,并用指令提示如:“将这只香水瓶放在阳光花园中的木桌上。”模型在保持产品完整性的同时,生成照片级逼真的背景。

3. 双语内容创作

应用场景: 面向全球的营销活动同时需要西方与亚洲市场的素材。

最佳实践: 利用文本渲染能力。

- 提示词: “在幽暗巷子里,一块写着‘OPEN’与‘营业中’的霓虹招牌。”

- Z-Image 将正确渲染英文与中文字符,这在大多数其他模型中并不常见。

4. 低资源环境

应用场景: 在边缘设备或普通办公笔记本上运行 AI 生成。

优化建议: 使用 INT8 量化版本 的 Z-Image。它将显存占用降至 6GB 以下,质量损失可忽略,使非游戏本地应用成为可能。

总结:谁该使用 Z-Image?

Z-Image 面向希望在 高质量写实、可接受延迟与成本 下工作,并偏好 开放许可 与本地/自托管的组织与开发者。它对需要快速迭代(创意工具、产品样机、实时服务)的团队,以及对微调紧凑但强大的图像模型感兴趣的研究者/社区成员尤为吸引。

CometAPI 提供同样限制更少的 Grok Image 模型,以及 Nano Banana Pro、GPT- image 1.5、Sora 2(Can Sora 2 generate NSFW content? How can we try it?)等——只要你掌握正确的 NSFW 技巧与方法绕过限制,即可自由创作。在访问前,请确保已登录 CometAPI 并获取 API key。CometAPI 提供远低于官方价格的方案,帮助你集成。

准备好开始了吗?→ 免费试用创作 !