2025年XNUMX月,阿里巴巴公佈 Qwen3-編碼器這是其最先進的開源 AI 模型,專為複雜的編碼工作流程和代理程式設計任務而設計。這份專業指南將逐步引導您了解所有需要了解的內容—從理解其核心功能和關鍵創新,到安裝和使用隨附的 Qwen代碼 用於自動化代理式編碼的 CLI 工具。在此過程中,您將學習最佳實踐、故障排除技巧以及如何優化提示和資源分配,以充分利用 Qwen3-Coder。

Qwen3‑Coder 是什麼?它為什麼重要?

阿里巴巴的 Qwen3-Coder 是一個擁有 480 億個參數的混合專家 (MoE) 模型,其中活躍參數達 35 億個,旨在支援大上下文編碼任務——原生支援 256K 個 token(使用外推方法可處理高達 1M 個 token)。該模型於 23 年 2025 月 XNUMX 日發布,代表了「代理 AI 編碼」領域的重大飛躍,該模型不僅可以產生程式碼,還可以自主規劃、調試和迭代複雜的程式設計挑戰,無需人工幹預。

Qwen3-Coder 與其前代產品有何不同?

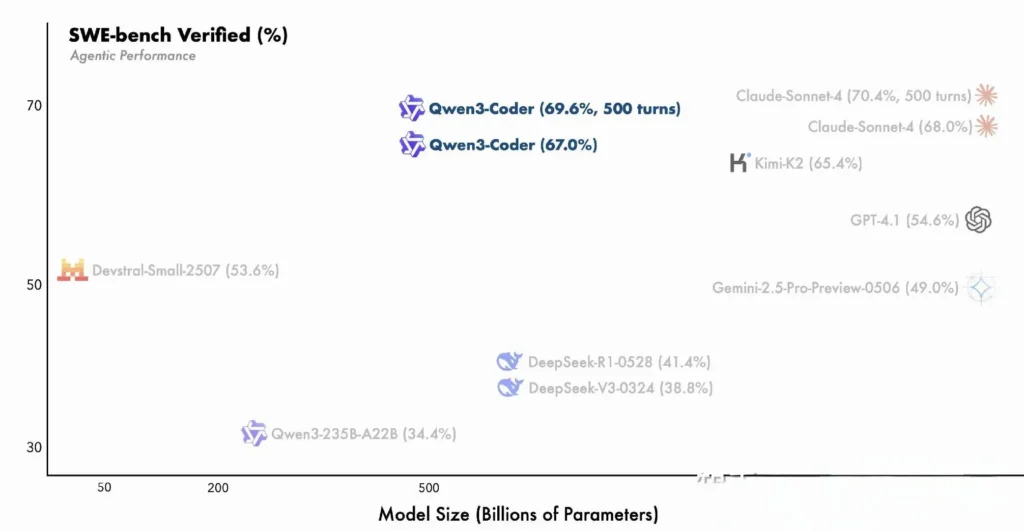

Qwen3‑Coder 以 Qwen3 系列的創新為基礎,將用於多步驟推理的「思考模式」和用於快速回應的「非思考模式」整合到一個統一的框架中,並可根據任務複雜度動態切換模式。與 Qwen2.5‑Coder 的密集運算能力和受限於較小場景不同,Qwen3‑Coder 採用稀疏的混合專家架構,在 SWE‑Bench Verified 和 CodeForces ELO 評級等基準測試中展現出卓越的效能,在關鍵編碼指標上匹敵甚至超越了 AnthropicAI 的 Claude 和 OpenAI 的 GPT‑4 等模型。

Qwen3‑Coder 的主要特點:

- 大型上下文視窗: 原生 256 K 個令牌,透過外推可達到 1 M 個,使其能夠一次處理整個程式碼庫或長文件。

- 代理能力: 專用的“代理模式”,可自主規劃、產生、測試和調試程式碼,減少人工工程開銷。

- 高吞吐量和效率: 混合專家設計每次推理僅啟動 35 億個參數,從而平衡效能和計算成本。

- 開源且可擴充: 在 Apache 2.0 下發布,具有完整記錄的 API 和社群驅動的增強功能,可在 GitHub 上取得。

- 多語言和跨領域: 對數十種程式語言(從 Python 和 JavaScript 到 Go 和 Rust)的 7.5 兆個標記(70% 為程式碼)進行了訓練。

開發人員如何開始使用 Qwen3-Coder?

在哪裡可以下載並安裝 Qwen3‑Coder?

您可以從以下位置取得模型權重和 Docker 映像:

- GitHub的: https://github.com/QwenLM/Qwen3-Coder

- 抱臉: https://huggingface.co/QwenLM/Qwen3-Coder-480B-A35B-Instruct

- 模型範圍: 阿里巴巴官方倉庫

只需克隆 repo 並拉取預先建置的 Docker 容器:

git clone https://github.com/QwenLM/Qwen3-Coder.git

cd Qwen3-Coder

docker pull qwenlm/qwen3-coder:latest

使用 Transformer 載入模型

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-Coder-480B-A35B-Instruct"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

此程式碼初始化模型和標記器,自動在可用的 GPU 之間分配層。

如何配置我的環境?

- 硬件要求:

- 具有 ≥ 48 GB VRAM 的 NVIDIA GPU(建議使用 100 GB 的 A80)

- 128–256 GB 系統 RAM

-

依賴關係:

pip install -r requirements.txt # PyTorch, CUDA, tokenizers, etc. -

API 金鑰(可選):

對於雲端託管推理,請設定您的ALIYUN_ACCESS_KEYALIYUN_SECRET_KEY作為環境變數。

如何使用 Qwen Code 進行代理編碼?

以下是逐步指導如何開始使用 Qwen3‑Coder 通過 Qwen代碼 CLI(簡單調用 qwen):

1。 先決條件

- Node.js 20+ (您可以透過官方安裝程式或透過下面的腳本安裝)

- NPM,與 Node.js 捆綁在一起

# (Linux/macOS)

curl -qL https://www.npmjs.com/install.sh | sh

2.安裝 Qwen Code CLI

npm install -g @qwen-code/qwen-code

另外,從來源安裝:

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code

npm install

npm install -g

3.配置您的環境

Qwen 代碼使用 相容 OpenAI 底層 API 介面。設定以下環境變數:

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

OPENAI_MODEL 可以設定為以下之一:

qwen3-coder-plus(別名為 Qwen3‑Coder-480B-A35B-Instruct)- 或您部署的任何其他 Qwen3‑Coder 變體。

4.基本用法

1.啟動互動式編碼 REPL:

qwen

這會將您帶入由 Qwen3-Coder 提供支援的代理編碼會話。

- Shell 的一次性提示,用於請求程式碼片段或完成某個功能:

qwen code complete \

--model qwen3-coder-plus \

--prompt "Write a Python function that reverses a linked list."

3.基於文件的程式碼完成,自動填入或重構現有文件:

qwen code file-complete \

--model qwen3-coder-plus \

--file ./src/utils.js

- 聊天式交互,在「聊天」模式下使用 Qwen,非常適合多輪編碼對話:

qwen chat \

--model qwen3-coder-plus \

--system "You are a helpful coding assistant." \

--user "Generate a REST API endpoint in Express.js for user authentication."

如何透過 CometAPI API 呼叫 Qwen3-Coder?

CometAPI 是一個統一的 API 平台,它將來自領先供應商(例如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等)的 500 多個 AI 模型聚合到一個開發者友好的介面中。透過提供一致的身份驗證、請求格式和回應處理,CometAPI 顯著簡化了將 AI 功能整合到您的應用程式中的過程。無論您是建立聊天機器人、影像產生器、音樂作曲家,還是資料驅動的分析流程,CometAPI 都能讓您更快地迭代、控製成本,並保持與供應商的兼容性——同時也能充分利用整個 AI 生態系統的最新突破。

如果您是 cometAPI 用戶,您可以登入 cometapi 取得 key 和 base url,登入 cometapi 取得 key 和 base url,參考 Qwen3-Coder API.首先,探索模型在 游乐场 並諮詢 API指南 有關詳細說明。

若要透過 CometAPI 呼叫 Qwen3‑Coder,您需要使用與任何其他模型相同的 OpenAI 相容端點 - 只需將您的用戶端指向 CometAPI 的基本 URL,將您的 CometAPI 金鑰作為 Bearer 令牌提供,並指定 qwen3-coder-plus or qwen3-coder-480b-a35b-instruct 模型。

1。 先決條件

- 立即註冊 at https://cometapi.com 並在您的儀表板中新增/產生 API 令牌。

- 注意你的 API密鑰 (開頭為

sk-…). - 熟悉 OpenAI Chat API 協定(角色 + 訊息)。

2. 基本 URL 和身分驗證

基本網址:

arduinohttps://api.cometapi.com/v1

端點:

bashPOST https://api.cometapi.com/v1/chat/completions

3. cURL / REST 範例

curl https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer sk-xxxxxxxxxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "qwen3-coder-plus",

"messages": [

{ "role": "system", "content": "You are a helpful coder." },

{ "role": "user", "content": "Generate a SQL query to find duplicate emails." }

],

"temperature": 0.7,

"max_tokens": 512

}'

- 響應:JSON 與

choices.message.content包含生成的程式碼。

如何利用 Qwen3-Coder 的代理功能?

Qwen3-Coder 的代理功能支援動態工具呼叫和自主的多步驟工作流程,允許模型在程式碼產生期間呼叫外部函數或 API。

工具呼叫和自訂工具

在程式碼庫中定義自訂工具(例如 linters、測試執行器或格式化程式),並透過函數模式將它們暴露給模型。例如:

tools = [

{"name":"run_tests","description":"Execute the test suite and return results","parameters":{}},

{"name":"format_code","description":"Apply black formatter to the code","parameters":{}}

]

response = client.chat.completions.create(

messages=,

functions=tools,

function_call="auto"

)

然後,Qwen3-Coder 可以在一個會話中自主產生、格式化和驗證程式碼,從而減少手動整合開銷 ()。

使用 Qwen Code CLI

qwen-code 命令列工具為代理程式編碼提供了互動式 REPL:

qwen-code --model qwen3-coder-480b-a35b-instruct

> generate: "Create a REST API in Node.js with JWT authentication."

> tool: install_package(express)

> tool: create_file(app.js)

> tool: run_tests

此 CLI 使用透明日誌協調複雜的工作流程,使其成為探索性原型設計或整合到 CI/CD 管道的理想選擇。

Qwen3-Coder 適合大型程式碼庫嗎?

由於其擴展的上下文窗口,Qwen3-Coder 可以在生成補丁或重構之前提取整個程式碼庫(多達數十萬行程式碼)。此功能可實現全域重構、跨模組分析和架構建議,而小型上下文模型則無法提供這些功能。

最大化 Qwen3-Coder 實用性的最佳實踐是什麼?

有效採用 Qwen3-Coder 需要周到的配置並將其整合到您的 CI/CD 管道中。

您應該如何調整採樣和光束設定?

- 溫度因素:平衡創造力為 0.6–0.8;確定性重構任務較低(0.2–0.4)。

- Top-p:0.7–0.9 專注於最可能的延續,同時允許偶爾提出新穎的建議。

- Top-k:標準用途為 20–50;尋求高度集中的輸出時減少至 5–10。

- 重複懲罰:1.05–1.1,以防止模型重複樣板模式。

根據項目對變化的容忍度來試驗這些參數可以顯著提高生產力。

有效使用 Qwen3-Coder 的最佳實踐是什麼?

程式碼品質的快速工程

- 請明確點:在提示中指定語言、樣式指南和所需的複雜度。

- 迭代細化:使用模型的代理功能來迭代調試和優化生成的程式碼。

- 溫度調節:降低生成溫度(例如,

temperature=0.2) 以在生產環境中獲得更確定的產出。

管理資源利用率

- 型號變體:從較小的 Qwen3-Coder 變體開始進行原型設計,然後根據需要擴大規模。

- 動態量化:嘗試使用 FP8 和 GGUF 量化檢查點來減少 GPU 記憶體佔用,而不會顯著降低效能。

- 非同步生成:將長時間運行的程式碼產生卸載到後台工作者以保持回應能力。

遵守這些準則可確保您將 Qwen3-Coder 整合到您的軟體開發生命週期中,從而最大限度地提高投資報酬率。

透過遵循上述指導 - 了解其架構、安裝和配置模型和 Qwen Code CLI,並利用最佳實踐 - 您將能夠充分利用 Qwen3-Coder 的全部潛力,從簡單的程式碼片段到完全自主的程式設計代理程式。