人工智慧 (AI) 已經徹底改變了無數行業,其最吸引人的應用之一就是圖像生成。從創造逼真的人臉到製作超現實的藝術作品,人工智慧圖像生成能力為藝術、設計和技術開闢了新的途徑。本文深入探討了人工智慧生成圖像背後的機制、支援這些圖像的模型以及這項技術的更廣泛影響。

了解基礎知識:AI 影像生成如何運作?

什麼是生成模型?

生成模型是一類可以創建類似於訓練資料的新資料實例的人工智慧演算法。在影像生成的背景下,這些模型從現有影像中學習模式,並利用這些知識產生新的、相似的影像。

神經網路的作用

人工智慧影像生成的核心是神經網絡,特別是卷積神經網路(CNN)等深度學習模型。 CNN 旨在以網格狀拓撲結構處理數據,使其成為影像分析和生成的理想選擇。它們透過偵測邊緣、紋理和形狀等模式來運作,這些模式對於理解和重建影像至關重要。

AI影像生成中的關鍵AI模型

生成對抗網絡(GAN)

GAN 由 Ian Goodfellow 於 2014 年提出,由兩個神經網路組成:一個生成器和一個鑑別器。生成器創建圖像,而鑑別器根據真實圖像對其進行評估。透過這種對抗過程,生成器改進其輸出以產生越來越逼真的影像。

風格

StyleGAN 由 NVIDIA 開發,是一種以生成高品質人臉而聞名的 GAN 變體。它引入了一種基於風格的生成器架構,允許控製影像中不同層級的細節。 StyleGAN2 和 StyleGAN3 進一步提高了影像品質並解決了紋理粘連等問題。

擴散模型

擴散模型從隨機雜訊開始並逐漸細化以匹配所需的輸出來產生影像。由於它們能夠生成高品質的圖像,並且在各種應用中具有靈活性,因此它們很受歡迎。

穩定擴散

Stable Diffusion 是一種開源擴散模型,可實現文字到圖像的生成。它還可以執行修復和移除操作,從而實現影像編輯和擴展。它的開源特性使得開發人員和藝術家可以廣泛使用它。

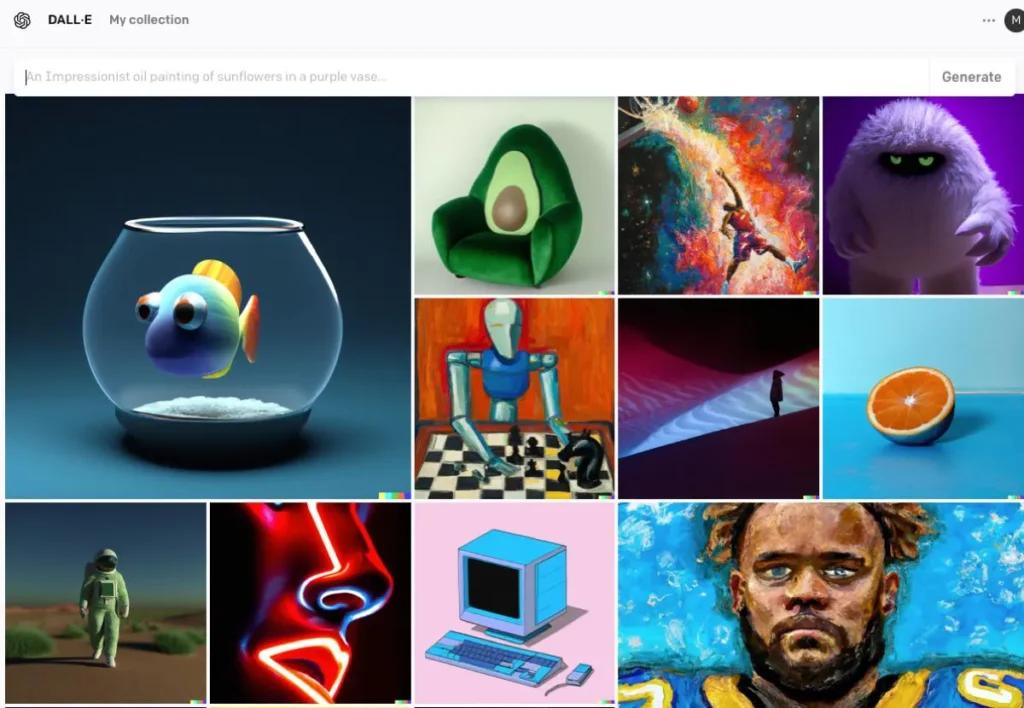

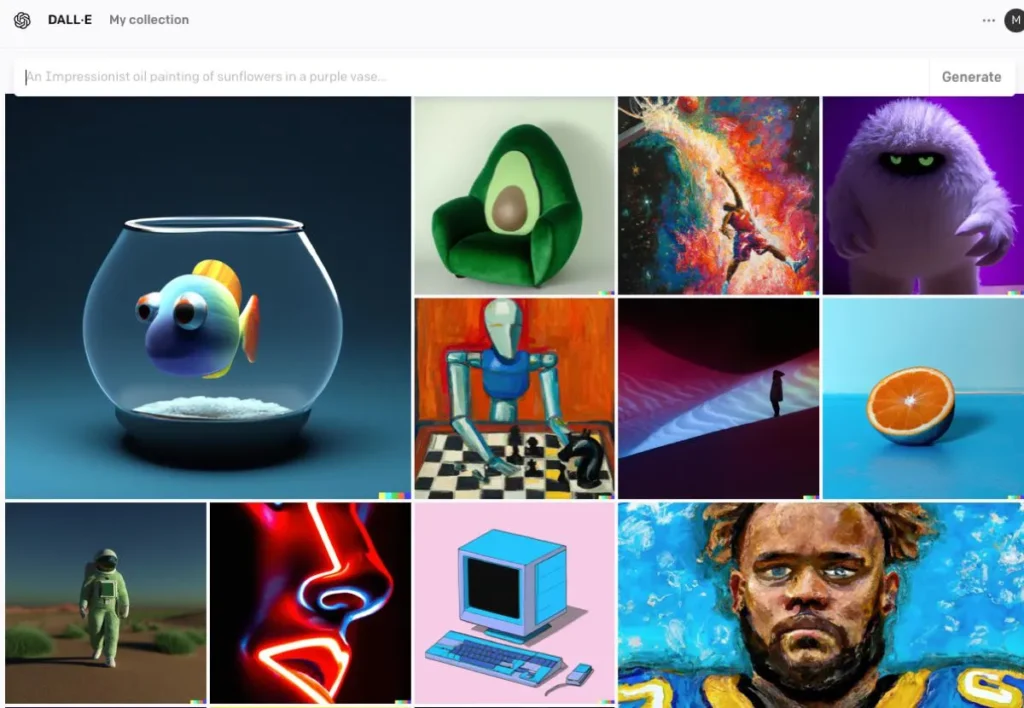

戴爾·E

DALL·E 由 OpenAI 開發,是一個基於 Transformer 的模型,能夠根據文字描述產生圖像。 DALL·E 2 和 DALL·E 3 在原始基礎上有所改進,提供更高的解析度和更準確的圖像文字對齊。 DALL·E 3 整合到 ChatGPT 中,以增強使用者互動。

AI影像生成流程

訓練模型

人工智慧模型需要對大量圖像資料集進行大量訓練。在訓練過程中,模型學習辨識影像中的模式和特徵,從而能夠產生模仿訓練資料的新影像。

產生新圖像

訓練完成後,該模型可以透過以下方式產生新圖像:

- 接收輸入:這可以是隨機雜訊(在 GAN 中)、文字提示(在 DALL·E 中)或現有圖像(用於編輯)。此步驟捕獲文本的語義含義,使 AI 能夠理解內容和上下文。

- 處理輸入:此模型透過其神經網路層處理輸入,應用學習到的模式和特徵。使用編碼文本,AI 採用生成對抗網路 (GAN) 或擴散模型等模型來創建圖像。這些模型從隨機雜訊開始並對其進行細化以匹配文字描述來產生圖像。

- 細化和評估:然後使用注意機制對生成的圖像進行細化,以確保與文字的一致性。鑑別器模型評估影像的真實性和與輸入的一致性,為進一步改進提供回饋。

- 輸出影像:最終的輸出是一幅反映訓練資料的特徵和所提供的具體輸入的新影像。

AI圖像生成程式碼範例

這裡有實用的 Python 程式碼範例,示範如何使用三種突出的 AI 模型生成圖像:生成對抗網路 (GAN)、穩定擴散和 DALL·E。

使用 PyTorch 的生成對抗網路 (GAN)

生成對抗網路 (GAN) 由兩個神經網路(生成器和鑑別器)組成,它們相互競爭以產生新的、真實的資料實例。以下是使用 PyTorch 產生影像的簡化範例:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

該程式碼定義了一個簡單的生成器網絡,它以 100 維噪聲向量作為輸入,並產生 784 維輸出,可以重塑為 28×28 的圖像。這 tanh 激活函數確保輸出值在範圍內,這對於影像資料來說很常見。號

貼面擴散器實現穩定擴散

穩定擴散是一種強大的文字到圖像模型,它可以根據文字描述產生圖像。擁抱的臉 diffusers 庫提供了一個簡單的介面來使用該模型:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

該腳本加載穩定擴散模型並根據提供的提示生成圖像。確保已安裝必要的依賴項並具有相容的 GPU,以獲得最佳效能。號

DALL·E 與 OpenAI API

DALL·E 是 OpenAI 開發的另一個文字轉圖像模型。您可以使用 OpenAI 的 API 與其進行互動:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

更換 "your-api-key" 使用您的實際 OpenAI API 金鑰。該腳本向 DALL·E 模型發送提示並檢索生成的圖像。然後將圖像保存在本地。號

CometAPI 也整合了 DALL-E 3 API,您也可以使用 CometAPI 的金鑰來存取 DALL-E 3 API,比OpenAI更方便、更快捷。

有關 Comet API 中的更多模型信息,請參閱 API 文件.

這些範例為使用不同的 AI 模型生成圖像提供了一個起點。每個模型都有其獨特的功能和要求,因此請選擇最適合您專案需求的型號。

結論

AI影像生成站在科技與創造力的交會點,為視覺內容創作提供了前所未有的可能性。當我們探索人工智慧如何產生圖像、所涉及的模型以及這項技術的含義時,了解人工智慧如何融入社會的各個方面至關重要。

在 CometAPI 中存取 AI 影像 API

CometAPI 提供超過 500 種 AI 模型,包括用於聊天、映像、程式碼等的開源和專用多模式模型。其主要優勢在於簡化傳統上複雜的人工智慧整合過程。有了它,您可以透過單一、統一的訂閱存取 Claude、OpenAI、Deepseek 和 Gemini 等領先的 AI 工具。您可以使用 CometAPI 中的 API 來創作音樂和藝術品、生成影片以及建立自己的工作流程

彗星API 提供遠低於官方價格的價格,幫助您整合 GPT-4o API ,Midjourney API 穩定擴散 API (穩定擴散 XL 1.0 API) 和 Flux API(FLUX.1 API 等等),註冊登入後您的帳戶中就會獲得1美元!

CometAPI 整合了最新的 GPT-4o-圖像 API .