由智浦人工智慧 (Z.ai) 開發的 GLM-4.5 系列代表了開源大型語言模型 (LLM) 的重大進步。 GLM-4.5 旨在統一推理、編碼和代理功能,在各種應用中提供強大的效能。無論您是開發者、研究人員還是愛好者,本指南都提供了有關如何有效存取和使用 GLM-4.5 系列的詳細資訊。

什麼是 GLM-4.5 系列?它為何如此重要?

GLM-4.5 是一個混合推理模型,它結合了兩種不同的模式:一種是用於複雜推理和工具使用的“思考模式”,另一種是用於即時回應的“非思考模式”。這種雙模式方法使該模型能夠有效率地處理各種任務。該系列包含兩種主要變體:

- GLM-4.5:該模型擁有 355 億個總參數和 32 億個活動參數,專為跨推理、生成和多智能體任務的大規模部署而設計。

- GLM-4.5-空氣:輕量級版本,擁有 106 億個總參數和 12 億個活動參數,針對設備上和小規模雲推理進行了最佳化,且不犧牲核心功能。

兩種模型都支援混合推理模式,提供「思考」與「非思考」模式,以平衡複雜的推理任務和快速的回應,並且都是開源的,並在 MIT 許可下發布,可用於商業用途和二次開發。

架構和設計原則

GLM-4.5 的核心是利用 MoE,透過專門的專家子網路動態路由 token,從而實現卓越的參數效率和擴展行為 ()。這種方法意味著每次前向傳播需要啟動的參數更少,從而降低營運成本,同時保持推理和編碼任務的領先效能 ()。

關鍵能力

- 混合推理和編碼:GLM-4.5 在自然語言理解基準和程式碼產生測試中都表現出 SOTA 效能,在準確性和流暢性方面通常可與專有模型相媲美。

- 代理集成:內建工具呼叫介面可讓 GLM-4.5 在單一會話中協調多步驟工作流程 - 例如資料庫查詢、API 協調和互動式前端產生。

- 多模態偽影:從 HTML/CSS 迷你應用程式到基於 Python 的模擬和互動式 SVG,GLM-4.5 可以輸出功能齊全的工件,從而提高使用者參與度和開發人員的工作效率。

為什麼 GLM-4.5 會改變遊戲規則?

GLM-4.5 不僅因其原始效能而受到稱讚,還因其重新定義了企業和研究環境中開源 LLM 的價值主張而受到稱讚。

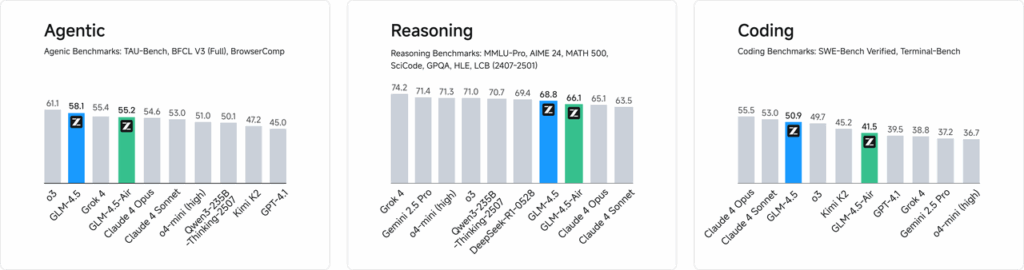

績效基準

在涵蓋 52 項程式設計任務(涵蓋 Web 開發、資料分析和自動化)的獨立評估中,GLM-4.5 在工具呼叫可靠性和整體任務完成率方面始終優於其他領先的開源模型。在與 Claude Code、Kimi-K2 和 Qwen3-Coder 的對比測試中,GLM-4.5 在「SWE-bench Verified」排行榜等基準測試中取得了同類最佳的成績。

成本效益

除了準確度之外,GLM-4.5 的 MoE 設計還大幅降低了推理成本。 API 調用的公開定價低至每百萬輸入令牌 0.8 元人民幣,每百萬輸出令牌 2 元人民幣——約為同類專有產品成本的三分之一。該模型的峰值生成速度高達每秒 100 個令牌,支援高吞吐量、低延遲部署,且無需高昂的成本。

如何存取 GLM-4.5?

1. 透過Z.ai平台直接訪問

與 GLM-4.5 互動最直接的方法是透過 Z.ai 平台。透過訪問 chat.z.ai使用者可以選擇 GLM-4.5 模型並透過使用者友善的介面開始互動。該平台支援即時測試和原型設計,無需複雜的整合。使用者可以從左上角選擇 GLM-4.5 或 GLM-4.5-Air 模型,並立即開始聊天。該介面用戶友好,無需設置,非常適合快速互動和演示。

2. 開發人員的 API 訪問

對於希望將 GLM-4.5 整合到應用程式中的開發者,Z.ai API 平台提供了全面的支援。該 API 為 GLM-4.5 和 GLM-4.5-Air 模型提供與 OpenAI 相容的接口,方便無縫整合到現有工作流程中。詳細文件和整合指南可訪問 Z.ai API 文件 .

3.開源部署

對於對本地部署感興趣的用戶,GLM-4.5 模型已在 Hugging Face 和 ModelScope 等平台上發布。這些模型採用 MIT 開源許可證發布,允許商業使用和二次開發。它們可以與 vLLM 和 SGLang 等主流推理框架整合。

4. 與 CometAPI 集成

彗星API 透過其統一的 API 平台提供對 GLM-4.5 模型的簡化訪問 達斯博拉德。此整合簡化了身份驗證、速率限制和錯誤處理,對於尋求輕鬆設定的開發人員來說,它無疑是一個絕佳選擇。此外,CometAPI 的標準化 API 格式支援在 GLM-4.5 和其他可用模型之間輕鬆切換和進行 A/B 測試。

開發人員如何存取 GLM-4.5 系列?

有多種管道可以取得和部署 GLM-4.5,從直接模型下載到託管 API。

透過 Hugging Face 和 ModelScope

Hugging Face 和 ModelScope 均在 zai-org 命名空間下託管完整的 GLM-4.5 系列。同意 MIT 許可證後,開發者可以:

- 克隆儲存庫:

git clone https://huggingface.co/zai-org/GLM-4.5

- 安裝依賴項:

pip install transformers accelerate

- 載入模型:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

透過 CometAPI

彗星API 提供無伺服器 API GLM-4.5 GLM-4.5 空氣 API 按每個令牌付費,透過設定與 OpenAI 相容的端點,您可以透過 OpenAI 的 Python 用戶端呼叫 GLM-4.5,而對現有程式碼庫進行最少的調整。 CometAPI 不僅提供 GLM4.5 和 GLM-4.5-air,還提供所有官方模型:

| 型號名稱 | 介紹 | 價格 |

glm-4.5 | 我們最強大的推理模型,擁有 355 億個參數 | 輸入代幣 0.48 美元 輸出代幣 1.92 美元 |

glm-4.5-air | 經濟實惠 輕量級 性能強勁 | 輸入代幣 0.16 美元 輸出代幣 1.07 美元 |

glm-4.5-x | 高性能強推理超快速反應 | 輸入代幣 1.60 美元 輸出代幣 6.40 美元 |

glm-4.5-airx | 輕量級 強勁性能 超快響應 | 輸入代幣 0.02 美元 輸出代幣 0.06 美元 |

glm-4.5-flash | 性能強勁,非常適合推理編碼和代理 | 輸入代幣 3.20 美元 輸出代幣 12.80 美元 |

Python 和 REST API 集成

對於客製化部署,組織可以使用 Docker 或 Kubernetes 在專用 GPU 叢集上託管 GLM-4.5。典型的 RESTful 設定包括:

啟動推理伺服器:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

發送請求:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

在應用程式中整合 GLM-4.5 的最佳實踐是什麼?

為了最大限度地提高投資回報率並確保強勁的表現,團隊應該考慮以下幾點:

API 優化和速率限制

- 大量請求:將相似的提示分組以減少開銷並利用 GPU 吞吐量。

- 快取常見查詢:在本地儲存頻繁完成,以避免冗餘的推理調用。

- 自適應採樣:動態調整

temperaturetop_p根據查詢的複雜性來平衡創造性和確定性。

安全與合規

- 數據清理:在將輸入發送到模型之前,對其進行預處理以去除敏感資訊。

- 智能門鎖:實作 API 金鑰、IP 允許清單和速率限制,以防止誤用和濫用。

- 審計日誌記錄:記錄提示、完成和元資料以符合公司和監管要求,特別是在金融或醫療保健領域。

入門

CometAPI 是一個統一的 API 平台,它將來自領先供應商(例如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等)的 500 多個 AI 模型聚合到一個開發者友好的介面中。透過提供一致的身份驗證、請求格式和回應處理,CometAPI 顯著簡化了將 AI 功能整合到您的應用程式中的過程。無論您是建立聊天機器人、影像產生器、音樂作曲家,還是資料驅動的分析流程,CometAPI 都能讓您更快地迭代、控製成本,並保持與供應商的兼容性——同時也能充分利用整個 AI 生態系統的最新突破。

對於希望將 GLM-4.5 整合到其應用程式中的開發人員,CometAPI 平台提供了一個強大的解決方案。該 API 提供與 OpenAI 相容的接口,可無縫整合到現有工作流程中。詳細的文件和使用指南可在 Comet API 頁面.

開發人員可以訪問 GLM-4.5 GLM-4.5 空氣 API 通過 彗星API,列出的最新模型版本截至本文發布之日。首先,探索該模型的功能 游乐场 並諮詢 API指南 以獲得詳細說明。造訪前請確保您已經登入CometAPI並取得API金鑰。 彗星API 提供遠低於官方價格的價格,幫助您整合。

結論

GLM-4.5 代表了大型語言模型領域的重大進步,為廣泛的應用提供了多功能解決方案。其混合推理架構、代理功能以及開源特性,使其成為尋求利用先進 AI 技術的開發者和組織的理想選擇。透過探索本指南中概述的各種存取方法,使用者可以有效地將 GLM-4.5 整合到他們的專案中,並為其持續發展做出貢獻。