2025-2026年,人工智慧工具領域持續整合:網關API(例如CometAPI)擴展,提供類似OpenAI的數百種模型存取方式;同時,終端用戶LLM應用(例如AnythingLLM)不斷改進其「通用OpenAI」提供者,使桌面應用和本地優先應用程式能夠調用任何相容OpenAI的端點相容。如今,透過CometAPI路由AnythingLLM流量變得非常簡單,使用者可以享受模型選擇、成本路由和統一計費等優勢,同時也能繼續使用AnythingLLM的本機使用者介面和RAG/代理功能。

AnythingLLM是什麼?為什麼要將其連接到CometAPI?

AnythingLLM是什麼?

AnythingLLM 是一款開源的一體化 AI 應用程式和本機/雲端用戶端,用於建立聊天助理、檢索增強生成 (RAG) 工作流程以及 LLM 驅動的代理程式。它提供簡潔的使用者介面、開發者 API、工作區/代理功能,並支援本機和雲端 LLM——預設為私有模式,可透過外掛程式進行擴充。 AnythingLLM 公開了一個 通用 OpenAI 提供程序,使其能夠與 OpenAI 相容的 LLM API 進行通訊。

什麼是 CometAPI?

CometAPI是一個商業API聚合平台,它公開了 500多個AI模型 透過一個 OpenAI 風格的 REST 介面和統一計費。實際上,它允許您透過同一個介面呼叫來自多個供應商的模型(OpenAI、Anthropic、Google/Gemini 的各種版本、圖像/音訊模型等)。 https://api.cometapi.com/v1 端點和單一 API 金鑰(格式) sk-xxxxxCometAPI 支援標準的 OpenAI 風格端點,例如: /v1/chat/completions, /v1/embeddings等等,這使得對已經支援 OpenAI 相容 API 的工具進行適配變得容易。

為什麼要將 AnythingLLM 與 CometAPI 整合?

三個實際原因:

- 型號選擇和供應商靈活性: AnythingLLM 可以透過其通用 OpenAI 封裝器使用任何「相容於 OpenAI 的」LLM 模型。將該封裝器指向 CometAPI 即可立即存取數百個模型,而無需更改 AnythingLLM 的使用者介面或流程。

- 成本/營運優化: 使用 CometAPI 可以集中切換型號(或降級到更便宜的型號)以控製成本,並保持統一計費,而無需管理多個提供者金鑰。

- 更快的實驗: 您可以對不同的模型進行 A/B 測試(例如,

gpt-4o,gpt-4.5(例如 Claude 變體或開源多模態模型)透過同一個 AnythingLLM UI — 適用於代理、RAG 回應、摘要和多模態任務。

在整合之前,您必須準備好環境和條件。

系統及軟體需求(摘要)

- 執行 AnythingLLM 的桌面或伺服器(Windows、macOS、Linux)-桌面安裝或自架執行個體。確認您使用的是最新版本,該版本公開了… 法學碩士偏好 / 人工智慧提供者 設置。

- CometAPI 帳戶和 API 金鑰(

sk-xxxxx(樣式密鑰)。您將在 AnythingLLM 的通用 OpenAI 提供者中使用此金鑰。 - 從您的電腦到網路的連接

https://api.cometapi.com(沒有防火牆阻止出站 HTTPS)。 - 可選但建議:用於測試的現代 Python 或 Node 環境(Python 3.10+ 或 Node 18+)、curl 和 HTTP 用戶端(Postman / HTTPie),以便在將 CometAPI 連接到 AnythingLLM 之前對其進行健全性檢查。

AnythingLLM 特定條件

通用 OpenAI 對於模擬 OpenAI API 介面的端點,建議使用 LLM 提供者。 AnythingLLM 的文件提醒您,此提供者是針對開發者,您應該了解您提供的輸入。如果您使用串流或您的端點不支援串流傳輸,AnythingLLM 提供了一個設置,可以停用通用 OpenAI 的串流傳輸。

安全與營運檢查清單

- 像對待其他任何秘密一樣對待 CometAPI 金鑰——不要將其提交到程式碼庫;盡可能將其儲存在作業系統鑰匙圈或環境變數中。

- 如果您打算在 RAG 中使用敏感文檔,請確保端點隱私保證符合您的合規性要求(請參閱 CometAPI 的文檔/條款)。

- 確定最大令牌數和上下文視窗限制,以防止帳單失控。

如何配置 AnythingLLM 以使用 CometAPI(逐步指南)?

以下是一個特定的步驟序列-後面是範例環境變數和程式碼片段,用於在 AnythingLLM UI 中儲存設定之前測試連線。

步驟 1 — 取得您的 CometAPI 金鑰

- 在 CometAPI 註冊或登入。

- 導航至“API 金鑰”並產生一個金鑰——您將獲得一個類似於這樣的字串

sk-xxxxx保密。

步驟 2 — 透過快速請求驗證 CometAPI 是否正常運作

使用 curl 或 Python 呼叫簡單的聊天完成端點來確認連線。

Curl 範例

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

如果傳回 200 狀態碼和一個包含以下內容的 JSON 回應: choices 數組、密鑰和網路均正常運作。 (CometAPI 的文檔展示了 OpenAI 風格的介面和端點)。

Python 範例(requests)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

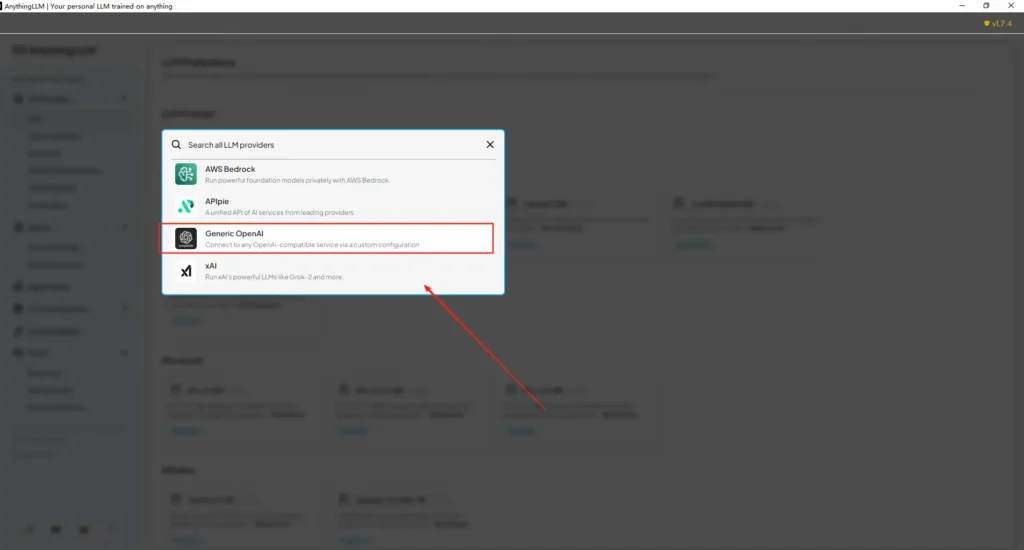

步驟 3 — 設定 AnythingLLM(使用者介面)

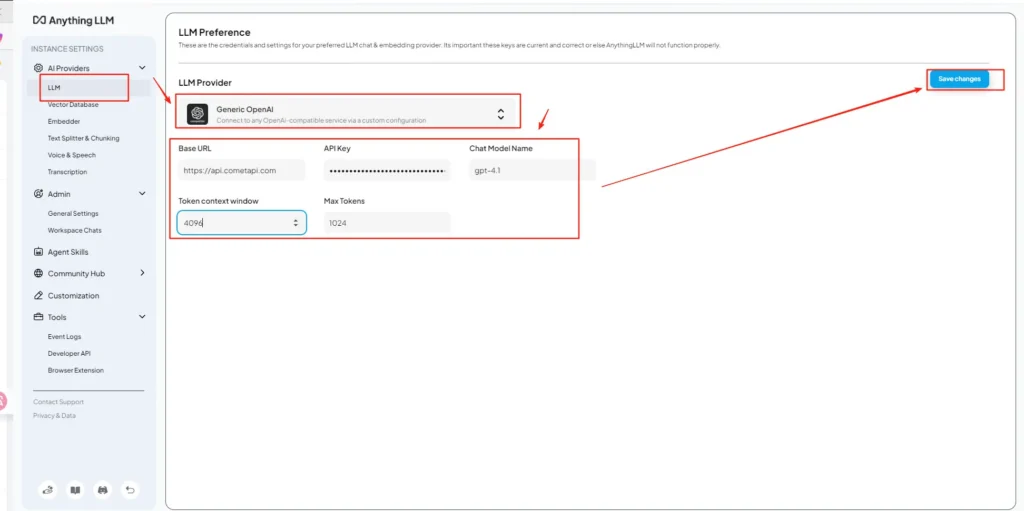

開啟 AnythingLLM → 設定 → 人工智慧提供者 → 法學碩士偏好 (或您版本中的類似路徑)。使用 通用 OpenAI 請按以下方式提供並填寫欄位:

API配置(範例)

• 進入 AnythingLLM 設定選單,在 AI 提供者下找到 LLM 首選項。

• 選擇 Generic OpenAI 作為模型提供程序,輸入https://api.cometapi.com/v1在網址欄中。

• 貼上sk-xxxxx在 API 金鑰輸入框中輸入 CometAPI 的金鑰。根據實際模型填入令牌上下文視窗和最大令牌數。您也可以在此頁面自訂模型名稱,例如新增模型名稱。gpt-4o模型。

這與 AnythingLLM 的「通用 OpenAI」指南(開發者封裝)和 CometAPI 的 OpenAI 相容的基本 URL 方法相符。

步驟 4 — 設定模型名稱和令牌限制

在同一設定畫面上,新增或自訂模型名稱,使其與 CometAPI 發布的名稱完全一致(例如, gpt-4o, minimax-m2, kimi-k2-thinking因此,AnythingLLM 使用者介面可以向使用者展示這些模型。 CometAPI 會為每個供應商發布模型字串。

步驟 5 — 在 AnythingLLM 中進行測試

發起新的聊天或使用現有工作區,選擇通用 OpenAI 提供者(如果您有多個提供者),選擇您新增的 CometAPI 模型名稱之一,然後執行一個簡單的提示。如果獲得一致的自動補全結果,則表示您已整合成功。

AnythingLLM 內部如何使用這些設置

AnythingLLM 的通用 OpenAI 包裝器建構 OpenAI 風格的請求(/v1/chat/completions, /v1/embeddings因此,一旦您指定了基本 URL 並提供 CometAPI 金鑰,AnythingLLM 就會透明地將聊天、代理程式呼叫和嵌入請求路由到 CometAPI。如果您使用 AnythingLLM 代理程式( @agent 流),它們將繼承相同的提供者。

最佳實務有哪些?可能存在的陷阱又是什麼?

最佳實踐

- 使用符合模型要求的上下文設定: 請將 AnythingLLM 的 Token 上下文視窗和最大 Token 數與您在 CometAPI 中選擇的模型進行比對。不匹配會導致意外截斷或呼叫失敗。

- 保護您的 API 金鑰: 將 CometAPI 金鑰儲存在環境變數和/或 Kubernetes/金鑰管理員中;切勿將其提交至 Git。如果您在 UI 中輸入金鑰,AnythingLLM 會將其儲存在本機設定中——請將主機儲存視為敏感資訊。

- 實驗流程可以先從較便宜/較小的模型開始: 使用 CometAPI 可以嘗試低成本模型進行開發,並將高成本模型保留用於生產環境。 CometAPI 明確支援成本切換和統一計費。

- 監控使用情況並設定提醒: CometAPI 提供使用情況儀錶板-設定預算/警報,避免意外帳單。

- 單獨測試代理程式和工具: AnythingLLM 代理程式可以觸發操作;請先使用安全性提示在測試實例上進行測試。

常見陷阱

- UI 與

.env衝突: 自託管時,UI 設定可能會覆蓋.env更改(反之亦然)。檢查生成的/app/server/.env如果重啟後問題依舊存在。社區問題報告LLM_PROVIDER重置。 - 型號名稱不符: 使用 CometAPI 中不存在的型號名稱會導致網關傳回 400/404 錯誤。請務必在 CometAPI 型號清單中確認可用型號。

- 代幣限額和串流媒體播放: 如果您需要串流回應,請確認 CometAPI 模型(以及 AnythingLLM 的 UI 版本)是否支援串流。不同的提供者在串流語義上有所不同。

這項整合可以帶來哪些實際應用場景?

檢索增強生成 (RAG)

使用 AnythingLLM 的文件載入器和向量資料庫,結合 CometAPI 的 LLM,即可產生上下文感知型答案。您可以嘗試低成本的嵌入和昂貴的聊天模型,或將所有功能放在 CometAPI 上,以實現統一計費。 AnythingLLM 的 RAG 流程是其主要內建功能之一。

代理自動化

AnythingLLM 支持 @agent 工作流程(瀏覽頁面、呼叫工具、運行自動化)。透過 CometAPI 路由代理程式的 LLM 調用,無需修改代理程式碼,即可選擇控制/解釋步驟的模型。

多模型A/B測試和成本優化

每個工作區或功能切換模型(例如, gpt-4o 對於生產方面的解答, gpt-4o-mini (供開發人員使用)。 CometAPI 讓模型替換變得非常簡單,並集中管理成本。

多模式管道

CometAPI 提供映像、音訊和專用模型。 AnythingLLM 的多模態支援(透過提供者)加上 CometAPI 的模型,使得影像標註、多模態摘要或音訊轉錄等流程可以透過相同介面實現。

結論

CometAPI 繼續將自己定位為多模型網關(支援 500 多個模型,採用 OpenAI 風格的 API),這使其成為 AnythingLLM 等已支援通用 OpenAI 提供者的應用程式的理想合作夥伴。同樣,AnythingLLM 的通用提供者及其最新的配置選項,也使得連接到此類網關變得非常簡單。這種融合將簡化 2025 年底的實驗和生產遷移。

如何開始使用 Comet API

CometAPI 是一個統一的 API 平台,它將來自領先供應商(例如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等)的 500 多個 AI 模型聚合到一個開發者友好的介面中。透過提供一致的身份驗證、請求格式和回應處理,CometAPI 顯著簡化了將 AI 功能整合到您的應用程式中的過程。無論您是建立聊天機器人、影像產生器、音樂作曲家,還是資料驅動的分析流程,CometAPI 都能讓您更快地迭代、控製成本,並保持與供應商的兼容性——同時也能充分利用整個 AI 生態系統的最新突破。

首先,探索模型的功能彗星API ,詳見 游乐场 並查閱 API 指南以取得詳細說明。造訪前,請確保您已登入 CometAPI 並取得 API 金鑰。 COMetAPI 提供遠低於官方價格的價格,幫助您整合。

準備出發了嗎? → 立即註冊 CometAPI !