DeepSeek-V3.1 是 DeepSeek 最新的混合推理模型,它支援快速的「非思考」聊天模式和更嚴謹的「思考/推理」模式,提供長達(最高 128K)的上下文、結構化輸出和函數調用,並且可以透過 DeepSeek 相容 OpenAI 的 API、相容 Anthropic 的端點或 CometAPI 直接存取。接下來,我將向您介紹該模型的構成、基準測試和成本亮點、高級功能(函數呼叫、JSON 輸出、推理模式),然後提供具體的端到端程式碼範例:直接呼叫 DeepSeek REST(curl / Node / Python)、使用 Anthropic 用戶端以及透過 CometAPI 呼叫。

什麼是 DeepSeek-V3.1?此版本有哪些新功能?

DeepSeek-V3.1 是 DeepSeek V3 系列的最新版本:高容量、混合專家大型語言模型系列,附帶 混合推理設計 具有兩種操作「模式」—快速 不假思索的聊天 模式和一個 思考/推理者 此模式可以揭示思路鍊式的軌跡,以應對更複雜的推理任務和代理/工具的使用。此版本強調更快的「思考」延遲、更強大的工具/代理功能以及更長的上下文處理時間,以適應文件規模的工作流程。

關鍵實用要點:

- 兩種操作模式:

deepseek-chat對於吞吐量和成本,deepseek-reasoner(推理模型)當你需要思路鏈痕跡或更高的推理保真度。 - 升級了代理/工具處理並改進了長文檔的標記器/上下文。

- 上下文長度: 最多 ~128K 個令牌(支援長文檔、程式碼庫、日誌)。

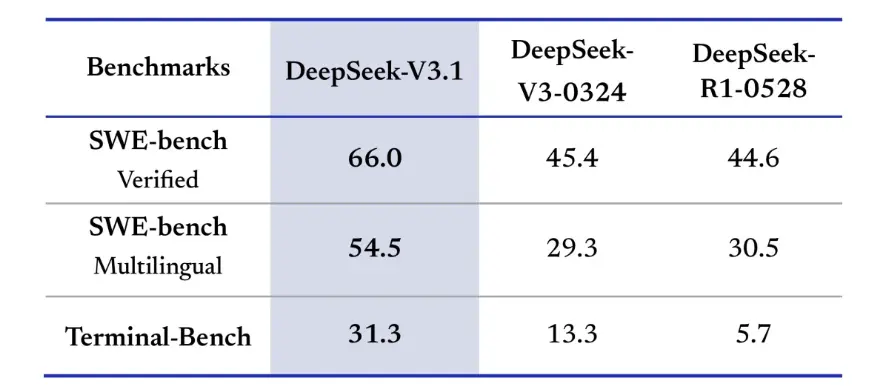

基準突破

DeepSeek-V3.1 在實際程式設計挑戰中展現出顯著的提升。在 SWE-bench Verified 評估中(該評估衡量了模型修復 GitHub 問題以確保單元測試通過的頻率),V3.1 的成功率為 66%,而 V45-3 和 R0324 的成功率均為 1%。在多語言版本中,V3.1 解決了 54.5% 的問題,幾乎是其他版本約 30% 成功率的兩倍。在 Terminal-Bench 評估中(此評估測試模型是否能在實際 Linux 環境中成功完成任務),DeepSeek-V3.1 的任務成功率為 31%,而其他版本分別為 13% 和 6%。這些改進表明 DeepSeek-V3.1 在執行程式碼和在實際工具環境中運行時更加可靠。

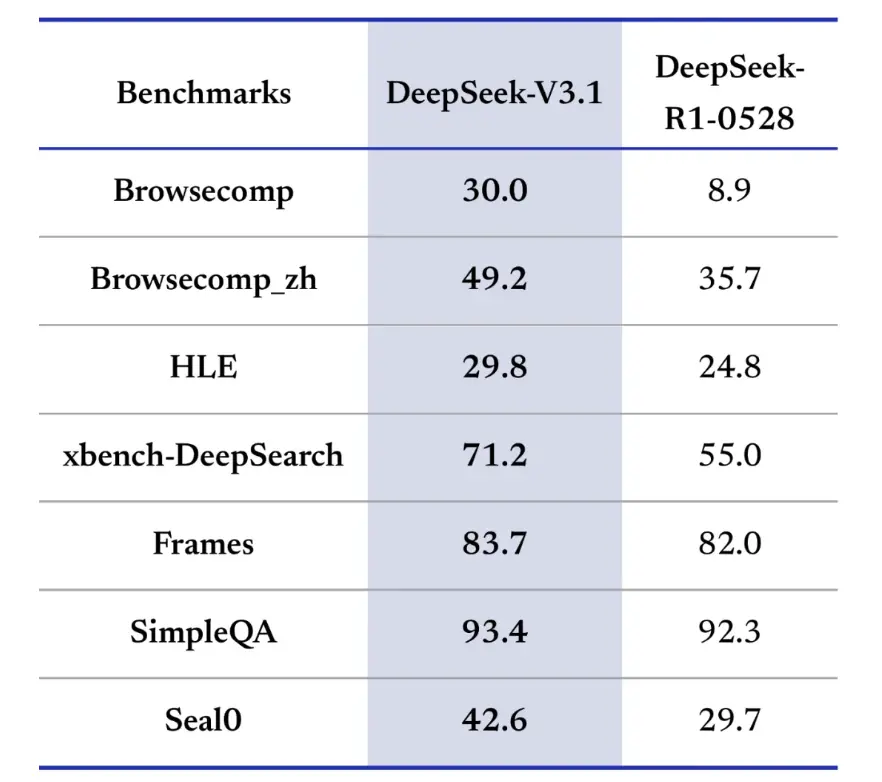

資訊檢索基準測試也青睞 DeepSeek-V3.1 在瀏覽、搜尋和問答方面的表現。在 BrowseComp 評估(需要瀏覽網頁並提取答案)中,V3.1 正確回答了 30% 的問題,而 R9 的正確率為 1%。在中文版測試中,DeepSeek-V3.1 的準確率達到 49%,而 R36 的準確率僅為 1%。在高難度語言測驗 (HLE) 中,V3.1 的表現略勝 R1,準確率分別為 30% 和 25%。在深度搜尋任務(例如 xbench-DeepSearch)中,由於需要跨來源整合訊息,V3.1 的得分為 71%,而 R1 的得分為 55%。 DeepSeek-V3.1 在結構化推理、SimpleQA(事實型問答)和 Seal0(特定領域問答)等基準測試中也表現出小幅但持續的領先優勢。整體而言,V3.1 在資訊檢索和輕量級問答方面表現明顯優於 R1。

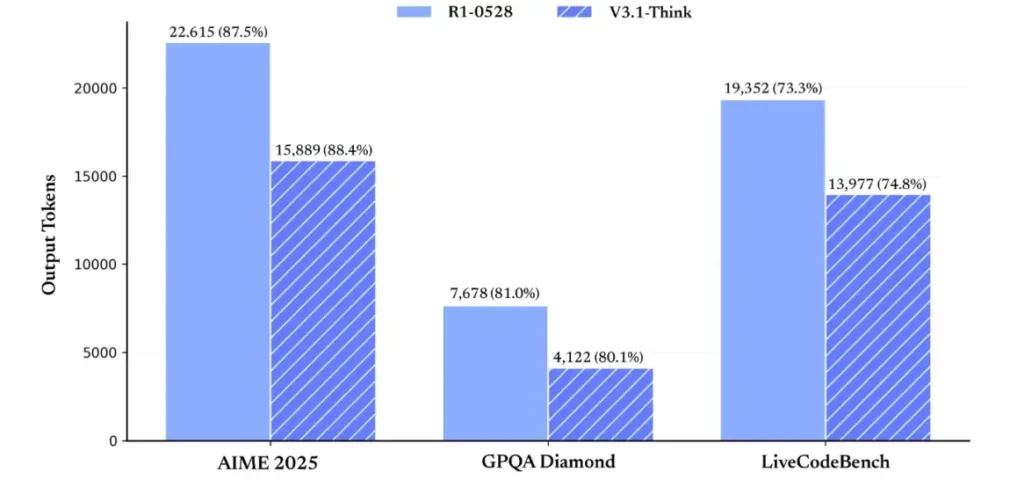

在推理效率方面,token 使用結果證明了其有效性。在 AIME 2025(一項難度較高的數學考試)中,V3.1-Think 的準確率與 R1 相當甚至略有提升(88.4% vs. 87.5%),但使用的 token 數量減少了約 30%。在 GPQA Diamond(一項多領域研究生考試)中,兩個模型的準確率接近(80.1% vs. 81.0%),但 V3.1 使用的 token 數量幾乎只有 R1 的一半。在評估程式碼推理能力的 LiveCodeBench 基準測試中,V3.1 不僅準確率更高(74.8% vs. 73.3%),而且更簡潔。這表明 V3.1-Think 能夠在避免冗長的同時提供詳細的推理。

總體而言,V3.1 與 V3-0324 相比實現了顯著的世代飛躍。與 R1 相比,V3.1 在幾乎所有基準測試中都實現了更高的準確率,並且在重推理任務上也更有效率。唯一與 R1 相當的基準測試是 GPQA,但成本幾乎翻了一番。

如何取得 API 金鑰並設定開發帳戶?

步驟 1:註冊並建立帳戶

- 造訪 DeepSeek 的開發者入口網站(DeepSeek 文件 / 控制台)。使用您的電子郵件或 SSO 提供者建立帳戶。

- 完成入口網站所需的任何身分檢查或帳單設定。

第 2 步:建立 API 金鑰

- 在儀表板中,轉到 API密鑰 → 創建密鑰. 命名您的金鑰(例如,

dev-local-01). - 複製金鑰並將其儲存在安全的秘密管理器中(請參閱下面的生產最佳實務)。

提示:某些網關和第三方路由器(例如 CometAPI)可讓您使用單一網關金鑰透過它們存取 DeepSeek 模型 - 這對於多提供者冗餘非常有用(請參閱 DeepSeek V3.1 API 部分)。

如何設定我的開發環境(Linux/macOS/Windows)?

這是一個簡單、可重複的 Python 和 Node.js 設定,適用於 DeepSeek(與 OpenAI 相容的端點)、CometAPI 和 Anthropic。

條件:

- Python 3.10+(建議)、pip、virtualenv。

- Node.js 18+ 和 npm/yarn。

- curl(用於快速測試)。

Python 環境(逐步說明)

- 建立專案目錄:

mkdir deepseek-demo && cd deepseek-demo

python -m venv .venv

source .venv/bin/activate # macOS / Linux

# .venv\Scripts\activate # Windows PowerShell

- 安裝最小軟體包:

pip install --upgrade pip

pip install requests

# Optional: install an OpenAI-compatible client if you prefer one:

pip install openai

- 將您的 API 金鑰儲存到環境變數(永不提交):

export DEEPSEEK_KEY="sk_live_xxx"

export CometAPI_KEY="or_xxx"

export ANTHROPIC_KEY="anthropic_xxx"

(Windows PowerShell 使用 $env:DEEPSEEK_KEY = "…")

Node 環境(逐步說明)

- 初始化:

mkdir deepseek-node && cd deepseek-node

npm init -y

npm install node-fetch dotenv

- 創建一個

.env文件:

DEEPSEEK_KEY=sk_live_xxx

CometAPI_KEY=or_xxx

ANTHROPIC_KEY=anthropic_xxx

如何直接呼叫 DeepSeek-V3.1 — 分步程式碼範例?

DeepSeek 的 API 與 OpenAI 相容。以下是 複製粘貼 範例:curl、Python(請求和 openai SDK 樣式)和 Node。

步驟 1:簡單的 curl 範例

curl https://api.deepseek.com/v1/chat/completions \

-H "Authorization: Bearer $DEEPSEEK_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-chat-v3.1",

"messages": [

{"role":"system","content":"You are a concise engineering assistant."},

{"role":"user","content":"Give a 5-step secure deployment checklist for a Django app."}

],

"max_tokens": 400,

"temperature": 0.0,

"reasoning_enabled": true

}'

注意: reasoning_enabled 切換思考模式(供應商標誌)。具體標誌名稱可能因供應商而異—請查看模型文件。

步驟 2:使用簡單遙測的 Python(請求)

import os, requests, time, json

API_KEY = os.environ

URL = "https://api.deepseek.com/v1/chat/completions"

payload = {

"model": "deepseek-chat-v3.1",

"messages": [

{"role": "system", "content": "You are a helpful coding assistant."},

{"role": "user", "content": "Refactor this Flask function to be testable: ..."}

],

"max_tokens": 600,

"temperature": 0.1,

"reasoning_enabled": True

}

start = time.time()

r = requests.post(URL, headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}, json=payload, timeout=60)

elapsed = time.time() - start

print("Status:", r.status_code, "Elapsed:", elapsed)

data = r.json()

print(json.dumps(data, indent=2))

CometAPI:完全免費存取DeepSeek V3.1

對於希望立即存取且無需註冊的開發者,CometAPI 提供了一個極具吸引力的 DeepSeek V3.1 替代方案(型號名稱:deepseek-v3-1-250821;deepseek-v3.1)。該網關服務透過統一的 API 聚合多個 AI 模型,提供對 DeepSeek 的訪問,並提供其他優勢,包括自動故障轉移、使用分析和簡化的跨提供者計費。

首先,建立一個 CometAPI 帳戶 https://www.cometapi.com/整個過程只需兩分鐘,只需驗證電子郵件地址即可。登入後,在「API 金鑰」部分產生新金鑰。 https://www.cometapi.com/ 為新帳戶提供免費積分,並在官方 API 價格的基礎上享受 20% 的折扣。

技術實現只需極少的程式碼修改。只需將您的 API 端點從直接的 DeepSeek URL 變更為 CometAPI 閘道即可。

注意:此 API 支援串流 (

stream: true),max_tokens、溫度、停止序列以及與其他 OpenAI 相容 API 類似的函數呼叫功能。

如何使用 Anthropic SDK 呼叫 DeepSeek?

DeepSeek 提供了一個與 Anthropic 相容的端點,因此您可以透過將 SDK 指向以下位置來重複使用 Anthropc SDK 或 Claude Code 工具 https://api.deepseek.com/anthropic 並將模型名稱設定為 deepseek-chat deepseek-reasoner 在受支持的地方)。

透過 Anthropic API 呼叫 DeepSeek 模型

安裝 Anthropic SDK:pip install anthropic。配置你的環境:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

建立訊息:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are a helpful assistant.",

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "Hi, how are you?"

}

]

}

]

)

print(message.content)

在 Claude 程式碼中使用 DeepSeek

安裝:npm install -g @anthropic-ai/claude-code。配置您的環境:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_AUTH_TOKEN=${YOUR_API_KEY}

export ANTHROPIC_MODEL=deepseek-chat

export ANTHROPIC_SMALL_FAST_MODEL=deepseek-chat

進入專案目錄,執行Claude程式碼:

cd my-project

claude

透過 CometAPI 在 Claude 程式碼中使用 DeepSeek

CometAPI 支援 Claude Code。安裝後,配置環境時,只需將基礎 URL 替換為 https://www.cometapi.com/console/ ,並將金鑰替換為 CometAPI 的 Key,即可在 Claude Code 中使用 CometAPI 的 DeepSeek 模型。

# Navigate to your project folder cd your-project-folder

# Set environment variables (replace sk-... with your actual token)

export ANTHROPIC_AUTH_TOKEN=sk-...

export ANTHROPIC_BASE_URL=https://www.cometapi.com/console/

# Start Claude Code

claude

注意:

- DeepSeek 將不受支援的 Anthropic 模型名稱對應到

deepseek-chat. - 人類相容層支持

system,messages,temperature、串流媒體、停止序列和思考數組。

具體的生產最佳實務是什麼(安全性、成本、可靠性)?

以下是適用於 DeepSeek 或任何大容量 LLM 使用情況的建議生產模式。

秘密與身份

- 將 API 金鑰儲存在秘密管理器中(不要使用

.env在生產環境中)。定期輪換密鑰,並為每個服務建立具有最小權限的密鑰。 - 為開發/準備/生產使用單獨的項目/帳戶。

速率限制和重試

- 實施 指數退避 HTTP 429/5xx 錯誤時出現抖動。限制重試次數(例如 3 次)。

- 對於可能重複的請求,請使用冪等鍵。

Python 範例 — 帶退避的重試

import time, random, requests

def post_with_retries(url, headers, payload, attempts=3):

for i in range(attempts):

r = requests.post(url, json=payload, headers=headers, timeout=60)

if r.status_code == 200:

return r.json()

if r.status_code in (429, 502, 503, 504):

backoff = (2 ** i) + random.random()

time.sleep(backoff)

continue

r.raise_for_status()

raise RuntimeError("Retries exhausted")

成本管理

- 限制

max_tokens並避免意外請求大量輸出。 - 快取模型回應 在適當的情況下(尤其是重複提示)。 DeepSeek 在定價上明確區分了快取命中和未命中——快取可以節省成本。

- 使用

deepseek-chat用於例行的小回覆;保留deepseek-reasoner對於真正需要 CoT 的情況(它更昂貴)。

可觀察性和日誌記錄

- 僅以明文形式記錄請求的元資料(例如提示雜湊值、令牌計數和延遲)。避免記錄完整的使用者資料或敏感內容。儲存請求/回應 ID 以用於支援和帳單對帳。

- 追蹤每個請求的令牌使用情況並顯示成本預算/警報。

安全與幻覺控制

- 使用 工具輸出與確定性驗證器 對於任何安全至關重要的事情(金融、法律、醫療)。

- 對於結構化輸出,使用

response_format+JSON 模式並在採取不可逆的行動之前驗證輸出。

部署模式

- 從專用工作進程運行模型呼叫來控制並發和排隊。

- 將繁重的工作卸載到非同步工作程序(Celery、Fargate 任務、Cloud Run 作業)並使用進度指示器回應使用者。

- 對於極端延遲/吞吐量需求,請考慮提供者 SLA 以及是否自架或使用提供者加速器。

結束語

DeepSeek-V3.1 是一款實用的混合模型,專為快速聊天和複雜的代理任務而設計。其與 OpenAI 相容的 API 結構使許多專案能夠輕鬆遷移,而 Anthropic 和 CometAPI 相容層則使其能夠靈活地適應現有生態系統。基準測試和社群報告顯示了良好的成本/效能權衡——但與任何新模型一樣,在全面投入生產之前,請在實際工作負載(提示、函數呼叫、安全檢查、延遲)上進行驗證。

在 CometAPI 上,您可以安全地運行它,並透過與 OpenAI 相容的 API 或使用者友好的 操場,沒有速率限制。

👉立即在 CometAPI 上部署 DeepSeek-V3.1!

為什麼要使用 CometAPI?

- 提供者多路復用:無需重寫程式碼即可切換提供者。

- 統一計費/指標:如果您透過 CometAPI 路由多個模型,您將獲得單一整合表面。

- 模型元數據:查看每個模型變體的上下文長度和活動參數。