低程式碼視覺化 AI 工具領域發展迅速。 Flowise 是一款針對 LLM 工作流程的開源視覺化建構器,它持續添加社群整合並頻繁發布更新;CometAPI 是眾多工具之一 統一的AI API 現在,這些平台可以透過單一端點公開數百個模型;而像 BuildShip 這樣的無程式碼後端建構器同樣提供了呼叫 CometAPI 的節點,以便您可以將相同的模型連接到伺服器工作流程。本指南將介紹為何以及何時組合這些部分,然後引導您完成具體的 Flowise → CometAPI 集成,以及如何連接 Prompt → LLM Chain → CometAPI,推薦的最佳實踐以及示例用例。

FlowiseAI 是什麼?它為什麼重要?

FlowiseAI 是一個開源視覺化平台,用於建立 LLM 工作流程、聊天助理和代理管道。它提供了一個由節點(整合)組成的拖放式畫布,這些節點代表提示、鏈、LLM 連接器、檢索器、記憶體、工具和輸出,讓團隊無需手動連接所有內容即可建立 LLM 驅動系統的原型並交付。 Flowise 也公開了 API、追蹤、評估工具和社群維護的節點,因此它既適用於快速原型設計,也適用於生產實驗。

為什麼這很重要: 透過使用 Flowise,您可以獲得對提示鍊和模型選擇的視覺可觀察性和快速迭代 - 並且透過新增第三方連接器(如 CometAPI),您可以以最少的變更切換或試驗許多底層模型。

CometAPI 是什麼以及它提供什麼?

CometAPI 是一個統一的 API 層,它聚合了對 數百個AI模型 (OpenAI、Anthropic/Claude、Google/Gemini、Replicate 模型、映像和音訊提供者等)均採用單一、一致的請求格式和身分驗證方案。這意味著您可以以程式設計方式選擇或切換模型、比較成本/延遲,或在提供者之間進行回退,而無需重寫應用程式程式碼。此平台定位為 LLM 和多模態模型的成本管理和與供應商無關的存取層。

這在實踐中能帶給你什麼: 更簡單的多模型評估憑證管理、快速對不同模型進行 A/B 測試的能力,以及(通常)在適當的時候透過選擇更便宜的模型變體來優化成本。

為什麼要將 FlowiseAI 與 CometAPI 整合?

將 Flowise 與 CometAPI 集成,您將能夠享受 Flowise 視覺化建構器的便利性,並透過 CometAPI 集中存取眾多模型後端。優勢包括:

- 多個模型端點的單一憑證管理(透過 CometAPI)。

- 在視覺鏈內輕鬆實現模型 A/Bing 和提供者級路由(無需更改節點接線即可切換模型)。

- 更快的實驗:交換模型、調整提示並比較 Flowise 流程中的輸出。

- 對於那些想要視覺化編排層但需要後台多個模型提供者的團隊來說,減少了工程摩擦。

- 為什麼要將 FlowiseAI 與 CometAPI 整合?

- 將 Flowise 與 CometAPI 集成,您將能夠享受 Flowise 視覺化建構器的便利性,並透過 CometAPI 集中存取眾多模型後端。優勢包括:

- 多個模型端點的單一憑證管理(透過 CometAPI)。

- 在視覺鏈內輕鬆實現模型 A/Bing 和提供者級路由(無需更改節點接線即可切換模型)。

- 更快的實驗:交換模型、調整提示並比較 Flowise 流程中的輸出。

- 對於那些想要視覺化編排層但需要後台多個模型提供者的團隊來說,減少了工程摩擦。

- 這些功能加速了 RAG 設定、代理編排和模型組合工作流程,同時保持了 Flowise 提供的視覺來源和可追溯性。

這些功能加速了 RAG 設定、代理編排和模型組合工作流程,同時保持了視覺來源和 Flowise 提供的可追溯性.

整合前需要什麼環境和前提條件?

清單(最低限度):

- 登錄到 FlowiseAI

- A 彗星API 帳戶 + API 金鑰(您可以從 CometAPI 控制台取得)。注意:CometAPI 使用基本路徑(例如

https://api.cometapi.com/v1/) 用於請求 — 您將在 Flowise 節點設定中提供該資訊。

安全和營運準備:

- 將 API 金鑰儲存在 Flowise Credentials 中 — 請勿將金鑰放在提示範本或節點程式碼中。

- 計劃配額和速率限制:CometAPI 和底層模型供應商都可能施加限制 - 檢查您的計劃並在需要時應用用戶端限製或重試。

- 觀察成本:切換模型時,您可以實質地改變代幣的使用和成本—測量指標並設定護欄。

如何將 CometAPI 與 FlowiseAI 整合? (尋找並新增 CometAPI 節點 — 步驟是什麼?)

請依照以下實際步驟添加 ChatCometAPI 節點並配置憑證。

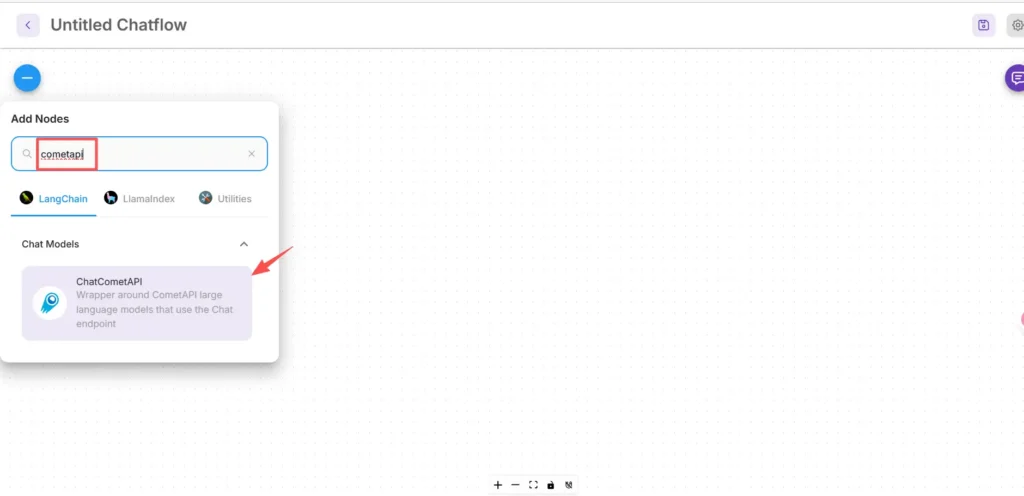

步驟 1 — 確認節點可用

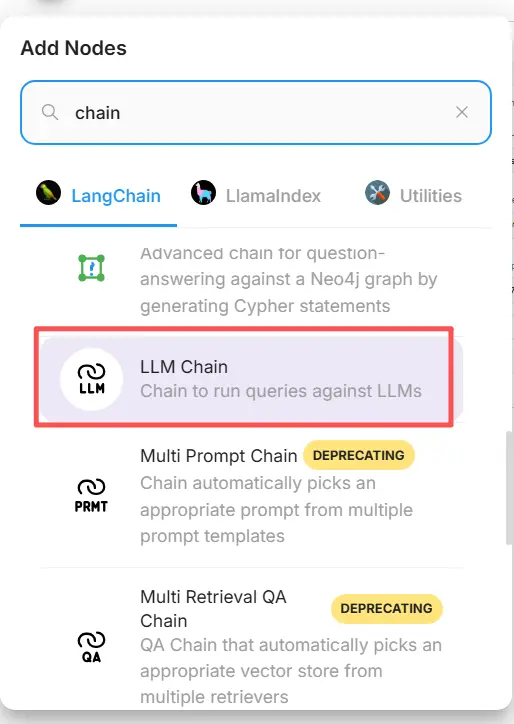

- 在 FlowiseAI 畫布中,按一下新增內容。

- 在搜尋框中輸入「cometapi」並蒐索,即可找到 CometAPI 框。部分社群節點會顯示在 LangChain → Chat Models 下。

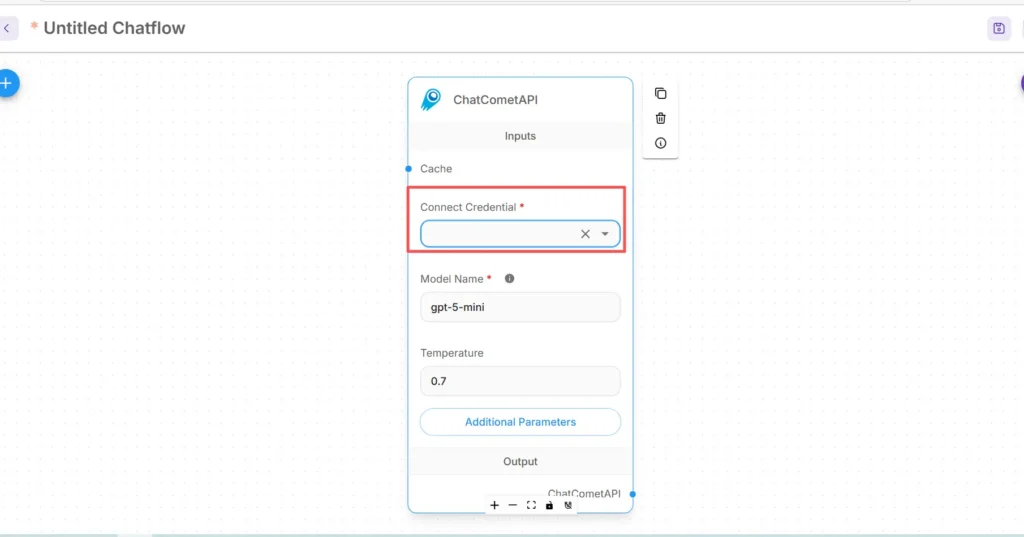

步驟 2 — 將 CometAPI 節點新增至您的流程中

- 拖動 ChatCometAPI 節點到您的工作區。此節點公開模型選擇、溫度、最大令牌和其他推理參數。

- 放置一個 開始/輸入 CometAPI 節點上游的節點(或您的聊天機器人前端節點)。

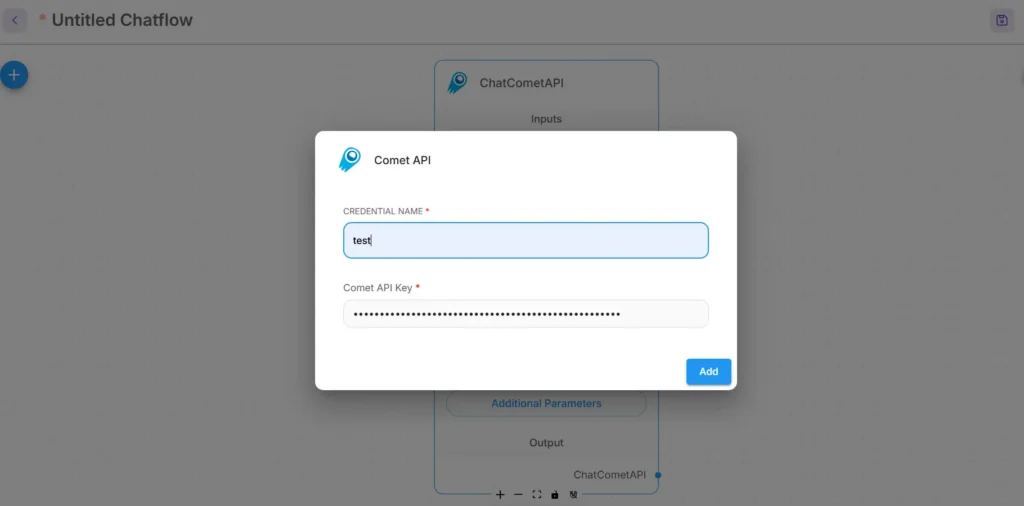

步驟 3 — 設定 CometAPI 的憑證

- 在 CometAPI 節點的 Connect Credential 下拉選單中,選擇 Create New 並找到 API密鑰 / 證書 字段。 (在 Flowise 中,或開啟 證書)

- 輸入您的 CometAPI API 金鑰 (最好透過 Flowise 的憑證管理器或作為環境變數)。在生產環境中,使用機密管理

- 選擇預設的底層模型(或者,如果您希望在運行時切換模型,則可以透過節點輸入進行調整)。 CometAPI 通常接受

model指示使用哪個供應商/型號的參數。

步驟 4 — 設定基本路徑和其他參數。

在 ChatCometAPI 節點設定中展開 附加參數 並設置 基本路徑 至 https://api.cometapi.com/v1/ (這是必需的,以便節點指向 CometAPI 的 v1 網關)。可選擇調整 CometAPI 支援的預設模型名稱或提供程序參數。

故障排除技巧:

- 如果通話失敗,請檢查網路出口以及 Flowise 和 CometAPI 端點之間的任何防火牆/NAT 規則。

- 檢查 CometAPI 回傳的速率限制和錯誤回應;在 429/5xx 上實現指數退避。

如何在 Flowise 中新增 Prompt 節點並設定 LLM 鏈?

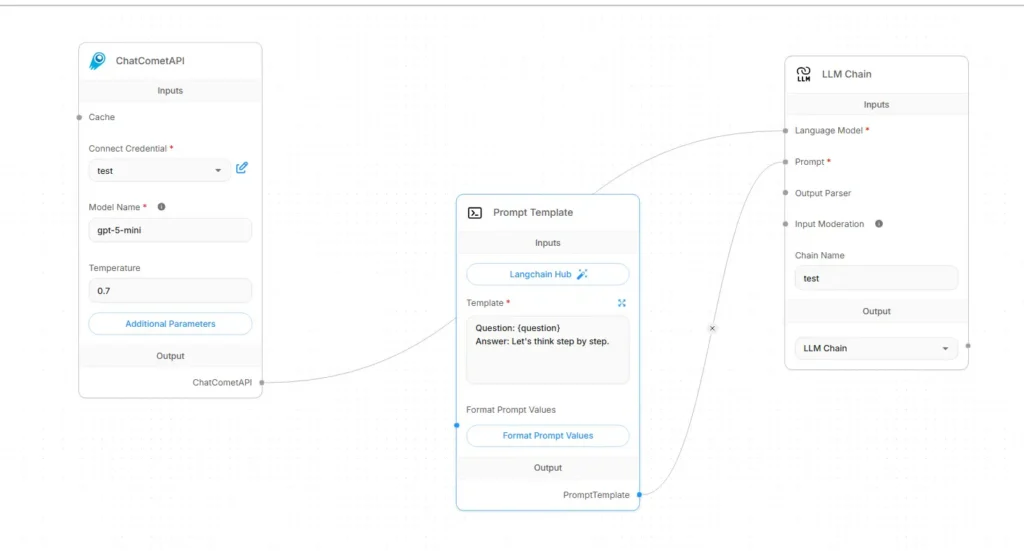

Flowise LLM 流程通常組裝為 輸入 → 提示範本 → LLM 鏈 → 輸出。以下是使用 CometAPI 作為語言模型的具體接線方法:

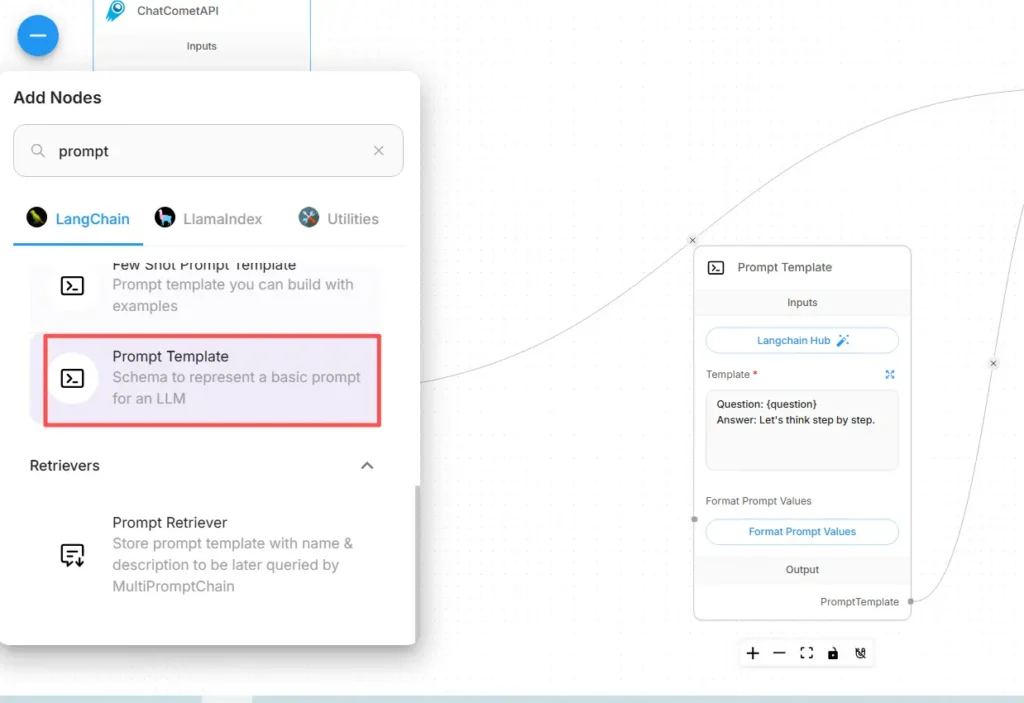

步驟 A — 建立提示範本節點

- 添加 提示模板 節點(或“提示”節點)加入到畫布。

- 在 Prompt 節點中,使用變數編寫動態內容模板,例如:

You are an expert SRE. Given the following user question: {{user_input}}

Produce a step-by-step diagnostic plan and concise summary.

- 暴露

user_input作為從 Start/Input 節點填充的變數。

步驟 B — 新增 LLM 鏈節點(LLM 包裝器)

添加一個 LLM連鎖 or LLM 表示提示 → 模型呼叫的節點。在 Flowise 中,LLM Chain 節點通常有兩個主要輸入: 語言模型 (模型/推理節點)和 提示 (提示模板)。

步驟 C — 連接節點(明確佈線)

- 將 CometAPI 節點連接到 LLM Chain 的 語言模型 輸入。

這會告訴鏈調用哪個模型進行產生。 (CometAPI 成為模型提供者。) - 將 Prompt Template 節點連接到 LLM Chain 的 提示 輸入。

該鏈將提示模板與變數值結合起來,並將產生的提示傳送給 CometAPI。 - 將 Start/Input 節點連接到提示範本的

user_input變量。 - 將 LLM Chain 輸出連接到輸出節點(UI 回應或下游工具)。

從視覺上看,流程應該是:

Start/Input → Prompt Template → LLM Chain (Language Model = CometAPI node) → Output

步驟 D — 進行試運行測試

- 在 Flowise 的測試控制台中執行流程。檢查發送到 CometAPI 的提示、回應令牌和延遲。在 CometAPI 節點設定中調整溫度、最大令牌數或最高峰值,以調整創造力與確定性之間的平衡。

這種整合可以實現哪些實際用例?

以下是 Flowise + CometAPI 帶來實際好處的強大用例:

1)多模型路由/最佳工具選擇

建立根據子任務選擇模型的流程:使用低成本模型進行快速匯總、使用高精度模型進行事實基礎分析以及透過圖像模型生成圖像 - 所有這些都透過 CometAPI 參數完成,而無需更改 Flowise 接線。

2)模型A/B測試與評估

在 Flowise 中啟動兩個並行的 LLM 鏈(A 和 B),將相同的請求路由到不同的 CometAPI 模型選項,並將結果回饋給一個小型比較器節點,該節點負責對輸出進行評分。使用指標來決定採用哪個模型。

3)混合 RAG(獵犬 + LLM)

使用 Flowise 的文件儲存和向量檢索器收集上下文,然後將組合的提示範本傳送到 CometAPI 的模型。統一的 API 簡化了用於最終合成的 LLM 的切換。

4)代理程式工具(API、DB、程式碼)

在 Flowise 代理程式內部建置工具(HTTP GET/POST、資料庫呼叫),使用 CometAPI 進行語言推理和動作選擇,並將輸出路由到連接器/工具。 Flowise 支援請求工具和代理模式。

入門

CometAPI 是一個統一的 API 平台,它將來自領先供應商(例如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等)的 500 多個 AI 模型聚合到一個開發者友好的介面中。透過提供一致的身份驗證、請求格式和回應處理,CometAPI 顯著簡化了將 AI 功能整合到您的應用程式中的過程。無論您是建立聊天機器人、影像產生器、音樂作曲家,還是資料驅動的分析流程,CometAPI 都能讓您更快地迭代、控製成本,並保持與供應商的兼容性——同時也能充分利用整個 AI 生態系統的最新突破。

首先,探索該模型的功能 游乐场 並諮詢Flowise API指南 以獲得詳細說明。造訪前請確保您已經登入CometAPI並取得API金鑰。 彗星API 提供遠低於官方價格的價格,幫助您整合。

準備出發了嗎? → 立即註冊 CometAPI !

最終建議和總結

將 Flowise 與 CometAPI 整合是一種實用的方法,可將快速視覺化編排 (Flowise) 與靈活存取眾多模型提供者 (CometAPI) 結合。此模式——將提示儲存為模板、保持模型節點解耦以及謹慎地檢測運行——使團隊能夠快速迭代並切換提供程序,而無需重寫流程。請記住要安全地管理憑證、考慮延遲和成本,並為可觀察性和治理性配置流程。