GLM-4.6 是 Z.ai(原 Zhipu AI)GLM 家族的最新重大版本:第四代、大型語言 MoE(混合專家)模型,為 代理式工作流程、長上下文推理與真實世界程式開發 進行調校。此版本著重於實用的代理/工具整合、非常大的 上下文視窗,以及可開放權重以供本地部署。

Key features

- Long context — 原生 200K token 上下文視窗(由 128K 擴展)。(docs.z.ai)

- Coding & agentic capability — 在真實世界程式開發任務上宣稱有所提升,並為代理帶來更好的工具呼叫能力。

- Efficiency — 在 Z.ai 的測試中,較 GLM-4.5 ~30% 降低 token 消耗。

- Deployment & quantization — 首次宣佈在 Cambricon 晶片上整合 FP8 與 Int4;透過 vLLM 在 Moore Threads 上原生支援 FP8。

- Model size & tensor type — 已公開的工件顯示在 Hugging Face 上是一個 ~357B 參數的模型(BF16 / F32 張量)。

Technical details

Modalities & formats. GLM-4.6 是 純文字 LLM(輸入與輸出模態:文字)。Context length = 200K tokens;max output = 128K tokens。

Quantization & hardware support. 團隊報告在 Cambricon 晶片上提供 FP8/Int4 量化,並透過 vLLM 在 Moore Threads GPU 上 原生 FP8 推論——有助於降低推論成本,並支持自建(on-prem)與國內雲端部署。

Tooling & integrations. GLM-4.6 透過 Z.ai 的 API、第三方供應網路(例如 CometAPI)發行,並整合進多種程式代理(Claude Code、Cline、Roo Code、Kilo Code)。

Technical details

Modalities & formats. GLM-4.6 是 純文字 LLM(輸入與輸出模態:文字)。Context length = 200K tokens;max output = 128K tokens。

Quantization & hardware support. 團隊報告在 Cambricon 晶片上提供 FP8/Int4 量化,並透過 vLLM 在 Moore Threads GPU 上 原生 FP8 推論——有助於降低推論成本,並支持自建(on-prem)與國內雲端部署。

Tooling & integrations. GLM-4.6 透過 Z.ai 的 API、第三方供應網路(例如 CometAPI)發行,並整合進多種程式代理(Claude Code、Cline、Roo Code、Kilo Code)。

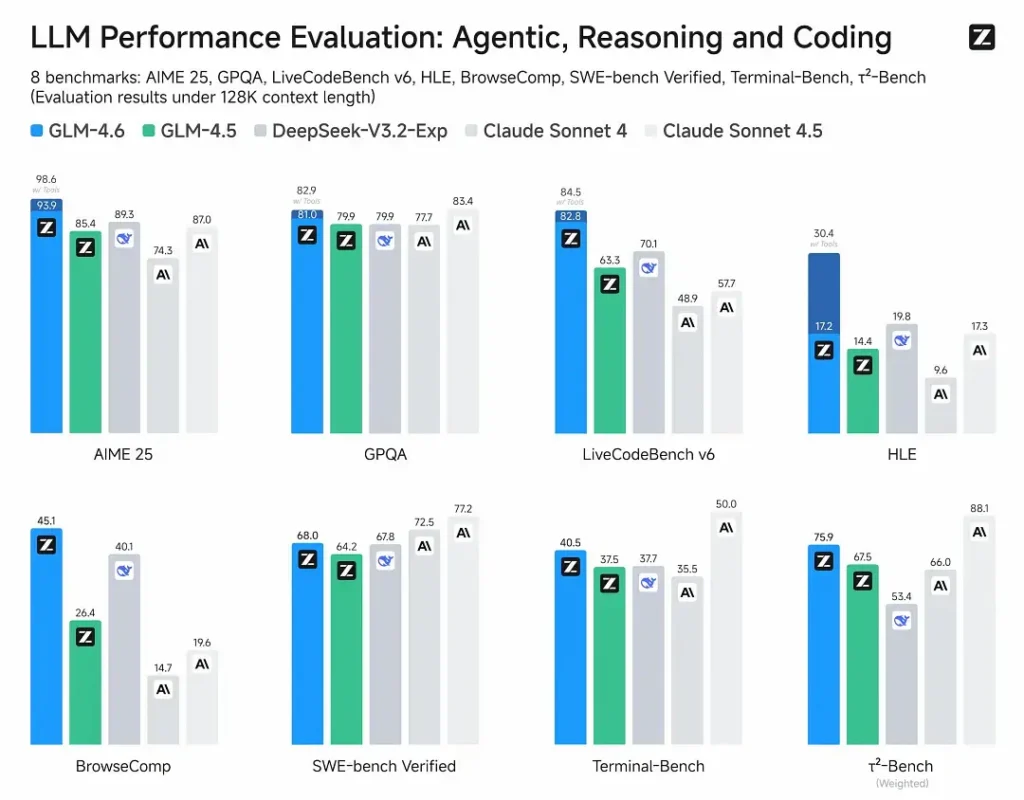

Benchmark performance

- Published evaluations: GLM-4.6 在涵蓋代理、推理與程式開發的八項公共基準上測試,顯示相較 GLM-4.5 有明顯提升。在人為評估的真實世界程式測試(擴展版 CC-Bench)中,GLM-4.6 相較 GLM-4.5 ~15% 減少 token 使用,並相對 Anthropic 的 Claude Sonnet 4 取得 ~48.6% 勝率(在許多排行榜上接近同等水準)。

- Positioning: 結果宣稱 GLM-4.6 與國內外領先模型具備競爭力(示例包括 DeepSeek-V3.1 與 Claude Sonnet 4)。

Limitations & risks

- Hallucinations & mistakes: 與當前所有 LLM 一樣,GLM-4.6 可能產生事實錯誤——Z.ai 的文件明確提醒輸出可能包含錯誤。用戶在關鍵內容上應進行驗證與檢索/RAG。

- Model complexity & serving cost: 200K 上下文與非常大的輸出大幅提升記憶體與延遲需求,可能增加推論成本;要在規模化運行需進行量化/推論工程。

- Domain gaps: 雖然 GLM-4.6 報告在代理/程式方面表現強勁,但一些公開報告指出其在特定微型基準上仍落後某些版本的競品(例如部分程式指標相較 Sonnet 4.5)。在替換生產模型前,應按任務逐一評估。

- Safety & policy: 開放權重提高可及性,同時也帶來治理問題(緩解、護欄與紅隊測試仍由用戶負責)。

Use cases

- Agentic systems & tool orchestration: 長代理追蹤、多工具規劃、動態工具呼叫;模型的代理式調校是核心賣點。

- Real-world coding assistants: 多輪程式碼生成、程式碼審查與互動式 IDE 助手(依 Z.ai,已整合至 Claude Code、Cline、Roo Code)。Token 效率提升使其對高頻使用的開發者方案更具吸引力。

- Long-document workflows: 由於 200K 視窗,可支援摘要、多文檔綜合、長篇法律/技術審閱。

- Content creation & virtual characters: 延伸對話,在多輪場景中保持一致的人設。

How GLM-4.6 compares to other models

- GLM-4.5 → GLM-4.6: 在 上下文大小(128K → 200K) 與 token 效率(在 CC-Bench 上少用 ~15% token) 上有躍升;代理/工具使用能力改進。

- GLM-4.6 vs Claude Sonnet 4 / Sonnet 4.5: Z.ai 報告稱在多個排行榜上接近同等表現,並在 CC-Bench 的真實世界程式任務上取得約 48.6% 勝率(即相當接近,部分微基準仍由 Sonnet 領先)。對許多工程團隊而言,GLM-4.6 被定位為具成本效率的替代方案。

- GLM-4.6 vs other long-context models (DeepSeek, Gemini variants, GPT-4 family): GLM-4.6 強調大上下文與代理式程式工作流程;相對優勢取決於指標(token 效率/代理整合 vs 原始程式生成準確度或安全管線)。實證選型應以任務為導向。

Zhipu AI 的最新旗艦模型 GLM-4.6 發布:355B 總參數,32B 活躍參數。核心能力全面超越 GLM-4.5。

- Coding: 與 Claude Sonnet 4 持平,為中國最佳。

- Context: 由 128K 擴展至 200K。

- Reasoning: 推理能力提升,推論期間支援工具呼叫。

- Search: 強化工具呼叫與代理效能。

- Writing: 在風格、可讀性與角色扮演上更貼近人類偏好。

- Multilingual: 提升跨語言翻譯能力。