Kimi K2 代表了開源大型語言模型的重大飛躍,它將最先進的混合專家架構與針對代理任務的專門訓練相結合。下文將探討它的起源、設計、效能以及存取和使用方面的實際考量。

Kimi K2 是什麼?

Kimi K2 是由 Moonshot AI 開發的萬億參數混合專家 (MoE) 語言模型。它擁有 32 億個「激活」參數(每個 token 參與的參數),專家參數總數達 1 萬億,從而實現了巨大的容量,且無需線性推理成本。 Kimi K2 基於 Muon 優化器構建,已在超過 15.5 兆個 token 上進行訓練,實現了先前被認為難以實現的規模下的穩定性。該模型提供兩種主要變體:

Kimi‑K2‑說明: 針對對話和代理應用程式進行了預先調整,可立即部署在對話系統和工具支援的工作流程中。

Kimi‑K2‑底座: 適用於研究、自訂微調和低階實驗的基礎模型。

它的架構如何運作?

- 混合專家(MoE): 在每一層,門控機制都會選擇一小部分專家(8 個專家中的 384 個)來處理每個標記,從而大大減少推理計算量,同時維護龐大的知識庫。

- 專用層: 包含一個密集層和總共 61 個層,其中註意力頭數量為 64 個,隱藏維度針對 MoE 效率進行了客製化。

- 上下文和詞彙: 支援最多 128 K 個上下文長度的標記和 160 K 個標記的詞彙表,從而實現長形式的理解和生成。

Kimi K2 為何重要?

Kimi K2 提供與領先的專有模型相當的性能,尤其是在編碼和推理基準方面,從而推動了開源 AI 的前沿。

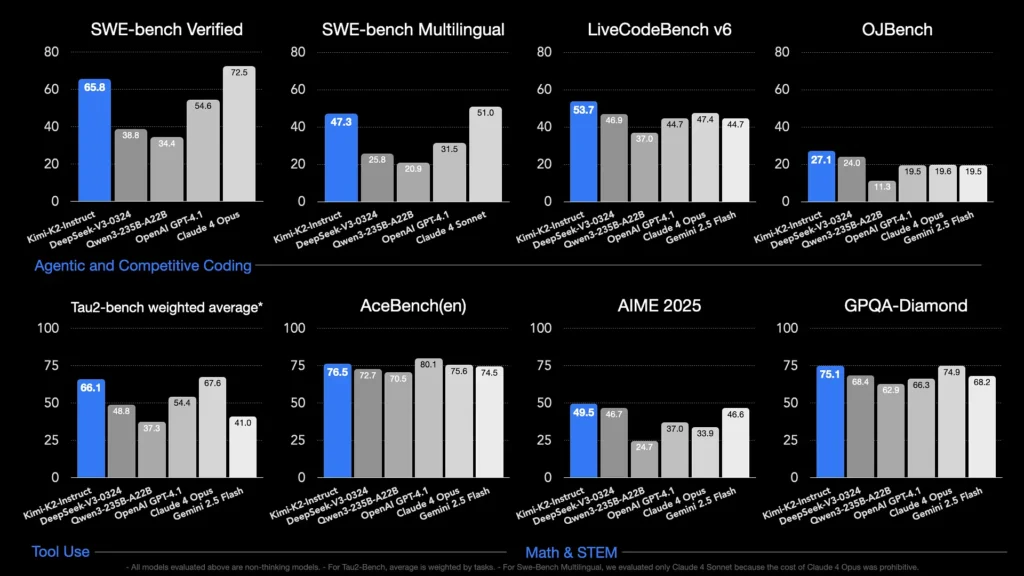

哪些基準可以展現能力?

- LiveCodeBench v6: 實現了 1% 的通過率,領先於開源模型,可與 GPT-53.7(4.1%)等封閉系統相媲美。

- 已通過 SWE‑bench 驗證: 得分為 65.8%,超過 GPT-4.1 的 54.6%,在公開的比較測試中僅次於 Claude Sonnet 4。

- MultiPL‑E 和 OJBench: 展現了強大的多語言編碼能力(MultiPL-E 上為 85.7%)和在現實世界程式設計挑戰中的可靠性能。

- 數學-500:達到 97.4%,超過 GPT-4.1 的 92.4%,展現了其在形式數學推理方面的實力。

它如何針對代理任務進行最佳化?

除了原始生成之外,Kimi K2 還接受了合成工具使用場景(模型上下文協議 (MCP) 資料)的訓練,能夠調用外部工具、推理多步驟流程並自主解決問題。這使得它在 Cline 等環境中表現尤為出色,能夠無縫協調程式碼執行、API 互動和工作流程自動化。

我如何造訪 Kimi K2?

存取選項涵蓋官方平台、開源發行版和第三方集成,滿足研究、開發和企業需求。

官方 Moonshot AI 平台

Moonshot AI 透過其平台提供託管推理功能,為 Kimi-K2-Base 和 Kimi-K2-Instruct 兩個版本提供低延遲 API 存取。定價基於運算消耗量,企業計畫包含優先支援和本地部署。用戶可以在 Moonshot AI 網站上註冊並取得 API 金鑰,以便立即整合。

彗星API

CometAPI 已將 K2 整合到其產品中。它將 K2 推理與託管 GPU 基礎架構、SLA 保證和可擴展的定價層級捆綁在一起,使組織能夠選擇按使用量付費的 API 或具有批量折扣的預留容量。

CometAPI 是一個統一的 API 平台,它將來自領先供應商(例如 OpenAI 的 GPT 系列、Google 的 Gemini、Anthropic 的 Claude、Midjourney、Suno 等)的 500 多個 AI 模型聚合到一個開發者友好的介面中。透過提供一致的身份驗證、請求格式和回應處理,CometAPI 顯著簡化了將 AI 功能整合到您的應用程式中的過程。

開發人員可以訪問 Kimi K2 API(kimi-k2-0711-preview)透過 彗星API。首先,探索該模型的功能 游乐场 並諮詢 API指南以獲得詳細說明。造訪前請確保您已經登入CometAPI並取得API金鑰。

第三方工具集成

- 克萊恩: 一個流行的以代碼為中心的 IDE,透過

cline:moonshotai/kimi-k2提供者,讓開發人員可以在編輯器中一鍵存取聊天、程式碼產生和代理工作流程。 - 擁抱臉部空間: 社群託管的演示和精簡的使用者介面 (UI) 允許使用者直接在瀏覽器中與 K2-Instruct 模型進行互動。需要 Hugging Face 帳戶,且效能可能會因共享的後端資源而異。

如何使用 Kimi K2?

一旦您選擇了一種存取方法,您就可以使用 K2 執行各種任務——從聊天到程式碼執行再到自主代理。

透過 API 或平台 SDK

- 認證: 從 Moonshot AI 或 CometAPI 檢索您的 API 金鑰。

- 初始化客戶端: 使用官方 SDK(Python/JavaScript)或標準 HTTP 請求。

- 選擇型號變體:

- Kimi‑K2‑Base 進行微調和研究。

- Kimi‑K2‑指導 用於即插即用聊天和代理。

- CometAPI的模型:

kimi-k2-0711-preview

- 發送提示: 根據聊天範本(系統、使用者、助理角色)格式化輸入,以利用最佳化的指令遵循行為。

使用 llama.cpp 在本地運行

對於離線或自託管設置,請使用 Unsloth 量化的 GGUF 權重(245 位元動態量化為 1.8 GB)。

- 下載權重: 來自 Moonshot AI GitHub 或 Hugging Face 儲存庫。

- 安裝llama.cpp: 確保您有足夠的磁碟(≥ 250 GB)和組合 RAM+VRAM(≥ 250 GB)以實現~5 個令牌/秒的吞吐量。

- 發射模型:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - 調整設置: 使用推薦參數(

rope_freq_base,context_len) 在 Unsloth 指南中記錄了穩定性能。

與開發工具集成

- IDE插件: 一些社群外掛程式可在 VS Code、Neovim 和 JetBrains IDE 中啟用 K2。配置通常涉及在設定中指定 API 端點和模型 ID。

- 自動化框架: 利用 K2 的代理核心和 LangChain 或 Haystack 等框架將提示、API 呼叫和程式碼執行步驟連結到複雜的自動化。

Kimi K2 的典型用例有哪些?

K2 的規模、代理培訓和開放存取相結合,使其能夠跨領域靈活運用。

編碼協助

從樣板生成和重構到錯誤修復和效能分析,K2 的 SOTA 編碼基準轉化為現實世界的生產力提升——通常在可讀性和簡單性方面優於替代方案。

知識與推理

K128 擁有 2 K 的上下文長度,能夠處理長文檔、多文檔問答和思維鍊式推理。其 MoE 架構確保了多樣化知識的保留,避免災難性遺忘。

代理商工作流程

K2 擅長協調多步驟任務(獲取資料、呼叫 API、更新程式碼庫和匯總結果),使其成為客戶支援、資料分析和 DevOps 中的自主助理的理想選擇。

Kimi K2 與其他開源車型相比如何?

儘管 DeepSeek 的 V3 和 Meta 的最新公開版本在 2025 年初佔據了各大媒體的頭條,但 Kimi K2 的獨特之處在於:

代理智能

Kimi K2 專為「代理」工作流程而設計—透過工具呼叫、shell 命令、Web 自動化和 API 整合實現任務自動化。其自演增強訓練資料集包含豐富的工具呼叫範例,可與實際系統無縫整合。

成本效益

與 Claude Sonnet 80 等模型相比,Kimi K90 的每個令牌推理成本降低了約 4-2%,它提供了企業級性能,且價格不菲,從而促進了對價格敏感的開發人員的快速採用。

許可證和可訪問性

與某些受限制性許可約束的開源版本不同,Kimi K2 採用寬鬆的許可,允許商業使用、衍生作品和本地部署,符合 Moonshot AI 的開源精神。

- Kimi K2 融合了前沿的 MoE 設計、嚴格的智能體訓練和開源可用性,賦能開發者和研究人員構建智能自主的應用程序,無需高昂的成本或封閉的生態系統。無論您是編寫程式碼、建立複雜的多步驟工作流程,還是進行大規模推理實驗,K2 都能為您提供多功能、高效能的基礎。