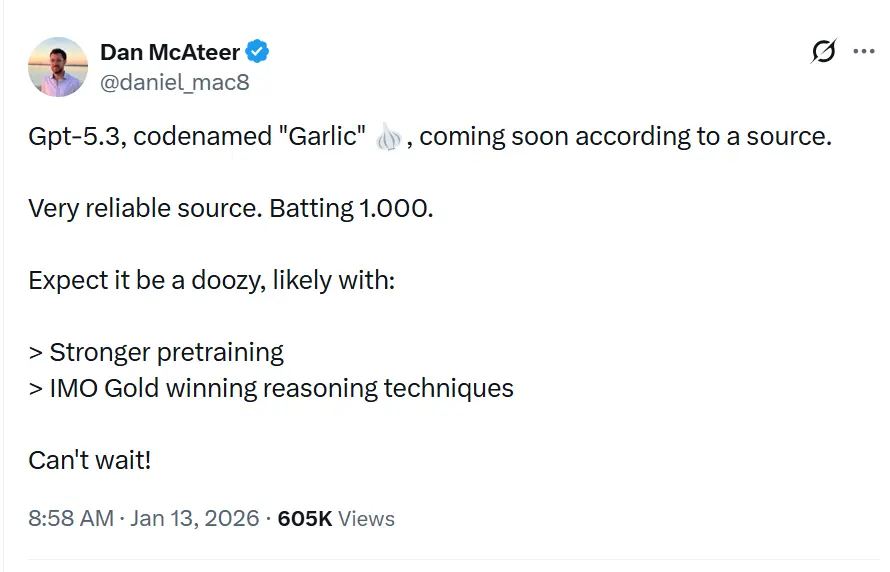

Kodenavnet GPT-5.3“Garlic” beskrives i læk og rapportering som den næste inkrementelle/iterative GPT-5.x-udgivelse, der skal lukke huller i ræsonnering, kodning og produktydelse for OpenAI som svar på konkurrencepres fra Googles Gemini og Anthropics Claude.

OpenAI eksperimenterer med en tættere, mere effektiv GPT-5.x-iteration, der fokuserer på stærkere ræsonnering, hurtigere inferens og længere kontekstarbejdsgange frem for udelukkende stadig større parameterantal. Dette er ikke blot endnu en iteration i serien af Generative Pre-trained Transformers; det er en strategisk modoffensiv. Født af en intern "Code Red" erklæret af CEO Sam Altman i december 2025 repræsenterer "Garlic" et opgør med "større er bedre"-dogmet, der har styret LLM-udviklingen i et halvt årti. I stedet satses der på en ny metrik: kognitiv densitet.

Hvad er GPT-5.3 “Garlic”?

GPT-5.3 — kodenavn “Garlic” — beskrives som det næste iterative skridt i OpenAIs GPT-5-familie. Kilder, der rammesætter lækket, positionerer Garlic ikke som et simpelt checkpoint eller token-justering, men som en målrettet arkitektur- og træningsforfining: målet er at udtrække højere ræsonneringsydelse, bedre flertrinsplanlægning og forbedret langkontekst-adfærd fra en mere kompakt, inferenseffektiv model frem for at læne sig udelukkende på rå skala. Denne rammesætning flugter med bredere branchetendenser mod “tætte” eller “højeffektivitet”-modeldesigns.

Tilnavnet "Garlic"—en markant afvigelse fra de himmelske (Orion) eller botanisk-søde (Strawberry) kodenavne fra tidligere—er angiveligt en bevidst intern metafor. Ligesom et enkelt hvidløgsfed kan give en hel ret mere intens smag end større, mere fad ingredienser, er denne model designet til at levere koncentreret intelligens uden det massive beregningsmæssige overhead fra branchens giganter.

“Code Red”-oprindelsen

Garlics eksistens kan ikke adskilles fra den eksistentielle krise, der fødte den. I slutningen af 2025 befandt OpenAI sig i en "defensiv position" for første gang siden lanceringen af ChatGPT. Googles Gemini 3 havde erobret tronen for multimodale benchmarks, og Anthropics Claude Opus 4.5 var blevet de facto-standarden for kompleks kodning og agentiske arbejdsgange. Som svar satte OpenAI-ledelsen perifere projekter på pause—herunder annonceplatformseksperimenter og forbrugeragent-udvidelser—for at fokusere fuldstændigt på en model, der kunne udføre et "taktisk angreb" på disse konkurrenter.

Garlic er det angreb. Den er ikke designet til at være verdens største model; den er designet til at være den klogeste per parameter. Den samler forskningslinjer fra tidligere interne projekter, især "Shallotpeat", og inkorporerer fejlrettelser og fortræningseffektiviseringer, der gør det muligt for den at slå langt over sin vægtklasse.

Hvad er den aktuelle status for GPT-5.3-modellens observerede iterationer?

Fra midten af januar 2026 er GPT-5.3 i de sidste faser af intern validering, en fase i Silicon Valley ofte beskrevet som "hærdning". Modellen er i øjeblikket synlig i interne logs og er blevet spot-testet af udvalgte enterprise-partnere under strenge fortrolighedsaftaler.

Observerede iterationer og "Shallotpeat"-integration

Vejen til Garlic var ikke lineær. Lækkede interne memoer fra Chief Research Officer Mark Chen antyder, at Garlic faktisk er en komposit af to forskellige forskningsspor. Indledningsvis udviklede OpenAI en model med kodenavnet "Shallotpeat", som var tiltænkt som en direkte inkrementel opdatering. Under fortræningen af Shallotpeat opdagede forskere imidlertid en ny metode til at "komprimere" ræsonneringsmønstre—i praksis at lære modellen at kassere redundante neurale stier tidligere i træningsprocessen.

Denne opdagelse førte til, at den selvstændige Shallotpeat-udgivelse blev skrottet. Dens arkitektur blev fusioneret med den mere eksperimentelle "Garlic"-gren. Resultatet er en hybriditeration, der besidder stabiliteten fra en moden GPT-5-variant, men den eksplosive ræsonneringseffektivitet fra en ny arkitektur.

Hvornår kan vi udlede, at udgivelsen vil finde sted?

At forudsige OpenAI-udgivelsesdatoer er notorisk svært, men "Code Red"-status accelererer standardtidslinjer. Baseret på konvergensen af læk, leverandøropdateringer og konkurrentcyklusser kan vi triangulere et udgivelsesvindue.

Primært vindue: 1. kvartal 2026 (januar - marts)

Konsensus blandt insidere er en udgivelse i 1. kvartal 2026. "Code Red" blev erklæret i december 2025 med en direktive om at udgive "så snart som muligt". I betragtning af at modellen allerede er i check/validering (og at "Shallotpeat"-fusionen har accelereret tidslinjen) virker slutningen af januar eller begyndelsen af februar mest plausibel.

Beta-udrulningen

Vi kan se en gradvis udrulning:

- Sen januar 2026: En "preview"-udgivelse til udvalgte partnere og ChatGPT Pro-brugere (muligvis under mærket "GPT-5.3 (Preview)").

- Februar 2026: Fuld API-tilgængelighed.

- Marts 2026: Integration i den gratis ChatGPT-klasse (begrænsede forespørgsler) for at modvirke Geminis gratis tilgængelighed.

3 definerende funktioner ved GPT-5.3?

Hvis rygtet holder, vil GPT-5.3 introducere en række funktioner, der prioriterer nytte og integration frem for rå generativ kreativitet. Funktionssættet læser som en ønskeliste for systemsarkitekter og enterprise-udviklere.

1. Høj-densitets fortræning (EPTE)

Garlics kronjuvel er dens Enhanced Pre-Training Efficiency (EPTE).

Traditionelle modeller lærer ved at se enorme datamængder og skabe et vidtforgrenet netværk af associationer. Garlics træningsproces involverer angiveligt en "beskærings"-fase, hvor modellen aktivt kondenserer information.

- Resultatet: En model, der er fysisk mindre (målt i VRAM-krav) men bevarer "verdensviden" fra et langt større system.

- Fordelen: Hurtigere inferenshastigheder og markant lavere API-omkostninger, der adresserer "intelligens-til-omkostning"-forholdet, som har forhindret masseadoption af modeller som Claude Opus.

2. Indbygget agentisk ræsonnering

I modsætning til tidligere modeller, der krævede "wrappers" eller kompleks prompt engineering for at fungere som agenter, har Garlic indbyggede værktøjsopkaldskapaciteter.

Modellen behandler API-kald, kodeeksekvering og databaseforespørgsler som "førsteklasses borgere" i sit ordforråd.

- Dybt integreret: Den "ved" ikke kun, hvordan man koder; den forstår kode-miljøet. Den kan angiveligt navigere i et filkatalog, redigere flere filer samtidig og køre sine egne enhedstests uden eksterne orkestreringsscripts.

3. Massive kontekst- og outputvinduer

For at konkurrere med Geminis million-token-vindue rygtes det, at Garlic leveres med et 400.000-token kontekstvindue. Selvom det er mindre end Googles tilbud, er nøgleforskellen "perfekt recall" over det vindue, ved hjælp af en ny opmærksomhedsmekanisme, der forhindrer det almindelige "midten-af-kontekst"-tab i 2025-modeller.

- 128k outputgrænse: Måske endnu mere spændende for udviklere er den rygtede udvidelse af outputgrænsen til 128.000 tokens. Dette vil gøre det muligt for modellen at generere hele softwarebiblioteker, omfattende juridiske notater eller romaner i fuld længde i én omgang, hvilket eliminerer behovet for "chunking".

4. Drastisk reduceret hallucination

Garlic anvender en eftertræningsforstærkningsteknik med fokus på "epistemisk ydmyghed"—modellen trænes rigorøst til at vide, hvad den ikke ved. Interne tests viser en hallucinationsrate, der er markant lavere end GPT-5.0, hvilket gør den anvendelig i højrisikoindustrier som biomedicin og jura.

Hvordan sammenlignes det med konkurrenter som Gemini og Claude 4.5?

Garlics succes vil ikke blive målt isoleret, men i direkte sammenligning med de to giganter, der i øjeblikket dominerer arenaen: Googles Gemini 3 og Anthropics Claude Opus 4.5.

GPT-5.3 “Garlic” vs. Google Gemini 3

Kampen mellem skala og densitet.

- Gemini 3: I øjeblikket "alt-i-en"-modellen. Den dominerer i multimodal forståelse (video, lyd, native billedgenerering) og har et effektivt uendeligt kontekstvindue. Den er den bedste model til "rodet" data fra virkeligheden.

- GPT-5.3 Garlic: Kan ikke konkurrere med Geminis rå multimodale bredde. I stedet angriber den Gemini på ræsonneringsrenhed. Til ren tekstgenerering, kodelogik og kompleks instruktionsfølgning sigter Garlic mod at være skarpere og mindre tilbøjelig til "afslag" eller at vandre.

- Konklusion: Hvis du skal analysere en 3-timers video, bruger du Gemini. Hvis du skal skrive backend til en bankapp, bruger du Garlic.

GPT-5.3 “Garlic” vs. Claude Opus 4.5

Kampen om udviklerens sjæl.

- Claude Opus 4.5: Udgivet i slutningen af 2025 vandt denne model udviklere med sin "varme" og "vibes". Den er berømt for at skrive ren, menneskeligt læsbar kode og for at følge systeminstruktioner med militær præcision. Den er dog dyr og langsom.

- GPT-5.3 Garlic: Dette er det direkte mål. Garlic sigter efter at matche Opus 4.5s kodekompetence men med 2x hastighed og 0,5x omkostning. Ved at bruge "høj-densitets fortræning" vil OpenAI tilbyde Opus-niveau intelligens på et Sonnet-niveau budget.

- Konklusion: "Code Red" blev specifikt udløst af Opus 4.5s dominans i kodning. Garlics succes afhænger helt af, om den kan overbevise udviklere om at skifte deres API-nøgler tilbage til OpenAI. Hvis Garlic kan kode lige så godt som Opus men køre hurtigere, vil markedet skifte med det samme.

Takeaway

Tidlige interne builds af Garlic overgår allerede Googles Gemini 3 og Anthropics Opus 4.5 i specifikke, højværdi-domæner:

- Kodningskompetence: I interne "hårde" benchmarks (ud over standard HumanEval) har Garlic vist en reduceret tendens til at sidde fast i "logiksløjfer" sammenlignet med GPT-4.5.

- Ræsonneringsdensitet: Modellen kræver færre tokens af "tænkning" for at nå korrekte konklusioner, i direkte kontrast til "chain-of-thought"-tyngden i o1 (Strawberry)-serien.

| Metric | GPT-5.3 (Garlic) | Google Gemini 3 | Claude 4.5 |

|---|---|---|---|

| Ræsonnering (GDP-Val) | 70.9% | 53.3% | 59.6% |

| Kodning (HumanEval+) | 94.2% | 89.1% | 91.5% |

| Kontekstvindue | 400K Tokens | 2M Tokens | 200K Tokens |

| Inferenshastighed | Ultra-hurtig | Moderat | Hurtig |

Konklusion

“Garlic” er et aktivt og plausibelt rygte: et målrettet OpenAI-ingeniørspor, der prioriterer ræsonneringsdensitet, effektivitet og real-world værktøjer. Dets fremkomst bør ses i lyset af et accelererende våbenkapløb blandt modeludbydere (OpenAI, Google, Anthropic) — hvor den strategiske præmie ikke kun er rå kapacitet, men anvendelig kapacitet per dollar og per millisekund latenstid.

Hvis du er interesseret i denne nye model, så følg CometAPI. Den opdaterer altid med de seneste og bedste AI-modeller til en overkommelig pris.

Udviklere kan få adgang til GPT-5.2 ,Gemini 3, Claude 4.5 gennem CometAPI nu. For at begynde, udforsk CometAPIs modelkapaciteter i Playground og se API guide for detaljerede instruktioner. Inden adgang, sørg venligst for, at du er logget ind på CometAPI og har fået API-nøglen. CometAPI tilbyder en pris langt lavere end den officielle pris for at hjælpe dig med at integrere.

Ready to Go?→ Sign up for CometAPI today !

Hvis du vil kende flere tips, guides og nyheder om AI, så følg os på VK, X og Discord!