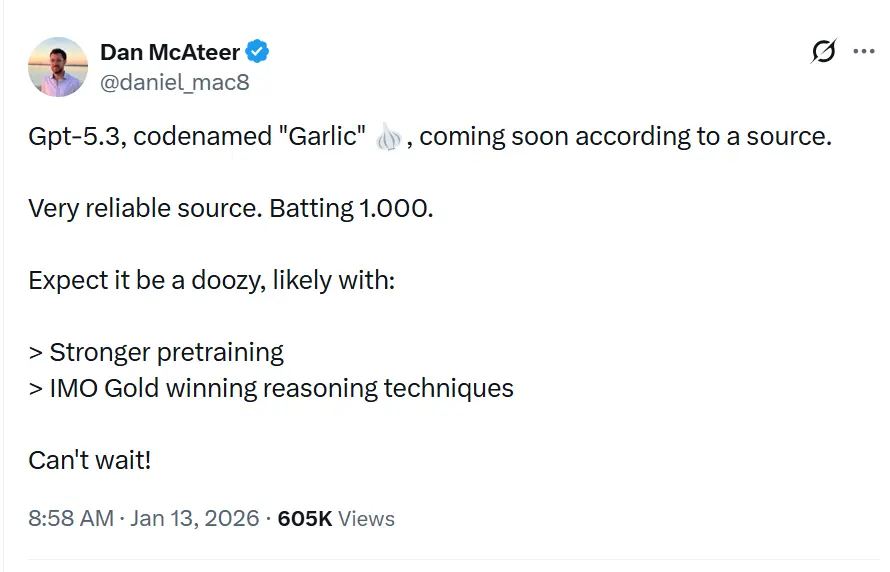

Der Codename GPT-5.3“Garlic”, wird in Leaks und Berichten als ein nächster inkrementeller/iterativer GPT-5.x-Release beschrieben, der Lücken in Reasoning, Coding und Produktleistung für OpenAI schließen soll – als Reaktion auf den Wettbewerbsdruck durch Googles Gemini und Anthropics Claude.

OpenAI experimentiert mit einer dichteren, effizienteren GPT-5.x-Iteration, die auf stärkere Reasoning-Fähigkeiten, schnellere Inferenz und Workflows mit längeren Kontexten fokussiert ist, statt ausschließlich auf immer größere Parameterzahlen. Dies ist nicht nur eine weitere Iteration der Generative Pre-trained Transformer-Serie; es ist eine strategische Gegenoffensive. Entstanden aus einem internen „Code Red“, das CEO Sam Altman im Dezember 2025 ausrief, steht „Garlic“ für eine Absage an das „größer ist besser“-Dogma, das die LLM-Entwicklung ein halbes Jahrzehnt bestimmte. Stattdessen setzt es alles auf eine neue Kennzahl: kognitive Dichte.

Was ist GPT-5.3 „Garlic“?

GPT-5.3 — Codename „Garlic“ — wird als der nächste iterative Schritt in OpenAIs GPT-5-Familie beschrieben. Quellen rahmen den Leak so, dass Garlic nicht als einfacher Checkpoint oder Token-Anpassung zu verstehen ist, sondern als gezielte Architektur- und Trainingsverfeinerung: Ziel ist es, höhere Reasoning-Performance, bessere mehrschrittige Planung und verbessertes Verhalten bei langen Kontexten aus einem kompakteren, inference-effizienten Modell zu extrahieren, anstatt sich allein auf reine Skalierung zu verlassen. Diese Einordnung entspricht breiteren Branchentrends hin zu „dichten“ bzw. hocheffizienten Modellarchitekturen.

Der Beiname „Garlic“ — eine deutliche Abkehr von früheren himmlischen (Orion) oder botanisch-süßen (Strawberry) Codenamen — ist Berichten zufolge eine bewusste interne Metapher. So wie eine einzelne Knoblauchzehe ein ganzes Gericht kräftiger würzen kann als größere, fade Zutaten, soll dieses Modell konzentrierte Intelligenz ohne den massiven Rechenaufwand der Branchenriesen bieten.

Die Entstehung von „Code Red“

Die Existenz von Garlic lässt sich nicht vom existenziellen Krisenmoment trennen, das es hervorbrachte. Ende 2025 befand sich OpenAI erstmals seit dem Start von ChatGPT in einer „Defensivposition“. Googles Gemini 3 hatte bei multimodalen Benchmarks die Krone erobert, und Anthropics Claude Opus 4.5 war de facto Standard für komplexes Coding und agentische Workflows geworden. Als Reaktion pausierte die OpenAI-Führung Nebenprojekte — darunter Experimente mit Anzeigenplattformen und Erweiterungen für Consumer-Agents — und konzentrierte sich vollständig auf ein Modell, das einen „taktischen Schlag“ gegen diese Wettbewerber ausführen konnte.

Garlic ist dieser Schlag. Es soll nicht das größte Modell der Welt sein; es soll das intelligenteste pro Parameter sein. Es vereint die Forschungslinien früherer interner Projekte, insbesondere „Shallotpeat“, und integriert Bugfixes sowie Pre-Training-Effizienzen, die ihm ermöglichen, weit über seine Gewichtsklasse hinauszuwirken.

Wie ist der aktuelle Status der beobachteten Iterationen des Modells GPT-5.3?

Stand Mitte Januar 2026 befindet sich GPT-5.3 in den letzten Phasen der internen Validierung, einer Phase, die im Silicon Valley oft als „Hardening“ bezeichnet wird. Das Modell ist derzeit in internen Logs sichtbar und wurde von ausgewählten Unternehmenskunden unter strengen Geheimhaltungsvereinbarungen stichprobenartig getestet.

Beobachtete Iterationen und Integration von „Shallotpeat“

Der Weg zu Garlic war nicht linear. Durchgesickerte interne Memos von Chief Research Officer Mark Chen deuten darauf hin, dass Garlic tatsächlich ein Komposit aus zwei unterschiedlichen Forschungspfaden ist. Zunächst entwickelte OpenAI ein Modell mit dem Codenamen „Shallotpeat“, das als direktes inkrementelles Update gedacht war. Während des Pre-Trainings von Shallotpeat entdeckten die Forscher jedoch eine neuartige Methode zur „Komprimierung“ von Reasoning-Mustern — im Grunde wurde dem Modell beigebracht, redundante neuronale Pfade früher im Trainingsprozess zu verwerfen.

Diese Entdeckung führte zur Verwerfung des eigenständigen Shallotpeat-Release. Dessen Architektur wurde mit dem experimentelleren „Garlic“-Zweig zusammengeführt. Das Ergebnis ist eine hybride Iteration, die die Stabilität einer ausgereiften GPT-5-Variante besitzt, aber die explosive Reasoning-Effizienz einer neuen Architektur mitbringt.

Wann kann der Veröffentlichungstermin abgeleitet werden?

OpenAI-Veröffentlichungstermine vorherzusagen ist berüchtigt schwierig, doch der „Code Red“-Status beschleunigt Standardzeitpläne. Auf Basis der Konvergenz von Leaks, Anbieter-Updates und Wettbewerberzyklen lässt sich ein Veröffentlichungsfenster triangulieren.

Primäres Zeitfenster: Q1 2026 (Januar - März)

Der Konsens unter Insidern ist ein Launch im Q1 2026. Das „Code Red“ wurde im Dezember 2025 ausgerufen, mit der Direktive, „so bald wie möglich“ zu veröffentlichen. Da sich das Modell bereits im Checking/Validation befindet (die „Shallotpeat“-Fusion hat den Zeitplan beschleunigt), erscheint ein Release Ende Januar oder Anfang Februar am plausibelsten.

Der „Beta“-Rollout

Es könnte einen gestaffelten Rollout geben:

- Ende Januar 2026: Eine „Preview“-Veröffentlichung für ausgewählte Partner und ChatGPT Pro-Nutzer (möglicherweise unter dem Label „GPT-5.3 (Preview)“).

- Februar 2026: Vollständige API-Verfügbarkeit.

- März 2026: Integration in die kostenlose ChatGPT-Stufe (begrenzte Anfragen), um die kostenlose Zugänglichkeit von Gemini zu kontern.

3 definierende Merkmale von GPT-5.3?

Wenn die Gerüchte zutreffen, wird GPT-5.3 ein Set von Funktionen einführen, die Nutzwert und Integration gegenüber reiner generativer Kreativität priorisieren. Das Funktionspaket liest sich wie eine Wunschliste für Systemarchitekten und Enterprise-Entwickler.

1. Hochdichtes Pre-Training (EPTE)

Das Kronjuwel von Garlic ist seine Enhanced Pre-Training Efficiency (EPTE).

Traditionelle Modelle lernen, indem sie enorme Datenmengen sehen und ein ausgedehntes Netz von Assoziationen bilden. Der Trainingsprozess von Garlic beinhaltet Berichten zufolge eine „Pruning“-Phase, in der das Modell Informationen aktiv kondensiert.

- Das Ergebnis: Ein physisch kleineres Modell (im Sinne der VRAM-Anforderungen), das dennoch das „Weltwissen“ eines deutlich größeren Systems beibehält.

- Der Nutzen: Schnellere Inferenzgeschwindigkeiten und deutlich niedrigere API-Kosten, was das „Intelligenz-zu-Kosten“-Verhältnis adressiert, das die Massenadoption von Modellen wie Claude Opus verhindert hat.

2. Natives agentisches Reasoning

Im Unterschied zu früheren Modellen, die „Wrapper“ oder komplexes Prompt-Engineering benötigen, um als Agenten zu funktionieren, verfügt Garlic über native Tool-Calling-Fähigkeiten.

Das Modell behandelt API-Aufrufe, Codeausführung und Datenbankabfragen als „First-Class Citizens“ in seinem Vokabular.

- Tiefe Integration: Es „kann nicht nur programmieren“; es versteht die Umgebung von Code. Berichten zufolge kann es ein Dateiverzeichnis navigieren, mehrere Dateien gleichzeitig bearbeiten und eigene Unit-Tests ohne externe Orchestrierungsskripte ausführen.

3. Massive Kontext- und Ausgabefenster

Um mit Geminis Millionen-Token-Fenster zu konkurrieren, soll Garlic mit einem 400.000-Token-Kontextfenster ausgeliefert werden. Zwar kleiner als das Angebot von Google, doch der entscheidende Unterschied ist die „Perfect Recall“ über dieses Fenster mittels eines neuen Attention-Mechanismus, der den bei 2025er Modellen üblichen „Verlust in der Mitte des Kontexts“ verhindert.

- 128k Ausgabelimit: Vielleicht noch spannender für Entwickler ist die gemunkelte Erweiterung des Ausgabelimits auf 128.000 Token. Das würde dem Modell erlauben, ganze Softwarebibliotheken, umfassende juristische Schriftsätze oder vollwertige Novellen in einem Durchgang zu generieren und damit „Chunking“ überflüssig zu machen.

4. Drastisch reduzierte Halluzination

Garlic nutzt eine Post-Training-Verstärkungstechnik mit Fokus auf „epistemische Bescheidenheit“ — das Modell wird rigoros darauf trainiert zu wissen, was es nicht weiß. Interne Tests zeigen eine signifikant niedrigere Halluzinationsrate als GPT-5.0, wodurch es sich für Hochrisikoindustrien wie Biomedizin und Recht eignet.

Wie schneidet es im Vergleich zu Wettbewerbern wie Gemini und Claude 4.5 ab?

Der Erfolg von Garlic wird nicht isoliert gemessen, sondern im direkten Vergleich mit den zwei Titanen, die derzeit die Arena beherrschen: Googles Gemini 3 und Anthropics Claude Opus 4.5.

GPT-5.3 „Garlic“ vs. Google Gemini 3

The Battle of Scale vs. Density.

- Gemini 3: Derzeit das „Kitchen-Sink“-Modell. Dominiert bei multimodalem Verständnis (Video, Audio, native Bilderzeugung) und verfügt faktisch über ein unendliches Kontextfenster. Es ist das beste Modell für „unordentliche“ Realdaten.

- GPT-5.3 Garlic: Kann mit Geminis reiner multimodaler Breite nicht konkurrieren. Stattdessen attackiert es Gemini über Reasoning-Purity. Für reine Textgenerierung, Code-Logik und komplexes Befolgen von Anweisungen soll Garlic schärfer sein und weniger zu „Refusal“ oder Abschweifen neigen.

- Das Urteil: Wenn Sie ein 3-Stunden-Video analysieren müssen, nutzen Sie Gemini. Wenn Sie das Backend für eine Banking-App schreiben müssen, nutzen Sie Garlic.

GPT-5.3 „Garlic“ vs. Claude Opus 4.5

The Battle for the Developer's Soul.

- Claude Opus 4.5: Ende 2025 veröffentlicht, gewann dieses Modell Entwickler mit „Wärme“ und „Vibes“. Es ist berühmt dafür, sauberen, gut lesbaren Code zu schreiben und Systemanweisungen mit militärischer Präzision zu befolgen. Allerdings ist es teuer und langsam.

- GPT-5.3 Garlic: Dies ist das direkte Ziel. Garlic will die Coding-Kompetenz von Opus 4.5 erreichen, jedoch mit 2x der Geschwindigkeit und 0.5x der Kosten. Mit „High-Density Pre-Training“ möchte OpenAI Intelligenz auf Opus-Niveau zum Sonnet-Budget anbieten.

- Das Urteil: Das „Code Red“ wurde ausdrücklich durch die Dominanz von Opus 4.5 im Coding ausgelöst. Der Erfolg von Garlic hängt vollständig davon ab, ob es Entwickler überzeugen kann, ihre API-Keys zurück zu OpenAI zu wechseln. Wenn Garlic so gut codiert wie Opus, aber schneller läuft, dreht sich der Markt über Nacht.

Fazit

Frühe interne Builds von Garlic übertreffen Googles Gemini 3 und Anthropics Opus 4.5 bereits in bestimmten, hochrelevanten Domänen:

- Programmierkompetenz: In internen „harten“ Benchmarks (jenseits des Standard-HumanEval) zeigt Garlic eine geringere Neigung, in „Logikschleifen“ festzustecken, verglichen mit GPT-4.5.

- Reasoning-Dichte: Das Modell benötigt weniger Token „Denkzeit“, um zu korrekten Schlussfolgerungen zu gelangen — ein direkter Kontrast zur „Chain-of-Thought“-Schwere der o1 (Strawberry)-Serie.

| Metrik | GPT-5.3 (Garlic) | Google Gemini 3 | Claude 4.5 |

|---|---|---|---|

| Reasoning (GDP-Val) | 70.9% | 53.3% | 59.6% |

| Coding (HumanEval+) | 94.2% | 89.1% | 91.5% |

| Kontextfenster | 400K Token | 2M Token | 200K Token |

| Inferenzgeschwindigkeit | Ultraschnell | Moderat | Schnell |

Schlussfolgerung

„Garlic“ ist ein aktives und plausibles Gerücht: ein gezielter OpenAI-Engineering-Track, der Reasoning-Dichte, Effizienz und reale Werkzeuge priorisiert. Sein Auftauchen ist im Kontext eines sich beschleunigenden Wettrüstens unter Modellanbietern (OpenAI, Google, Anthropic) zu sehen — eines Wettkampfs, bei dem der strategische Preis nicht nur rohe Fähigkeit ist, sondern nutzbare Fähigkeit pro Dollar und pro Millisekunde Latenz.

Wenn Sie an diesem neuen Modell interessiert sind, folgen Sie CometAPI. Dort gibt es stets die neuesten und besten KI-Modelle zu erschwinglichen Preisen.

Entwickler können über CometAPI jetzt auf GPT-5.2 ,Gemini 3, Claude 4.5 zugreifen. Beginnen Sie, indem Sie die Modellfähigkeiten von CometAPI im Playground erkunden und die API guide für detaillierte Anleitungen konsultieren. Bitte stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bietet einen Preis, der deutlich unter dem offiziellen liegt, um Ihnen die Integration zu erleichtern.

Ready to Go?→ Sign up for CometAPI today !

Wenn Sie mehr Tipps, Guides und News zu KI erfahren möchten, folgen Sie uns auf VK, X und Discord!