Als xAI ankündigte Grok Code Fast 1 Ende August 2025 erhielt die KI-Community ein klares Signal: Grok ist nicht mehr nur ein Konversationsassistent – es wird für Entwickler-Workflows gerüstet. Grok Code Fast 1 (kurz: Code Fast 1) ist ein speziell entwickeltes, latenzarmes und kostengünstiges Reasoning-Modell, das speziell auf Codierungsaufgaben abgestimmt ist und Agenten Codierungs-Workflows – das heißt, Workflows, in denen das Modell planen, Tools aufrufen und als autonomer Codierungsassistent in IDEs und Pipelines agieren kann. Das Modell ist bereits in Partnerintegrationen (insbesondere als Opt-in-Vorschau in GitHub Copilot) und in einer Reihe von Cloud- und Drittanbieterkatalogen wie CometAPI verfügbar.

Was ist Grok Code Fast 1 und warum ist es wichtig?

xAIs Grok-Code-Fast-1 Als bewusst fokussiertes Codierungsmodell mit geringer Latenz ist es darauf ausgerichtet, ein aktiver Partner in Entwicklertools und automatisierten Workflows zu sein. Es ist als praktischer „Paarprogrammierer“ positioniert, der auf Geschwindigkeit, die Nutzung agentenbasierter Tools (Suche, Funktionsaufrufe, Codebearbeitungen, Tests) und großkontextuelles Denken über Repositories hinweg optimiert ist. Es ist eine spezialisierte Variante der Grok-Familie von xAI, die zwei Dinge priorisiert: interaktive Geschwindigkeit kombiniert mit einem nachhaltigen Materialprofil. wirtschaftliche Token-Kosten für Codierungs-Workflows. Anstatt darum zu konkurrieren, der umfassendste, multimodale Generalist zu sein, zielt es auf die alltägliche Entwicklerschleife ab: Code lesen, Änderungen vorschlagen, Tools (Linter/Tests) aufrufen und schnell iterieren.

Warum es jetzt wichtig ist:

- Teams erwarten zunehmend sofortiges Feedback innerhalb von IDEs und CI – das Warten auf mehrere Sekunden bei jeder Assistent-Iteration unterbricht den Arbeitsfluss. Grok Code Fast 1 wurde speziell entwickelt, um diese Reibung zu reduzieren.

- Es unterstützt Funktionsaufrufe, strukturierte Ausgaben und sichtbare Argumentationsspuren, wodurch eine bessere Automatisierung mehrstufiger Aufgaben (Suchen → Bearbeiten → Testen → Validieren) ermöglicht wird. Dadurch eignet es sich ideal für agentenbasierte Codierungssysteme und orchestrierte Entwicklerassistenten.

Warum „agentisch“ hier wichtig ist

Agentenmodelle sind mehr als nur „Autovervollständigung“. Sie können:

- entscheiden, welches externe Tool aufgerufen werden soll (Tests ausführen, Paketdokumente abrufen),

- eine Aufgabe in Teilschritte aufteilen und diese ausführen,

- Geben Sie strukturierte JSON-Ergebnisse zurück oder nehmen Sie programmgesteuert Änderungen im Git-Stil vor.

Grok Code Fast 1 legt seine Argumentationsspuren bewusst offen (damit Entwickler die Gedankenkette während des Streamings überprüfen können) und betont das Aufrufen nativer Tools – zwei Funktionen, die sicheres, steuerbares Agenten-Coding unterstützen.

Leistung und Geschwindigkeit Grok Code Fast 1

Wie misst Grok die Geschwindigkeit?

„Schnell“ bezieht sich im Branding des Modells auf mehrere Dimensionen:

- Inferenzlatenz – Token-Durchsatz und Reaktionszeit beim Generieren von Code oder beim Begründen von Traces. Das Modell ist auf geringere Latenz optimiert, sodass es für interaktive IDE-Schleifen (Autovervollständigung, Codevorschläge, schnelle Fehlerbehebungen) und nicht nur für langwierige Batch-Jobs geeignet ist.

- Kosteneffizienz – Token-Preisgestaltung und Modellkonfiguration zielen darauf ab, die Kosten pro Nutzung für routinemäßige Codierungsaufgaben zu senken; auf Marktplätzen von Drittanbietern werden sie im Vergleich zu größeren, allgemeineren Modellen zu niedrigeren Preisen angeboten.

- Entwicklerproduktivität – wahrgenommene „Geschwindigkeit“ in einem Workflow: wie schnell ein Entwickler von der Eingabeaufforderung zum ausführbaren Code gelangen kann, einschließlich der Fähigkeit des Modells, Funktionen aufzurufen und strukturierte, testbare Ausgaben zurückzugeben.

Hinweise zur Leistung in der Praxis

| Aktion / Modell | Grok Code Fast 1 (Beobachtet) |

|---|---|

| Einfache Zeilenvervollständigung | Augenblicklich |

| Funktionsgenerierung (5-10 Zeilen) | <1 Sekunde |

| Komplexe Komponenten-/Dateigenerierung (50+ Zeilen) | 2-5 Sekunden |

| Refactoring einer großen Funktion | 5-10 Sekunden |

Leistungsvergleich

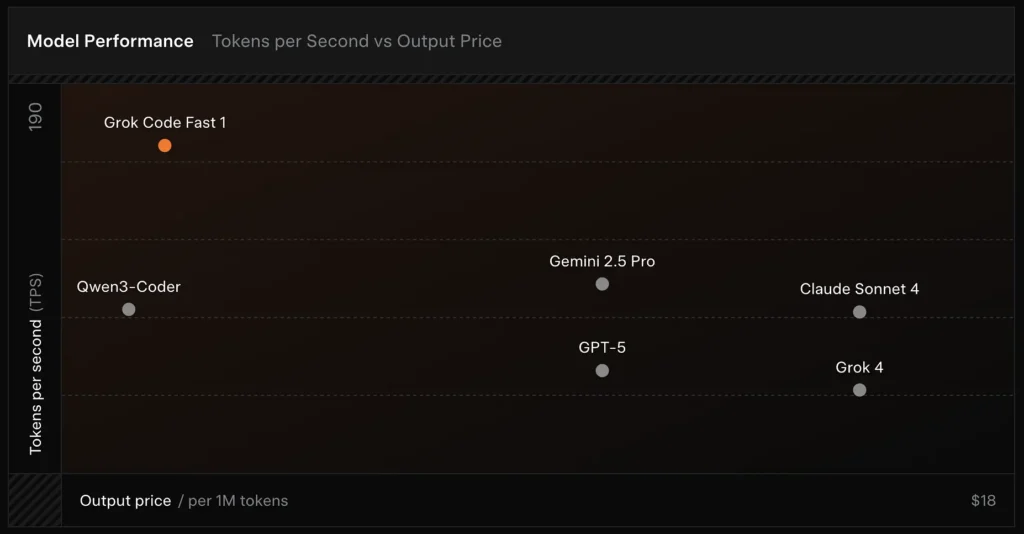

- Geschwindigkeit: Beim Testen wurden 190 Token/Sekunde erreicht.

- Preisvergleich: Die Ausgabe von GPT-5 kostet ungefähr 18 $ pro 1 Million Token, während Grok Code Fast-1 nur 1.50 $ kostet.

- Genauigkeit: 70.8 % beim SWE-Bench-Verified-Benchmark.

Designentscheidungen, die Geschwindigkeit ermöglichen

- Großes Kontextfenster (256 Token): ermöglicht dem Modell die Aufnahme großer Codebasen oder langer Konversationsverläufe ohne Kürzung, wodurch die Notwendigkeit wiederholter Kontext-Uploads reduziert wird.

- Cache-freundliche Eingabeaufforderung: Das Modell und die Plattform sind für das Zwischenspeichern von Präfix-Token optimiert, die sich zwischen Agentenschritten selten ändern. Dadurch werden wiederholte Berechnungen reduziert und die Latenz bei mehrstufigen Tool-Interaktionen verbessert.

- Natives Tool-Aufrufprotokoll: Anstelle von Ad-hoc-XML oder fehleranfälligen stringbasierten „Funktionsaufrufen“ unterstützt die API von Grok strukturierte Funktions-/Tooldefinitionen, die das Modell während seines Denkprozesses aufrufen kann (mit zurückgesendeten Zusammenfassungen oder „Denkspuren“). Dies minimiert den Analyseaufwand und ermöglicht dem Modell die zuverlässige Kombination mehrerer Tools.

Welche Funktionen bietet Grok Code Fast 1?

Nachfolgend sind die Kernfunktionen aufgeführt, die Grok Code Fast 1 für Integrationen für Entwickler attraktiv machen.

Kernkompetenzen

- Agentische Kodierung: Integrierte Unterstützung für den Aufruf von Tools (Testläufer, Linter, Paketsuchen, Git-Operationen) und das Erstellen mehrstufiger Workflows.

- Argumentationsspuren beim Streaming: Bei Verwendung im Streaming-Modus zeigt die API zwischenzeitlich „Argumentationsinhalte“ an, sodass Entwickler und Systeme die Planung des Modells beobachten und eingreifen können.

- Strukturierte Ausgaben und Funktionsaufrufe: gibt JSON- oder typisierte Ergebnisse zurück, die für die programmgesteuerte Verwendung geeignet sind (nicht nur Freitext).

- Sehr großer Kontext (256 Token): leistungsstark für dateiübergreifende Aufgaben in Einzelsitzungen.

- Schnelle Schlussfolgerung: Innovative Beschleunigungstechnologie und Prompt-Cache-Optimierung verbessern die Inferenzgeschwindigkeit erheblich. Die Reaktionsgeschwindigkeit ist extrem hoch und oft sind Dutzende von Tool-Aufrufen abgeschlossen, bis ein Benutzer mit dem Lesen einer Eingabeaufforderung fertig ist.

- Optimierung der Agentenprogrammierung: Gängige Entwicklungstools: grep, Terminaloperationen und Dateibearbeitung. Nahtlos integriert in wichtige IDEs wie Cursor, GitHub Copilot und Cline.

- Abdeckung der Programmiersprachen: Hervorragende Kenntnisse in verschiedenen Sprachen: TypeScript, Python, Java, Rust, C++ und Go. Kann eine breite Palette von Entwicklungsaufgaben bewältigen, vom Erstellen von Projekten von Grund auf bis hin zur Fehlerbehebung bei komplexen Codebasen und der Durchführung detaillierter Fehlerbehebungen.

Entwicklerergonomie

- OpenAI-kompatible SDK-Oberfläche: Die API von xAI legt Wert auf die Kompatibilität mit gängigen SDKs und bietet Migrationsanleitungen, um die Einarbeitung von Entwicklern zu verkürzen.

- CometAPI- und BYOK-Unterstützung: Drittanbieter wie CometAPI Stellen Sie Grok Code Fast 1 über REST für Teams bereit, die OpenAI-kompatible Endpunkte bevorzugen. Dies erleichtert die Integration in Toolchains, die OpenAI-ähnliche APIs erwarten.

Wie unterscheidet sich Grok Code Fast 1 von allgemeinen LLMs?

Grok Code Fast 1 verzichtet auf die Breite eines führenden Konversationsmodells und bietet stattdessen eine präzisere Abstimmung von Code, Entwicklertools und schnellen Tool-Loops. In der Praxis bedeutet dies:

- Schnellere Roundtrip-Latenz für die Token-Generierung und Tool-Aufrufe.

- Klarere, aktionsorientierte Ausgaben (strukturierte Antworten, JSON-/Funktionsaufruf-Metadaten).

- Kostenmodell, das auf Codeinteraktionen mit hohem Volumen abgestimmt ist (in vielen Gateway-Listen günstiger pro Token)

Wie agentisch ist Grok Code Fast 1 – was bedeutet „agentisches Coding“ in der Praxis?

„Agentisch“ bedeutet, dass das Modell mehrstufige Aufgaben mit externen Tool-Interaktionen planen und ausführen kann. Für Grok Code Fast 1 nimmt die agentische Leistung folgende Formen an:

- Funktionsaufruf: Grok kann Aufrufe externer Funktionen anfordern (z. B. Tests ausführen, Dateien abrufen, Linter aufrufen) und die zurückgegebenen Ergebnisse für Folgeentscheidungen einbeziehen.

- Sichtbare Argumentationsspuren: Die Ausgaben können schrittweise Schlussfolgerungen enthalten, die Sie überprüfen und zum Debuggen oder Steuern des Agentenverhaltens verwenden können. Diese Transparenz hilft bei der Automatisierung von Änderungen in einer Codebasis.

- Permanente Tool-Schleifen: Grok ist für die Verwendung in kurzen, wiederholten Planungs-, Ausführungs- und Überprüfungszyklen konzipiert, anstatt eine einzelne monolithische Antwort zu erwarten.

Anwendungsfälle, die am meisten vom Agentenverhalten profitieren

- Automatisierte Codereparatur: Fehlerhafte Tests finden, Änderungen vorschlagen, Tests ausführen, iterieren.

- Repository-Analyse: Suchen Sie in Tausenden von Dateien nach Nutzungsmustern, erstellen Sie Zusammenfassungen oder schlagen Sie Refactorings mit Zitaten zu genauen Dateien/Zeilen vor.

- Unterstützte PR-Generierung: Erstellen Sie PR-Beschreibungen, generieren Sie Diff-Patches und kommentieren Sie Tests – alles innerhalb eines orchestrierten Flows, der in CI ausgeführt werden kann.

Wie können Entwickler auf die Grok Code Fast 1-API zugreifen und sie verwenden?

xAI stellt Grok-Modelle über seine öffentliche API und Partnerintegrationen bereit. Es gibt drei gängige Zugriffsmuster:

- Direkte xAI-API — Erstellen Sie ein xAI-Konto, generieren Sie einen API-Schlüssel in der Konsole und rufen Sie die REST-Endpunkte auf. Die xAI-Dokumente zeigen die REST-Basis als

https://api.x.aiund geben Sie die Standard-Bearer-Token-Authentifizierung an. Die Dokumente und Anleitungen enthalten Curl- und SDK-Beispiele und betonen die Kompatibilität mit OpenAI-ähnlichen Anfragen für viele Tooling-Ebenen. - IDE-/Servicepartner (Vorschauintegrationen) — GitHub Copilot (Opt-in Public Preview) und weitere Partner (Cursor, Cline usw.) wurden als Startpartner angekündigt. Sie ermöglichen Grok Code Fast 1 in VS Code und ähnlichen Tools, teilweise über „Bring Your Own Key“-Flows. Wenn Sie Copilot für Pro- oder Enterprise-Level verwenden, achten Sie auf die Opt-in-Option für Grok Code Fast 1.

- Gateways von Drittanbietern (CometAPI, API-Aggregatoren) – Anbieter normalisieren API-Aufrufe zwischen verschiedenen Anbietern und bieten manchmal unterschiedliche Tarifstufen an (hilfreich für Prototyping oder Fallbacks mehrerer Anbieter). CometAPI und andere Register listen Modellkontexte, Beispielpreise und Beispielanrufe auf.

Nachfolgend finden Sie zwei praktische Codebeispiele (Python natives SDK-Streaming und REST über CometAPI), die veranschaulichen, wie Sie Grok Code Fast 1 in einer echten App ausführen können.

Gestalten Sie Ihre Werkzeuge: Registrieren Sie Funktions-/Tooldefinitionen in der Anfrage, damit das Modell sie aufrufen kann. Erfassen Sie zum Streaming

reasoning_contentum den Plan des Modells zu überwachen.

Anwendungsfallcode: Python (natives xAI SDK, Streaming-Sampler)

Dieses Beispiel ist an die Dokumentationsmuster von xAI angepasst. Ersetzen Sie

XAI_API_KEYmit Ihrem echten Schlüssel und passen Sie die Tool-Definitionen an Ihre Umgebung an. Streaming zeigt Token und Reasoning-Traces.

# Save as grok_code_fast_example.py

import os

import asyncio

# Hypothetical xai_sdk per xAI docs

import xai_sdk

API_KEY = os.getenv("XAI_API_KEY") # store your key securely

async def main():

client = xai_sdk.Client(api_key=API_KEY)

# Example: ask the model to add a unit test and fix failing code

prompt = """

Repo structure:

/src/math_utils.py

/tests/test_math_utils.py

Task: run the tests, identify the first failing test case, and modify src/math_utils.py

to fix the bug. Show the minimal code diff and run tests again.

"""

# Start a streaming sample; we want to see reasoning traces

async for chunk in client.sampler.sample(

model="grok-code-fast-1",

prompt=prompt,

max_len=1024,

stream=True,

return_reasoning=True, # stream reasoning_content when available

):

# chunk may include tokens and reasoning traces

if hasattr(chunk, "delta"):

if getattr(chunk.delta, "reasoning_content", None):

# model is exposing its internal planning steps

print("", chunk.delta.reasoning_content, flush=True)

if getattr(chunk.delta, "token_str", None):

print(chunk.delta.token_str, end="", flush=True)

if __name__ == "__main__":

asyncio.run(main())

Notizen

- Die

return_reasoning=TrueDas Flag stellt die Anleitung der Dokumentation zum Streamen von Argumentationsspuren dar – erfassen und zeigen Sie sie an, damit Sie den Plan des Modells prüfen können. - In einem echten Agenten-Setup würden Sie auch Tools registrieren (z. B.

run_tests,apply_patch) und autorisieren Sie das Modell, sie aufzurufen. Das Modell kann dann entscheiden,run_tests()und verwenden Sie Ausgaben, um einen Patch zu informieren.

Anwendungsfallcode: REST (CometAPI / OpenAI-kompatibel)

Wenn Ihr Stack REST-Endpunkte im OpenAI-Stil erwartet, CometAPI macht aus

grok-code-fast-1als kompatible Modellzeichenfolge. Das folgende Beispiel verwendet dieopenai-Stil-Clientmuster.

import os

import requests

CometAPI_KEY = os.getenv("CometAPI_API_KEY")

BASE = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {CometAPI_KEY}",

"Content-Type": "application/json",

}

payload = {

"model": "grok-code-fast-1",

"messages": [

{"role": "system", "content": "You are Grok Code Fast 1, a fast coding assistant."},

{"role": "user", "content": "Write a function in Python that merges two sorted lists into one sorted list."}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

Notizen

- CometAPI fungiert als Brücke, wenn der native gRPC- oder SDK-Zugriff in Ihrer Umgebung problematisch ist; es unterstützt denselben 256k-Kontext und stellt

grok-code-fast-1. Überprüfen Sie die Verfügbarkeit und Tarifgrenzen des Anbieters.

Was sind praktische Integrationsmuster und Best Practices?

IDE-first (Paarprogrammierung)

Betten Sie Grok Code Fast 1 als Vervollständigungs-/Assistentenmodell in VS Code oder andere IDEs ein. Verwenden Sie kurze Eingabeaufforderungen, die zu kleinen, testbaren Änderungen auffordern. Halten Sie den Assistenten in einer engen Schleife: Patch generieren → Tests ausführen → Assistent mit fehlgeschlagener Testausgabe erneut ausführen.

CI-Automatisierung

Verwenden Sie Grok Code Fast 1, um Fehler zu identifizieren, Fehlerbehebungen vorzuschlagen oder automatisch Unit-Tests für neu hinzugefügten Code zu generieren. Dank des günstigen Preises und der Architektur für geringe Latenz eignet es sich im Vergleich zu teureren Generalistenmodellen für häufige CI-Läufe.

Agentenorchestrierung

Kombinieren Sie das Modell mit robusten Tool-Schutzmechanismen: Führen Sie vorgeschlagene Patches immer in einer Sandbox aus, führen Sie die vollständige Testsuite aus und verlangen Sie bei nicht trivialen Sicherheits- oder Designänderungen eine menschliche Überprüfung. Nutzen Sie sichtbare Argumentationsspuren, um Aktionen zu prüfen und reproduzierbar zu machen.

Schnelle Engineering-Tipps

- Stellen Sie dem Modell die genauen Dateien oder ein kleines, fokussiertes Kontextfenster für Änderungen zur Verfügung.

- Bevorzugen Sie strukturierte Ausgabeschemata für Diffs oder JSON-Zusammenfassungen – diese lassen sich einfacher automatisch validieren.

- Protokollieren Sie beim Ausführen mehrstufiger Flows die Toolaufrufe und Ergebnisse des Modells, damit Sie das Agentenverhalten wiedergeben oder debuggen können.

Konkreter Anwendungsfall: Automatische Korrektur eines fehlgeschlagenen Pytest-Tests

Unten sehen Sie einen illustrativen Python-Workflow (vereinfacht), der zeigt, wie Sie Grok Code Fast 1 in eine Test-Fix-Schleife integrieren können.

# pseudo-code: agentic test-fix loop with grok-code-fast-1

# 1) collect failing test output

failing_test_output = run_pytest_and_capture("tests/test_math.py")

# 2) ask Grok to propose a patch and tests

prompt = f"""

Pyproject: repo root

Failing test output:

{failing_test_output}

Please:

1) Explain root cause briefly.

2) Provide a patch in unified diff format that should fix the issue.

3) Suggest a minimal new/updated unit test to prove the fix.

"""

resp = call_grok_model("grok-code-fast-1", prompt, show_reasoning=True)

# 3) parse structured patch from response (validate!)

patch = extract_patch_from_response(resp)

if is_patch_safe(patch):

apply_patch(patch)

test_result = run_pytest_and_capture("tests/test_math.py")

report_back_to_grok(test_result)

else:

alert_human_review(resp)

Diese Schleife zeigt, wie agentenbasiertes Verhalten (Vorschlagen → Validieren → Ausführen → Iterieren) implementiert werden kann, während der Entwickler die Kontrolle über die Anwendung der Änderungen behält.

Erste Schritte

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Entwickler können zugreifen Grok Code Fast 1 API über CometAPI,die neuste Modellversion wird immer mit der offiziellen Website aktualisiert. Erkunden Sie zunächst die Fähigkeiten des Modells in der Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → Melden Sie sich noch heute für CometAPI an !

Fazit

Grok Code Fast 1 wird nicht als das „beste“ Modell für jeden Job angepriesen. Stattdessen ist es ein Spezialist – optimiert für agentenbasierte, toolreiche Coding-Workflows, bei denen Geschwindigkeit, ein großes Kontextfenster und niedrige Kosten pro Iteration am wichtigsten sind. Diese Kombination macht es zu einem praktischen Alltagshelfer für viele Entwicklungsteams: schnell genug für Live-Editor-Erlebnisse, günstig genug für Iterationen und ausreichend transparent für eine sichere Integration mit entsprechenden Grenzen.