DeepSeek hat eine experimentell Modell genannt DeepSeek-V3.2-Exp on September 29, 2025, indem ein neuer Mechanismus für spärliche Aufmerksamkeit (DeepSeek Sparse Attention oder DSA) eingeführt wird, der auf deutlich niedrigere Inferenzkosten für Workloads mit großem Kontext abzielt – und das Unternehmen hat gleichzeitig die API-Preise um etwa die Hälfte gesenkt. Dieser Leitfaden erklärt, was das Modell ist, die Architektur/Funktionshighlights, wie man auf die API zugreift und sie verwendet (mit Codebeispielen), wie es im Vergleich zu früheren DeepSeek-Modellen abschneidet und wie seine Antworten in der Produktion analysiert und verarbeitet werden.

Was ist DeepSeek-V3.2-Exp?

DeepSeek-V3.2-Exp ist eine experimentelle Iteration im V3-Track von DeepSeek. Die für Ende September 2025 angekündigte Version ist als Zwischenschritt positioniert, der Architekturoptimierungen für erweiterte Kontextlängen validiert, und nicht als großer Sprung in der Rohgenauigkeit. Die wichtigste Innovation ist DeepSeek Sparse Attention (DSA), ein Aufmerksamkeitsmuster, das sich selektiv auf Teile einer langen Eingabe konzentriert, um Rechen- und Speicherkosten zu reduzieren und gleichzeitig die Ausgabequalität mit V3.1-Terminus vergleichbar zu halten.

Warum es in der Praxis wichtig ist:

- Kosten für Aufgaben mit langem Kontext: DSA zielt auf die quadratischen Aufmerksamkeitskosten ab und reduziert den Rechenaufwand für sehr lange Eingaben (denken Sie an die Abfrage mehrerer Dokumente, lange Transkripte, große Spielwelten). Die API-Nutzungskosten sind für typische Anwendungsfälle mit langem Kontext wesentlich niedriger.

- Kompatibilität und Zugänglichkeit: Die DeepSeek-API verwendet ein OpenAI-kompatibles Anforderungsformat, sodass viele vorhandene OpenAI-SDK-Workflows schnell angepasst werden können.

Was sind die Hauptfunktionen und die Architektur von DeepSeek V3.2-Exp?

Was ist DeepSeek Sparse Attention (DSA) und wie funktioniert es?

DSA ist ein feinkörnige spärliche Aufmerksamkeit Schema, das darauf ausgelegt ist, selektiv auf Token zu achten, anstatt die Aufmerksamkeit über den gesamten Kontext zu verteilen. Kurz gesagt:

- Das Modell wählt dynamisch Teilmengen von Token aus, die auf jeder Ebene oder in jedem Block berücksichtigt werden sollen, wodurch die FLOPs bei großen Eingabelängen reduziert werden.

- Die Auswahl ist so konzipiert, dass der „wichtige“ Kontext für Schlussfolgerungsaufgaben erhalten bleibt, indem eine Kombination aus erlernten Auswahlrichtlinien und Routing-Heuristiken genutzt wird.

DSA ist die Kerninnovation in V3.2-Exp und soll die Ausgabequalität nahe an Dense-Attention-Modellen halten und gleichzeitig die Inferenzkosten senken, insbesondere bei zunehmender Kontextlänge. In den Versionshinweisen und auf der Modellseite wird betont, dass die Trainingskonfigurationen an V3.1-Terminus angepasst wurden, sodass Unterschiede in den Benchmark-Metriken den Sparse-Attention-Mechanismus und nicht eine umfassende Trainingsänderung widerspiegeln.

Welche anderen Architekturen/Funktionen werden mit V3.2-Exp ausgeliefert?

- Hybridmodi (Denken vs. Nicht-Denken): DeepSeek stellt zwei Modell-IDs bereit:

deepseek-chat(nicht nachdenken / schnellere Antworten) unddeepseek-reasoner(Denkmodus, der Gedankenketten oder Inhalte mittlerer Art offenlegen kann). Diese Modi ermöglichen Entwicklern die Auswahl zwischen Geschwindigkeit und expliziter Argumentationstransparenz. - Sehr große Kontextfenster: Die V3.x-Familie unterstützt sehr große Kontexte (die V3-Linie bietet DeepSeek in aktuellen Updates 128 Kontextoptionen) und eignet sich daher für Workflows mit mehreren Dokumenten, lange Protokolle und wissensintensive Agenten.

- JSON-Ausgabe und strikter Funktionsaufruf (Beta): Die API unterstützt eine

response_formatObjekt, das JSON-Ausgabe erzwingen kann (und eine Betaversion mit striktem Funktionsaufruf). Dies ist hilfreich, wenn Sie für die Tool-Integration vorhersehbare, maschinenlesbare Ausgaben benötigen. - Streaming- und Reasoning-Token: Die API unterstützt Streaming-Antworten und – für Reasoning-Modelle – unterschiedliche Reasoning-Inhaltstoken (oft verfügbar unter

reasoning_content), mit dem Sie die Zwischenschritte des Modells anzeigen oder prüfen können.

Wie greife ich über CometAPI auf die DeepSeek-V3.2-Exp-API zu und verwende sie?

DeepSeek verwendet bewusst ein API-Format im OpenAI-Stil, sodass vorhandene OpenAI-SDKs oder kompatible Tools mit einer anderen Basis-URL neu angesprochen werden können. Ich empfehle CometAPI für den Zugriff auf DeepSeek-V3.2-Exp, da es kostengünstig ist und ein multimodales Aggregations-Gateway darstellt. DeepSeek stellt Modellnamen bereit, die dem V3.2-Exp-Verhalten entsprechen. Beispiele:

DeepSeek-V3.2-Exp-thinking — Argumentations-/Denkmodus auf V3.2-Exp abgebildet.

DeepSeek-V3.2-Exp-thinking – Nicht-Argumentations-/Chat-Modus auf V3.2-Exp abgebildet.

Wie authentifiziere ich mich und was ist die Basis-URL?

- Holen Sie sich einen API-Schlüssel von der CometAPI-Entwicklerkonsole (bewerben Sie sich auf deren Site).

- Basis-URL: (

https://api.cometapi.comorhttps://api.cometapi.com/v1für OpenAI-kompatible Pfade). Die OpenAI-Kompatibilität bedeutet, dass viele OpenAI-SDKs mit kleinen Änderungen auf DeepSeek umgeleitet werden können.

Welche Modell-IDs sollte ich verwenden?

DeepSeek-V3.2-Exp-thinking– Denkmodus, der Gedankenketten-/Argumentationsinhalte offenlegt. Beide wurden in den neuesten Versionshinweisen auf V3.2-Exp aktualisiert.DeepSeek-V3.2-Exp-nothinking– gedankenlose, schnellere Antworten, typische Chat-/Abschlussnutzung.

Beispiel: einfache Curl-Anfrage (Chat-Abschluss)

curl -s https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer $cometapi_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize the attached meeting transcript in 3 bullet points."}

],

"max_tokens": 512,

"stream": false

}'

Beispiel: Python (OpenAI-kompatibles Clientmuster)

Dieses Muster funktioniert, nachdem ein OpenAI-Client auf die CometAPI-Basis-URL verwiesen wurde (oder das CometAPI-SDK verwendet wurde). Das folgende Beispiel folgt dem Docs-Stil von DeepSeek:

import os

import requests

API_KEY = os.environ

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Extract action items from the following notes..."}

],

"max_tokens": 800

}

r = requests.post(url, headers=headers, json=payload)

r.raise_for_status()

print(r.json())

Es ist kein spezielles SDK erforderlich — aber wenn Sie bereits OpenAIs SDK verwenden, können Sie oft neu konfigurieren base_url kombiniert mit einem nachhaltigen Materialprofil. api_key und behalten Sie die gleichen Anrufmuster bei.

Erweiterte Nutzung: Ermöglichen von Argumentation oder reasoning_content

Wenn Sie die interne Gedankenkette des Modells benötigen (für Audits, Destillationen oder das Extrahieren von Zwischenschritten), wechseln Sie zu DeepSeek-V3.2-Exp-thinkingdem „Vermischten Geschmack“. Seine reasoning_content Feld (und zugehöriger Stream oder Token) ist in der Antwort für den Reasoning-Modus verfügbar; die API-Dokumente bieten reasoning_content als Antwortfeld, um den vor der endgültigen Antwort generierten CoT zu überprüfen. Hinweis: Die Offenlegung dieser Token kann sich auf die Abrechnung auswirken, da sie Teil der Modellausgabe sind.

Streaming und Teilupdates

- Nutzen Sie

"stream": truein Anfragen zum Empfangen von Token-Deltas über SSE (vom Server gesendete Ereignisse). stream_optionskombiniert mit einem nachhaltigen Materialprofil.include_usageermöglicht Ihnen die Anpassung, wie und wann Nutzungsmetadaten während eines Streams angezeigt werden (hilfreich für inkrementelle Benutzeroberflächen).

Wie schneidet DeepSeek-V3.2-Exp im Vergleich zu früheren DeepSeek-Modellen ab?

V3.2-Exp vs. V3.1-Terminus

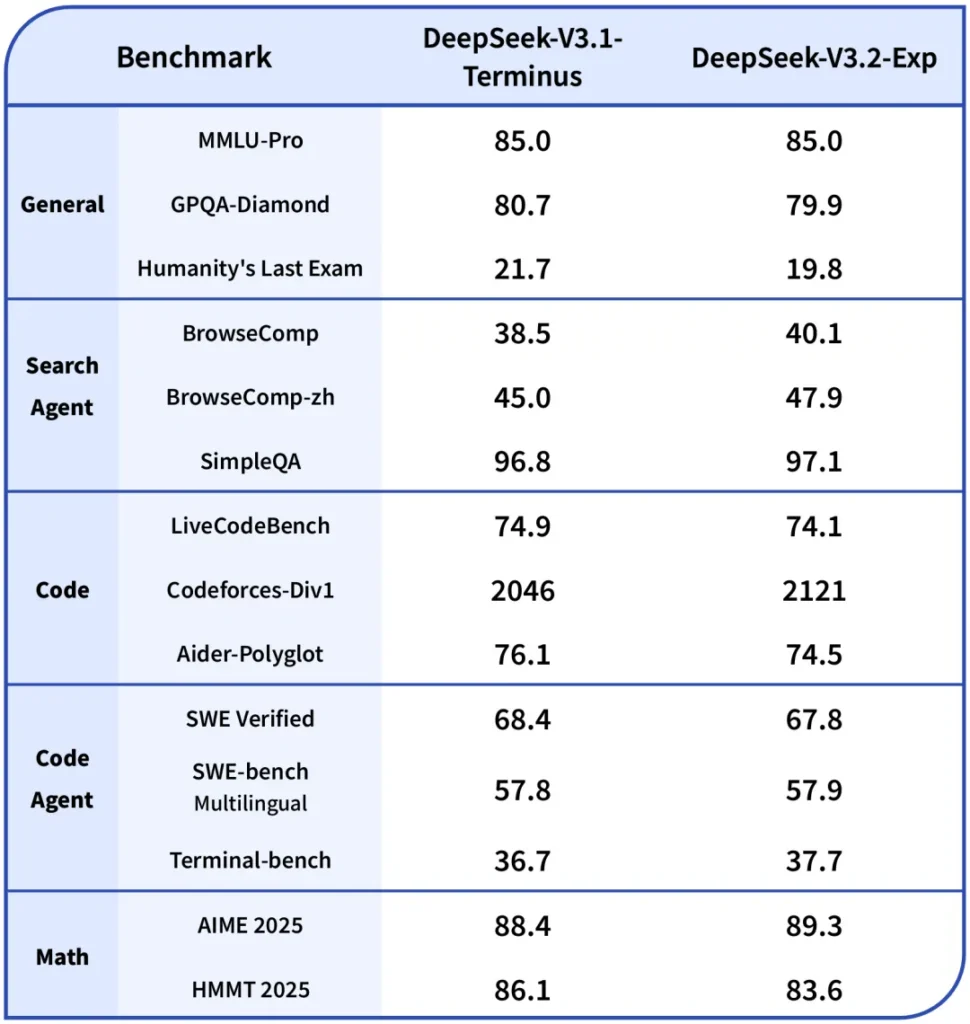

- Hauptunterschied: V3.2-Exp führt den Sparse-Attention-Mechanismus ein, um den Rechenaufwand für lange Kontexte zu reduzieren, während der Rest des Trainingsrezepts an V3.1 angepasst bleibt. Dies ermöglichte DeepSeek einen besseren Vergleich der Effizienzgewinne. ()

- Benchmarks: Öffentliche Hinweise zeigen, dass V3.2-Exp bei vielen Reasoning-/Codierungsaufgaben ungefähr die gleiche Leistung wie V3.1 erbringt, in langen Kontexten jedoch deutlich günstiger ist. Beachten Sie, dass es bei bestimmten Aufgaben immer noch zu geringfügigen Regressionen kommen kann, je nachdem, wie die Aufmerksamkeitssparsität mit den erforderlichen Token-Interaktionen interagiert.

V3.2-Exp vs. R1 / Ältere Versionen

- Die R1- und V3-Linien verfolgen unterschiedliche Designziele (R1 konzentrierte sich historisch auf unterschiedliche architektonische Kompromisse und multimodale Kapazitäten in einigen Zweigen). V3.2-Exp ist eine Verfeinerung der V3-Familie, die sich auf lange Kontexte und Durchsatz konzentriert. Wenn Ihr Arbeitspensum stark auf Single-Turn-Rohgenauigkeits-Benchmarks basiert, können die Unterschiede gering sein; wenn Sie mit Multi-Dokument-Pipelines arbeiten, ist das Kostenprofil von V3.2-Exp wahrscheinlich attraktiver.

Zugriff auf Claude Sonnet 4.5

CometAPI ist eine einheitliche API-Plattform, die über 500 KI-Modelle führender Anbieter – wie die GPT-Reihe von OpenAI, Gemini von Google, Claude von Anthropic, Midjourney, Suno und weitere – in einer einzigen, entwicklerfreundlichen Oberfläche vereint. Durch konsistente Authentifizierung, Anforderungsformatierung und Antwortverarbeitung vereinfacht CometAPI die Integration von KI-Funktionen in Ihre Anwendungen erheblich. Ob Sie Chatbots, Bildgeneratoren, Musikkomponisten oder datengesteuerte Analyse-Pipelines entwickeln – CometAPI ermöglicht Ihnen schnellere Iterationen, Kostenkontrolle und Herstellerunabhängigkeit – und gleichzeitig die neuesten Erkenntnisse des KI-Ökosystems zu nutzen.

Entwickler können zugreifen DeepSeek V3.2 Exp über CometAPI, die neuste Modellversion wird immer mit der offiziellen Website aktualisiert. Erkunden Sie zunächst die Fähigkeiten des Modells in der Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → Melden Sie sich noch heute für CometAPI an !

Fazit

DeepSeek-V3.2-Exp ist eine pragmatische experimentelle Version, die darauf abzielt, die Arbeit mit langen Kontexten kostengünstiger und praktikabler zu gestalten und gleichzeitig die Ausgabequalität der V3-Klasse beizubehalten. Für Teams, die mit langen Dokumenten, Transkripten oder Multi-Dokumenten-Argumentation arbeiten, lohnt sich ein Pilotversuch: Die API folgt einer OpenAI-ähnlichen Schnittstelle, die die Integration vereinfacht. Sie hebt sowohl den DSA-Mechanismus als auch signifikante Preissenkungen hervor, die die Wirtschaftlichkeit von Skalierungslösungen verändern. Wie bei jedem experimentellen Modell sind eine umfassende Evaluierung, Instrumentierung und ein schrittweiser Rollout unerlässlich.