DeepSeek veröffentlicht DeepSeek V3.2 und eine rechenintensive Variante DeepSeek-V3.2-SpecialeMit einer neuen Sparse-Attention-Engine (DSA), verbessertem Agenten-/Tool-Verhalten und einem „Denkmodus“ (Gedankenkettenmodus), der interne Schlussfolgerungen sichtbar macht. Beide Modelle sind über die DeepSeek-API (OpenAI-kompatible Endpunkte) verfügbar, und Modellartefakte/technische Berichte werden öffentlich zugänglich gemacht.

Was ist DeepSeek V3.2?

DeepSeek V3.2 ist der Nachfolger der DeepSeek V3-Familie – einer großen, kontextlang anwendbaren generativen Modellfamilie, die explizit für … entwickelt wurde. Argumentation zuerst Workflows und Agentennutzung. Version 3.2 konsolidiert frühere experimentelle Verbesserungen (V3.2-Exp) in eine Standardmodelllinie, die über die DeepSeek-App, die Web-Oberfläche und die API zugänglich ist. Sie unterstützt sowohl schnelle, dialogbasierte Ausgaben als auch einen dedizierten Workflow. Denken (Gedankenketten-)Modus, der sich für mehrstufige Denkaufgaben wie Mathematik, Fehlersuche und Planung eignet.

Warum Version 3.2 wichtig ist (kurzer Kontext)

DeepSeek V3.2 zeichnet sich durch drei praktische Gründe aus:

- Langer Kontext: Bis zu 128 Token-Kontextfenster, wodurch es sich für lange Dokumente, juristische Verträge oder die Recherche in mehreren Dokumenten eignet.

- Argumentationsbasiertes Design: Das Modell integriert Gedankengänge („Denken“) in Arbeitsabläufe und in die Werkzeugnutzung – eine Verlagerung hin zu agentenbasierten Anwendungen, die Zwischenschritte des Denkens benötigen.

- Kosten und Effizienz: Die Einführung von DSA (Sparse Attention) reduziert den Rechenaufwand für lange Sequenzen und ermöglicht so eine wesentlich kostengünstigere Inferenz für große Kontexte.

Was ist DeepSeek-V3.2-Speciale und wie unterscheidet es sich von der Basisversion v3.2?

Was macht die Variante „Speciale“ so besonders?

DeepSeek V3.2-Speciale ist ein Hochleistungsrechenleistung, hohes Denkvermögen Speciale ist eine Variante der v3.2-Familie. Im Vergleich zur ausgewogenen v3.2-Variante ist Speciale speziell für mehrstufiges Schließen, mathematische Aufgaben und agentenbasierte Aufgaben optimiert (und nachtrainiert). Es nutzt zusätzliches Reinforcement Learning durch menschliches Feedback (RLHF) und eine erweiterte interne Denkkette während des Trainings. Der temporäre Endpunkt und der Zugriff auf die Speciale-API sind zeitlich begrenzt (Ablaufdatum des Speciale-Pfads: 15. Dezember 2025).

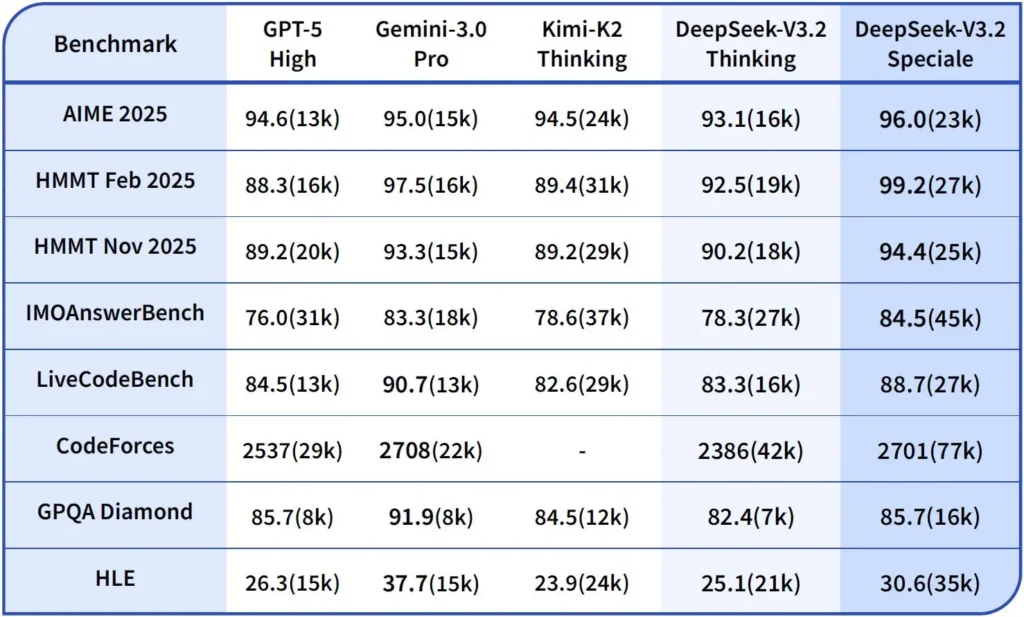

Leistung und Benchmarks

DeepSeek-V3.2-Speciale ist die rechenintensive, für logisches Denken optimierte Variante von V3.2. Die Speciale-Version integriert das vorherige mathematische Modell DeepSeek-Math-V2 und ist als Modell der Wahl positioniert, wenn die Arbeitslast dies erfordert. tiefstmögliche Gedankenkette, mehrstufige Problemlösung, wettbewerbsorientiertes Denken (z. B. im Stil der Mathematikolympiade) und komplexe agentenbasierte Orchestrierung.

Es kann selbstständig mathematische Theoreme beweisen und logische Schlussfolgerungen überprüfen; es hat in zahlreichen Weltklasse-Wettbewerben bemerkenswerte Ergebnisse erzielt:

- Goldmedaille der Internationalen Mathematik-Olympiade

- Goldmedaille der Chinesischen Mathematik-Olympiade

- ICPC (Internationaler Computerprogrammierwettbewerb) 2. Platz (Wettbewerb für Menschen)

- IOI (Internationale Informatik-Olympiade) 10. Platz (Wettbewerb der menschlichen Teilnehmer)

Was ist der Reasoning-Modus in DeepSeek v3.2?

DeepSeek legt eine explizite Denk-/Argumentationmodus was dazu führt, dass das Modell ein Ergebnis erzeugt Gedankenkette (CoT) als diskreter Teil des Ausgangssignals bevor Die endgültige Antwort. Die API stellt dieses CoT bereit, sodass Clientanwendungen es untersuchen, anzeigen oder extrahieren können.

Mechanik – was die API bietet

reasoning_contentFeldWenn der Denkmodus aktiviert ist, enthält die Antwortstruktur Folgendes:reasoning_contentFeld (das CoT) auf dem gleichen Niveau wie das FinalecontentDies ermöglicht es Clients, programmatisch auf die internen Schritte zuzugreifen.- Werkzeugaufrufe während des DenkensV3.2 soll Tool-Aufrufe unterstützen. . Der Denkprozess: Das Modell kann Denkschritte und Werkzeugaufrufe miteinander verschachteln, was die Leistung bei komplexen Aufgaben verbessert.

Wie die DeepSeek v3.2 API logisches Denken implementiert

Version 3.2 führt einen standardisierten API-Mechanismus für Argumentationsketten ein, um eine konsistente Argumentationslogik über mehrere Gesprächsrunden hinweg zu gewährleisten:

- Jede Begründungsanfrage enthält eine

reasoning_contentFeld innerhalb des Modells; - Wenn der Benutzer möchte, dass das Modell die Schlussfolgerungen fortsetzt, muss dieses Feld an den nächsten Durchlauf zurückgegeben werden.

- Wenn eine neue Frage beginnt, die alte

reasoning_contentmuss freigegeben werden, um logische Verunreinigungen zu vermeiden; - Das Modell kann die Schleife „Schlussfolgerung → Werkzeugaufruf → erneute Schlussfolgerung“ im Schlussfolgerungsmodus mehrmals ausführen.

Wie greife ich auf die DeepSeek v3.2 API zu und wie nutze ich sie?

Short: CometAPI ist ein Gateway im OpenAI-Stil, das viele Modelle (einschließlich der DeepSeek-Familien) über https://api.cometapi.com/v1 Sie können also die Modelle austauschen, indem Sie die model Zeichenketten in Anfragen. Registrieren Sie sich bei CometAPI und besorgen Sie sich zuerst Ihren API-Schlüssel.

Warum CometAPI anstelle von direktem DeepSeek verwenden?

- CometAPI zentralisiert Abrechnung, Ratenbegrenzungen und Modellauswahl (praktisch, wenn Sie den Anbieter wechseln möchten, ohne den Code zu ändern).

- Direkte DeepSeek-Endpunkte (z. B.

https://api.deepseek.com/v1Einige dieser Funktionen existieren weiterhin und stellen mitunter anbieterspezifische Merkmale dar. Wählen Sie daher CometAPI aus Gründen der Bequemlichkeit oder den direkten Anbieter-Endpunkt für anbietereigene Steuerelemente. Prüfen Sie, welche Funktionen (z. B. Speciale, experimentelle Endpunkte) über CometAPI verfügbar sind, bevor Sie sich darauf verlassen.

Schritt A – Erstellen Sie ein CometAPI-Konto und besorgen Sie sich einen API-Schlüssel.

- Gehen Sie zu CometAPI (Registrierung / Konsole) und generieren Sie einen API-Schlüssel (das Dashboard zeigt normalerweise an

sk-...). Bewahre es geheim. CometAPI

Schritt B – Bestätigen Sie die genaue Modellbezeichnung.

- Prüfen Sie die Modellliste, um die genaue Modellzeichenfolge zu bestätigen, die CometAPI bereitstellt (Modellnamen können Variantensuffixe enthalten). Verwenden Sie den Modellendpunkt, bevor Sie Namen fest codieren.

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

Suchen Sie nach dem DeepSeek-Eintrag (z. B. deepseek-v3.2 or deepseek-v3.2-exp) und notieren Sie die genaue ID. CometAPI stellt eine bereit /v1/models listing.

Schritt C – Einen einfachen Chatanruf tätigen (curl)

Ersetzen <COMET_KEY> kombiniert mit einem nachhaltigen Materialprofil. deepseek-v3.2 mit der von Ihnen bestätigten Modell-ID:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

Dies entspricht dem OpenAI-ähnlichen Aufrufmuster – CometAPI leitet an den ausgewählten Anbieter weiter.

Kompatibilität und Vorsichtsmaßnahmen

- Unterstützt die Aktivierung des Denkmodus in der Claude Code-Umgebung;

- Geben Sie in der Befehlszeile (CLI) einfach den Modellnamen deepseek-reasoner ein;

- Allerdings ist es vorerst möglicherweise nicht mit nicht standardmäßigen Tools wie Cline und RooCode kompatibel;

- Es wird empfohlen, für alltägliche Aufgaben den Nicht-Denk-Modus und für komplexe logische Schlussfolgerungen den Denk-Modus zu verwenden.

Praktische Übernahmemuster: einige Beispielarchitekturen

1 — Unterstützungsagent für Entwickler-Workflows

- Modus: Der Spezialmodus (Denkmodus) wird für die Generierung komplexer Codes und die Erstellung von Tests aufgerufen; der Schnellchat-Modus dient als Inline-Assistent.

- Sicherheit: Verwenden Sie CI-Pipeline-Prüfungen und eine Sandbox-Testausführung für generierten Code.

- Hosting: API oder selbst gehostet auf vLLM + Multi-GPU-Cluster für große Kontexte.

2 — Dokumentenanalyse für Rechts-/Finanzteams

- Modus: V3.2 mit DSA-Langkontextoptimierungen zur Verarbeitung langer Verträge und zur Erstellung strukturierter Zusammenfassungen und Aktionslisten.

- Sicherheit: Genehmigung durch einen Anwalt für nachfolgende Entscheidungen; Schwärzung personenbezogener Daten vor der Übermittlung an gehostete Endpunkte.

3 — Autonomer Datenpipeline-Orchestrator

- Modus: Denkmodus zur Planung mehrstufiger ETL-Aufgaben, Aufruf von Tools zur Abfrage von Datenbanken und Aufruf von Validierungstests.

- Sicherheit: Vor jeder irreversiblen Operation (z. B. einem destruktiven DB-Schreibvorgang) sollten eine Aktionsbestätigung und überprüfbare Kontrollen durchgeführt werden.

Alle oben genannten Muster sind mit den Modellen der V3.2-Familie heute realisierbar, allerdings muss das Modell mit Verifizierungswerkzeugen und einer konservativen Governance kombiniert werden.

Wie kann ich Kosten und Leistung mit Version 3.2 optimieren?

Nutzen Sie die beiden Modi bewusst.

- Schnellmodus für Mikrointeraktionen: Verwenden Sie den Modus „Nicht-Denkendes Werkzeug“ für kurze Abrufe, Formatkonvertierungen oder direkte API-Aufrufe, bei denen es auf die Latenz ankommt.

- Denkmodus für Planung und Verifizierung: Komplexe Aufgaben, Agenten mit mehreren Aktionen oder sicherheitsrelevante Entscheidungen werden in den Denkmodus geleitet. Zwischenschritte werden erfasst und vor der Ausführung kritischer Aktionen eine Verifizierung (automatisiert oder manuell) durchgeführt.

Welche Modellvariante soll ich wählen?

- deepseek-v3.2 — Ausgewogenes Produktionsmodell für allgemeine agentenbasierte Aufgaben.

- deepseek-v3.2-Speciale — spezialisierte Variante für rechenintensive Berechnungen; möglicherweise zunächst nur über die API verfügbar und zum Einsatz kommend, wenn Sie die bestmögliche Berechnungs-/Benchmark-Leistung benötigen (und gegebenenfalls höhere Kosten in Kauf nehmen).

Praktische Kostenkontrolltipps

- Prompt Engineering: Halten Sie Systemanweisungen kurz und vermeiden Sie redundante Kontextinformationen. Explizite Systemanweisungen: Verwenden Sie Systemaufforderungen, die den Modus verdeutlichen, z. B.: „Sie befinden sich im Denkmodus – listen Sie Ihren Plan auf, bevor Sie Tools aufrufen.“ Fügen Sie für den Tool-Modus Einschränkungen hinzu wie: „Bei der Interaktion mit der Taschenrechner-API geben Sie nur JSON mit den folgenden Feldern aus.“

- Chunking + Retrieval Augmentation: Verwenden Sie einen externen Retrieval, um nur die relevantesten Segmente für jede Benutzerfrage zu senden.

- Temperatur und Stichprobenverfahren: Niedrigere Temperatur bei Werkzeuginteraktionen erhöht den Determinismus; höhere Temperatur bei explorativen Aufgaben oder Ideenfindungsaufgaben.

Vergleichsmaßstab und Messung

- Behandeln Sie Ausgaben als unzuverlässig, bis sie verifiziert sind: Selbst logische Schlussfolgerungen können fehlerhaft sein. Fügen Sie deterministische Prüfungen (Unit-Tests, Typüberprüfungen) hinzu, bevor Sie irreversible Aktionen durchführen.

- Führen Sie A/B-Tests mit einer Beispiellast (Latenz, Token-Verbrauch, Korrektheit) durch, bevor Sie sich für eine Variante entscheiden. Version 3.2 erzielte deutliche Verbesserungen bei Benchmarks zur logischen Argumentation, das tatsächliche Anwendungsverhalten hängt jedoch von der Gestaltung der Eingabeaufforderung und der Verteilung der Eingaben ab.

FAQ

F: Wie lässt sich der CoT am besten aus dem Modell ermitteln?

A: Verwenden Sie das deepseek-reasoner Modell oder Set thinking/thinking.type = enabled in Ihrer Anfrage. Die Antwort beinhaltet reasoning_content (CoT) und das Finale content.

F: Kann das Modell im Denkmodus externe Tools aufrufen?

A: Ja – Version 3.2 führte die Möglichkeit ein, Werkzeuge sowohl im Denk- als auch im Nicht-Denkmodus zu verwenden; das Modell kann während interner Schlussfolgerungen strukturierte Werkzeugaufrufe ausgeben. strict Modus und klare JSON-Schemas, um fehlerhafte Aufrufe zu vermeiden.

F: Führt die Verwendung des Denkmodus zu höheren Kosten?

A: Ja – der Denkmodus erzeugt Zwischen-CoT-Token, was den Tokenverbrauch und damit die Kosten erhöht. Gestalten Sie Ihr System so, dass der Denkmodus nur bei Bedarf aktiviert wird.

F: Welchen Endpunkt und welche Basis-URL sollte ich verwenden?

A: CometAPI bietet OpenAI-kompatible Endpunkte. Die Standard-Basis-URL lautet: https://api.cometapi.com und der primäre Chat-Endpunkt ist /v1/chat/completions (oder /chat/completions abhängig von der gewählten Basis-URL).

F: Ist für die Werkzeugaufruffunktion ein spezielles Werkzeug erforderlich?

A: Nein – die API unterstützt strukturierte Funktionsdeklarationen in JSON. Sie müssen die tools Parameter, die Tool-Schemas und die Verwaltung des JSON-Funktionslebenszyklus in Ihrer Anwendung: Empfangen von Funktionsaufruf-JSON, Ausführen der Funktion und anschließendes Zurückgeben der Ergebnisse an das Modell zur Fortsetzung oder zum Abschluss. Der Denkmodus fügt die Anforderung hinzu, die Ergebnisse zurückzugeben. reasoning_content zusammen mit den Tool-Ergebnissen.

Fazit

DeepSeek V3.2 und DeepSeek-V3.2-Speciale stellen einen klaren Schritt hin zu offen, vernunftzentriert LLMs, die Gedankengänge explizit machen und agentenbasierte Werkzeug-Workflows unterstützen. Sie bieten leistungsstarke neue Grundbausteine (DSA, Denkmodus, Werkzeugnutzungstraining), die die Entwicklung vertrauenswürdiger Agenten vereinfachen können – vorausgesetzt, Tokenkosten, sorgfältiges Zustandsmanagement und operative Kontrollen werden berücksichtigt.

Entwickler können zugreifen Deepseek v3.2 API usw. über CometAPI, die neuste Modellversion wird immer mit der offiziellen Website aktualisiert. Erkunden Sie zunächst die Fähigkeiten des Modells in der Spielplatz und konsultieren Sie die API-Leitfaden Für detaillierte Anweisungen. Stellen Sie vor dem Zugriff sicher, dass Sie sich bei CometAPI angemeldet und den API-Schlüssel erhalten haben. CometAPI bieten einen Preis weit unter dem offiziellen Preis an, um Ihnen bei der Integration zu helfen.

Bereit loszulegen? → Kostenlose Testversion von deepseek v3.2 !

Wenn Sie weitere Tipps, Anleitungen und Neuigkeiten zu KI erfahren möchten, folgen Sie uns auf VK, X kombiniert mit einem nachhaltigen Materialprofil. Discord!