Gemini 3 Pro (Preview) ist das neueste multimodale Reasoning-Flaggschiffmodell von Google/DeepMind in der Gemini-3-Familie. Es wird als ihr „bisher intelligentestes Modell“ positioniert, entwickelt für tiefes Reasoning, agentische Workflows, fortgeschrittenes Coding sowie langkontextuelles multimodales Verständnis (Text, Bilder, Audio, Video, Code und Tool-Integrationen).

Wichtige Funktionen

- Modalitäten: Text, Bild, Video, Audio, PDFs (und strukturierte Tool-Ausgaben).

- Agentik/Tooling: Integriertes Function Calling, Search-as-Tool, Codeausführung, URL-Kontext und Unterstützung für die Orchestrierung mehrstufiger Agenten. Ein Thought-Signature-Mechanismus bewahrt mehrschrittiges Reasoning über Aufrufe hinweg.

- Coding & „Vibe-Coding“: Optimiert für Frontend-Generierung, interaktive UI-Generierung und agentisches Coding (führt laut Google relevante Bestenlisten an). Es wird als ihr bislang stärkstes „Vibe-Coding“-Modell vermarktet.

- Neue Entwicklereinstellungen:

thinking_level(low|high) zum Abwägen von Kosten/Latenz gegenüber Reasoning-Tiefe sowiemedia_resolutionzur Steuerung der multimodalen Wiedergabetreue pro Bild oder Videoframe. Diese helfen, Performance, Latenz und Kosten auszubalancieren.

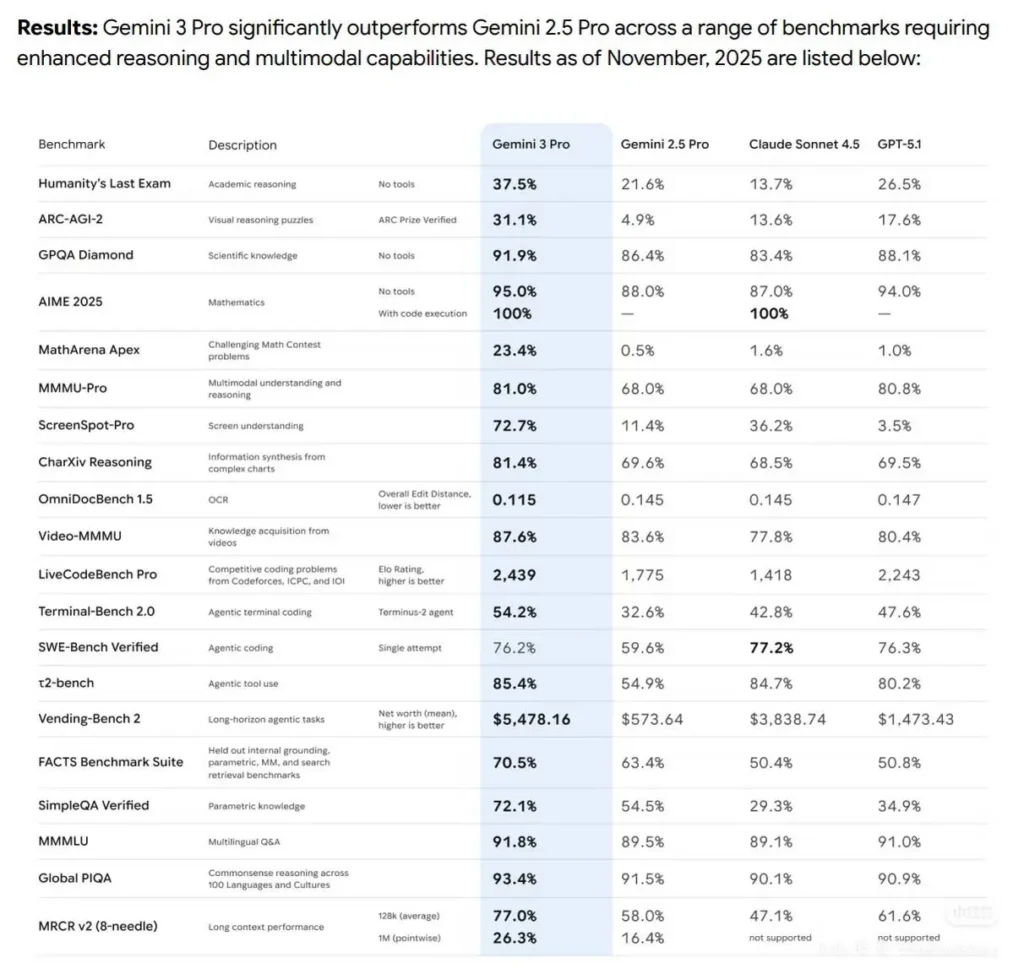

Benchmark-Leistung

- Das Gemini3Pro erreichte den ersten Platz in LMARE mit 1501 Punkten, übertraf Grok-4.1-thinking mit 1484 Punkten und lag auch vor Claude Sonnet 4.5 und Opus 4.1.

- Es erreichte ebenfalls den ersten Platz in der WebDevArena-Programmierarena mit einer Punktzahl von 1487.

- In Humanity’s Last Exam (akademisches Reasoning) erzielte es 37,5% (ohne Tools); in GPQA Diamond (Wissenschaft) 91,9%; und im MathArena Apex (Mathematik) 23,4% und setzte damit einen neuen Rekord.

- In multimodalen Fähigkeiten erzielte das MMMU-Pro 81%; und in Video-MMMU (Videokompetenz) 87,6%.

Technische Details & Architektur

- „Thinking level“-Parameter: Gemini 3 stellt eine

thinking_level-Steuerung bereit, mit der Entwickler die Tiefe des internen Reasonings gegenüber Latenz/Kosten abwägen können. Das Modell behandeltthinking_levelals relative Freigabe für internes mehrstufiges Reasoning, nicht als strikte Token-Garantie. Standard ist bei Pro typischerweisehigh. Dies ist eine explizite neue Kontrolle für Entwickler, um Mehrschrittplanung und Chain-of-Thought-Tiefe zu justieren. - Strukturierte Ausgaben & Tools: Das Modell unterstützt strukturierte JSON-Ausgaben und kann mit integrierten Tools kombiniert werden (Google-Suche als Grounding, URL-Kontext, Codeausführung usw.). Einige Funktionen für strukturierte Ausgaben plus Tools sind nur in der Preview für

gemini-3-pro-previewverfügbar. - Multimodale und agentische Integrationen: Gemini 3 Pro ist ausdrücklich für agentische Workflows (Tooling + mehrere Agenten über Code/Terminals/Browser) gebaut.

Einschränkungen und bekannte Hinweise

- Nicht perfekte Faktentreue — Halluzinationen sind weiterhin möglich. Trotz der von Google behaupteten Verbesserungen bei der Faktentreue sind abgesicherte Verifikation und menschliche Prüfung in kritischen Bereichen (juristisch, medizinisch, finanziell) weiterhin notwendig.

- Leistung bei langem Kontext variiert je nach Aufgabe. Unterstützung für ein 1M-Eingabefenster ist eine harte Fähigkeit, aber die empirische Effektivität kann bei Extremlängen auf einigen Benchmarks abfallen (beobachtete punktweise Rückgänge bei 1M in einigen Long-Context-Tests).

- Kosten- & Latenz-Trade-offs. Große Kontexte und höhere

thinking_level-Einstellungen erhöhen Rechenaufwand, Latenz und Kosten; Preisstaffelungen gelten basierend auf Token-Volumina. Nutzen Siethinking_levelund Chunking-Strategien zur Kostensteuerung. - Sicherheits- & Inhaltsfilter. Google setzt weiterhin Sicherheitsrichtlinien und Moderationsebenen ein; bestimmte Inhalte und Handlungen bleiben eingeschränkt oder lösen Ablehnungsmodi aus.

Wie Gemini 3 Pro Preview im Vergleich zu anderen Topmodellen abschneidet

Vergleich auf hoher Ebene (Preview → qualitativ):

Im Vergleich zu Gemini 2.5 Pro: Sprunghafte Verbesserungen bei Reasoning, agentischer Tool-Nutzung und multimodaler Integration; deutlich größere Kontextverarbeitung und besseres Langform-Verständnis. DeepMind zeigt konsistente Zuwächse in akademischem Reasoning, Coding und multimodalen Aufgaben.

Im Vergleich zu GPT-5.1 und Claude Sonnet 4.5 (laut Angaben): Auf der von Google/DeepMind genutzten Benchmark-Auswahl wird Gemini 3 Pro als führend in mehreren agentischen, multimodalen und Langkontext-Metriken präsentiert (siehe Terminal-Bench, MMMU-Pro, AIME). Vergleichsergebnisse variieren je nach Aufgabe.

Typische und besonders wertvolle Anwendungsfälle

- Zusammenfassungen großer Dokumente/Bücher & Q&A: Die Unterstützung für langen Kontext macht es attraktiv für Rechts‑, Forschungs‑ und Compliance-Teams.

- Codeverständnis & -generierung im Repo-Maßstab: Integration mit Coding-Toolchains und verbessertes Reasoning unterstützt Refactorings großer Codebasen und automatisierte Code-Review-Workflows.

- Multimodale Produktassistenten: Bild + Text + Audio-Workflows (Kundensupport, der Screenshots, Gesprächsausschnitte und Dokumente verarbeitet).

- Medienerstellung & -bearbeitung (Foto → Video): Frühere Gemini-Features umfassen nun Veo-/Flow-style Foto→Video-Fähigkeiten; die Preview deutet auf tiefere Multimedia-Generierung für Prototypen und Medien-Workflows hin.