DeepSeek lanzado Búsqueda profunda V3.2 y una variante de alto rendimiento DeepSeek-V3.2-EspecialCon un nuevo motor de atención dispersa (DSA), un comportamiento mejorado de agente/herramienta y un modo de "pensamiento" (cadena de pensamiento) que revela el razonamiento interno. Ambos modelos están disponibles a través de la API de DeepSeek (puntos finales compatibles con OpenAI) y los artefactos e informes técnicos del modelo se publican.

¿Qué es DeepSeek V3.2?

DeepSeek V3.2 es el sucesor de producción de la familia DeepSeek V3: una gran familia de modelos generativos de contexto largo que está diseñada explícitamente para razonamiento primero Flujos de trabajo y uso de agentes. La versión 3.2 consolida las mejoras experimentales previas (V3.2-Exp) en una línea de modelos general que se presenta a través de la aplicación, la interfaz web y la API de DeepSeek. Admite resultados rápidos y conversacionales, así como un... pensando (Modo de cadena de pensamiento) adecuado para tareas de razonamiento de varios pasos, como matemáticas, depuración y planificación.

Por qué es importante la versión 3.2 (contexto breve)

DeepSeek V3.2 se destaca por tres razones prácticas:

- Contexto largo: Hasta 128 000 ventanas de contexto de token, lo que lo hace adecuado para documentos largos, contratos legales o investigación de múltiples documentos.

- Diseño que prioriza el razonamiento: El modelo integra la cadena de pensamiento (“pensamiento”) en los flujos de trabajo y en el uso de herramientas: un cambio hacia aplicaciones agenciales que necesitan pasos de razonamiento intermedios.

- Costo y eficiencia: La introducción de DSA (atención dispersa) reduce el procesamiento para secuencias largas, lo que permite una inferencia mucho más barata para contextos grandes.

¿Qué es DeepSeek-V3.2-Speciale y en qué se diferencia de la versión v3.2 básica?

¿Qué hace que la variante “Speciale” sea especial?

DeepSeek V3.2-Speciale es un alto cálculo, alto razonamiento Variante de la familia v3.2. En comparación con la variante v3.2 equilibrada, Speciale está optimizada (y postentrenada) específicamente para razonamiento multipaso, matemáticas y tareas de agencia. Utiliza aprendizaje de refuerzo adicional basado en la retroalimentación humana (RLHF) y una cadena de pensamiento interna ampliada durante el entrenamiento. Este punto final temporal y el acceso a la API de Speciale se anunciaron como temporales (la ruta de Speciale vence el 15 de diciembre de 2025).

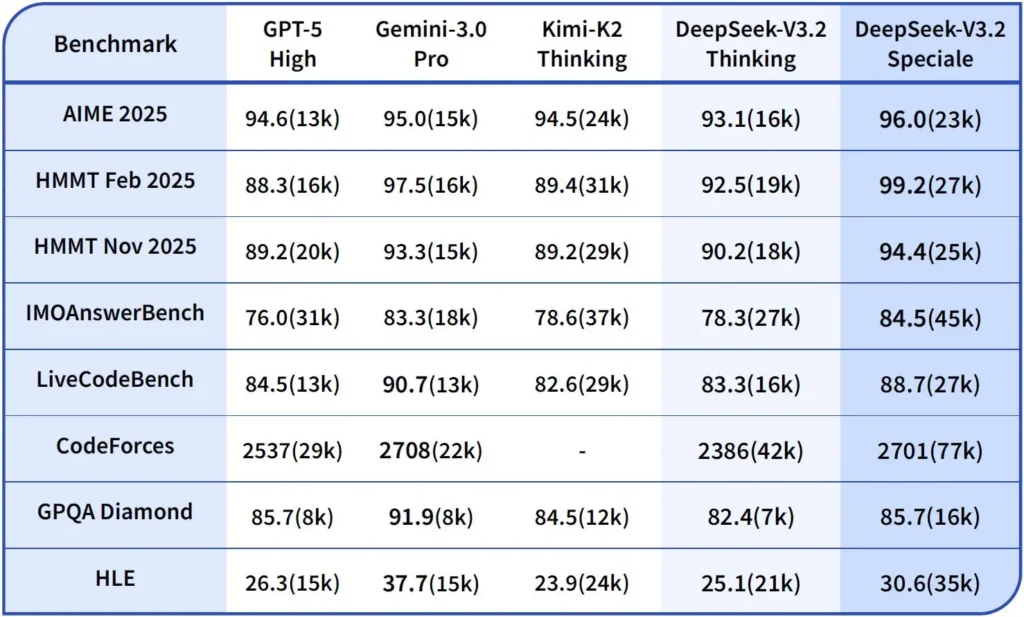

Rendimiento y puntos de referencia

DeepSeek-V3.2-Speciale es la variante de la versión 3.2, optimizada para el razonamiento y con alto rendimiento computacional. Esta versión integra el modelo matemático anterior, DeepSeek-Math-V2. Se posiciona como el modelo ideal cuando la carga de trabajo lo requiere. cadena de pensamiento más profunda posible, resolución de problemas de varios pasos, razonamiento competitivo (por ejemplo, estilo olimpiada matemática) y orquestación agencial compleja.

Puede demostrar teoremas matemáticos y verificar razonamientos lógicos por sí mismo; ha logrado resultados notables en múltiples competiciones de clase mundial:

- Medalla de Oro de la OMI (Olimpiada Internacional de Matemáticas)

- Medalla de oro de la Olimpiada Matemática China (CMO)

- ICPC (Concurso Internacional de Programación Informática) 2do Lugar (Concurso Humano)

- IOI (Olimpiada Internacional de Informática) 10º puesto (Concurso Humano)

¿Qué es el modo de razonamiento en DeepSeek v3.2?

DeepSeek expone una información explícita modo de pensar/razonamiento lo que hace que el modelo produzca un Cadena de pensamiento (CdP) como una parte discreta de la salida antes La respuesta final. La API muestra este CoT para que las aplicaciones cliente puedan inspeccionarlo, mostrarlo o destilarlo.

Mecánica: qué proporciona la API

reasoning_contentcampo:cuando el modo de pensamiento está habilitado, la estructura de respuesta incluye unareasoning_contentcampo (el CoT) al mismo nivel que el finalcontentEsto permite a los clientes acceder programáticamente a los pasos internos.- Llamadas de herramientas durante el pensamiento:V3.2 afirma soportar llamadas de herramientas within La trayectoria del pensamiento: el modelo puede intercalar pasos de razonamiento e invocaciones de herramientas, lo que mejora el rendimiento de tareas complejas.

Cómo la API DeepSeek v3.2 implementa el razonamiento

La versión 3.2 introduce un mecanismo API de cadena de razonamiento estandarizado para mantener una lógica de razonamiento consistente en conversaciones de múltiples turnos:

- Cada solicitud de razonamiento contiene una

reasoning_contentcampo dentro del modelo; - Si el usuario desea que el modelo continúe razonando, este campo debe devolverse al siguiente turno;

- Cuando comienza una nueva pregunta, la antigua

reasoning_contentdebe limpiarse para evitar la contaminación lógica; - El modelo puede ejecutar el bucle “razonamiento → llamada a herramienta → re-razonamiento” varias veces en modo de razonamiento.

¿Cómo accedo y uso la API de DeepSeek v3.2?

Corto: CometAPI es una puerta de enlace de estilo OpenAI que expone muchos modelos (incluidas las familias DeepSeek) a través de https://api.cometapi.com/v1 para que puedas intercambiar modelos cambiando el model Cadena en las solicitudes. Regístrate en CometAPI y obtén tu clave API primero.

¿Por qué utilizar CometAPI frente a DeepSeek directo?

- CometAPI centraliza la facturación, los límites de tarifas y la selección de modelos (útil si planea cambiar de proveedor sin cambiar el código).

- Puntos finales directos de DeepSeek (por ejemplo,

https://api.deepseek.com/v1) aún existen y, en ocasiones, ofrecen funciones específicas del proveedor; elija CometAPI para mayor comodidad o el punto de conexión directo del proveedor para controles nativos del proveedor. Verifique qué funciones (p. ej., Speciale, puntos de conexión experimentales) están disponibles a través de CometAPI antes de usarlas.

Paso A: Crea una cuenta de CometAPI y obtén una clave API

- Vaya a CometAPI (registro/consola) y genere una clave API (el panel de control generalmente muestra

sk-...) Mantenlo en secreto. CometAPI

Paso B: Confirme el nombre exacto del modelo disponible

- Consulta la lista de modelos para confirmar la cadena de modelo exacta que CometAPI expone (los nombres de modelo pueden incluir sufijos variantes). Usa el punto de conexión de modelos antes de codificar los nombres:

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

Busque la entrada DeepSeek (por ejemplo deepseek-v3.2 or deepseek-v3.2-exp) y anote la identificación exacta. CometAPI expone una /v1/models listado.

Paso C: Realizar una llamada de chat básica (curl)

Reemplace <COMET_KEY> y deepseek-v3.2 con el id del modelo que confirmaste:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

Este es el mismo patrón de llamada de estilo OpenAI: CometAPI reenvía al proveedor seleccionado.

Compatibilidad y precauciones

- Admite la habilitación del modo Think en el entorno de Claude Code;

- En la línea de comando (CLI), simplemente ingrese el nombre del modelo deepseek-reasoner;

- Sin embargo, es posible que no sea compatible con herramientas no estándar como Cline y RooCode por el momento;

- Se recomienda utilizar el modo sin pensamiento para tareas ordinarias y el modo pensamiento para razonamientos lógicos complejos.

Patrones de adopción prácticos: algunos ejemplos de arquitecturas

1 — Agente de asistencia para flujos de trabajo de desarrolladores

- Modo: Se invoca un modo especial (modo de pensamiento) para la generación de código complejo y la creación de pruebas; modo de chat rápido para el asistente en línea.

- Seguridad: Utilice comprobaciones de canalización de CI y ejecución de pruebas en espacio aislado para el código generado.

- de alojamiento: API o autohospedado en vLLM + clúster multi-GPU para contexto grande.

2 — Análisis de documentos para equipos jurídicos y financieros

- Modo: V3.2 con optimizaciones de contexto largo DSA para procesar contratos largos y producir resúmenes estructurados y listas de acciones.

- Seguridad: Aprobación por parte de un abogado humano para decisiones posteriores; redacción de información de identificación personal (PII) antes de enviar a puntos finales alojados.

3 — Orquestador autónomo de canalizaciones de datos

- Modo: Modo de pensamiento para planificar tareas ETL de varios pasos, llamar herramientas para consultar bases de datos y llamar pruebas de validación.

- Seguridad: Implemente la confirmación de acciones y verificaciones verificables antes de cualquier operación irreversible (por ejemplo, escritura destructiva en la base de datos).

Cada uno de los patrones anteriores es factible con los modelos de la familia V3.2 en la actualidad, pero es necesario combinar el modelo con herramientas de verificación y gobernanza conservadora.

¿Cómo optimizo el costo y el rendimiento con v3.2?

Utilice los modos duales deliberadamente

- Modo rápido para microinteracciones: utilice el modo de herramienta sin pensamiento para recuperaciones breves, conversiones de formato o llamadas API directas donde la latencia es importante.

- Modo de pensamiento para la planificación y verificación: Dirija tareas complejas, agentes con múltiples acciones o decisiones sensibles a la seguridad al modo de pensamiento. Capture los pasos intermedios y ejecute una verificación (automatizada o humana) antes de ejecutar acciones críticas.

¿Qué variante de modelo debo elegir?

- deepseek-v3.2: modelo de producción equilibrado para tareas de agencia generales.

- deepseek-v3.2-Speciale: variante especializada de razonamiento pesado; inicialmente, puede ser solo de API y usarse cuando se necesita el mejor razonamiento/rendimiento de referencia posible (y se acepta un costo potencialmente mayor).

Controles de costes prácticos y consejos

- Ingeniería de indicaciones: Mantenga las instrucciones del sistema concisas y evite enviar contexto redundante. Instrucciones explícitas del sistema: Use indicaciones del sistema que declaren la intención del modo: p. ej., "Está en modo PENSANDO: enumere su plan antes de llamar a las herramientas". Para el modo herramienta, agregue restricciones como "Al interactuar con la API de la calculadora, solo genere JSON con los siguientes campos".

- Aumento de fragmentación + recuperación: utilice un recuperador externo para enviar solo los segmentos más relevantes para cada pregunta del usuario.

- Temperatura y muestreo: Reducir la temperatura en las interacciones de las herramientas para aumentar el determinismo; aumentarla en las tareas de exploración o de ideación.

Punto de referencia y medición

- Tratar las salidas como no confiables hasta su verificación: Incluso las salidas de razonamiento pueden ser incorrectas. Agregar comprobaciones deterministas (pruebas unitarias, comprobaciones de tipo) antes de tomar medidas irreversibles.

- Ejecute pruebas A/B en una carga de trabajo de muestra (latencia, uso de token, corrección) antes de comprometerse con una variante. La versión 3.2 informó grandes avances en los puntos de referencia de razonamiento, pero el comportamiento real de la aplicación depende del diseño del mensaje y la distribución de entrada.

Preguntas Frecuentes

P: ¿Cuál es la forma recomendada de obtener CoT del modelo?

A: Use la opción deepseek-reasoner modelo o conjunto thinking/thinking.type = enabled en su solicitud. La respuesta incluye reasoning_content (CoT) y la final content.

P: ¿Puede el modelo llamar a herramientas externas mientras está en modo de pensamiento?

R: Sí. La versión 3.2 introdujo la posibilidad de usar herramientas tanto en modo de pensamiento como de no pensamiento; el modelo puede emitir llamadas estructuradas a herramientas durante el razonamiento interno. Uso strict modo y borrar esquemas JSON para evitar llamadas malformadas.

P: ¿El uso del modo de pensamiento aumenta el costo?

R: Sí. El modo de pensamiento genera tokens CoT intermedios, lo que aumenta el uso de tokens y, por lo tanto, el costo. Diseñe su sistema para permitir el pensamiento solo cuando sea necesario.

P: ¿Qué punto final y URL base debo utilizar?

R: CometAPI proporciona puntos finales compatibles con OpenAI. La URL base predeterminada es https://api.cometapi.com y el punto final del chat principal es /v1/chat/completions (o /chat/completions dependiendo de la URL base que elijas).

P: ¿Se requieren herramientas especiales para utilizar la llamada de herramientas?

R: No, la API admite declaraciones de funciones estructuradas en JSON. Debe proporcionar la tools Parámetro, los esquemas de la herramienta y la gestión del ciclo de vida de la función JSON en su aplicación: recibir el JSON de la llamada a la función, ejecutar la función y devolver los resultados al modelo para su continuación o cierre. El modo de pensamiento añade un requisito para devolver reasoning_content junto con los resultados de la herramienta.

Conclusión

DeepSeek V3.2 y DeepSeek-V3.2-Speciale representan un claro impulso hacia abierto, centrado en el razonamiento LLM que explicitan la cadena de pensamiento y admiten flujos de trabajo de herramientas de agencia. Ofrecen nuevas y potentes primitivas (DSA, modo de pensamiento, entrenamiento en el uso de herramientas) que pueden simplificar la creación de agentes confiables, siempre que se consideren los costos de tokens, la gestión cuidadosa del estado y los controles operativos.

Los desarrolladores pueden acceder API de Deepseek v3.2 etc. a través de CometAPI, la última versión del modelo Se actualiza constantemente con el sitio web oficial. Para empezar, explora las capacidades del modelo en el Playground y consultar el Guía de API Para obtener instrucciones detalladas, consulte la sección "Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y de haber obtenido la clave API". CometAPI Ofrecemos un precio muy inferior al oficial para ayudarte a integrarte.

¿Listo para ir?→ Prueba gratuita de deepseek v3.2 !

Si quieres conocer más consejos, guías y novedades sobre IA síguenos en VK, X y Discord!