La API Qwen2.5-Omni-7B proporciona a los desarrolladores métodos compatibles con OpenAI para interactuar con el modelo, lo que permite procesar entradas de texto, imágenes, audio y video, y generar respuestas de texto y voz natural en tiempo real.

¿Qué es Qwen2.5-Omni-7B?

Qwen2.5-Omni-7B es el modelo insignia de IA multimodal de Alibaba, con 7 mil millones de parámetros. Diseñado para procesar y comprender múltiples modalidades de datos, admite entradas de texto, imagen, audio y video. El modelo facilita las interacciones de voz y video en tiempo real, lo que lo convierte en una herramienta versátil para diversas aplicaciones.

Características principales de Qwen2.5-Omni-7B

- Procesamiento multimodal: Capaz de manejar diversas entradas, incluidos texto, imágenes, audio y video, lo que permite una comprensión integral de los datos.

- Interacción en tiempo real: Admite procesamiento de baja latencia, lo que permite conversaciones de voz y video en tiempo real.

- Arquitectura pensador-hablador: Utiliza un sistema de arquitectura dual donde el "Pensador" gestiona el procesamiento y la comprensión de los datos, mientras que el "Hablador" genera salidas de voz fluidas.

- RoPE multimodal alineado en el tiempo (TMRoPE): Utiliza TMRoPE para la sincronización precisa de datos temporales en diferentes modalidades, lo que garantiza una comprensión coherente y la generación de respuestas.

Métricas de rendimiento

Logros de referencia

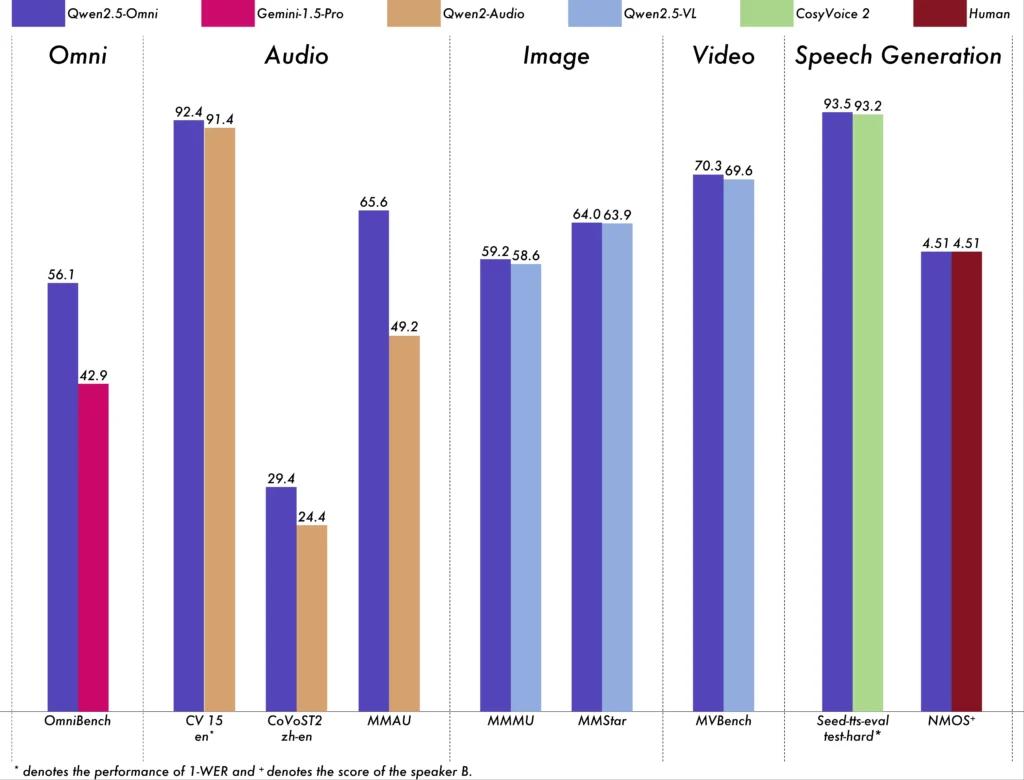

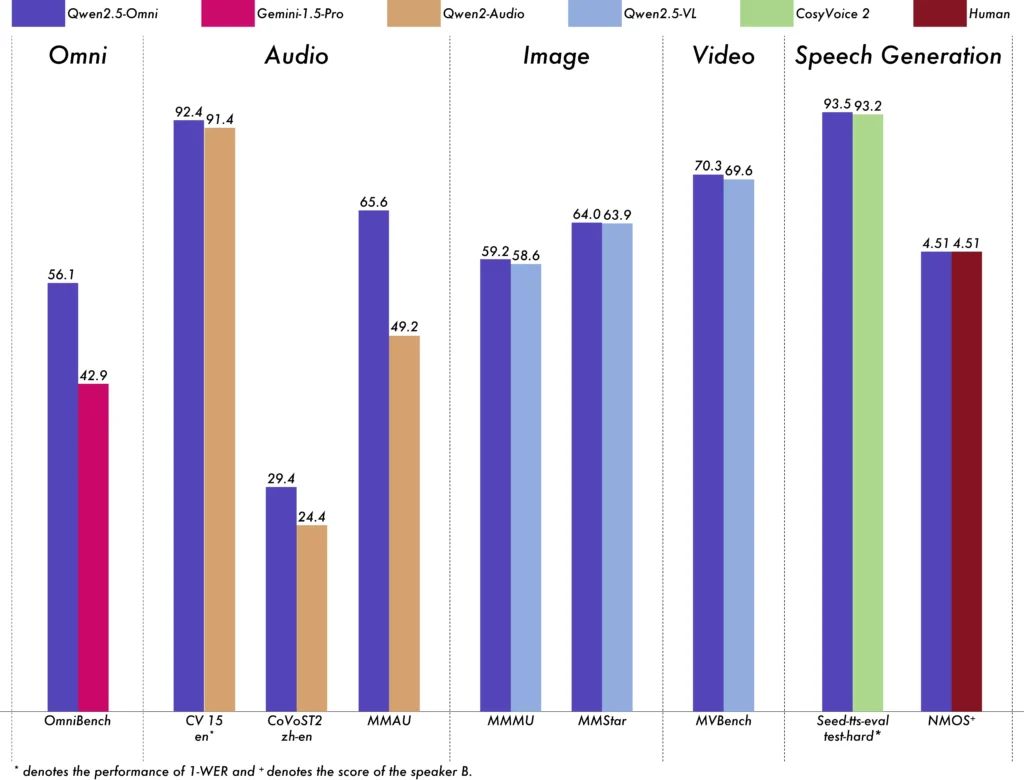

Qwen2.5-Omni-7B ha demostrado un rendimiento excepcional en varios puntos de referencia:

- OmniBench: Obtuvo una puntuación media del 56.13%, superando modelos como Gemini-1.5-Pro (42.91%) y MIO-Instruct (33.80%).

- Reconocimiento de voz: En el conjunto de datos Librispeech, alcanzó tasas de error de palabras que oscilaron entre el 1.6% y el 3.5%, comparables a modelos especializados como Whisper-large-v3.

- Reconocimiento de eventos sonoros: Obtuvo una puntuación de 0.570 en el conjunto de datos Meld, estableciendo un nuevo punto de referencia en el campo.

- Comprensión musical: Obtuvo una puntuación de 0.88 en el benchmark GiantSteps Tempo, lo que destaca su competencia en comprensión musical.

Capacidades de procesamiento en tiempo real

Diseñado para aplicaciones en tiempo real, Qwen2.5-Omni-7B admite la transmisión bloque a bloque, lo que permite la generación inmediata de audio con mínima latencia. Esta función es especialmente beneficiosa para aplicaciones que requieren respuestas rápidas, como asistentes virtuales y sistemas interactivos de IA.

Especificaciones técnicas

Diseño arquitectonico

- Marco pensador-hablador: El componente "Pensador" procesa y comprende entradas multimodales, generando representaciones semánticas de alto nivel y salidas textuales. El componente "Hablador" convierte estas representaciones en un habla natural y fluida, garantizando una comunicación fluida entre el sistema de IA y los usuarios.

- Mecanismo TMRoPE: Aborda el desafío de sincronizar datos temporales de diversas fuentes alineando las marcas de tiempo de las entradas de video y audio, lo que facilita una comprensión multimodal coherente.

Metodología de Entrenamiento

El modelo pasó por un proceso de entrenamiento de tres fases:

- Fase uno: Se corrigieron los parámetros del modelo de lenguaje durante el entrenamiento de codificadores visuales y de audio utilizando pares audio-texto e imagen-texto extensos para mejorar la comprensión multimodal.

- Fase dos: Descongelamos todos los parámetros y entrenamos con un conjunto de datos diverso que incluye imágenes, videos, audio y texto, mejorando aún más la comprensión multimodal integral.

- Fase tres: Se centró en el entrenamiento de datos de secuencia larga para reforzar la capacidad del modelo para manejar entradas complejas y extendidas.

Evolución de los modelos Qwen

Progresión de Qwen a Qwen2.5

La evolución de Qwen a Qwen2.5 significa un salto sustancial en el desarrollo de modelos de IA:

- Parámetros mejorados: Qwen2.5 se amplió a modelos con hasta 72 mil millones de parámetros, ofreciendo soluciones escalables para diversas aplicaciones.

- Procesamiento de contexto extendido: Se introdujo la capacidad de procesar hasta 128,000 tokens, lo que facilita el manejo de documentos extensos y conversaciones complejas.

- Capacidades de codificación: La variante Qwen2.5-Coder admite más de 92 lenguajes de programación, lo que ayuda en las tareas de generación de código, depuración y optimización.

Ventajas de Qwen2.5-Omni-7B

Integración multimodal integral

Al procesar eficazmente texto, imágenes, audio y video, Qwen2.5-Omni-7B proporciona una solución de IA integral adecuada para una amplia gama de aplicaciones.

Interacción en tiempo real

Su procesamiento de baja latencia asegura respuestas inmediatas, mejorando la experiencia del usuario en aplicaciones interactivas.

Accesibilidad de código abierto

Como modelo de código abierto, Qwen2.5-Omni-7B promueve la transparencia y permite a los desarrolladores personalizar e integrar el modelo en varias plataformas sin restricciones de propiedad.

Indicadores técnicos

- Parámetros del modelo: 7 mil millones

- Modalidades de entrada: Texto, imagen, audio, vídeo

- Modalidades de salida: Texto, voz

- Capacidad de procesamiento: Interacción de voz y video en tiempo real

- Puntos de referencia de rendimiento:

- OmniBench: Puntuación media del 56.13%

- Librispeech (tasa de error de palabras): Prueba limpia: 1.8%, Prueba-otras: 3.4%

Escenarios de aplicación

Asistentes virtuales interactivos

El procesamiento en tiempo real y la comprensión multimodal de Qwen2.5-Omni-7B lo hacen ideal para asistentes virtuales que pueden ver, escuchar y responder de forma natural.

Creación de contenido multimedia

Los creadores de contenido pueden aprovechar el modelo para generar contenido multimedia atractivo, combinando texto, imágenes y audio sin problemas.

Tecnologías de asistencia

Las capacidades del modelo pueden ayudar a las personas con discapacidades, como proporcionar audio descriptivo para contenido visual.

Consejos de uso

Optimización del rendimiento

Para lograr un rendimiento óptimo, especialmente en aplicaciones en tiempo real, se recomienda utilizar aceleradores de hardware y garantizar suficiente memoria de GPU.

Integración con sistemas existentes

Los desarrolladores deben considerar los formatos de entrada y salida del modelo al integrarlo con aplicaciones existentes para garantizar la compatibilidad y maximizar la eficiencia.

Mantenerse Actualizado

Revise periódicamente los repositorios oficiales y la documentación para obtener actualizaciones y mejores prácticas para aprovechar al máximo las capacidades de Qwen2.5-Omni-7B.

Temas relacionados Cómo ejecutar el modelo Qwen2.5-Omni-7B

Conclusión

Qwen2.5-Omni-7B ejemplifica la convergencia de la investigación avanzada en IA y su aplicación práctica, ofreciendo una solución versátil y eficiente para una multitud de tareas en diversos sectores. Su código abierto garantiza su accesibilidad y adaptabilidad, allanando el camino para futuras innovaciones en IA multimodal.

Cómo llamar a la API Qwen2.5-Omni-7B desde CometAPI

1.Iniciar sesión a cometapi.comSi aún no eres nuestro usuario, por favor regístrate primero.

2.Obtener la clave API de credenciales de acceso De la interfaz. Haga clic en "Agregar token" en el token de API del centro personal, obtenga la clave del token: sk-xxxxx y envíela.

-

Obtenga la URL de este sitio: https://api.cometapi.com/

-

Seleccione el punto final Qwen2.5-Omni-7B para enviar la solicitud de API y configure el cuerpo de la solicitud. El método y el cuerpo de la solicitud se obtienen de nuestra documentación de la API del sitio webNuestro sitio web también ofrece la prueba Apifox para su comodidad.

-

Procesa la respuesta de la API para obtener la respuesta generada. Tras enviar la solicitud a la API, recibirás un objeto JSON con la finalización generada.