GPT-5.2 es la versión puntual de diciembre de 2025 de OpenAI dentro de la familia GPT-5: una familia de modelos multimodales insignia (texto + visión + herramientas) ajustada para el trabajo profesional del conocimiento, el razonamiento de largo contexto, el uso agentivo de herramientas y la ingeniería de software. OpenAI presenta GPT-5.2 como el modelo más capaz de la serie GPT-5 hasta la fecha y afirma que se desarrolló con énfasis en el razonamiento confiable de múltiples pasos, el manejo de documentos muy grandes y un mayor nivel de seguridad/cumplimiento de políticas; el lanzamiento incluye tres variantes orientadas al usuario — Instant, Thinking y Pro — y se está desplegando primero para suscriptores de pago de ChatGPT y clientes de la API.

¿Qué es GPT-5.2 y por qué importa?

GPT-5.2 es el miembro más reciente de la familia GPT-5, una nueva serie de modelos “frontera” diseñada específicamente para cerrar la brecha entre asistentes conversacionales de una sola interacción y sistemas que deben razonar sobre documentos largos, llamar herramientas, interpretar imágenes y ejecutar flujos de trabajo de múltiples pasos de forma confiable. OpenAI posiciona 5.2 como su lanzamiento más capaz hasta ahora para el trabajo profesional del conocimiento: establece nuevos resultados de vanguardia en evaluaciones internas (notablemente un nuevo benchmark GDPval para trabajo del conocimiento), demuestra un rendimiento de codificación más sólido en benchmarks de ingeniería de software y ofrece capacidades significativamente mejoradas en largo contexto y visión.

En términos prácticos, GPT-5.2 es más que “un modelo de chat más grande”. Es una familia de tres variantes ajustadas (Instant, Thinking, Pro) que intercambian latencia, profundidad de razonamiento y costo, y que, junto con la API de OpenAI y el ruteo de ChatGPT, pueden usarse para ejecutar trabajos largos de investigación, construir agentes que llamen herramientas externas, interpretar imágenes y gráficos complejos, y generar código de nivel de producción con mayor fidelidad que lanzamientos anteriores. El modelo admite ventanas de contexto muy grandes (los documentos de OpenAI listan una ventana de contexto de 400,000 tokens y un límite de salida máxima de 128,000 para los modelos insignia), nuevas funciones de API para niveles explícitos de esfuerzo de razonamiento y un comportamiento “agentivo” de invocación de herramientas.

5 capacidades clave mejoradas en GPT-5.2

1) ¿GPT-5.2 es mejor en lógica de múltiples pasos y matemáticas?

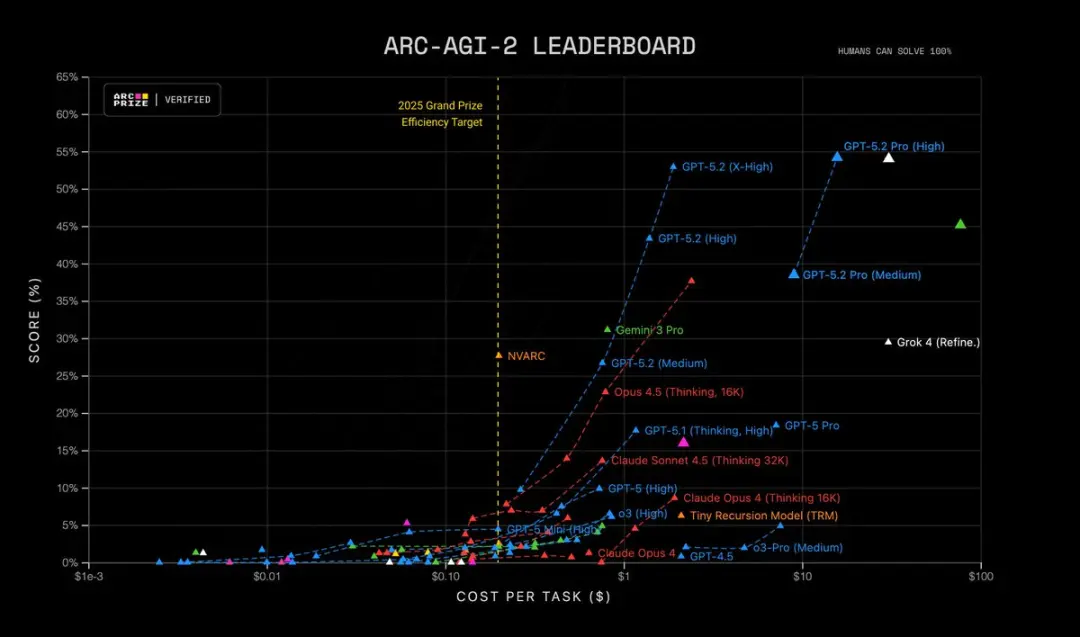

GPT-5.2 aporta un razonamiento de múltiples pasos más afinado y un rendimiento notablemente más sólido en matemáticas y resolución estructurada de problemas. OpenAI afirma que añadió un control más granular sobre el esfuerzo de razonamiento (nuevos niveles como xhigh), incorporó soporte de “tokens de razonamiento” y ajustó el modelo para mantener la cadena de pensamiento a lo largo de trazas internas de razonamiento más extensas. Benchmarks como FrontierMath y pruebas estilo ARC-AGI muestran mejoras sustantivas frente a GPT-5.1; obtiene márgenes mayores en benchmarks específicos de dominio utilizados en flujos de trabajo científicos y financieros. En resumen: GPT-5.2 “piensa durante más tiempo” cuando se le pide, y puede realizar trabajo simbólico/matemático más complejo con mejor consistencia.

| RC-AGI-1 (Verificado) Razonamiento abstracto | 86.2% | 72.8% |

|---|---|---|

| ARC-AGI-2 (Verificado) Razonamiento abstracto | 52.9% | 17.6% |

GPT-5.2 Thinking establece récords en múltiples pruebas avanzadas de ciencia y razonamiento matemático:

- GPQA Diamond Science Quiz: 92.4% (versión Pro 93.2%)

- ARC-AGI-1 Razonamiento abstracto: 86.2% (primer modelo en superar el umbral del 90%)

- ARC-AGI-2 Razonamiento de orden superior: 52.9%, estableciendo un nuevo récord para el modelo Thinking Chain

- FrontierMath Prueba de matemáticas avanzadas: 40.3%, superando ampliamente a su predecesor;

- HMMT Problemas de competición de matemáticas: 99.4%

- Prueba de matemáticas AIME: 100% Solución completa

Además, GPT-5.2 Pro (Alta) es el estado del arte en ARC-AGI-2, logrando una puntuación de 54.2% a un costo de $15.72 por tarea, superando a todos los demás modelos.

Por qué importa: muchas tareas del mundo real — modelado financiero, diseño experimental, síntesis de programas que requieren razonamiento formal — están limitadas por la capacidad del modelo para encadenar muchos pasos correctos. GPT-5.2 reduce los “pasos alucinados” y produce trazas intermedias de razonamiento más estables cuando se le pide que muestre su trabajo.

2) ¿Cómo han mejorado la comprensión de textos largos y el razonamiento entre documentos?

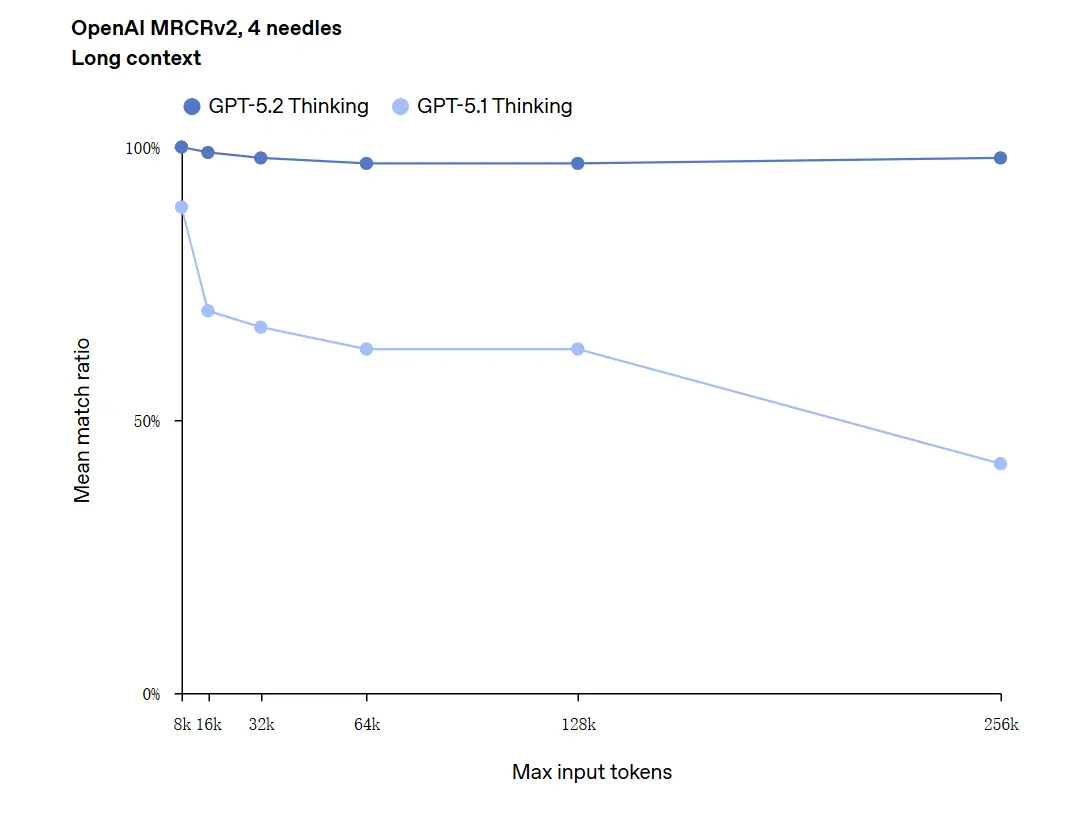

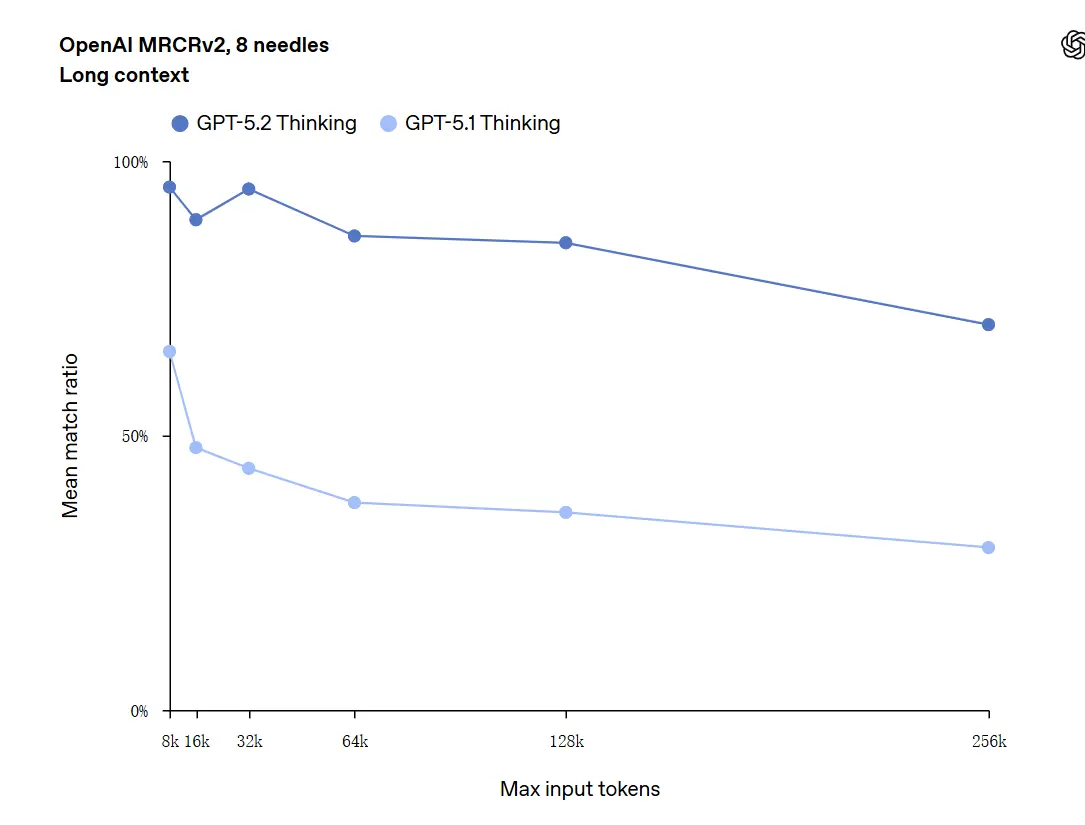

La comprensión de largo contexto es una de las mejoras más destacadas. El modelo subyacente de GPT-5.2 admite una ventana de contexto de 400k tokens y — lo importante — mantiene mayor precisión a medida que el contenido relevante se desplaza profundamente en ese contexto. GDPval, un conjunto de tareas para “trabajo del conocimiento bien especificado” en 44 ocupaciones, donde GPT-5.2 Thinking alcanza paridad o supera a jueces humanos expertos en una gran proporción de tareas. Informes independientes confirman que el modelo retiene y sintetiza información a través de muchos documentos mucho mejor que modelos anteriores. Esto es un avance genuinamente práctico para tareas como due diligence, resúmenes legales, revisiones de literatura y comprensión de bases de código.

GPT-5.2 puede manejar contextos de hasta 256,000 tokens (aproximadamente más de 200 páginas de documentos). Además, en la prueba de comprensión de textos largos "OpenAI MRCRv2", GPT-5.2 Thinking logró una tasa de precisión cercana al 100%.

Advertencia acerca de “100% de precisión”: describió las mejoras como “acercándose al 100%” para microtareas estrechas; los datos de OpenAI se describen mejor como “estado del arte y en muchos casos en o por encima de niveles de expertos humanos en tareas evaluadas”, no literalmente perfectos en todos los usos. Los benchmarks muestran grandes mejoras pero no perfección universal.

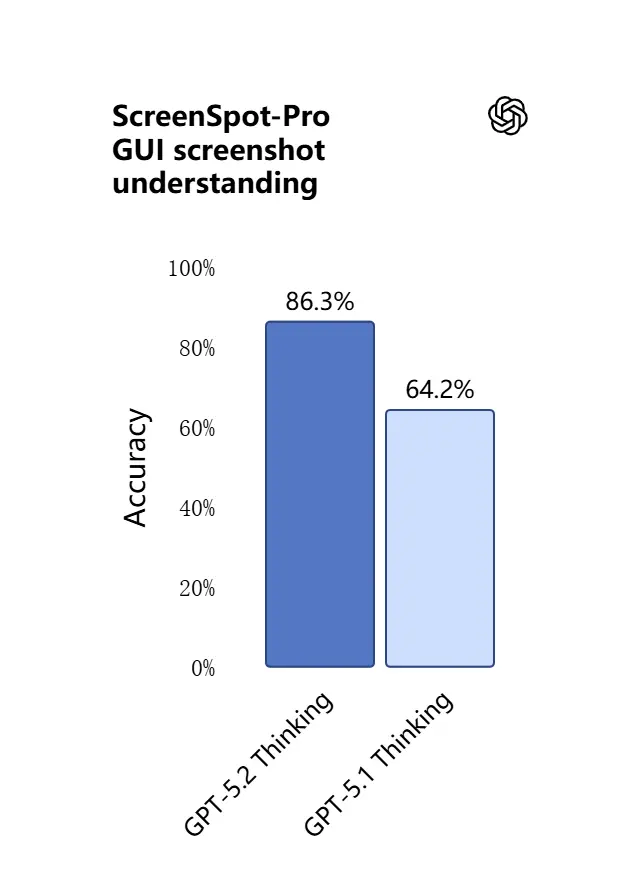

3) ¿Qué hay de nuevo en la comprensión visual y el razonamiento multimodal?

Las capacidades de visión en GPT-5.2 son más precisas y prácticas. El modelo es mejor interpretando capturas de pantalla, leyendo gráficos y tablas, reconociendo elementos de la interfaz de usuario y combinando entradas visuales con un largo contexto textual. No es solo subtitulado: GPT-5.2 puede extraer datos estructurados de imágenes (p. ej., tablas en un PDF), explicar gráficos y razonar sobre diagramas de formas que respaldan acciones posteriores con herramientas (p. ej., generar una hoja de cálculo a partir de un informe fotografiado).

.webp)

Efecto práctico: los equipos pueden proporcionar directamente al modelo presentaciones completas, informes de investigación escaneados o documentos con abundantes imágenes y pedir síntesis entre documentos, reduciendo considerablemente el trabajo de extracción manual.

4) ¿Cómo han cambiado la invocación de herramientas y la ejecución de tareas?

GPT-5.2 avanza más en el comportamiento agentivo: es mejor planificando tareas de múltiples pasos, decidiendo cuándo llamar herramientas externas y ejecutando secuencias de llamadas a APIs/herramientas para completar un trabajo de principio a fin. Mejoras de “llamadas de herramientas agentivas”: el modelo propondrá un plan, llamará herramientas (bases de datos, cómputo, sistemas de archivos, navegador, ejecutores de código) y sintetizará resultados en un entregable final con mayor confiabilidad que versiones anteriores. La API introduce ruteo y controles de seguridad (listas de herramientas permitidas, andamiaje de herramientas) y la interfaz de ChatGPT puede enrutar automáticamente solicitudes a la variante 5.2 adecuada (Instant vs Thinking).

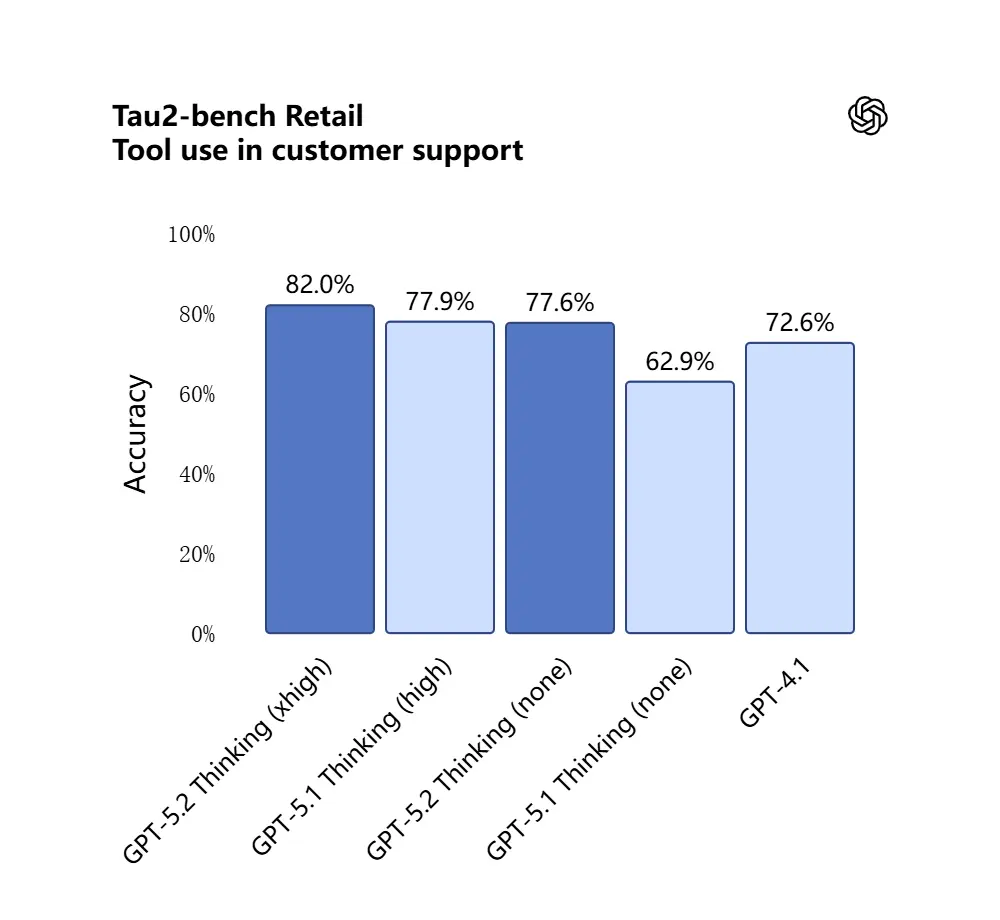

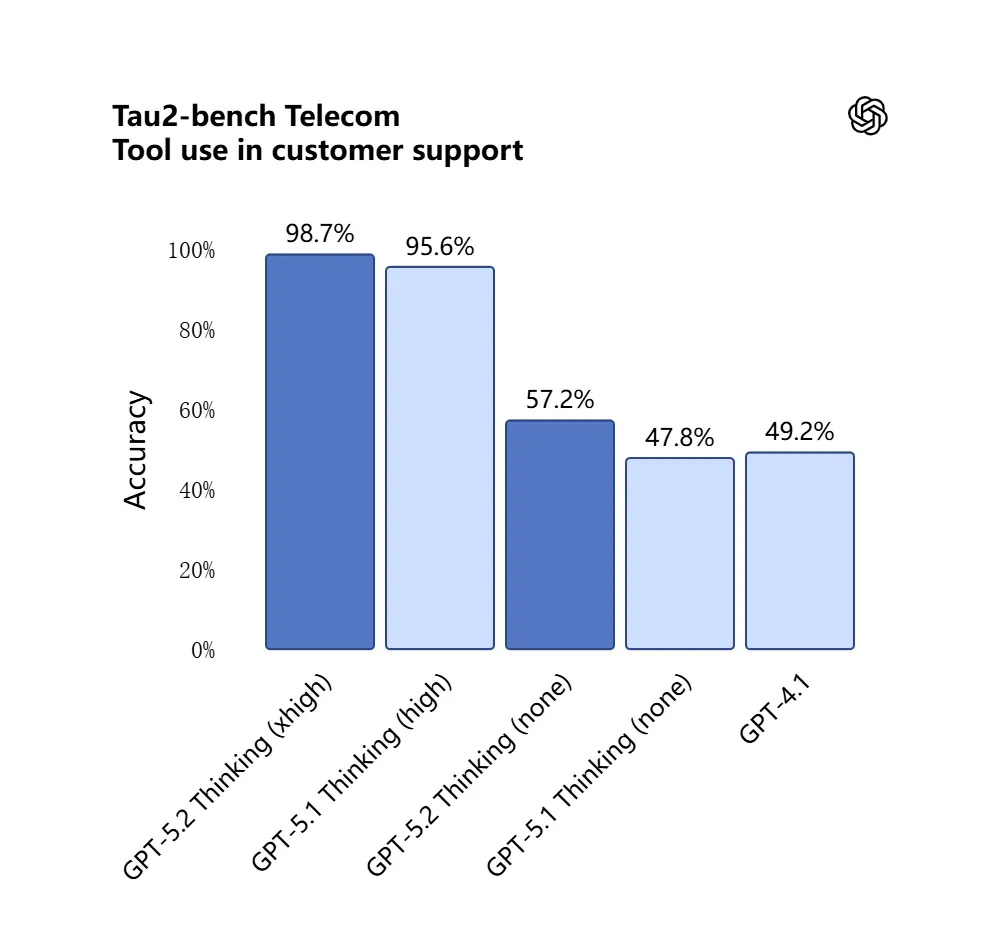

GPT-5.2 obtuvo 98.7% en el benchmark Tau2-Bench Telecom, demostrando capacidades maduras de llamadas de herramientas en tareas complejas de múltiples turnos.

Por qué importa: esto hace que GPT-5.2 sea más útil como asistente autónomo para flujos de trabajo como “ingresa estos contratos, extrae cláusulas, actualiza una hoja de cálculo y redacta un correo de resumen”, tareas que antes requerían una orquestación cuidadosa.

5) La capacidad de programación evolucionó

GPT-5.2 es notablemente mejor en tareas de ingeniería de software: escribe módulos más completos, genera y ejecuta pruebas con mayor confiabilidad, comprende gráficos complejos de dependencias de proyectos y es menos propenso al “código perezoso” (omitir boilerplate o fallar al conectar módulos). En benchmarks de codificación de nivel industrial (SWE-bench Pro, etc.) GPT-5.2 establece nuevos récords. Para equipos que usan LLMs como copilotos de programación, esa mejora puede reducir la verificación manual y el retrabajo requeridos después de la generación.

En la prueba SWE-Bench Pro (tarea de ingeniería de software industrial del mundo real), la puntuación de GPT-5.2 Thinking mejoró a 55.6%, mientras que también alcanzó un nuevo máximo de 80% en la prueba SWE-Bench Verified.

_Software%20engineering.webp)

En aplicaciones prácticas, esto significa:

- La depuración automática de código en entornos de producción conduce a mayor estabilidad;

- Soporte para programación multilenguaje (no limitado a Python);

- Capacidad para completar de forma independiente tareas de reparación de extremo a extremo.

¿Cuáles son las diferencias entre GPT-5.2 y GPT-5.1?

Respuesta corta: GPT-5.2 es una mejora iterativa pero sustancial. Mantiene la arquitectura de la familia GPT-5 y las bases multimodales, pero avanza en cuatro dimensiones prácticas:

- Profundidad y consistencia del razonamiento. 5.2 introduce niveles más altos de esfuerzo de razonamiento y mejor encadenamiento para problemas de múltiples pasos; 5.1 mejoró el razonamiento anteriormente, pero 5.2 eleva el techo para matemáticas complejas y lógica de múltiples etapas.

- Fiabilidad en largo contexto. Ambas versiones ampliaron el contexto, pero 5.2 está ajustado para mantener la precisión profundamente dentro de entradas muy largas (OpenAI afirma una retención mejorada hasta cientos de miles de tokens).

- Fidelidad en visión + multimodal. 5.2 mejora el cruce de referencias entre imágenes y texto — por ejemplo, leer un gráfico e integrar esos datos en una hoja de cálculo — mostrando una mayor precisión a nivel de tarea.

- Comportamiento agentivo de herramientas y funciones de API. 5.2 expone nuevos parámetros de esfuerzo de razonamiento (

xhigh) y funciones de compactación de contexto en la API, y OpenAI ha refinado la lógica de ruteo en ChatGPT para que la interfaz pueda elegir automáticamente la mejor variante. - Menos errores, mayor estabilidad: GPT-5.2 reduce su “tasa de ilusión” (tasa de respuestas falsas) en un 38%. Responde preguntas de investigación, redacción y análisis con mayor confiabilidad, reduciendo instancias de “hechos inventados”. En tareas complejas, su salida estructurada es más clara y su lógica más estable. Mientras tanto, la seguridad de las respuestas del modelo mejora significativamente en tareas relacionadas con salud mental. Se desempeña de manera más robusta en escenarios sensibles como salud mental, autobservación, suicidio y dependencia emocional.

En evaluaciones del sistema, GPT-5.2 Instant obtuvo 0.995 (sobre 1.0) en la tarea de “Apoyo a la salud mental”, significativamente superior a GPT-5.1 (0.883).

Cuantitativamente, los benchmarks publicados por OpenAI muestran mejoras medibles en GDPval, benchmarks de matemáticas (FrontierMath) y evaluaciones de ingeniería de software. GPT-5.2 supera a GPT-5.1 en tareas de hojas de cálculo de banca de inversión junior por varios puntos porcentuales.

¿GPT-5.2 es gratuito? — ¿Cuánto cuesta?

¿Puedo usar GPT-5.2 gratis?

OpenAI comenzó a desplegar GPT-5.2 empezando por los planes de pago de ChatGPT y el acceso a la API. Históricamente, OpenAI ha mantenido los modelos más rápidos/de mayor profundidad detrás de niveles de pago mientras hace disponibles variantes más ligeras más ampliamente después; con 5.2 la compañía dijo que el despliegue comenzaría en planes de pago (Plus, Pro, Business, Enterprise) y que la API está disponible para desarrolladores. Eso significa que el acceso inmediato gratuito es limitado: el nivel gratuito puede recibir acceso degradado o ruteado (por ejemplo a subvariantes más ligeras) más adelante a medida que OpenAI escala el despliegue.

La buena noticia es que CometAPI ahora se integra con GPT-5.2, y actualmente está en oferta navideña. Ahora puedes usar GPT-5.2 a través de CometAPI; el playground te permite interactuar libremente con GPT-5.2, y los desarrolladores pueden usar la API de GPT-5.2 (CometAPI tiene un precio del 20% del de OpenAI) para construir flujos de trabajo.

¿Cuánto cuesta mediante la API (uso de desarrollador / producción)?

El uso de la API se factura por token. La plataforma de OpenAI muestra precios publicados en el lanzamiento (CometAPI tiene un precio del 20% del de OpenAI):

- GPT-5.2 (chat estándar) — $1.75 por 1M tokens de entrada y $14 por 1M tokens de salida (aplican descuentos por entrada en caché).

- GPT-5.2 Pro (insignia) — $21 por 1M tokens de entrada y $168 por 1M tokens de salida (significativamente más caro porque está destinado a cargas de trabajo de alta precisión y alto cómputo).

- En comparación, GPT-5.1 era más barato (p. ej., $1.25 entrada / $10 salida por 1M tokens).

Interpretación: los costos de la API aumentaron respecto a generaciones anteriores; el precio indica que el razonamiento premium y el rendimiento de largo contexto de 5.2 están tarifados como un nivel de producto distinto. Para sistemas de producción, los costos del plan dependen en gran medida de cuántos tokens ingresas/sales y con qué frecuencia reutilizas entradas en caché (las entradas en caché obtienen grandes descuentos).

Qué significa en la práctica

- Para uso casual a través de la interfaz de ChatGPT, los planes de suscripción mensual (Plus, Pro, Business, Enterprise) son la vía principal. Los precios de los niveles de suscripción de ChatGPT no cambiaron con el lanzamiento de 5.2 (OpenAI mantiene los precios de los planes estables aunque cambien los modelos ofrecidos).

- Para producción y desarrolladores, presupuesta los costos por tokens. Si tu app transmite muchas respuestas largas o procesa documentos largos, el precio de tokens de salida ($14 / 1M tokens para Thinking) dominará los costos a menos que caches cuidadosamente entradas y reutilices salidas.

GPT-5.2 Instant vs GPT-5.2 Thinking vs GPT-5.2 Pro

OpenAI lanzó GPT-5.2 con tres variantes según propósito para ajustarse a casos de uso: Instant, Thinking y Pro:

- GPT-5.2 Instant: Rápido, rentable, ajustado para trabajo cotidiano — FAQs, how-tos, traducciones, redacción rápida. Menor latencia; buenos primeros borradores y flujos simples.

- GPT-5.2 Thinking: Respuestas más profundas y de mayor calidad para trabajo sostenido — resumen de documentos largos, planificación de múltiples pasos, revisiones de código detalladas. Latencia y calidad equilibradas; el ‘caballo de batalla’ por defecto para tareas profesionales.

- GPT-5.2 Pro: Máxima calidad y confiabilidad. Más lento y más costoso; ideal para tareas difíciles y de alto riesgo (ingeniería compleja, síntesis legal, decisiones de alto valor) y donde se requiere un esfuerzo de razonamiento ‘xhigh’.

Tabla comparativa

| Característica / Métrica | GPT-5.2 Instant | GPT-5.2 Thinking | GPT-5.2 Pro |

|---|---|---|---|

| Uso previsto | Tareas diarias, borradores rápidos | Análisis profundo, documentos largos | Máxima calidad, problemas complejos |

| Latencia | Más baja | Moderada | Más alta |

| Esfuerzo de razonamiento | Estándar | Alto | xHigh disponible |

| Ideal para | FAQ, tutoriales, traducciones, prompts cortos | Resúmenes, planificación, hojas de cálculo, tareas de código | Ingeniería compleja, síntesis legal, investigación |

| Ejemplos de nombre de API | gpt-5.2-chat-latest | gpt-5.2 | gpt-5.2-pro |

| Precio token de entrada (API) | $1.75 / 1M | $1.75 / 1M | $21 / 1M |

| Precio token de salida (API) | $14 / 1M | $14 / 1M | $168 / 1M |

| Disponibilidad (ChatGPT) | Despliegue progresivo; planes de pago y luego más amplio | Despliegue a planes de pago | Usuarios Pro / Enterprise (de pago) |

| Ejemplo de caso de uso | Redacción de emails, fragmentos de código menores | Construir modelo financiero multih hoja, Q&A de informes largos | Auditar base de código, generar diseño de sistema de producción |

¿Quién debería usar GPT-5.2?

GPT-5.2 está diseñado con un conjunto amplio de usuarios objetivo en mente. A continuación, recomendaciones por rol:

Empresas y equipos de producto

Si construyes productos de trabajo del conocimiento (asistentes de investigación, revisión de contratos, canalizaciones de analítica o herramientas para desarrolladores), las capacidades de largo contexto y agentivas de GPT-5.2 pueden reducir significativamente la complejidad de integración. Las empresas que necesitan comprensión robusta de documentos, informes automatizados o copilotos inteligentes encontrarán útiles Thinking/Pro. Microsoft y otros socios de plataforma ya están integrando 5.2 en pilas de productividad (p. ej., Microsoft 365 Copilot).

Desarrolladores y equipos de ingeniería

Los equipos que desean usar LLMs como copilotos de programación o automatizar generación/pruebas de código se beneficiarán de la mayor fidelidad de programación en 5.2. El acceso a la API (con modos thinking o pro) habilita síntesis más profundas de grandes bases de código gracias a la ventana de contexto de 400k tokens. Espera pagar más en la API al usar Pro, pero la reducción en depuración y revisión manual puede justificar ese costo para sistemas complejos.

Investigadores y analistas intensivos en datos

Si sintetizas literatura con regularidad, analizas informes técnicos largos o deseas diseño de experimentos asistido por modelo, las mejoras de largo contexto y matemáticas de GPT-5.2 ayudan a acelerar flujos de trabajo. Para investigación reproducible, acopla el modelo con ingeniería de prompts cuidadosa y pasos de verificación.

Pequeñas empresas y usuarios avanzados

ChatGPT Plus (y Pro para usuarios avanzados) obtendrá acceso ruteado a variantes 5.2; esto hace que la automatización avanzada y salidas de alta calidad sean alcanzables para equipos pequeños sin construir una integración de API. Para usuarios no técnicos que necesitan mejores resúmenes de documentos o creación de diapositivas, GPT-5.2 ofrece un valor práctico notable.

Notas prácticas para desarrolladores y operadores

Funciones de API a observar

- Niveles de

reasoning.effort(p. ej.,medium,high,xhigh) te permiten indicar al modelo cuánto cómputo dedicar al razonamiento interno; úsalo para intercambiar latencia por precisión por solicitud. - Context compaction: la API incluye herramientas para comprimir y compactar el historial de modo que se preserve el contenido verdaderamente relevante en cadenas largas. Esto es crítico cuando debes mantener el uso efectivo de tokens manejable.

- Tool scaffolding y controles de allowed-tools: los sistemas de producción deben listar explícitamente qué herramientas puede invocar el modelo y registrar llamadas de herramientas para auditoría.

Consejos de control de costos

- Cachea embeddings de documentos usados frecuentemente y usa entradas en caché (que reciben fuertes descuentos) para consultas repetidas sobre el mismo corpus. Los precios de la plataforma de OpenAI incluyen descuentos significativos para entradas en caché.

- Enruta consultas exploratorias/de bajo valor a Instant y reserva Thinking/Pro para trabajos por lotes o pasadas finales.

- Estima cuidadosamente el uso de tokens (entrada + salida) al proyectar costos de la API, porque salidas largas multiplican el costo.

En resumen — ¿deberías actualizar a GPT-5.2?

Si tu trabajo depende del razonamiento sobre documentos largos, la síntesis entre documentos, la interpretación multimodal (imágenes + texto) o la construcción de agentes que llamen herramientas, GPT-5.2 es una mejora clara: eleva la precisión práctica y reduce el trabajo manual de integración. Si principalmente ejecutas chatbots de alto volumen y baja latencia o aplicaciones estrictamente limitadas por presupuesto, Instant (o modelos anteriores) pueden seguir siendo una opción razonable.

GPT-5.2 representa un cambio deliberado de “mejor chat” a “mejor asistente profesional”: más cómputo, más capacidad y niveles de costo más altos, pero también ganancias reales de productividad para equipos que pueden aprovechar un largo contexto confiable, mejores matemáticas/razonamiento, comprensión de imágenes y ejecución agentiva de herramientas.

Para empezar, explora las capacidades de los modelos GPT-5.2 (GPT-5.2;GPT-5.2 pro, GPT-5.2 chat) en el Playground y consulta la guía de la API para instrucciones detalladas. Antes de acceder, asegúrate de haber iniciado sesión en CometAPI y de haber obtenido la clave de API. CometAPI ofrece un precio mucho más bajo que el oficial para ayudarte a integrar.

¿Listo para comenzar?→ Prueba gratuita de modelos gpt-5.2 !