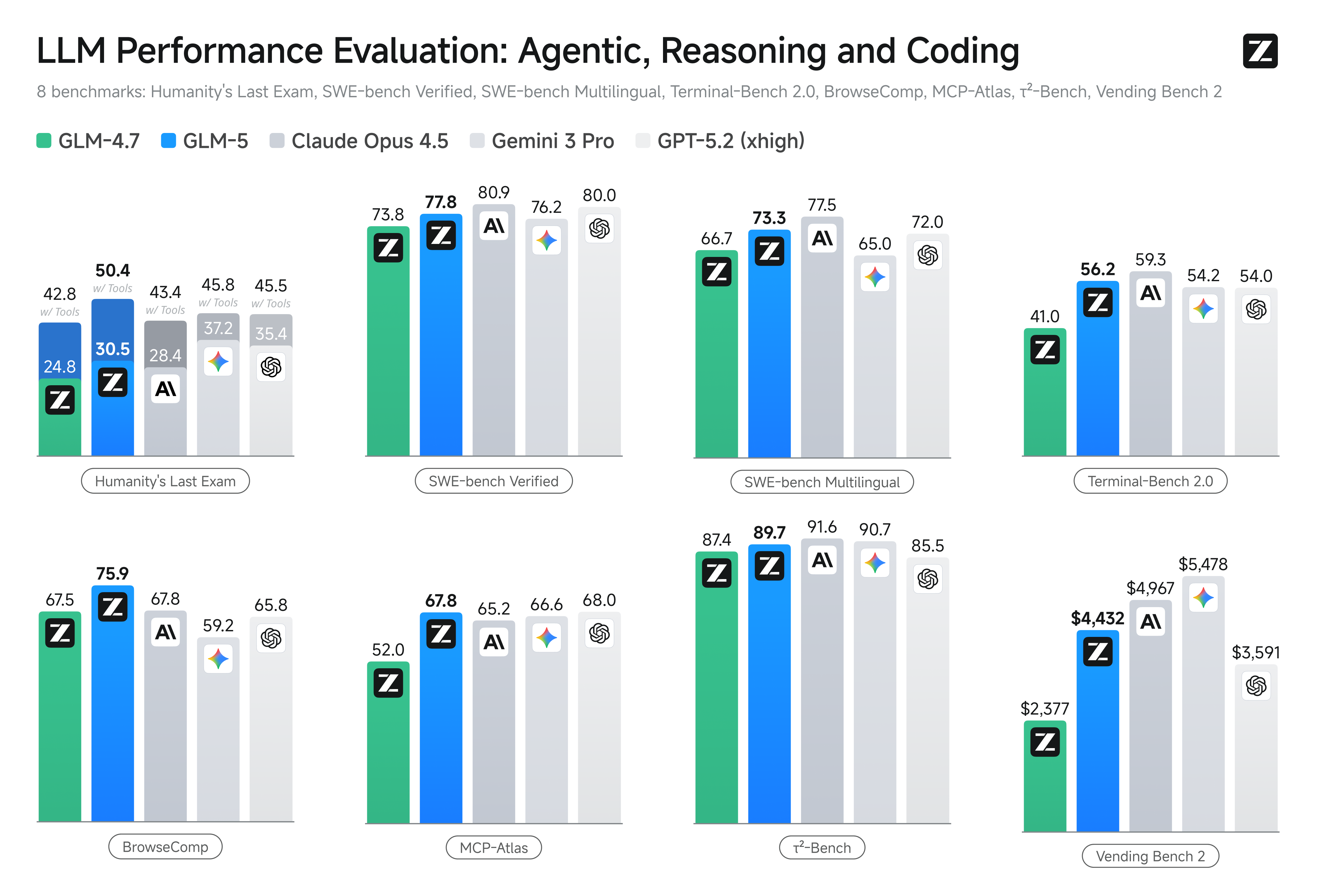

La sortie de GLM-5, dévoilé cette semaine par Zhipu AI en Chine (marque publique Z.AI / zai-org sur de nombreux canaux développeurs), marque une nouvelle étape dans l’accélération du rythme des publications de grands modèles. Le nouveau modèle est positionné comme le fleuron de Zhipu : plus vaste, optimisé pour des tâches agentiques à long horizon, et conçu avec des choix d’ingénierie visant à réduire le coût d’inférence tout en préservant un long contexte. Les premiers rapports de l’industrie et retours de développeurs indiquent des gains significatifs en codage, raisonnement multi-étapes et orchestration d’agents par rapport aux itérations GLM précédentes — et sur certains tests il rivalise même avec Claude 4.5. ## Qu’est-ce que GLM-5 et qui l’a développé ? GLM-5 est la dernière version majeure de la famille GLM : un grand modèle de base open source développé et publié par Z.ai (l’équipe derrière la série GLM). Annoncé début février 2026, GLM-5 est présenté comme un modèle de nouvelle génération spécifiquement optimisé pour des tâches « agentiques » — c.-à-d. des workflows multi-étapes et à long horizon où le modèle doit planifier, appeler des outils, exécuter et maintenir le contexte pour des conversations prolongées ou des agents automatisés. La publication se distingue non seulement par la conception du modèle mais aussi par son entraînement et son lieu : Z.ai a utilisé un mix de matériel et de chaînes d’outils domestiques chinois dans le cadre d’une démarche d’autosuffisance. Chiffres rapportés de l’architecture et de l’entraînement : * Mise à l’échelle des paramètres : GLM-5 monte à environ 744B de paramètres (avec un nombre d’experts « actifs » plus petit cité dans certaines notes techniques, p. ex. 40B actifs), contre des tailles de la famille GLM-4 autour de 355B/32B actifs. * Données de pré-entraînement : La taille du corpus d’entraînement serait passée d’environ 23 trillions de tokens (génération GLM-4) à environ 28,5 trillions de tokens pour GLM-5. * Attention clairsemée / DeepSeek Sparse Attention (DSA) : Un schéma d’attention clairsemée pour préserver le long contexte tout en réduisant le coût de calcul à l’inférence. * Accent de conception : des choix d’ingénierie axés sur l’orchestration d’agents, le raisonnement en long contexte et une inférence économique. ### Origines et positionnement GLM-5 s’appuie sur une lignée comprenant GLM-4.5 (sorti mi-2025) et quelques mises à jour itératives comme 4.7. Z.ai présente GLM-5 comme un bond du « vibe coding » (sorties de code rapides en une étape) vers l’« ingénierie agentique » : raisonnement soutenu, orchestration multi-outils et synthèse de systèmes sur de longues fenêtres de contexte. Les documents publics soulignent que GLM-5 a été conçu pour gérer des tâches d’ingénierie de systèmes complexes — construire, coordonner et maintenir des comportements d’agents multi-étapes plutôt que de simplement répondre à des requêtes isolées. ## Quelles sont les nouveautés de GLM-5 ? ### Changements architecturaux majeurs * Mise à l’échelle clairsemée massive (MoE) : GLM-5 adopte une architecture Mixture-of-Experts clairsemée bien plus grande. Des chiffres publics dans les pages développeurs et des analyses indépendantes indiquent environ 744B de paramètres au total avec ~40B actifs par token — une avancée notable par rapport à la configuration de GLM-4.5 (~355B / 32B actifs). Cette mise à l’échelle clairsemée offre une grande capacité totale tout en maintenant un calcul par token maîtrisable. * DeepSeek Sparse Attention (DSA) : Pour préserver la capacité de long contexte sans faire croître linéairement le coût d’inférence, GLM-5 intègre un mécanisme d’attention clairsemée (marque DeepSeek) pour conserver les dépendances de longue portée importantes tout en réduisant le coût de l’attention sur des contextes très longs. ### L’ingénierie agentique comme objectif fondamental de conception Une des caractéristiques phares de GLM-5 est qu’il est explicitement conçu pour l’ingénierie agentique — le modèle est pensé non seulement pour le chat en un tour ou la synthèse, mais comme le « cerveau » d’agents multi-étapes capables de planifier, lancer des appels d’outils, gérer l’état et raisonner sur de longs contextes. Z.ai positionne GLM-5 pour opérer dans des boucles d’orchestration : décomposer des problèmes complexes, appeler des outils/API externes et suivre des tâches longues sur de nombreux tours. #### Pourquoi la conception agentique compte Les workflows agentiques sont centraux dans l’automatisation réelle : assistants de recherche automatisés, ingénieurs logiciels autonomes, orchestration des opérations et contrôle de simulations. Un modèle conçu pour ce monde doit offrir une planification solide, un comportement stable d’appel d’outils et une robustesse sur des milliers de tokens de contexte. ### Codage, raisonnement et comportement « long-horizon » améliorés GLM-5 met l’accent sur l’amélioration de la génération de code et du raisonnement. Z.ai revendique des progrès ciblés dans la capacité du modèle à écrire, refactorer et déboguer du code, ainsi qu’un raisonnement multi-étapes plus cohérent au fil d’interactions longues. Des rapports d’accès anticipé indépendants et des évaluations de partenaires ont constaté que le modèle est sensiblement plus performant sur des tâches orientées développeurs que les générations GLM précédentes. ### Fonctionnalités pratiques pour les développeurs * Fenêtres de contexte plus grandes pour contenir documentation, bases de code et état de conversation. * Primitives de tooling pour des invocations d’outils sûres et la gestion des résultats. * Meilleures performances en few-shot et chaîne de pensée pour décomposer et exécuter des tâches complexes. * Fonctionnalités agentiques et appel d’outils : GLM-5 met l’accent sur un support natif des agents : appel de fonctions/outils, sessions avec état et meilleure gestion des dialogues longs et des séquences d’utilisation d’outils. Cela facilite la création d’agents intégrant la recherche web, des bases de données ou l’automatisation de tâches. ## Comment GLM-5 se comporte-t-il sur les benchmarks ?  ### Faits marquants de benchmarks spécifiques * Benchmarks de codage : GLM-5 s’approche (et dans certains cas, égale) des performances de codage de modèles propriétaires très optimisés comme Claude Opus 4.5 d’Anthropic sur des tâches spécifiques de codage. Ces résultats dépendent des tâches (tests unitaires, codage algorithmique, utilisation d’API), mais marquent une nette amélioration par rapport à GLM-4.5. * Tests de raisonnement et agentiques : Sur des suites d’évaluation de raisonnement multi-étapes et agentiques (p. ex., planification multi-tours, benchmarks de décomposition de tâches), GLM-5 a obtenu des résultats parmi les meilleurs de sa catégorie pour les modèles open source et, sur certaines métriques, a surpassé des modèles fermés concurrents sur des tâches ciblées. ## Comment accéder et essayer GLM-5 ? GLM-5 est la cinquième génération de grand modèle linguistique de Zhipu AI (Z.ai), construit avec une architecture Mixture-of-Experts (~745 B au total, ~44 B actifs) et visant un fort raisonnement, du codage et des workflows agentiques. Il a été lancé officiellement autour du 12 février 2026. À l’heure actuelle, il existe deux principales façons d’y accéder : ### A) Accès API officiel (Z.ai ou agrégateurs) Zhipu AI propose des API pour ses modèles, et vous pouvez appeler GLM-5 via ces API. Étapes typiques : 1. Inscrivez-vous à un compte API Z.ai/Open BigModel. 2. Obtenez une clé API depuis le tableau de bord. 3. Utilisez un endpoint API OpenAPI-style ou REST avec le nom du modèle (p. ex.,

### Faits marquants de benchmarks spécifiques * Benchmarks de codage : GLM-5 s’approche (et dans certains cas, égale) des performances de codage de modèles propriétaires très optimisés comme Claude Opus 4.5 d’Anthropic sur des tâches spécifiques de codage. Ces résultats dépendent des tâches (tests unitaires, codage algorithmique, utilisation d’API), mais marquent une nette amélioration par rapport à GLM-4.5. * Tests de raisonnement et agentiques : Sur des suites d’évaluation de raisonnement multi-étapes et agentiques (p. ex., planification multi-tours, benchmarks de décomposition de tâches), GLM-5 a obtenu des résultats parmi les meilleurs de sa catégorie pour les modèles open source et, sur certaines métriques, a surpassé des modèles fermés concurrents sur des tâches ciblées. ## Comment accéder et essayer GLM-5 ? GLM-5 est la cinquième génération de grand modèle linguistique de Zhipu AI (Z.ai), construit avec une architecture Mixture-of-Experts (~745 B au total, ~44 B actifs) et visant un fort raisonnement, du codage et des workflows agentiques. Il a été lancé officiellement autour du 12 février 2026. À l’heure actuelle, il existe deux principales façons d’y accéder : ### A) Accès API officiel (Z.ai ou agrégateurs) Zhipu AI propose des API pour ses modèles, et vous pouvez appeler GLM-5 via ces API. Étapes typiques : 1. Inscrivez-vous à un compte API Z.ai/Open BigModel. 2. Obtenez une clé API depuis le tableau de bord. 3. Utilisez un endpoint API OpenAPI-style ou REST avec le nom du modèle (p. ex., glm-5). (Similaire à la façon d’appeler des modèles GPT chez OpenAI). 4. Définissez des prompts et envoyez des requêtes HTTP. 👉 La page de tarification de Z.ai indique des prix officiels de tokens pour GLM-5 comme : * ~$1.0 par million de tokens d’entrée * ~$3.2 par million de tokens de sortie ### B) Enveloppes API tierces ——CometAPI Des API comme CometAPI ou WaveSpeed encapsulent plusieurs modèles d’IA (OpenAI, Claude, Z.ai, etc.) derrière une interface unifiée. * Avec des services comme CometAPI, vous pouvez appeler des modèles GLM en changeant l’ID du modèle. (CometAPI prend actuellement en charge GLM-5/GLM-4.7.) * Le glm-5 de CometAPI est tarifé à 20 % du prix officiel. | Type d’usage | Prix | | -------------- | --------------------- | | Jetons d’entrée| ~$0.8 par 1M tokens | | Jetons de sortie| ~$2.56 par 1M tokens | Pourquoi c’est important : Vous conservez votre code client compatible OpenAI existant et vous ne changez que l’URL de base/l’ID du modèle. ### C) Auto-hébergement via Hugging Face / Weights Il existe des dépôts de poids GLM-5 non officiels (p. ex., des versions nommées glm-5/glm-5-fp8) visibles dans les listings de modèles Hugging Face. Avec ceux-ci, vous pouvez : * Télécharger les poids du modèle. * Utiliser des outils comme vLLM, SGLang, xLLM ou Transformers pour servir en local ou sur votre flotte de GPU cloud. Avantages : contrôle maximal, pas de coût API récurrent. Inconvénients : besoins de calcul énormes — probablement plusieurs GPU haut de gamme et beaucoup de mémoire (plusieurs centaines de Go), ce qui rend cela impraticable sur de petites machines. ## Alors — GLM-5 en vaut-il la peine, et devez-vous garder GLM-4.7 ? ### Réponse courte (résumé exécutif) * Si votre travail exige un comportement agentique robuste, une génération de code de qualité production ou une automatisation au niveau système : GLM-5 mérite une évaluation immédiate. Son architecture, son échelle et son réglage priorisent précisément ces résultats. * Si vous avez besoin de microservices économiques à haut débit (chat court, classification, prompts légers) : GLM-4.7 reste probablement le choix le plus rentable. GLM-4.7 conserve un solide ensemble de capacités à un coût par token nettement inférieur chez de nombreux fournisseurs et a déjà fait ses preuves. ### Réponse plus longue (recommandation pratique) Adoptez une stratégie de modèles à plusieurs niveaux : utilisez GLM-4.7 pour les interactions quotidiennes à fort volume et réservez GLM-5 pour les problèmes d’ingénierie à forte valeur et l’orchestration agentique. Pilotez GLM-5 sur une petite partie de produit qui exerce le long contexte, l’intégration d’outils et la correction de code ; mesurez à la fois le temps d’ingénierie économisé et le coût incrémental du modèle. Au fil du temps, vous saurez si l’élévation de capacité de GLM-5 justifie une migration plus large. Avec CometAPI, vous pouvez basculer entre GLM-4.7 et GLM-5 à tout moment. ## Cas d’usage réels où GLM-5 excelle ### 1. Orchestration complexe d’agents L’orientation de GLM-5 vers la planification multi-étapes et l’appel d’outils le rend bien adapté aux systèmes devant coordonner recherche, appels API et exécution de programmes (par exemple : assistants de recherche automatisés, générateurs de code itératifs, ou agents de service client multi-étapes devant consulter des bases de données et des API externes). ### 2. Ingénierie longue et raisonnement sur bases de code Lorsque vous avez besoin que le modèle analyse, refactore ou synthétise sur de nombreux fichiers ou une grande base de code, le contexte étendu de GLM-5 et son attention clairsemée sont des avantages directs — moins de modes d’échec causés par un contexte tronqué et une meilleure cohérence sur de longues portées. ### 3. Synthèse riche en connaissances Les analystes et équipes produit qui génèrent des rapports complexes — notes de recherche multi-sections, synthèses juridiques, ou dépôts réglementaires — peuvent bénéficier des améliorations du modèle en raisonnement multi-étapes soutenu et de la réduction des hallucinations dans les tests rapportés par les fournisseurs. ### 4. Automatisation agentique des workflows Les équipes construisant de l’automatisation devant orchestrer plusieurs systèmes (p. ex., planification + ticketing + pipelines de déploiement) peuvent utiliser GLM-5 comme planificateur et exécuteur central, soutenu par des cadres d’appel d’outils et des enveloppes de sécurité. ## Conclusion GLM-5 est une publication importante dans un paysage de modèles de pointe en rapide évolution. Son accent sur l’ingénierie agentique, le codage et le raisonnement améliorés, ainsi que la disponibilité de poids ouverts, le rend attractif pour les équipes construisant des systèmes d’IA à long horizon et activés par des outils. Des gains réels sur des tâches sélectionnées et des compromis coût/performance encourageants — mais les acheteurs doivent évaluer GLM-5 sur leurs tâches spécifiques et mener leurs propres benchmarks contrôlés avant un engagement en production. Les développeurs peuvent accéder à GLM-5 via CometAPI dès maintenant. Pour commencer, explorez les capacités du modèle dans le Playground et consultez le API guide pour des instructions détaillées. Avant d’y accéder, veuillez vous assurer que vous êtes connecté à CometAPI et que vous avez obtenu la clé API. CometAPI propose un prix bien inférieur au prix officiel pour faciliter votre intégration. Ready to Go?→ Sign up fo glm-5 today ! If you want to know more tips, guides and news on AI follow us on VK, X and Discord!

GLM-5 : fonctionnalité, tests de performance et accès

AnnaFeb 12, 2026