DeepSeek a publié un expérimental modèle appelé DeepSeek-V3.2-Exp on 29 septembre, introduisant un nouveau mécanisme d'attention éparse (DeepSeek Sparse Attention, ou DSA) qui vise à réduire considérablement les coûts d'inférence pour les charges de travail à contexte long. Parallèlement, l'entreprise a divisé par deux environ le prix des API. Ce guide explique le modèle, son architecture et ses fonctionnalités principales, comment accéder à l'API et l'utiliser (avec des exemples de code), comment le comparer aux modèles DeepSeek précédents, et comment analyser et gérer ses réponses en production.

Qu'est-ce que DeepSeek-V3.2-Exp ?

DeepSeek-V3.2-Exp est une itération expérimentale de la version 3 de DeepSeek. Annoncée fin septembre 2025, cette version se positionne comme une étape intermédiaire validant les optimisations architecturales pour des longueurs de contexte étendues, plutôt que comme une avancée majeure en termes de précision brute. Son innovation majeure est : DeepSeek Sparse Attention (DSA), un modèle d'attention qui s'intéresse de manière sélective aux parties d'une longue entrée pour réduire les coûts de calcul et de mémoire tout en visant à maintenir une qualité de sortie comparable à celle de V3.1-Terminus.

Pourquoi c'est important dans la pratique :

- Coût des tâches à contexte long : DSA cible le coût quadratique de l'attention, réduisant ainsi les calculs pour les entrées très longues (recherche de documents multiples, transcriptions longues, univers de jeu volumineux, etc.). Les coûts d'utilisation des API sont sensiblement inférieurs pour les cas d'utilisation classiques à contexte long.

- Compatibilité et accessibilité : L'API DeepSeek utilise un format de requête compatible OpenAI, de sorte que de nombreux workflows OpenAI SDK existants peuvent être adaptés rapidement.

Quelles sont les principales fonctionnalités et l'architecture de DeepSeek V3.2-Exp ?

Qu'est-ce que DeepSeek Sparse Attention (DSA) et comment fonctionne-t-il ?

DSA est un attention clairsemée à grain fin Schéma conçu pour une attention sélective sur des jetons plutôt que pour une concentration intense sur l'ensemble du contexte. En résumé :

- Le modèle sélectionne dynamiquement des sous-ensembles de jetons à prendre en compte à chaque couche ou bloc, réduisant ainsi les FLOP pour les longues longueurs d'entrée.

- La sélection est conçue pour préserver le contexte « important » pour les tâches de raisonnement, en tirant parti d’une combinaison de politiques de sélection apprises et d’heuristiques de routage.

L'architecture DSA, innovation majeure de la version 3.2-Exp, vise à maintenir une qualité de sortie proche de celle des modèles à attention dense tout en réduisant les coûts d'inférence, notamment lorsque la longueur des contextes augmente. Les notes de version et la page du modèle soulignent que les configurations d'entraînement ont été alignées sur celles de la version 3.1-Terminus, de sorte que les différences dans les métriques de référence reflètent le mécanisme d'attention clairsemée plutôt qu'une modification radicale de l'entraînement.

Quelles autres architectures/fonctionnalités sont fournies avec la V3.2-Exp ?

- Modes hybrides (pensant vs non-pensant) : DeepSeek expose deux ID de modèle :

deepseek-chat(réponses sans réflexion / plus rapides) etdeepseek-reasoner(mode de réflexion permettant d'exposer le contenu de la chaîne de pensée ou du raisonnement intermédiaire). Ces modes permettent aux développeurs de choisir entre rapidité et transparence du raisonnement explicite. - Fenêtres de contexte très grandes : La famille V3.x prend en charge des contextes très volumineux (la gamme V3 offre à DeepSeek 128 000 options de contexte dans les mises à jour actuelles), ce qui la rend adaptée aux flux de travail multi-documents, aux longs journaux et aux agents riches en connaissances.

- Sortie JSON et appel de fonction strict (bêta) : L'API prend en charge un

response_formatObjet permettant de forcer la sortie JSON (et une fonction bêta stricte d'appel). Ceci est utile lorsque vous avez besoin de sorties prévisibles et analysables par machine pour l'intégration d'outils. - Jetons de streaming et de raisonnement : L'API prend en charge les réponses en streaming et, pour les modèles de raisonnement, des jetons de contenu de raisonnement distincts (souvent exposés sous

reasoning_content), qui vous permet d'afficher ou d'auditer les étapes intermédiaires du modèle.

Comment accéder et utiliser l'API DeepSeek-V3.2-Exp via CometAPI ?

DeepSeek conserve intentionnellement un format d'API de type OpenAI, afin que les SDK OpenAI existants ou les outils compatibles puissent être reciblés avec une URL de base différente. Je recommande d'utiliser CometAPI pour accéder à DeepSeek-V3.2-Exp, car il est économique et constitue une passerelle d'agrégation multimodale. DeepSeek expose les noms de modèles correspondant au comportement de V3.2-Exp. Exemples :

DeepSeek-V3.2-Exp-thinking — mode de raisonnement/réflexion mappé sur V3.2-Exp.

DeepSeek-V3.2-Exp-thinking — mode non-raisonnement/chat mappé sur V3.2-Exp.

Comment m'authentifier et quelle est l'URL de base ?

- Obtenir une clé API depuis la console développeur CometAPI (postulez sur leur site).

- URL de base : (

https://api.cometapi.comorhttps://api.cometapi.com/v1(pour les chemins compatibles OpenAI). La compatibilité OpenAI signifie que de nombreux SDK OpenAI peuvent être redirigés vers DeepSeek avec de légères modifications.

Quels identifiants de modèle dois-je utiliser ?

DeepSeek-V3.2-Exp-thinking— Mode réflexion : expose le contenu de la chaîne de pensée/raisonnement. Ces deux éléments ont été mis à jour vers la version 3.2-Exp dans les dernières notes de version.DeepSeek-V3.2-Exp-nothinking— sans réflexion, réponses plus rapides, utilisation typique du chat/de la complétion.

Exemple : requête curl simple (achèvement du chat)

curl -s https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer $cometapi_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize the attached meeting transcript in 3 bullet points."}

],

"max_tokens": 512,

"stream": false

}'

Exemple : Python (modèle client compatible OpenAI)

Ce modèle fonctionne après avoir redirigé un client OpenAI vers l'URL de base de CometAPI (ou en utilisant le SDK de CometAPI). L'exemple ci-dessous suit le style de documentation de DeepSeek :

import os

import requests

API_KEY = os.environ

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Extract action items from the following notes..."}

],

"max_tokens": 800

}

r = requests.post(url, headers=headers, json=payload)

r.raise_for_status()

print(r.json())

Aucun SDK spécial n'est requis — mais si vous utilisez déjà le SDK d'OpenAI, vous pouvez souvent reconfigurer base_url et api_key et conservez les mêmes modèles d’appel.

Utilisation avancée : permettre le raisonnement ou reasoning_content

Si vous avez besoin de la chaîne de pensée interne du modèle (pour l'audit, la distillation ou l'extraction d'étapes intermédiaires), passez à DeepSeek-V3.2-Exp-thinkingL’ reasoning_content le champ (et le flux ou les jetons associés) est disponible dans la réponse pour le mode de raisonnement ; les documents de l'API fournissent reasoning_content comme champ de réponse pour inspecter le CoT généré avant la réponse finale. Remarque : l'exposition de ces jetons peut affecter la facturation, car ils font partie de la sortie du modèle.

Streaming et mises à jour partielles

- Utilisez le

"stream": truedans les demandes de réception de deltas de jetons via SSE (événements envoyés par le serveur). stream_optionsetinclude_usagevous permet de régler comment et quand les métadonnées d'utilisation apparaissent pendant un flux (utile pour les interfaces utilisateur incrémentielles).

Comment DeepSeek-V3.2-Exp se compare-t-il aux modèles DeepSeek précédents ?

V3.2-Exp contre V3.1-Terminus

- Différence principale : La version 3.2-Exp introduit le mécanisme d'attention parcimonieuse afin de réduire les calculs pour les contextes longs, tout en conservant le reste de la recette d'entraînement conforme à la version 3.1. Cela a permis à DeepSeek de comparer plus précisément les gains d'efficacité. ()

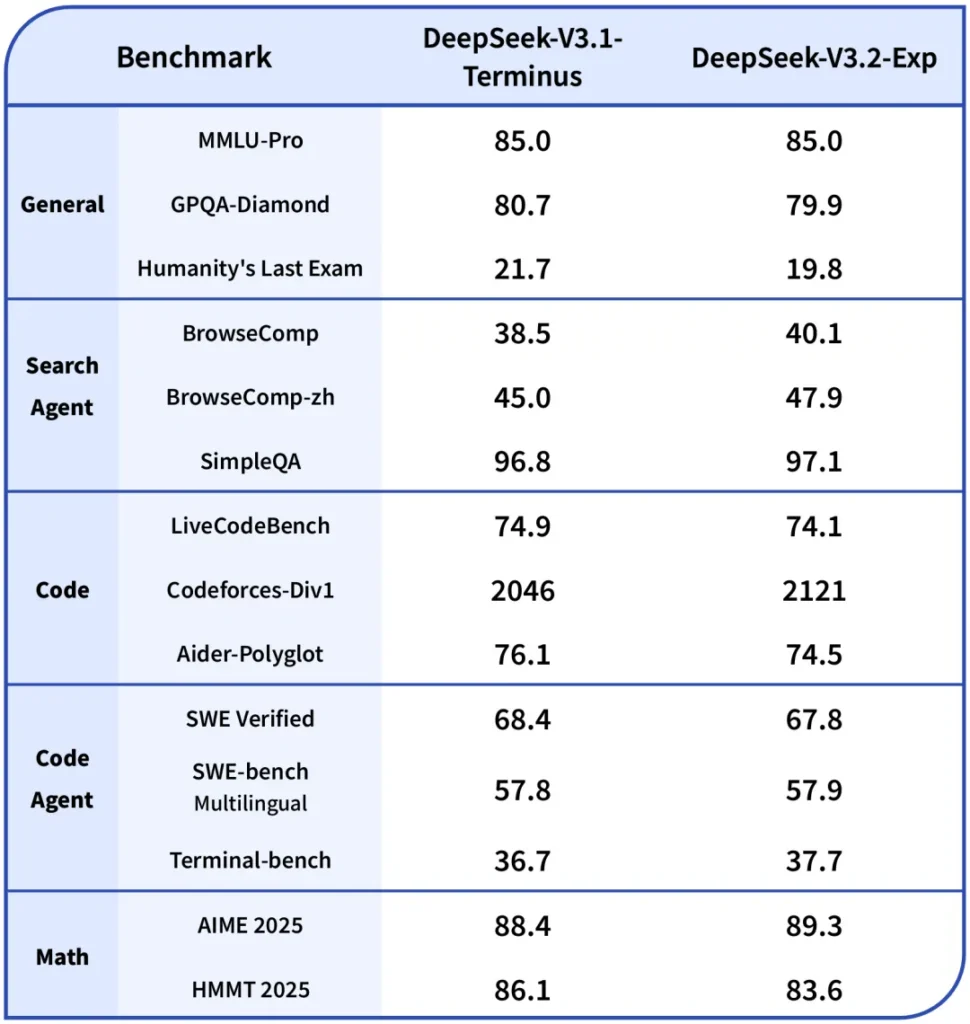

- points de référence: Les notes publiques indiquent que V3.2-Exp fonctionne à peu près au même niveau que V3.1 sur de nombreuses tâches de raisonnement/codage tout en étant nettement moins cher sur les contextes longs ; notez que des tâches spécifiques peuvent encore avoir des régressions mineures en fonction de la manière dont la parcimonie de l'attention interagit avec les interactions de jetons requises.

V3.2-Exp vs R1 / Versions plus anciennes

- Les gammes R1 et V3 poursuivent des objectifs de conception différents (R1 privilégiait historiquement des compromis architecturaux et des capacités multimodales différents dans certaines branches). V3.2-Exp est une évolution de la gamme V3 axée sur les contextes longs et le débit. Si votre charge de travail repose principalement sur des benchmarks de précision brute monotour, les différences peuvent être modestes ; si vous utilisez des pipelines multidocuments, le profil de coût de V3.2-Exp est probablement plus attractif.

Où accéder à Claude Sonnet 4.5

CometAPI est une plateforme d'API unifiée qui regroupe plus de 500 modèles d'IA provenant de fournisseurs leaders, tels que la série GPT d'OpenAI, Gemini de Google, Claude d'Anthropic, Midjourney, Suno, etc., au sein d'une interface unique et conviviale pour les développeurs. En offrant une authentification, un formatage des requêtes et une gestion des réponses cohérents, CometAPI simplifie considérablement l'intégration des fonctionnalités d'IA dans vos applications. Que vous développiez des chatbots, des générateurs d'images, des compositeurs de musique ou des pipelines d'analyse pilotés par les données, CometAPI vous permet d'itérer plus rapidement, de maîtriser les coûts et de rester indépendant des fournisseurs, tout en exploitant les dernières avancées de l'écosystème de l'IA.

Les développeurs peuvent accéder DeepSeek V3.2 Exp via CometAPI, la dernière version du modèle est constamment mis à jour avec le site officiel. Pour commencer, explorez les capacités du modèle dans la section cour de récréation et consultez le Guide de l'API Pour des instructions détaillées, veuillez vous connecter à CometAPI et obtenir la clé API avant d'y accéder. API Comet proposer un prix bien inférieur au prix officiel pour vous aider à vous intégrer.

Prêt à partir ?→ Inscrivez-vous à CometAPI dès aujourd'hui !

Conclusion

DeepSeek-V3.2-Exp est une version expérimentale pragmatique visant à simplifier et à rendre plus économique le travail en contexte long, tout en préservant la qualité de sortie de classe V3. Pour les équipes travaillant avec des documents longs, des transcriptions ou des raisonnements multi-documents, ce test est pertinent : l'API adopte une interface de type OpenAI qui simplifie l'intégration et met en avant le mécanisme DSA ainsi que des réductions de prix significatives qui modifient le calcul économique du développement à grande échelle. Comme pour tout modèle expérimental, une évaluation complète, une instrumentation et un déploiement progressif sont essentiels.