L'API Qwen2.5-Omni-7B fournit aux développeurs des méthodes compatibles OpenAI pour interagir avec le modèle, permettant le traitement des entrées de texte, d'image, d'audio et de vidéo, et générant des réponses textuelles et vocales naturelles en temps réel.

Qu'est-ce que Qwen2.5-Omni-7B ?

Qwen2.5-Omni-7B est le modèle d'IA multimodal phare d'Alibaba, avec 7 milliards de paramètres. Conçu pour traiter et comprendre de multiples modalités de données, il prend en charge les entrées texte, image, audio et vidéo. Ce modèle facilite les interactions vocales et vidéo en temps réel, ce qui en fait un outil polyvalent pour diverses applications.

Principales caractéristiques du Qwen2.5-Omni-7B

- Traitement multimodal : Capable de gérer diverses entrées, notamment du texte, des images, de l'audio et de la vidéo, permettant une compréhension complète des données.

- Interaction en temps réel : Prend en charge le traitement à faible latence, permettant des conversations vocales et vidéo en temps réel.

- Architecture penseur-locuteur : Utilise un système à double architecture dans lequel le « penseur » gère le traitement et la compréhension des données, tandis que le « locuteur » génère des sorties vocales fluides.

- RoPE multimodal aligné dans le temps (TMRoPE) : Utilise TMRoPE pour une synchronisation précise des données temporelles sur différentes modalités, garantissant une compréhension cohérente et la génération de réponses.

Indicateurs de performance

Réalisations de référence

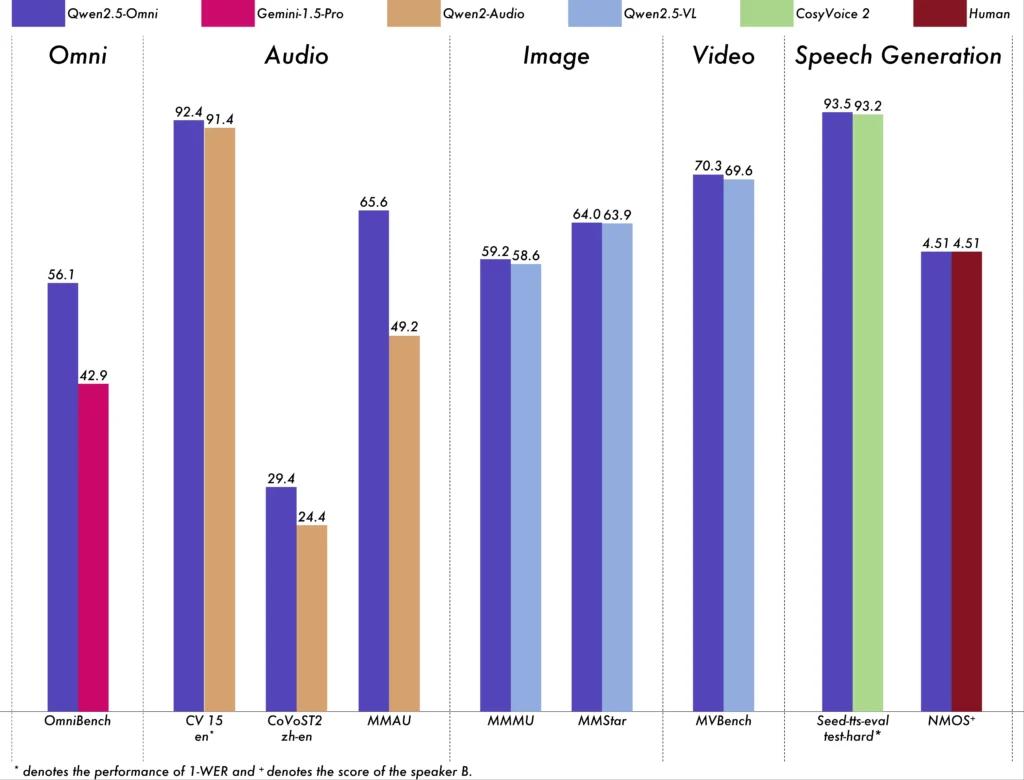

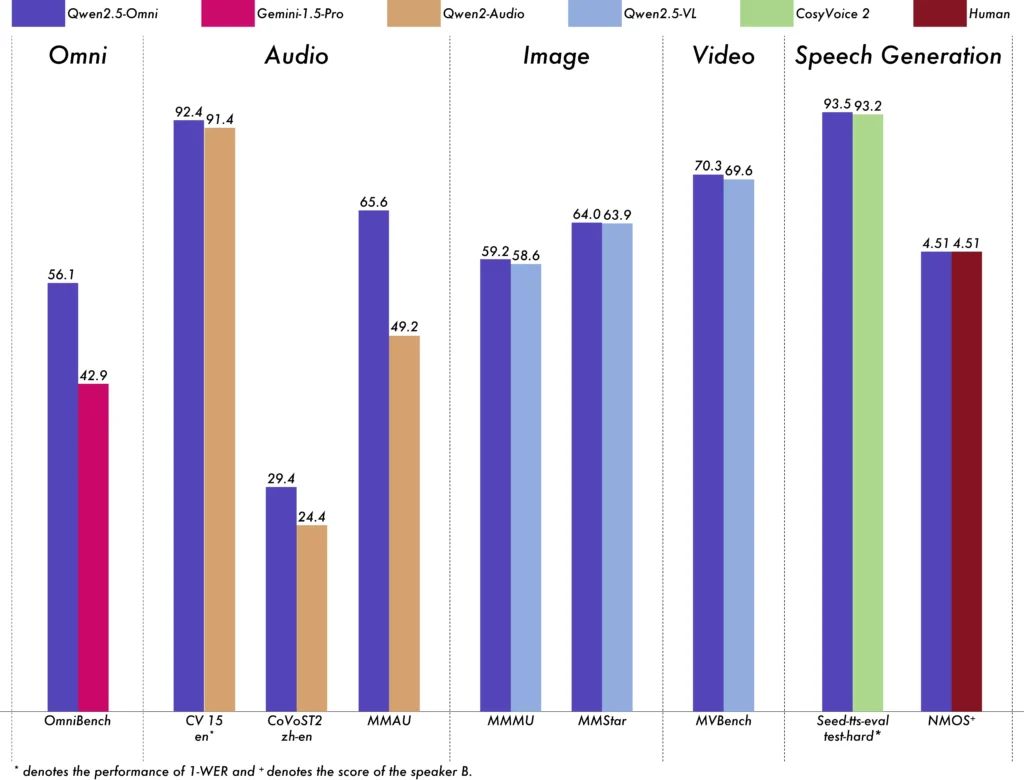

Qwen2.5-Omni-7B a démontré des performances exceptionnelles dans divers benchmarks :

- OmniBench : A obtenu un score moyen de 56.13 %, surpassant des modèles comme Gemini-1.5-Pro (42.91 %) et MIO-Instruct (33.80 %).

- Reconnaissance de la parole: Sur l'ensemble de données Librispeech, il a atteint des taux d'erreur de mots allant de 1.6 % à 3.5 %, comparables à des modèles spécialisés tels que Whisper-large-v3.

- Reconnaissance des événements sonores : A obtenu un score de 0.570 sur l'ensemble de données Meld, établissant une nouvelle référence dans le domaine.

- Compréhension de la musique : A obtenu un score de 0.88 sur le benchmark GiantSteps Tempo, soulignant sa compétence en compréhension musicale.

Capacités de traitement en temps réel

Conçu pour les applications temps réel, le Qwen2.5-Omni-7B prend en charge le streaming bloc par bloc, permettant une génération audio instantanée avec une latence minimale. Cette fonctionnalité est particulièrement utile pour les applications nécessitant des réponses rapides, telles que les assistants virtuels et les systèmes d'IA interactifs.

Spécifications techniques

Conception architecturale

- Cadre du penseur-locuteur : Le composant « Thinker » traite et comprend les entrées multimodales, générant des représentations sémantiques de haut niveau et des sorties textuelles. Le composant « Talker » convertit ces représentations en discours naturel et fluide, assurant une communication fluide entre le système d'IA et les utilisateurs.

- Mécanisme TMRoPE : Répond au défi de la synchronisation des données temporelles provenant de diverses sources en alignant les horodatages des entrées vidéo et audio, facilitant ainsi une compréhension multimodale cohérente.

Méthodologie de formation

Le modèle a subi un processus de formation en trois phases :

- Première phase: Paramètres de modèle de langage fixes lors de la formation d'encodeurs visuels et audio à l'aide de paires audio-texte et image-texte étendues pour améliorer la compréhension multimodale.

- Phase Deux: Dégelez tous les paramètres et entraînez-vous sur un ensemble de données diversifié comprenant des images, des vidéos, de l'audio et du texte, améliorant encore la compréhension multimodale complète.

- Troisième phase: Axé sur la formation de données à longue séquence pour renforcer la capacité du modèle à gérer des entrées complexes et étendues.

Évolution des modèles Qwen

Progression de Qwen à Qwen2.5

L’évolution de Qwen vers Qwen2.5 signifie un bond substantiel dans le développement des modèles d’IA :

- Paramètres améliorés : Qwen2.5 s'est étendu à des modèles comportant jusqu'à 72 milliards de paramètres, offrant des solutions évolutives pour diverses applications.

- Traitement du contexte étendu : Introduction de la possibilité de traiter jusqu'à 128,000 XNUMX jetons, facilitant la gestion de documents volumineux et de conversations complexes.

- Capacités de codage : La variante Qwen2.5-Coder prend en charge plus de 92 langages de programmation, aidant aux tâches de génération de code, de débogage et d'optimisation.

Avantages du Qwen2.5-Omni-7B

Intégration multimodale complète

En traitant efficacement le texte, les images, l'audio et la vidéo, Qwen2.5-Omni-7B fournit une solution d'IA holistique adaptée à une large gamme d'applications.

Interaction en temps réel

Son traitement à faible latence garantit des réponses immédiates, améliorant ainsi l'expérience utilisateur dans les applications interactives.

Accessibilité open source

En tant que modèle open source, Qwen2.5-Omni-7B favorise la transparence et permet aux développeurs de personnaliser et d'intégrer le modèle dans diverses plates-formes sans restrictions propriétaires.

Indicateurs techniques

- Paramètres du modèle: 7 milliards

- Modalités de saisie : Texte, image, audio, vidéo

- Modalités de sortie : Texte, discours

- Capacité de traitement : Interaction vocale et vidéo en temps réel

- Repères de performances :

- OmniBench : 56.13 % de score moyen

- Librispeech (taux d'erreur de mots) : Test-propre : 1.8 %, Test-autre : 3.4 %

Scénarios d'application

Assistants virtuels interactifs

Le traitement en temps réel et la compréhension multimodale du Qwen2.5-Omni-7B le rendent idéal pour les assistants virtuels qui peuvent voir, entendre et répondre naturellement.

Création de contenu multimédia

Les créateurs de contenu peuvent exploiter le modèle pour générer du contenu multimédia attrayant, combinant de manière transparente du texte, des images et de l'audio.

Technologies d'assistance

Les capacités du modèle peuvent aider les personnes handicapées, par exemple en fournissant un son descriptif pour le contenu visuel.

Conseils d'utilisation

Optimiser les performances

Pour obtenir des performances optimales, en particulier dans les applications en temps réel, il est recommandé d'utiliser des accélérateurs matériels et de garantir une mémoire GPU suffisante.

Intégration avec les systèmes existants

Les développeurs doivent prendre en compte les formats d'entrée et de sortie du modèle lors de l'intégration avec des applications existantes pour garantir la compatibilité et maximiser l'efficacité.

Rester à jour

Consultez régulièrement les référentiels et la documentation officiels pour connaître les mises à jour et les meilleures pratiques afin d'exploiter pleinement les capacités de Qwen2.5-Omni-7B.

Rubriques connexes Comment exécuter le modèle Qwen2.5-Omni-7B

Conclusion

Qwen2.5-Omni-7B illustre la convergence entre la recherche avancée en IA et ses applications pratiques, offrant une solution polyvalente et efficace pour une multitude de tâches dans divers secteurs. Son caractère open source garantit son accessibilité et son adaptabilité, ouvrant la voie à de futures innovations en IA multimodale.

Comment appeler l'API Qwen2.5-Omni-7B depuis CometAPI

1.Se connecter à cometapi.comSi vous n'êtes pas encore notre utilisateur, veuillez d'abord vous inscrire

2.Obtenir la clé API d'identification d'accès de l'interface. Cliquez sur « Ajouter un jeton » au niveau du jeton API dans l'espace personnel, récupérez la clé du jeton : sk-xxxxx et soumettez.

-

Obtenez l'URL de ce site : https://api.cometapi.com/

-

Sélectionnez le point de terminaison Qwen2.5-Omni-7B pour envoyer la requête API et définissez le corps de la requête. La méthode et le corps de la requête sont obtenus à partir de notre documentation API de site WebNotre site Web propose également le test Apifox pour votre commodité.

-

Traitez la réponse de l'API pour obtenir la réponse générée. Après l'envoi de la requête API, vous recevrez un objet JSON contenant la complétion générée.