Il rilascio di GLM-5, presentato questa settimana da Zhipu AI in Cina (pubblicamente con il brand Z.AI / zai-org in molti canali per sviluppatori), segna un ulteriore passo nel ritmo accelerato delle release di modelli di grandi dimensioni. Il nuovo modello viene posizionato come il modello di punta di Zhipu: più grande in scala, ottimizzato per compiti agentici di lungo orizzonte e costruito con scelte ingegneristiche pensate per ridurre il costo di inferenza preservando un contesto lungo. Le prime segnalazioni del settore e le note pratiche degli sviluppatori indicano progressi significativi in coding, ragionamento multi-step e orchestrazione di agenti rispetto alle precedenti iterazioni GLM — e in alcuni test sfida persino Claude 4.5.

Che cos’è GLM-5 e chi l’ha costruito?

GLM-5 è l’ultima major release della famiglia GLM: un grande foundation model open source sviluppato e pubblicato da Z.ai (il team dietro la serie GLM). Annunciato all’inizio di febbraio 2026, GLM-5 viene presentato come un modello di nuova generazione specificamente ottimizzato per compiti “agentici” — cioè workflow multi-step e di lungo orizzonte in cui il modello deve pianificare, chiamare strumenti, eseguire e mantenere il contesto per conversazioni estese o agenti automatizzati. Il rilascio è notevole non solo per il design del modello ma anche per come e dove è stato addestrato: Z.ai ha utilizzato un mix di hardware e toolchain domestici cinesi nell’ambito di una spinta verso l’autosufficienza.

Dati segnalati su architettura e training includono:

- Parameter scaling: GLM-5 scala fino a circa 744B parametri (con un numero di esperti “attivi” più piccolo citato in alcune note tecniche, ad es. 40B attivi), rispetto alle dimensioni della famiglia GLM-4 intorno a 355B/32B attivi.

- Pretraining data: La dimensione del corpus di training è passata da ~23 trilioni di token (generazione GLM-4) a ~28.5 trilioni di token per GLM-5.

- Sparse attention / DeepSeek Sparse Attention (DSA): Uno schema di attenzione sparsa per preservare il lungo contesto riducendo il costo computazionale in inferenza.

- Design emphasis: scelte ingegneristiche focalizzate su orchestrazione di agenti, ragionamento su contesti lunghi e inferenza a costo contenuto.

Origini e posizionamento

GLM-5 si basa su una linea che include GLM-4.5 (rilasciato a metà 2025) e alcuni aggiornamenti iterativi come 4.7. Z.ai posiziona GLM-5 come un salto dal "vibe coding" (output di codice rapidi in singolo step) verso l’“ingegneria agentica”: ragionamento sostenuto, orchestrazione multi-strumento e sintesi di sistemi su lunghe finestre di contesto. I materiali pubblici sottolineano che GLM-5 è stato progettato per gestire compiti complessi di ingegneria dei sistemi — costruendo, coordinando e mantenendo comportamenti di agenti multi-step anziché limitarsi a rispondere a query isolate.

Quali sono le nuove funzionalità di GLM-5?

Principali cambiamenti architetturali

- Scalabilità sparsa massiva (MoE): GLM-5 passa a un’architettura a Mixture-of-Experts sparsa molto più ampia. Le cifre pubbliche dalle pagine per sviluppatori e da articoli indipendenti indicano il modello a circa 744B parametri totali con ~40B attivi per token — un passo significativo rispetto alla configurazione di GLM-4.5 di ~355B / 32B attivi. Questa scalabilità sparsa consente al modello di presentare una capacità totale molto grande mantenendo il computo per token gestibile.

- DeepSeek Sparse Attention (DSA): Per preservare la capacità di lungo contesto senza scalare linearmente il costo di inferenza, GLM-5 integra un meccanismo di attenzione sparsa (brandizzato DeepSeek) per mantenere importanti dipendenze di lungo raggio mentre riduce il costo dell’attenzione su contesti di lunghezza molto grande.

Ingegneria agentica come obiettivo di progettazione fondamentale

Una delle caratteristiche di punta di GLM-5 è che è esplicitamente progettato per l’ingegneria agentica — il che significa che il modello è pensato per essere usato non solo per chat a singolo turno o attività di riepilogo, ma come il “cervello” di agenti multi-step in grado di pianificare, emettere chiamate a strumenti, gestire lo stato e ragionare su contesti lunghi. Z.ai posiziona GLM-5 per operare in cicli di orchestrazione: scomporre problemi complessi, chiamare strumenti/API esterni e tracciare compiti lunghi su molti turni.

Perché il design agentico conta

I workflow agentici sono centrali per l’automazione reale: assistenti di ricerca automatizzati, ingegneri software autonomi, orchestrazione di operazioni e controllo di simulazioni. Un modello costruito per questo mondo necessita di pianificazione solida, comportamento stabile nel tool-calling e robustezza su migliaia di token di contesto.

Coding, ragionamento e comportamento “di lungo orizzonte” migliorati

GLM-5 enfatizza il miglioramento nella generazione di codice e nel ragionamento. Z.ai dichiara miglioramenti mirati nella capacità del modello di scrivere, refactoring e fare debug del codice, oltre a un ragionamento multi-step più coerente su interazioni lunghe. Report di early-access indipendenti e valutazioni di partner hanno riscontrato il modello nettamente più forte sui compiti orientati agli sviluppatori rispetto alle generazioni GLM precedenti.

Funzionalità pratiche per sviluppatori

- Finestre di contesto più grandi per contenere documentazione, codebase e stato della conversazione.

- Primitive di tooling per invocazioni sicure degli strumenti e gestione dei risultati.

- Migliori prestazioni few-shot e di ragionamento a catena per scomporre ed eseguire compiti complessi.

- Funzionalità agentiche e tool-calling: GLM-5 enfatizza il supporto nativo per agenti: function/tool calling, sessioni stateful e migliore gestione di dialoghi lunghi e sequenze d’uso degli strumenti. Questo rende più semplice costruire agenti che integrano web search, database o automazione di task.

Come si comporta GLM-5 nei benchmark?

Evidenze specifiche dai benchmark

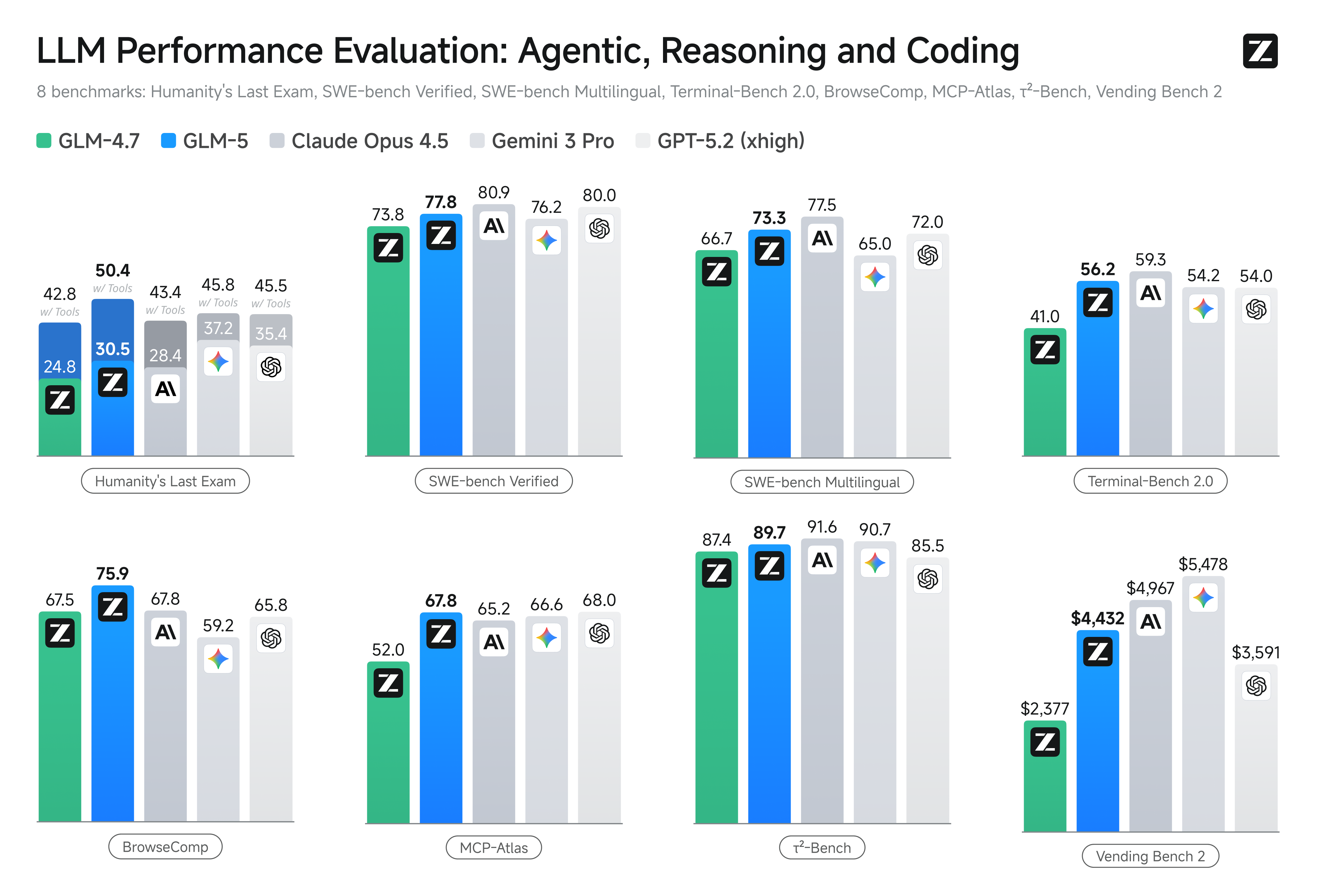

- Benchmark di coding: GLM-5 si avvicina (e in alcuni casi eguaglia) le prestazioni di coding di modelli proprietari altamente ottimizzati come Claude Opus 4.5 su compiti specifici di coding. Questi risultati dipendono dal compito (unit test, coding algoritmico, uso di API), ma segnano un chiaro miglioramento rispetto a GLM-4.5.

- Test di ragionamento e agentic: Su suite di valutazione del ragionamento multi-step e agentico (ad es., pianificazione multi-turno, benchmark di scomposizione dei compiti), GLM-5 ha ottenuto risultati best-in-class tra i modelli open source e in alcune metriche ha superato modelli chiusi concorrenti su task mirati.

Come posso accedere e provare GLM-5?

GLM-5 è il modello di linguaggio di quinta generazione di Zhipu AI (Z.ai), costruito con un’architettura Mixture-of-Experts (~745 B totali, ~44 B attivi) e mirato a forte ragionamento, coding e workflow agentici. È stato lanciato ufficialmente intorno al 12 febbraio 2026.

Al momento ci sono due modi principali per accedervi:

A) Accesso API ufficiale (Z.ai o aggregatori)

Zhipu AI offre direttamente API per i suoi modelli, e puoi chiamare GLM-5 tramite queste API.

Passi tipici:

- Iscriviti a un account API Z.ai/Open BigModel.

- Ottieni una chiave API dal dashboard.

- Usa un endpoint stile OpenAPI o REST con il nome del modello (es.,

glm-5).

(Simile a come chiameresti i modelli GPT da OpenAI). - Imposta i prompt e invia richieste HTTP.

👉 La pagina prezzi di Z.ai mostra prezzi ufficiali per i token di GLM-5 come:

- ~$1.0 per milione di token di input

- ~$3.2 per milione di token di output

B) Wrapper API di terze parti ——CometAPI

API come CometAPI o WaveSpeed avvolgono più modelli AI (OpenAI, Claude, Z.ai ecc.) dietro un’interfaccia unificata.

- Con servizi come CometAPI puoi chiamare i modelli GLM cambiando l’ID del modello.

(CometAPI attualmente supporta GLM-5/GLM-4.7.) - Il glm-5 di CometAPI è prezzato al 20% del prezzo ufficiale.

| Tipo di utilizzo | Prezzo |

|---|---|

| Token di input | ~$0.8 per 1M token |

| Token di output | ~$2.56 per 1M token |

Perché è importante: Conservi il tuo codice client compatibile con OpenAI e cambi solo la base URL/ID del modello.

C) Self-Hosting via Hugging Face / Weights

Ci sono repository non ufficiali dei pesi di GLM-5 (ad es., versioni denominate glm-5/glm-5-fp8) visibili nelle listing dei modelli su Hugging Face.

Con questi puoi:

- Scaricare i pesi del modello.

- Usare strumenti come vLLM, SGLang, xLLM o Transformers per servire localmente o sulla tua fleet di GPU in cloud.

Pro: controllo massimo, nessun costo API ricorrente.

Contro: requisiti computazionali enormi — probabilmente più GPU di fascia alta e memoria (diverse centinaia di GB), rendendolo impraticabile su sistemi piccoli.

Quindi — GLM-5 vale la pena, e conviene mantenere GLM-4.7?

Risposta breve (sintesi esecutiva)

- Se il tuo lavoro richiede comportamento agentico robusto multi-step, generazione di codice di livello produttivo o automazione a livello di sistema: vale la pena valutare GLM-5 subito. La sua architettura, scala e tuning danno priorità proprio a questi risultati.

- Se ti serve una microservitistica efficiente in costi e ad alto throughput (chat brevi, classificazione, prompt leggeri): GLM-4.7 probabilmente rimane la scelta più economica. GLM-4.7 preserva un set di capacità solide a un costo per token significativamente inferiore in molte offerte dei provider ed è già collaudato.

Risposta più articolata (raccomandazione pratica)

Adotta una strategia a livelli di modelli: usa GLM-4.7 per interazioni quotidiane ad alto volume e riserva GLM-5 per problemi di ingegneria ad alto valore e orchestrazione agentica. Fai un pilot di GLM-5 su una piccola porzione di prodotto che eserciti contesto lungo, integrazione di strumenti e correttezza del codice; misura sia il tempo di ingegneria risparmiato sia il costo incrementale del modello. Nel tempo, saprai se l’aumento di capacità di GLM-5 giustifica una migrazione più ampia.

Con CometAPI, puoi passare tra GLM-4.7 e GLM-5 in qualsiasi momento.

Casi d’uso reali in cui GLM-5 eccelle

1. Orchestrazione complessa di agenti

Il focus di GLM-5 su pianificazione multi-step e chiamata di strumenti lo rende adatto a sistemi che devono coordinare ricerca, chiamate API e esecuzione di programmi (per esempio: assistenti di ricerca automatizzati, generatori di codice iterativi o agenti di customer service multi-step che devono consultare database e API esterne).

2. Ingegneria longform e ragionamento su codebase

Quando serve che il modello analizzi, faccia refactoring o sintetizzi su molti file o una codebase grande, il contesto esteso e l’attenzione sparsa di GLM-5 sono vantaggi diretti — meno modalità di errore causate da contesti troncati e migliore coerenza su lunghe tratte.

3. Sintesi knowledge-intensive

Analisti e team di prodotto che generano report complessi — brief di ricerca multi-sezione, sintesi legali o filing regolatori — possono beneficiare dei miglioramenti nel ragionamento multi-step sostenuto e della riduzione delle allucinazioni nei test riportati dai vendor.

4. Automazione agentica dei workflow

I team che costruiscono automazioni che devono orchestrare più sistemi (ad es., pianificazione + ticketing + pipeline di deploy) possono usare GLM-5 come pianificatore ed esecutore centrale, supportato da framework di tool-calling e wrapper di sicurezza.

Conclusione

GLM-5 è un rilascio importante nel panorama in rapida evoluzione dei frontier model. La sua enfasi sull’ingegneria agentica, coding e ragionamento migliorati, e disponibilità di pesi lo rende attraente per team che costruiscono sistemi AI abilitati agli strumenti e di lungo orizzonte. Progressi reali su task selezionati e incoraggianti tradeoff costo/prestazioni — ma gli acquirenti dovrebbero valutare GLM-5 rispetto ai loro task specifici ed eseguire benchmark controllati prima di impegnarsi in produzione.

Gli sviluppatori possono accedere a GLM-5 tramite CometAPI ora. Per iniziare, esplora le capacità del modello nel Playground e consulta la API guide per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l’accesso a CometAPI e ottenuto la chiave API. CometAPI offre un prezzo molto inferiore a quello ufficiale per aiutarti a integrare.

Pronto a partire?→ Sign up fo glm-5 today !

Se vuoi conoscere altri suggerimenti, guide e notizie sull’AI, seguici su VK, X e Discord!