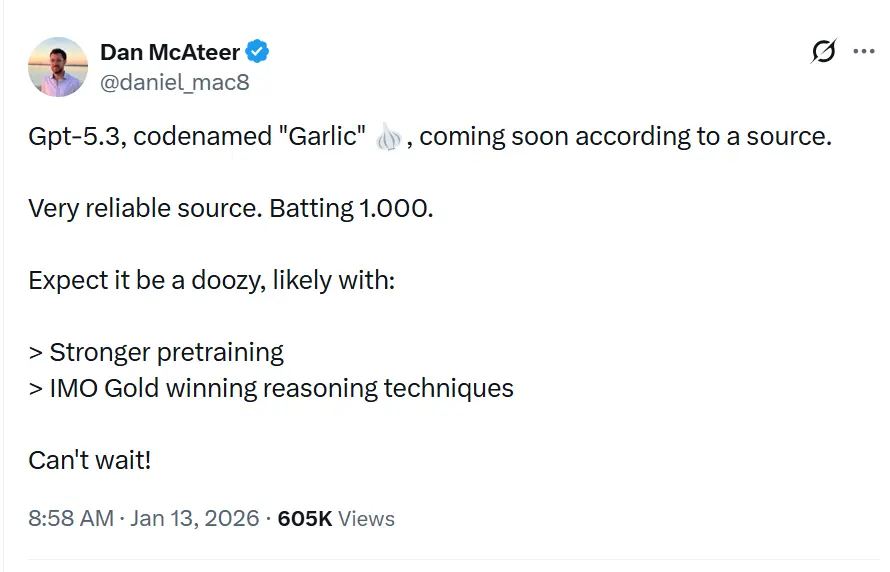

Il nome in codice GPT-5.3“Garlic”, è descritto in leak e report come la prossima release incrementale/iterativa della serie GPT-5.x, concepita per colmare lacune nel ragionamento, nella programmazione e nelle prestazioni di prodotto; è la risposta di OpenAI alla pressione competitiva di Gemini di Google e Claude di Anthropic.

OpenAI sta sperimentando un’iterazione GPT-5.x più densa ed efficiente, focalizzata su un ragionamento più solido, un’inferenza più veloce e flussi di lavoro a contesto più lungo, invece che su conteggi di parametri sempre più grandi. Non è semplicemente un’altra iterazione della serie Generative Pre-trained Transformer; è una controffensiva strategica. Nata da un “Code Red” interno dichiarato dal CEO Sam Altman nel dicembre 2025, “Garlic” rappresenta un rifiuto del dogma “bigger is better” che ha governato lo sviluppo degli LLM per mezzo decennio. Invece, punta tutto su una nuova metrica: la densità cognitiva.

Che cos’è GPT-5.3 “Garlic”?

GPT-5.3 — nome in codice “Garlic” — viene descritto come il prossimo passo iterativo nella famiglia GPT-5 di OpenAI. Le fonti che inquadrano il leak presentano Garlic non come un semplice checkpoint o un ritocco ai token, ma come un affinamento mirato di architettura e training: l’obiettivo è estrarre prestazioni di ragionamento più elevate, una migliore pianificazione multi-step e un comportamento più efficace su contesti lunghi da un modello più compatto ed efficiente in inferenza, invece di fare affidamento esclusivamente sulla scala. Questa impostazione è in linea con le tendenze del settore verso modelli “densi” o ad “alta efficienza”.

Il soprannome “Garlic” — una netta deviazione dai nomi in codice più celestiali (Orion) o dolcemente botanici (Strawberry) del passato — è presumibilmente una metafora interna deliberata. Proprio come un singolo spicchio d’aglio può insaporire un intero piatto più potentemente di ingredienti più grandi ma più insipidi, questo modello è progettato per fornire intelligenza concentrata senza l’enorme overhead computazionale dei giganti del settore.

La genesi del “Code Red”

L’esistenza di Garlic non può essere disgiunta dalla crisi esistenziale che l’ha generata. Alla fine del 2025, OpenAI si è trovata per la prima volta in una posizione “difensiva” dal lancio di ChatGPT. Gemini 3 di Google aveva conquistato la corona nei benchmark multimodali, e Claude Opus 4.5 di Anthropic era diventato lo standard de facto per la programmazione complessa e i flussi di lavoro agentici. In risposta, la leadership di OpenAI ha messo in pausa i progetti periferici — inclusi esperimenti su piattaforme pubblicitarie ed espansioni di agenti consumer — per concentrarsi interamente su un modello in grado di eseguire un “colpo tattico” contro questi concorrenti.

Garlic è quel colpo. Non è pensato per essere il modello più grande al mondo; è pensato per essere il più intelligente per parametro. Unisce le linee di ricerca di precedenti progetti interni, in particolare “Shallotpeat”, incorporando correzioni di bug ed efficienze nel pre-training che gli consentono di rendere molto al di sopra della sua “classe di peso”.

Qual è lo stato attuale delle iterazioni osservate del modello GPT-5.3?

A metà gennaio 2026, GPT-5.3 è nelle fasi finali di validazione interna, una fase spesso descritta nella Silicon Valley come “hardening”. Il modello è attualmente visibile nei log interni ed è stato testato a campione da selezionati partner enterprise sotto rigidi accordi di non divulgazione.

Iterazioni osservate e integrazione di “Shallotpeat”

La strada verso Garlic non è stata lineare. Leak di memo interni del Chief Research Officer Mark Chen suggeriscono che Garlic sia in realtà un composito di due filoni di ricerca distinti. Inizialmente, OpenAI stava sviluppando un modello con nome in codice “Shallotpeat”, pensato come aggiornamento incrementale diretto. Tuttavia, durante il pre-training di Shallotpeat, i ricercatori hanno scoperto un metodo inedito per “comprimere” i pattern di ragionamento — in sostanza, insegnando al modello a scartare prima nel processo di training i percorsi neurali ridondanti.

Questa scoperta ha portato all’abbandono del rilascio standalone di Shallotpeat. La sua architettura è stata fusa con il ramo più sperimentale “Garlic”. Il risultato è un’iterazione ibrida che possiede la stabilità di una variante GPT-5 matura ma l’esplosiva efficienza nel ragionamento di una nuova architettura.

Quando possiamo ipotizzare il momento del rilascio?

Prevedere le date di rilascio di OpenAI è notoriamente difficile, ma lo status di “Code Red” accelera le tempistiche standard. Basandoci sulla convergenza di leak, aggiornamenti dei vendor e cicli dei concorrenti, possiamo triangolare una finestra di rilascio.

Finestra principale: Q1 2026 (gennaio - marzo)

Il consenso tra gli insider è un lancio nel Q1 2026. Il “Code Red” è stato dichiarato a dicembre 2025, con la direttiva di rilasciare “il prima possibile”. Dato che il modello è già in fase di verifica/validazione (la fusione con “Shallotpeat” avendo accelerato la timeline), un rilascio a fine gennaio o inizio febbraio sembra il più plausibile.

Il rollout “beta”

Potremmo vedere un rilascio scaglionato:

- Fine gennaio 2026: una release “preview” per partner selezionati e utenti ChatGPT Pro (forse con l’etichetta “GPT-5.3 (Preview)”).

- Febbraio 2026: piena disponibilità dell’API.

- Marzo 2026: integrazione nel livello gratuito di ChatGPT (query limitate) per contrastare la gratuità di Gemini.

3 caratteristiche distintive di GPT-5.3?

Se le voci si rivelassero vere, GPT-5.3 introdurrà una suite di funzionalità che privilegiano utilità e integrazione rispetto alla pura creatività generativa. Il set di feature sembra una lista dei desideri per architetti di sistemi e sviluppatori enterprise.

1. Pre-training ad alta densità (EPTE)

Il fiore all’occhiello di Garlic è la sua Enhanced Pre-Training Efficiency (EPTE).

I modelli tradizionali apprendono osservando enormi quantità di dati e creando una vasta rete di associazioni. Il processo di training di Garlic coinvolge presumibilmente una fase di “potatura” in cui il modello condensa attivamente le informazioni.

- Il risultato: un modello fisicamente più piccolo (in termini di requisiti di VRAM) ma che conserva la “World Knowledge” di un sistema molto più grande.

- Il beneficio: velocità di inferenza più elevate e costi API significativamente inferiori, affrontando il rapporto “intelligenza/costo” che ha ostacolato l’adozione di massa di modelli come Claude Opus.

2. Ragionamento agentico nativo

A differenza dei modelli precedenti che richiedevano “wrapper” o complesse tecniche di prompt engineering per funzionare come agenti, Garlic dispone di capacità native di chiamata degli strumenti.

Il modello tratta le chiamate API, l’esecuzione di codice e le query ai database come “cittadini di primo livello” nel suo vocabolario.

- Integrazione profonda: non solo “sa come programmare”; comprende l’ambiente del codice. A quanto si dice può navigare in una directory di file, modificare più file simultaneamente ed eseguire i propri unit test senza script di orchestrazione esterni.

3. Finestre di contesto e di output enormi

Per competere con la finestra di contesto da un milione di token di Gemini, si dice che Garlic venga distribuito con una finestra di contesto da 400.000 token. Pur essendo più piccola dell’offerta di Google, il differenziatore chiave è la “Memoria perfetta” su tale finestra, grazie a un nuovo meccanismo di attenzione che evita la perdita “a metà contesto” comune nei modelli del 2025.

- Limite di output a 128k: forse ancora più entusiasmante per gli sviluppatori è l’espansione del limite di output a 128.000 token. Questo permetterebbe al modello di generare intere librerie software, memorie legali complete o novelle a lunghezza piena in un’unica passata, eliminando la necessità di “spezzare” i contenuti.

4. Allucinazioni drasticamente ridotte

Garlic utilizza una tecnica di rinforzo post-training incentrata sull’“umiltà epistemica” — il modello viene addestrato rigorosamente a sapere ciò che non sa. I test interni mostrano un tasso di allucinazioni significativamente inferiore rispetto a GPT-5.0, rendendolo idoneo per settori ad alto rischio come biomedicina e diritto.

Come si confronta con concorrenti come Gemini e Claude 4.5?

Il successo di Garlic non sarà misurato in isolamento, ma in confronto diretto con i due titani che attualmente dominano l’arena: Gemini 3 di Google e Claude Opus 4.5 di Anthropic.

GPT-5.3 “Garlic” vs. Google Gemini 3

La battaglia tra scala e densità.

- Gemini 3: attualmente il modello “tutto incluso”. Domina nella comprensione multimodale (video, audio, generazione nativa di immagini) e dispone di una finestra di contesto di fatto infinita. È il miglior modello per dati “disordinati” del mondo reale.

- GPT-5.3 Garlic: non può competere con l’ampiezza multimodale grezza di Gemini. Invece, attacca Gemini sulla purezza del ragionamento. Per la generazione pura di testo, la logica del codice e il rispetto di istruzioni complesse, Garlic punta a essere più affilato e meno incline a “rifiuti” o divagazioni.

- Il verdetto: se devi analizzare un video di 3 ore, usi Gemini. Se devi scrivere il backend di un’app bancaria, usi Garlic.

GPT-5.3 “Garlic” vs. Claude Opus 4.5

La battaglia per l’anima degli sviluppatori.

- Claude Opus 4.5: rilasciato alla fine del 2025, ha conquistato gli sviluppatori con il suo “calore” e le sue “vibes”. È famoso per scrivere codice pulito, leggibile e per seguire le istruzioni di sistema con precisione militare. Tuttavia, è costoso e lento.

- GPT-5.3 Garlic: questo è il bersaglio diretto. Garlic mira a eguagliare la competenza di Opus 4.5 nella programmazione ma a doppia velocità e metà costo. Usando il “Pre-training ad Alta Densità”, OpenAI vuole offrire intelligenza a livello Opus con un budget da Sonnet.

- Il verdetto: il “Code Red” è stato innescato specificamente dal dominio di Opus 4.5 nella programmazione. Il successo di Garlic dipende interamente dalla capacità di convincere gli sviluppatori a tornare a usare le chiavi API di OpenAI. Se Garlic saprà programmare bene quanto Opus ma gira più veloce, il mercato cambierà dall’oggi al domani.

Considerazioni chiave

Le prime build interne di Garlic stanno già superando Gemini 3 di Google e Opus 4.5 di Anthropic in domini specifici ad alto valore:

- Competenza nella programmazione: in benchmark “difficili” interni (oltre lo standard HumanEval), Garlic mostra una minore tendenza a bloccarsi in “loop logici” rispetto a GPT-4.5.

- Densità di ragionamento: il modello richiede meno token di “pensiero” per arrivare a conclusioni corrette, in netto contrasto con la pesantezza della “chain-of-thought” della serie o1 (Strawberry).

| Metrica | GPT-5.3 (Garlic) | Google Gemini 3 | Claude 4.5 |

|---|---|---|---|

| Ragionamento (GDP-Val) | 70.9% | 53.3% | 59.6% |

| Programmazione (HumanEval+) | 94.2% | 89.1% | 91.5% |

| Finestra di contesto | 400K token | 2M token | 200K token |

| Velocità di inferenza | Ultra-rapida | Moderata | Rapida |

Conclusione

“Garlic” è una voce plausibile e attiva: una linea di ingegneria mirata di OpenAI che dà priorità a densità di ragionamento, efficienza e strumenti per il mondo reale. La sua comparsa va letta nel contesto di una corsa agli armamenti accelerata tra i fornitori di modelli (OpenAI, Google, Anthropic) — in cui il premio strategico non è solo la capacità grezza ma la capacità utilizzabile per dollaro e per millisecondo di latenza.

Se sei interessato a questo nuovo modello, segui CometAPI. Aggiorna sempre con i modelli di AI più recenti e migliori a un prezzo accessibile.

Gli sviluppatori possono accedere a GPT-5.2 ,Gemini 3, Claude 4.5 tramite CometAPI ora. Per iniziare, esplora le capacità dei modelli di CometAPI nel Playground e consulta la guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l’accesso a CometAPI e di aver ottenuto la chiave API. CometAPI offre un prezzo di gran lunga inferiore a quello ufficiale per aiutarti a integrare.

Pronti a partire?→ Registrati a CometAPI oggi !

Se vuoi conoscere altri suggerimenti, guide e novità sull’AI, seguici su VK, X e Discord!