Quando xAI ha annunciato Grok Code Fast 1 Alla fine di agosto 2025, la comunità dell'intelligenza artificiale ha ricevuto un segnale chiaro: Grok non è più solo un assistente conversazionale, ma è diventato un'arma per i flussi di lavoro degli sviluppatori. Grok Code Fast 1 (breve: Codice veloce 1) è un modello di ragionamento a basso costo, a bassa latenza e appositamente progettato per attività di codifica e agentico Flussi di lavoro di codifica, ovvero flussi di lavoro in cui il modello può pianificare, richiamare strumenti e agire come un assistente di codifica autonomo all'interno di IDE e pipeline. Il modello ha già iniziato a comparire nelle integrazioni dei partner (in particolare come anteprima opt-in in GitHub Copilot) e in numerosi cataloghi di provider cloud e di terze parti come CometAPI.

Che cos'è Grok Code Fast 1 e perché è importante?

xAI grok-code-fast-1 In quanto modello di codifica deliberatamente focalizzato e a bassa latenza, mirato a essere un partner attivo all'interno di strumenti di sviluppo e flussi di lavoro automatizzati. Posizionato come un pratico "programmatore in coppia" ottimizzato per la velocità, l'uso di strumenti agenti (ricerca, chiamate di funzioni, modifiche al codice, test) e il ragionamento in contesti ampi su più repository, è una variante specialistica della famiglia Grok di xAI che privilegia due aspetti: velocità interattiva e al costi economici dei token per i flussi di lavoro di codifica. Invece di competere per essere il più ampio e multimodale generalista, si concentra sul ciclo quotidiano dello sviluppatore: leggere il codice, proporre modifiche, richiamare strumenti (linter/test) e iterare rapidamente.

Perché è importante adesso:

- I team si aspettano sempre più feedback immediati all'interno di IDE e CI: attendere diversi secondi per ogni iterazione dell'assistente interrompe il flusso. Grok Code Fast 1 è progettato espressamente per ridurre questo attrito.

- Supporta chiamata di funzione, output strutturati e tracce di ragionamento visibili, consentendo una migliore automazione delle attività multi-step (ricerca → modifica → test → convalida). Ciò lo rende una soluzione ideale per sistemi di codifica agentica e assistenti sviluppatori orchestrati.

Perché “agente” è importante qui

I modelli agentivi sono più di un semplice "completamento automatico". Possono:

- decidere quale strumento esterno chiamare (eseguire test, recuperare la documentazione del pacchetto),

- suddividere un compito in sotto-fasi ed eseguirli,

- restituire risultati JSON strutturati o apportare modifiche in stile git a livello di programmazione.

Grok Code Fast 1 espone deliberatamente le sue tracce di ragionamento (in modo che gli sviluppatori possano ispezionare la catena di pensiero durante lo streaming) e sottolinea la chiamata di strumenti nativi, due funzionalità che supportano una codifica agentica sicura e gestibile.

Prestazioni e velocità Grok Code Fast 1

Come misura la velocità Grok?

"Veloce" nel branding del modello si riferisce a più dimensioni:

- Latenza di inferenza — throughput dei token e tempo di risposta durante la generazione di codice o di tracce di ragionamento. Il modello è ottimizzato per una latenza inferiore, in modo da adattarsi ai cicli IDE interattivi (completamento automatico, suggerimenti di codice, correzioni rapide di bug) anziché solo a lunghi processi batch.

- Efficienza dei costi — la determinazione del prezzo dei token e la configurazione del modello mirano a ridurre i costi per utilizzo per le attività di codifica di routine; i marketplace di terze parti li elencano a tariffe inferiori rispetto a modelli più grandi e generali.

- Produttività degli sviluppatori — “velocità” percepita in un flusso di lavoro: la rapidità con cui uno sviluppatore può passare da un prompt a un codice eseguibile, inclusa la capacità del modello di chiamare funzioni e restituire output strutturati e testabili.

Note sulle prestazioni nel mondo reale

| Azione / Modello | Grok Code Fast 1 (Osservato) |

|---|---|

| Completamento semplice della riga | istantaneo |

| Generazione di funzioni (5-10 righe) | <1 secondo |

| Generazione di componenti/file complessi (oltre 50 righe) | secondi 2-5 |

| Refactoring di una funzione di grandi dimensioni | secondi 5-10 |

Confronto delle prestazioni

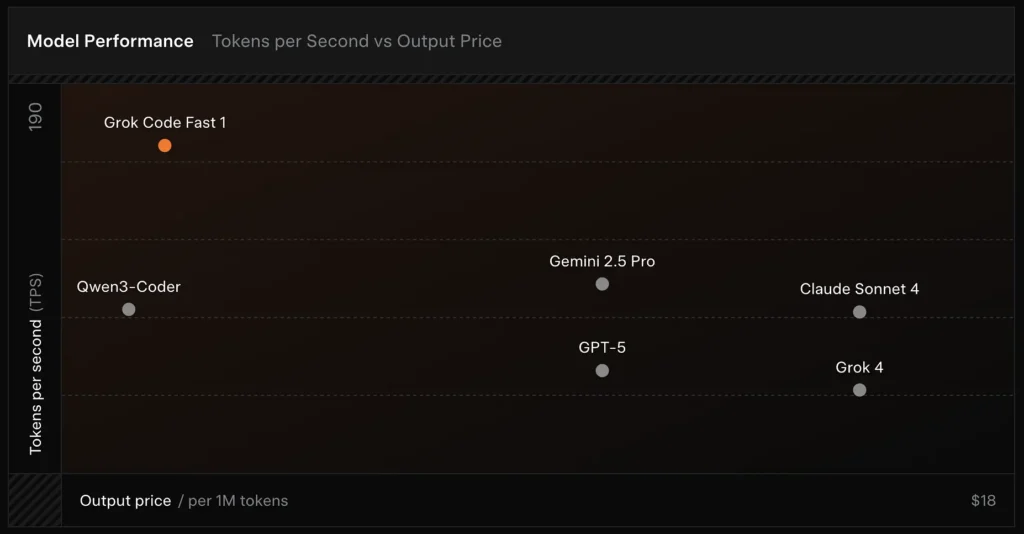

- Velocità: raggiunti 190 token/secondo durante i test.

- Confronto dei prezzi: l'output di GPT-5 costa circa $ 18 per 1 milione di token, mentre Grok Code Fast-1 costa solo $ 1.50.

- Precisione: punteggio del 70.8% nel benchmark SWE-Bench-Verified.

Scelte di progettazione che consentono velocità

- Ampia finestra di contesto (256k token): consente al modello di assimilare grandi basi di codice o lunghe cronologie di conversazioni senza troncamento, riducendo la necessità di ripetuti caricamenti di contesto.

- Prompt compatibile con la cache: il modello e la piattaforma sono ottimizzati per memorizzare nella cache i token di prefisso che raramente cambiano nei vari passaggi agenti, il che riduce i calcoli ripetuti e migliora la latenza per le interazioni degli strumenti in più fasi.

- Protocollo nativo di chiamata degli strumenti: Invece di XML ad hoc o di fragili "chiamate di funzione" basate su stringhe, l'API di Grok supporta definizioni strutturate di funzioni/strumenti che il modello può invocare durante il suo processo di ragionamento (con riepiloghi o "tracce di pensiero" trasmessi in streaming). Questo riduce al minimo il lavoro di analisi e consente al modello di combinare più strumenti in modo affidabile.

Quali funzionalità offre Grok Code Fast 1?

Di seguito sono elencate le caratteristiche principali che rendono Grok Code Fast 1 interessante per le integrazioni rivolte agli sviluppatori.

Capacità principali

- Codifica agentica: supporto integrato per la chiamata di strumenti (test runner, linter, ricerche di pacchetti, operazioni git) e la composizione di flussi di lavoro multi-step.

- Tracce di ragionamento in streaming: quando utilizzata in modalità streaming, l'API fornisce "contenuti di ragionamento" intermedi in modo che sviluppatori e sistemi possano osservare la pianificazione del modello e intervenire.

- Output strutturati e chiamata di funzione: restituisce risultati JSON o tipizzati adatti al consumo programmatico (non solo testo libero).

- Contesto molto ampio (256k token): potente per attività su più file e sessioni singole.

- Inferenza rapida: L'innovativa tecnologia di accelerazione e l'ottimizzazione della cache dei prompt migliorano significativamente la velocità di inferenza. La velocità di risposta è estremamente rapida, spesso completando decine di chiamate di strumenti prima che un utente finisca di leggere un prompt.

- Ottimizzazione della programmazione agentica: Strumenti di sviluppo comuni: grep, operazioni da terminale e modifica dei file. Perfettamente integrato nei principali IDE come Cursor, GitHub Copilot e Cline.

- Copertura del linguaggio di programmazione: Ottime competenze in diversi linguaggi: TypeScript, Python, Java, Rust, C++ e Go. In grado di gestire una gamma completa di attività di sviluppo, dalla creazione di progetti da zero alla risoluzione di problemi di basi di codice complesse e all'esecuzione di correzioni di bug dettagliate.

Ergonomia dello sviluppatore

- Superficie SDK compatibile con OpenAI: L'API di xAI enfatizza la compatibilità con gli SDK più diffusi e fornisce indicazioni sulla migrazione per abbreviare l'onboarding degli sviluppatori.

- Supporto CometAPI e BYOK: fornitori terzi come CometaAPI Esporre Grok Code Fast 1 tramite REST per i team che preferiscono endpoint compatibili con OpenAI. Questo facilita l'integrazione in toolchain che prevedono API simili a OpenAI.

In che modo Grok Code Fast 1 si differenzia dagli LLM generici?

Grok Code Fast 1 rinuncia a parte dell'ampiezza di un modello conversazionale di punta in cambio di una maggiore ottimizzazione del codice, degli strumenti di sviluppo e dei cicli di strumenti rapidi. In pratica, questo significa:

- Latenza di andata e ritorno più rapida per la generazione di token e le chiamate degli strumenti.

- Risultati più nitidi e incentrati sull'azione (risposte strutturate, metadati JSON/chiamate di funzione).

- Modello di costo ottimizzato per interazioni di codice ad alto volume (più economico per token in molti elenchi di gateway)

Quanto è agentico Grok Code Fast 1? Cosa significa in pratica "codifica agentica"?

"Agentic" significa che il modello può pianificare ed eseguire attività multi-step con interazioni con strumenti esterni. Per Grok Code Fast 1, la potenza agentica assume le seguenti forme:

- Chiamata di funzione: Grok può richiedere chiamate a funzioni esterne (ad esempio, eseguire test, recuperare file, chiamare linter) e incorporare i risultati restituiti per decisioni di follow-up.

- Tracce di ragionamento visibili: gli output possono includere un ragionamento graduale che è possibile ispezionare e utilizzare per eseguire il debug o indirizzare il comportamento dell'agente. Questa trasparenza è utile quando si automatizzano le modifiche in una base di codice.

- Cicli di strumenti persistenti: Grok è progettato per essere utilizzato in cicli brevi e ripetuti di pianificazione→esecuzione→verifica, anziché aspettarsi una singola risposta monolitica.

Casi d'uso che traggono il massimo vantaggio dal comportamento agentico

- Riparazione automatica del codice: individua i test non riusciti, proponi modifiche, esegui test, ripeti.

- Analisi del repository: ricerca di modelli di utilizzo in migliaia di file, creazione di riepiloghi o proposta di refactoring con citazioni di file/righe esatte.

- Generazione assistita di PR: scrivi descrizioni di PR, genera patch diff e annota test, il tutto all'interno di un flusso orchestrato che può essere eseguito in CI.

In che modo gli sviluppatori possono accedere e utilizzare l'API Grok Code Fast 1?

xAI espone i modelli Grok tramite la sua API pubblica e le integrazioni con i partner. Esistono tre modelli di accesso comuni:

- API Direct xAI — creare un account xAI, generare una chiave API nella console e chiamare gli endpoint REST. La documentazione di xAI mostra la base REST come

https://api.x.aie specificano l'autenticazione standard tramite token Bearer. La documentazione e le guide forniscono esempi di curl e SDK e sottolineano la compatibilità con le richieste in stile OpenAI per molti livelli di strumenti. - Partner IDE/servizi (integrazioni di anteprima) — GitHub Copilot (anteprima pubblica con adesione volontaria) e altri partner (Cursor, Cline, ecc.) sono stati annunciati come collaboratori al lancio, abilitando Grok Code Fast 1 all'interno di VS Code e strumenti simili, talvolta tramite flussi "bring your own key". Se utilizzate Copilot per i livelli Pro o Enterprise, cercate l'opzione di adesione volontaria per Grok Code Fast 1.

- Gateway di terze parti (CometAPI, aggregatori API) — i fornitori normalizzano le chiamate API tra i provider e talvolta propongono diversi livelli di tariffazione (utile per la prototipazione o per i fallback multi-provider). CometaAPI e altri registri elencano contesti modello, prezzi campione e chiamate di esempio.

Di seguito sono riportati due esempi di codice pratico (streaming SDK nativo Python e REST tramite CometaAPI) che illustrano come potresti usare Grok Code Fast 1 in un'app reale.

Progetta i tuoi strumenti: registrare le definizioni di funzioni/strumenti nella richiesta in modo che il modello possa chiamarle; per lo streaming, catturare

reasoning_contentper monitorare il piano del modello.

Codice del caso d'uso: Python (SDK xAI nativo, campionatore in streaming)

Questo esempio è adattato dai modelli di documentazione di xAI. Sostituisci

XAI_API_KEYcon la tua chiave reale e adatta le definizioni degli strumenti al tuo ambiente. Lo streaming mostra token e tracce di ragionamento.

# Save as grok_code_fast_example.py

import os

import asyncio

# Hypothetical xai_sdk per xAI docs

import xai_sdk

API_KEY = os.getenv("XAI_API_KEY") # store your key securely

async def main():

client = xai_sdk.Client(api_key=API_KEY)

# Example: ask the model to add a unit test and fix failing code

prompt = """

Repo structure:

/src/math_utils.py

/tests/test_math_utils.py

Task: run the tests, identify the first failing test case, and modify src/math_utils.py

to fix the bug. Show the minimal code diff and run tests again.

"""

# Start a streaming sample; we want to see reasoning traces

async for chunk in client.sampler.sample(

model="grok-code-fast-1",

prompt=prompt,

max_len=1024,

stream=True,

return_reasoning=True, # stream reasoning_content when available

):

# chunk may include tokens and reasoning traces

if hasattr(chunk, "delta"):

if getattr(chunk.delta, "reasoning_content", None):

# model is exposing its internal planning steps

print("", chunk.delta.reasoning_content, flush=True)

if getattr(chunk.delta, "token_str", None):

print(chunk.delta.token_str, end="", flush=True)

if __name__ == "__main__":

asyncio.run(main())

Note

- .

return_reasoning=Trueflag rappresenta la guida dei documenti per trasmettere in streaming le tracce di ragionamento: catturale e visualizzale in modo da poter verificare il piano del modello. - In una configurazione agentica reale registreresti anche gli strumenti (ad esempio,

run_tests,apply_patch) e autorizzare il modello a chiamarli. Il modello può quindi decidere di invocarlirun_tests()e utilizzare gli output per informare una patch.

Codice del caso d'uso: REST (compatibile con CometAPI / OpenAI)

Se il tuo stack prevede endpoint REST in stile OpenAI, CometaAPI espone

grok-code-fast-1come una stringa modello compatibile. L'esempio seguente utilizzaopenaimodello client in stile.

import os

import requests

CometAPI_KEY = os.getenv("CometAPI_API_KEY")

BASE = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {CometAPI_KEY}",

"Content-Type": "application/json",

}

payload = {

"model": "grok-code-fast-1",

"messages": [

{"role": "system", "content": "You are Grok Code Fast 1, a fast coding assistant."},

{"role": "user", "content": "Write a function in Python that merges two sorted lists into one sorted list."}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

Note

- CometaAPI funge da ponte quando l'accesso nativo a gRPC o SDK è problematico nel tuo ambiente; supporta lo stesso contesto 256k ed espone

grok-code-fast-1Verificare la disponibilità del provider e i limiti tariffari.

Quali sono i modelli di integrazione pratica e le migliori pratiche?

IDE-first (programmazione in coppia)

Incorpora Grok Code Fast 1 come modello di completamento/assistente in VS Code o altri IDE. Utilizza prompt brevi che richiedano piccole modifiche testabili. Mantieni l'assistente in un ciclo serrato: genera patch → esegui test → riesegui l'assistente con output di test non riuscito.

Automazione CI

Utilizza Grok Code Fast 1 per individuare errori non evidenti, suggerire soluzioni o generare automaticamente unit test per il codice appena aggiunto. Grazie al suo prezzo e alla sua architettura a bassa latenza, è adatto a esecuzioni di CI frequenti rispetto ai modelli generalisti più costosi.

Orchestrazione degli agenti

Combina il modello con robuste protezioni degli strumenti: esegui sempre le patch proposte in una sandbox, esegui l'intera suite di test e richiedi la revisione umana per modifiche di sicurezza o di progettazione non banali. Utilizza tracce di ragionamento visibili per verificare le azioni e renderle riproducibili.

Suggerimenti tecnici immediati

- Fornire al modello i file esatti o una piccola finestra contestuale mirata per le modifiche.

- Preferisci schemi di output strutturati per diff o riepiloghi JSON: sono più facili da convalidare automaticamente.

- Quando si eseguono flussi multi-step, registrare le chiamate degli strumenti del modello e i risultati in modo da poter riprodurre o eseguire il debug del comportamento dell'agente.

Caso d'uso concreto: correzione automatica di un test pytest non riuscito

Di seguito è riportato un flusso di lavoro Python esemplificativo (semplificato) che mostra come integrare Grok Code Fast 1 in un ciclo di correzione dei test.

# pseudo-code: agentic test-fix loop with grok-code-fast-1

# 1) collect failing test output

failing_test_output = run_pytest_and_capture("tests/test_math.py")

# 2) ask Grok to propose a patch and tests

prompt = f"""

Pyproject: repo root

Failing test output:

{failing_test_output}

Please:

1) Explain root cause briefly.

2) Provide a patch in unified diff format that should fix the issue.

3) Suggest a minimal new/updated unit test to prove the fix.

"""

resp = call_grok_model("grok-code-fast-1", prompt, show_reasoning=True)

# 3) parse structured patch from response (validate!)

patch = extract_patch_from_response(resp)

if is_patch_safe(patch):

apply_patch(patch)

test_result = run_pytest_and_capture("tests/test_math.py")

report_back_to_grok(test_result)

else:

alert_human_review(resp)

Questo ciclo mostra come è possibile implementare un comportamento agentico (proponi → convalida → esegui → itera) mantenendo allo stesso tempo il controllo sull'applicazione delle modifiche.

Iniziamo

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni. Che tu stia sviluppando chatbot, generatori di immagini, compositori musicali o pipeline di analisi basate sui dati, CometAPI ti consente di iterare più velocemente, controllare i costi e rimanere indipendente dal fornitore, il tutto sfruttando le più recenti innovazioni nell'ecosistema dell'IA.

Gli sviluppatori possono accedere API Grok Code Fast 1 tramite CometAPI,l'ultima versione del modello è sempre aggiornato con il sito ufficiale. Per iniziare, esplora le capacità del modello nel Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Pronti a partire? → Iscriviti oggi a CometAPI !

Conclusione

Grok Code Fast 1 non è pubblicizzato come il modello "migliore" per ogni lavoro. Invece, è un specialista — ottimizzato per flussi di lavoro di codifica agentici e ricchi di strumenti, in cui velocità, un'ampia finestra di contesto e un basso costo per iterazione sono gli elementi più importanti. Questa combinazione lo rende un driver pratico e quotidiano per molti team di ingegneria: sufficientemente veloce per esperienze di editor live, sufficientemente economico da iterare e sufficientemente trasparente da essere integrato in modo sicuro con limiti appropriati.